Maison >Périphériques technologiques >IA >Il ne faut que quelques secondes pour convertir une photo d'identité en personne numérique. Microsoft a réalisé la première génération de modèles de diffusion 3D de haute qualité, et vous pouvez modifier votre apparence et votre apparence en une seule phrase.

Il ne faut que quelques secondes pour convertir une photo d'identité en personne numérique. Microsoft a réalisé la première génération de modèles de diffusion 3D de haute qualité, et vous pouvez modifier votre apparence et votre apparence en une seule phrase.

- 青灯夜游avant

- 2023-03-31 22:40:411345parcourir

Le nom de ce modèle de diffusion généré en 3D "Rodin" est inspiré de l'artiste sculpteur français Auguste Rodin.

Avec une photo d'identité 2D, vous pouvez concevoir un avatar de jeu 3D en quelques secondes seulement !

C'est la dernière réalisation du modèle de diffusion dans le domaine 3D. Par exemple, une simple vieille photo du sculpteur français Rodin peut le "transformer" en jeu en quelques minutes :

△Le modèle RODIN est une image 3D générée à partir de l'ancienne photo de Rodin

Il ne nécessite même qu'une seule phrase. peut modifier votre apparence et votre image. Dites à Rodin généré par l'IA "qu'il a l'air de porter un pull rouge et des lunettes" :

Vous n'aimez pas les gros cheveux gominés en arrière ? Passez ensuite au "look tressé" :

Essayez à nouveau de changer de couleur de cheveux ? Il s'agit d'une "personne branchée à la mode" aux cheveux bruns, même la couleur de la barbe est fixe :

("personne branchée à la mode" aux yeux de l'IA est effectivement un peu trop tendance)

Le dernier modèle de diffusion généré en 3D ci-dessus "Rodin" RODIN (Roll-out Diffusion Network), de Microsoft Research Asia.

RODIN est également le premier modèle à utiliser le modèle de diffusion générative pour générer automatiquement des avatars numériques 3D (Avatar) sur des données d'entraînement 3D. L'article a été accepté par CVPR 2023.

Jetons un coup d’œil.

Entraînez le modèle de diffusion directement avec des données 3D

Le nom de ce modèle de diffusion généré en 3D "Rodin" est inspiré de l'artiste sculpteur français Auguste Rodin.

Auparavant, les modèles d'images 3D générés en 2D étaient généralement obtenus en entraînant des réseaux contradictoires génératifs (GAN) ou des auto-encodeurs variationnels (VAE) avec des données 2D, mais les résultats étaient souvent insatisfaisants.

Les chercheurs ont analysé que la raison de ce phénomène est que ces méthodes ont un problème fondamental sous-déterminé (mal posé). Autrement dit, en raison de l'ambiguïté géométrique des images à vue unique, il est difficile d'apprendre la distribution raisonnable d'avatars 3D de haute qualité uniquement à travers une grande quantité de données 2D, ce qui entraîne de mauvais résultats de génération.

Par conséquent, cette fois, ils ont essayé d'utiliser directement les données 3D pour entraîner le modèle de diffusion, ce qui a principalement résolu trois problèmes :

- Premièrement, comment utiliser le modèle de diffusion pour générer des images multi-vues du modèle 3D. Auparavant, il n’existait aucune méthode pratique ni précédent à suivre pour les modèles de diffusion sur des données 3D.

- Deuxièmement, des ensembles de données d'images 3D de haute qualité et à grande échelle sont difficiles à obtenir, et il existe des risques en matière de confidentialité et de droits d'auteur, mais la cohérence multi-vues ne peut pas être garantie pour les images 3D publiées sur Internet.

- Enfin, le modèle de diffusion 2D est directement étendu à la génération 3D, ce qui nécessite d'énormes frais de mémoire, de stockage et de calcul.

Afin de résoudre ces trois problèmes, les chercheurs ont proposé le modèle de diffusion RODIN « AI Sculptor », qui dépasse le niveau SOTA des modèles existants.

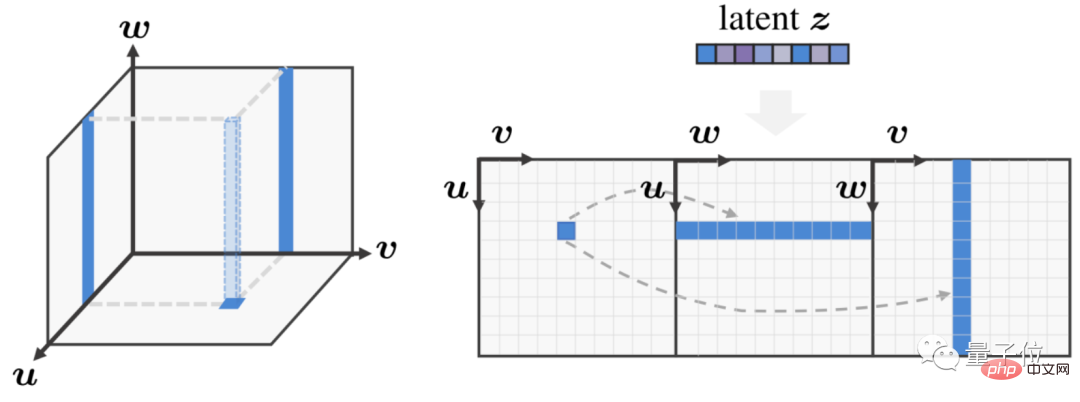

Le modèle RODIN utilise la méthode du champ de rayonnement neuronal (NeRF) et s'appuie sur le travail EG3D de NVIDIA pour exprimer de manière compacte l'espace 3D en trois plans caractéristiques mutuellement perpendiculaires (Triplans) dans l'espace, et étendre ces cartes en un seul plan caractéristique 2D. Effectuez ensuite une diffusion de détection 3D.

Plus précisément, il s'agit d'étendre l'espace 3D avec des caractéristiques bidimensionnelles sur trois vues planes orthogonales de plans horizontal, vertical et vertical. Cela permet non seulement au modèle RODIN d'utiliser une architecture 2D efficace pour la diffusion de la perception 3D, mais réduit également. l'image 3D. Les images 2D dimensionnelles réduisent également considérablement la complexité et les coûts de calcul.

△La convolution perceptuelle 3D traite efficacement les caractéristiques 3D

Sur le côté gauche de la figure ci-dessus, un triplan est utilisé pour exprimer l'espace 3D. À ce stade, les points caractéristiques du plan caractéristique inférieur correspondent aux deux. lignes des deux autres plans caractéristiques ; sur le côté droit de la figure ci-dessus, une convolution perceptuelle 3D est introduite pour traiter le plan caractéristique 2D étendu, tout en tenant compte de la correspondance tridimensionnelle inhérente des trois plans.

Plus précisément, trois éléments clés sont nécessaires pour parvenir à la génération d'images 3D :

Premièrement, la convolution compatible 3D assure la corrélation intrinsèque des trois plans après réduction de dimensionnalité.

Le réseau neuronal convolutif (CNN) 2D utilisé dans la diffusion 2D traditionnelle ne gère pas bien les cartes de caractéristiques Triplane.

La convolution prenant en compte la 3D ne génère pas simplement trois plans de caractéristiques 2D, mais prend en compte ses caractéristiques tridimensionnelles inhérentes lors du traitement de telles expressions 3D, c'est-à-dire que les caractéristiques 2D de l'un des trois plans de vue sont essentiellement un espace 3D. La projection d'une ligne droite La ligne dans le plan est donc liée aux caractéristiques de projection en ligne droite correspondantes dans les deux autres plans.

Afin de parvenir à une communication entre plans, les chercheurs considèrent ces corrélations 3D en convolution, synthétisant ainsi efficacement les détails 3D en 2D.

Deuxièmement, génération d'expressions 3D à trois plans de concerto spatial latent.

Les chercheurs coordonnent la génération de caractéristiques via des vecteurs latents pour la rendre globalement cohérente dans l'ensemble de l'espace tridimensionnel, ce qui aboutit à des avatars et à une édition sémantique de meilleure qualité.

Dans le même temps, un encodeur d'image supplémentaire est également entraîné en utilisant les images de l'ensemble de données d'entraînement, qui peut extraire des vecteurs sémantiques latents comme entrées conditionnelles du modèle de diffusion.

De cette manière, le réseau génératif global peut être considéré comme un auto-encodeur, utilisant le modèle de diffusion comme vecteur spatial latent de décodage. Pour la modification sémantique, les chercheurs ont adopté un encodeur d'image CLIP figé qui partage l'espace latent avec des invites de texte.

Troisièmement, la synthèse hiérarchique génère des détails tridimensionnels haute fidélité.

Les chercheurs ont utilisé le modèle de diffusion pour générer d'abord un plan à trois vues basse résolution (64 × 64), puis ont généré un plan à trois vues haute résolution (256 × 256) par suréchantillonnage de diffusion.

De cette manière, le modèle de diffusion de base se concentre sur la génération globale de la structure 3D, tandis que le modèle de suréchantillonnage ultérieur se concentre sur la génération de détails.

Générer une grande quantité de données aléatoires basées sur Blender

Sur l'ensemble de données d'entraînement, les chercheurs ont utilisé le logiciel de rendu 3D open source Blender pour combiner de manière aléatoire des images de personnages virtuels 3D créées manuellement par des artistes, ainsi qu'un grand nombre de cheveux, vêtements, expressions et accessoires, puis a créé 100 000 individus synthétiques, tout en restituant 300 images multi-vues avec une résolution de 256*256 pour chaque individu.

Dans la génération de texte en avatar 3D, les chercheurs ont utilisé le sous-ensemble portrait de l'ensemble de données LAION-400M pour entraîner le mappage de la modalité d'entrée à l'espace latent du modèle de diffusion 3D, et ont finalement permis au modèle RODIN d'utiliser une seule image 2D ou avec une seule description textuelle, vous pouvez créer un avatar 3D réaliste.

△À partir d'une photo pour générer un avatar

, vous ne pouvez pas seulement changer l'image en une phrase, comme "un homme aux cheveux bouclés et à la barbe portant une veste en cuir noir":

Vous pouvez même changer le sexe à volonté, « Femmes avec des vêtements rouges et des coiffures africaines » : (Tête de chien manuelle)

Les chercheurs ont également fait une démonstration de l'application. Créer votre propre image ne nécessite que quelques boutons :

.

△ Utilisez du texte pour créer un portrait en 3D

Pour plus d'effets, vous pouvez cliquer sur l'adresse du projet pour voir~

△Plus d'images virtuelles générées aléatoirement

Après avoir créé RODIN, quel est le prochain plan de l'équipe ?

Selon les auteurs de Microsoft Research Asia, les travaux actuels de RODIN se concentrent principalement sur les portraits en demi-longueur 3D, ce qui est également lié au fait qu'il utilise principalement les données du visage pour l'entraînement, mais la demande de génération d'images 3D n'est pas limité aux visages humains.

Dans la prochaine étape, l'équipe envisagera d'essayer d'utiliser les modèles RODIN pour créer davantage de scènes 3D, notamment des fleurs, des arbres, des bâtiments, des voitures et des maisons, etc., afin d'atteindre l'objectif ultime de « tout générer en 3D avec un seul modèle ». .

Adresse papier :

https://arxiv.org/abs/2212.06135

Page du projet :

https://3d-avatar-diffusion.microsoft.com

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI