Maison >Périphériques technologiques >IA >Pour une compréhension complète des grands modèles de langage, voici une liste de lecture

Pour une compréhension complète des grands modèles de langage, voici une liste de lecture

- PHPzavant

- 2023-03-31 22:40:251553parcourir

Pour comprendre la conception, les contraintes et l’évolution des modèles linguistiques contemporains à grande échelle, vous pouvez suivre la liste de lecture de cet article.

Les modèles linguistiques à grande échelle ont attiré l'attention du public et, en seulement cinq ans, des modèles tels que Transforme ont presque complètement transformé le domaine du traitement du langage naturel. De plus, ils commencent à révolutionner des domaines tels que la vision par ordinateur et la biologie computationnelle.

Étant donné que les Transformers ont un impact si important sur le processus de recherche de chacun, cet article vous présentera une courte liste de lectures pour que les chercheurs et les praticiens de l'apprentissage automatique puissent commencer.

La liste suivante est principalement développée par ordre chronologique, principalement quelques articles de recherche universitaire. Bien entendu, il existe de nombreuses autres ressources utiles. Par exemple :

- "The Illustrated Transformer" écrit par Jay Alammar

- "The Transformer Family" écrit par Lilian Weng

- "Transformer models: an introduction and catalogue — 2023 Edition" écrit par Xavier Amatriain

- nanoGPT écrit par Andrej Bibliothèque Karpathy

Compréhension de l'architecture et des tâches principales

Si vous débutez avec Transformers et les grands modèles de langage, ces articles vous conviennent le mieux.

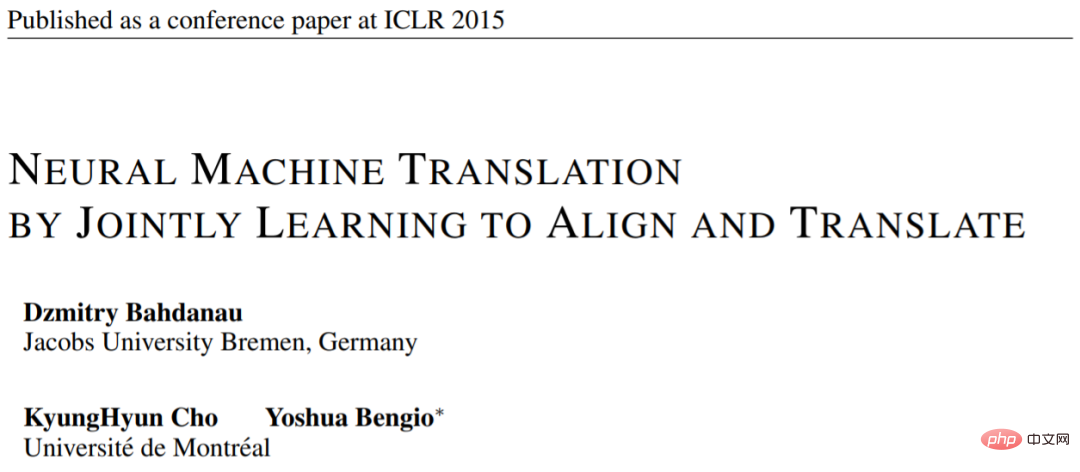

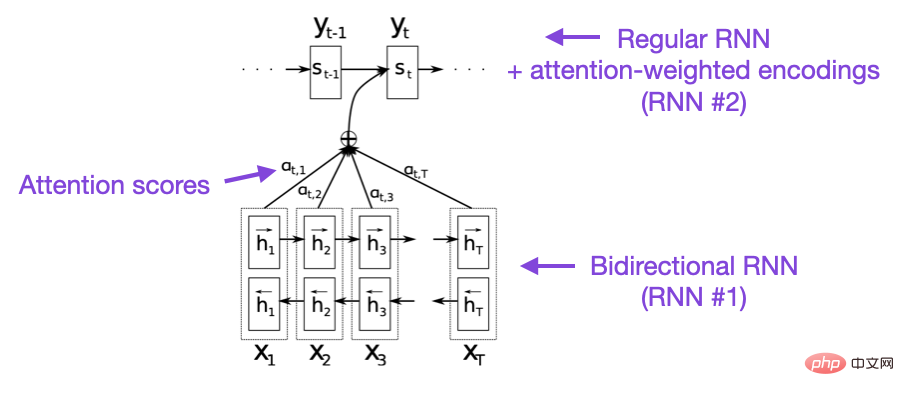

Article 1 : "Traduction automatique neuronale en apprenant conjointement à aligner et à traduire"

Adresse de l'article : https://arxiv.org/pdf/1409.0473.pdf

Cet article présente une approche neuronale récurrente. Le mécanisme d'attention du réseau (RNN) améliore les capacités de modélisation de séquences à longue portée du modèle. Cela permet aux RNN de traduire avec plus de précision des phrases plus longues – la motivation derrière le développement de l’architecture originale du Transformer.

Source de l'image : https://arxiv.org/abs/1409.0473

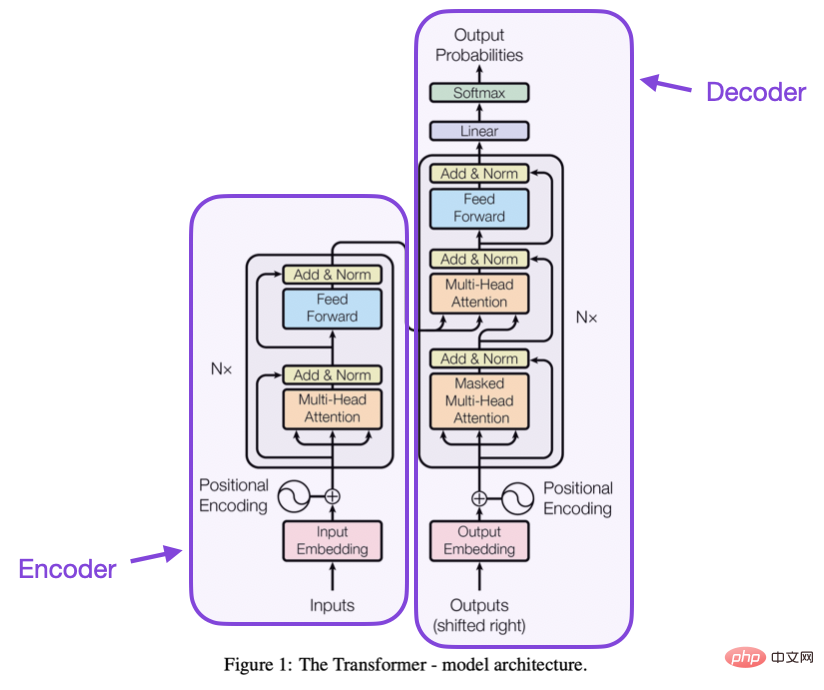

Papier 2 : "L'attention est tout ce dont vous avez besoin"

Adresse du papier : https://arxiv.org /abs/1706.03762

Cet article présente l'architecture originale du Transformer composée d'un encodeur et d'un décodeur. Ces parties seront présentées sous forme de modules séparés à l'avenir. De plus, cet article présente des concepts tels que la mise à l'échelle des mécanismes d'attention des produits scalaires, les blocs d'attention multi-têtes et le codage d'entrée positionnel, qui restent le fondement des Transformers modernes.

Source de l'image : https://arxiv.org/abs/1706.03762

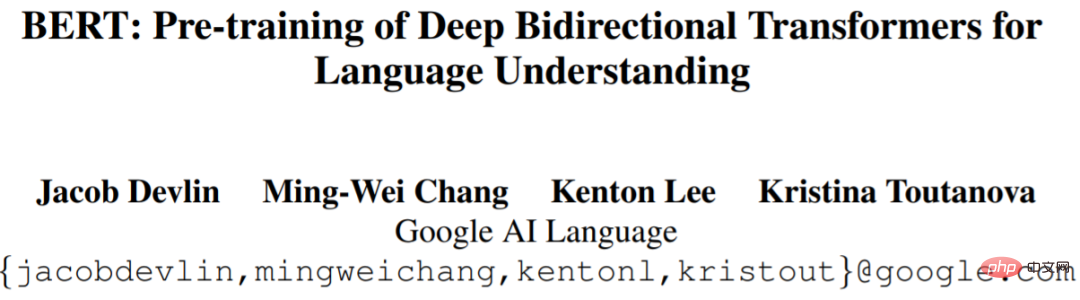

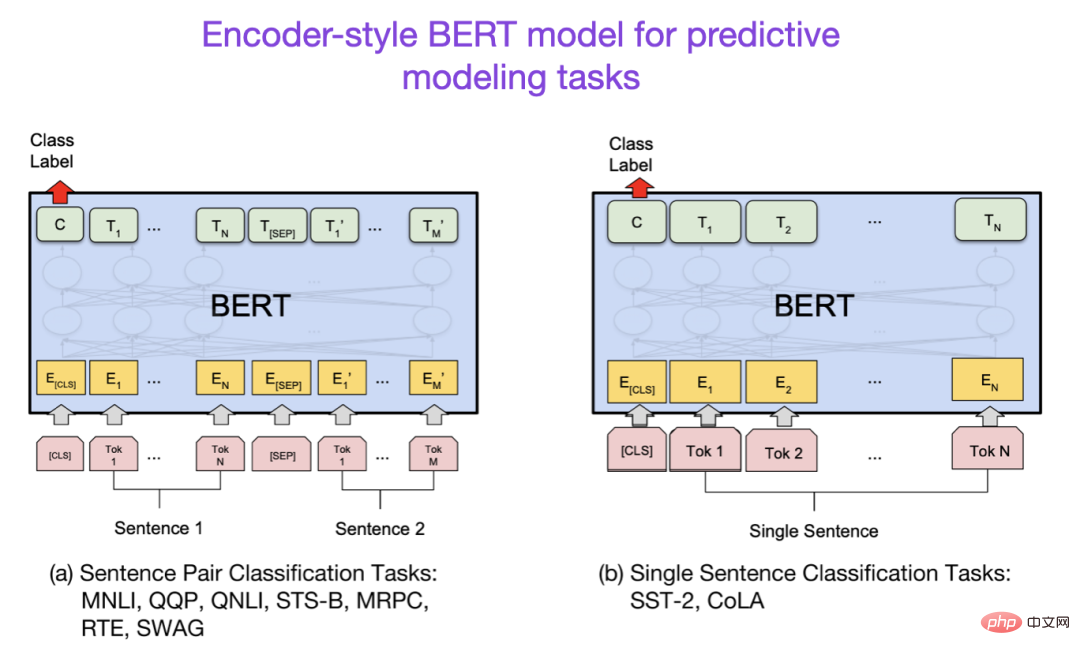

Papier 3 : "BERT : Pré-formation de transformateurs bidirectionnels profonds pour la compréhension du langage"

Adresse papier : https://arxiv.org/abs/1810.04805

La recherche sur les modèles de langage à grande échelle a suivi l'architecture initiale de Transformer, puis a commencé à s'étendre dans deux directions : Transformer pour les tâches de modélisation prédictive (telles que la classification de texte) et Transformer pour les tâches génératives. transformateur de construction pour les tâches modulaires telles que la traduction, le résumé et d'autres formes de création de texte.

L'article BERT introduit le concept original de modélisation du langage masqué. Si vous êtes intéressé par cette branche de recherche, vous pouvez faire un suivi avec RoBERTa, ce qui simplifie l'objectif de pré-formation.

Source de l'image : https://arxiv.org/abs/1810.04805

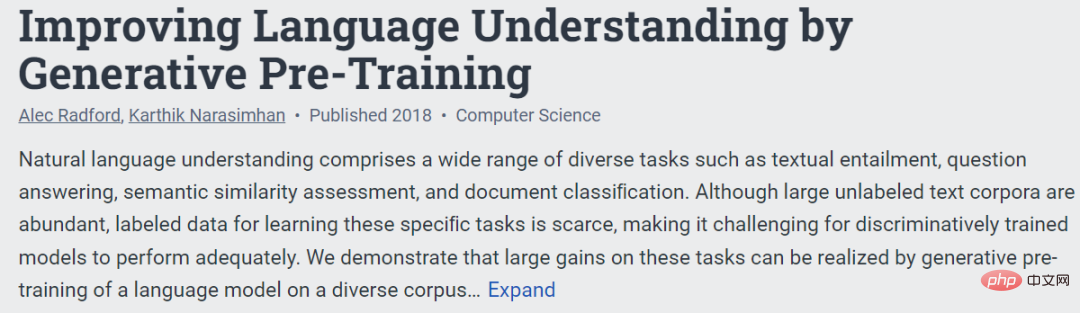

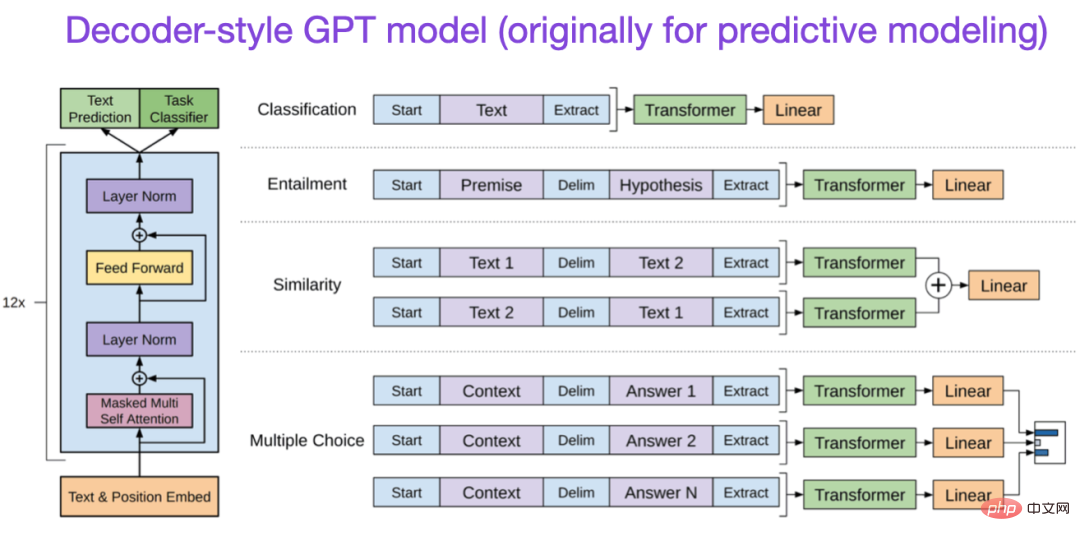

Papier 4 : "Améliorer la compréhension du langage grâce à une pré-formation générative"

Adresse du papier : https:// www.semanticscholar.org/paper/Improving-Language-Understanding-by-Generative-Radford-Narasimhan/cd18800a0fe0b668a1cc19f2ec95b5003d0a5035

L'article GPT original a présenté l'architecture populaire de style décodeur et la pré-formation avec la prédiction du mot suivant. BERT peut être considéré comme un transformateur bidirectionnel en raison de son objectif de pré-formation de modèle de langage masqué, tandis que GPT est un modèle autorégressif unidirectionnel. Bien que les intégrations GPT puissent également être utilisées pour la classification, les méthodes GPT sont au cœur des LLM les plus influents d'aujourd'hui, tels que ChatGPT.

Si cette branche de recherche vous intéresse, vous pouvez suivre les articles GPT-2 et GPT-3. De plus, cet article présentera la méthode InstructGPT séparément plus tard.

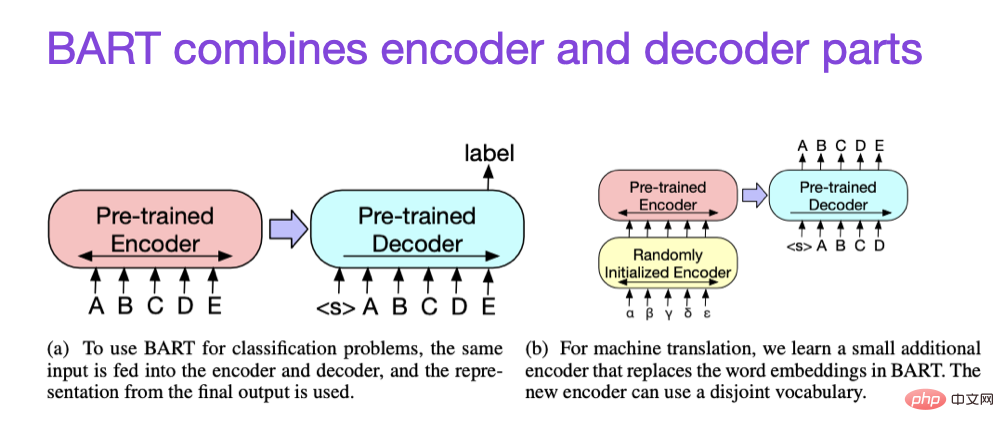

Papier 5 : "BART : Pré-entraînement au débruitage séquence à séquence pour la génération, la traduction et la compréhension du langage naturel"

Adresse du papier https://arxiv.org/abs/1910.13461.

Comme mentionné ci-dessus, le LLM de style encodeur de type BERT est généralement préféré pour les tâches de modélisation prédictive, tandis que le LLM de style décodeur de type GPT est meilleur pour générer du texte. Pour obtenir le meilleur des deux mondes, le document BART ci-dessus combine les parties encodeur et décodeur.

Loi d'expansion et amélioration de l'efficacité

Si vous souhaitez en savoir plus sur la technologie permettant d'améliorer l'efficacité des transformateurs, vous pouvez vous référer à l'article suivant

- Article 1 : "Une enquête sur la formation efficace des transformateurs"

- Adresse papier : https://arxiv.org/abs/2302.01107

- Papier 2 : "FlashAttention : Attention exacte rapide et efficace en mémoire avec IO-Awareness"

- Adresse papier : https:// arxiv.org /abs/2205.14135

- Papier 3 : "Cramming : Entraîner un modèle de langage sur un seul GPU en une journée"

- Adresse du papier : https://arxiv.org/abs/2212.14034

- Paper 4 : "Training Compute-Optimal Large Language Models"

- Adresse du papier : https://arxiv.org/abs/2203.15556

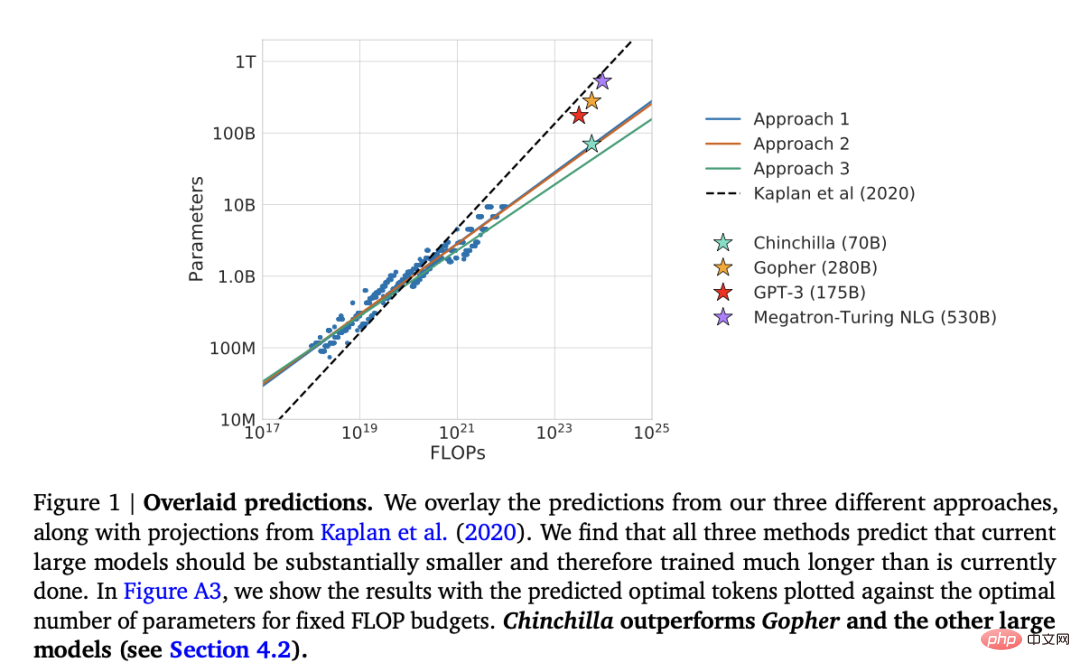

De plus, il y a aussi le document "Training Compute-Optimal Large Language Models"

Adresse de l'article : https://arxiv.org/abs/2203.15556

Cet article présente le modèle Chinchilla à 70 milliards de paramètres, qui surpasse le populaire modèle GPT-3 à 175 milliards de paramètres sur les tâches de modélisation générative. Cependant, son principal point fort est que les modèles de langage contemporains à grande échelle sont gravement sous-entraînés.

Cet article définit la loi d'échelle linéaire pour la formation de grands modèles de langage. Par exemple, bien que Chinchilla soit deux fois plus petit que GPT-3, il surpasse GPT-3 car il est formé sur 1,4 billion (au lieu de 300 milliards) de jetons. En d’autres termes, le nombre de jetons de formation est aussi important que la taille du modèle.

Alignement - orienter les grands modèles de langage vers les objectifs et les intérêts souhaités

Ces dernières années, de nombreux grands modèles de langage relativement puissants sont apparus et peuvent générer du texte réel (tels que GPT-3 et Chinchilla). En termes de paradigmes de pré-formation couramment utilisés, il semble qu’une limite supérieure ait été atteinte.

Afin de rendre le modèle linguistique plus utile aux humains et de réduire la désinformation et le langage grossier, les chercheurs ont conçu des paradigmes de formation supplémentaires pour affiner le modèle de base pré-entraîné, y compris les articles suivants.

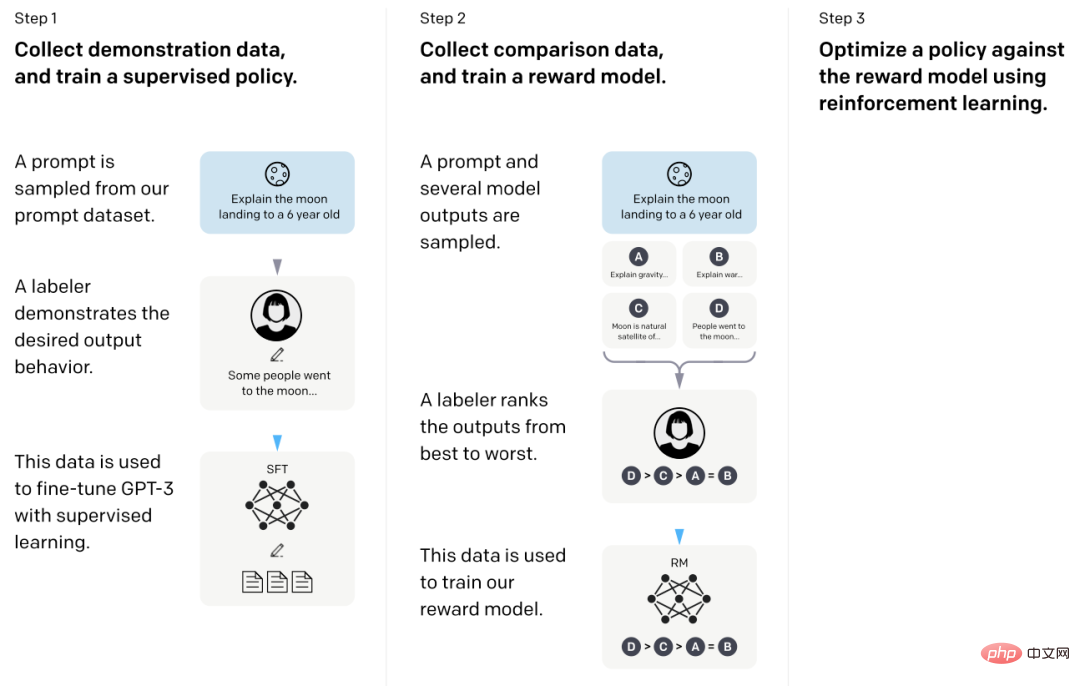

- Article 1 : « Former des modèles de langage pour suivre les instructions avec des commentaires humains »

- Adresse de l'article : https://arxiv.org/abs/2203.02155

Dans cet article dit InstructGPT, les chercheurs ont utilisé le RLHF (Reinforcement Learning à partir des commentaires humains). Ils ont commencé avec un modèle de base GPT-3 pré-entraîné et l’ont affiné sur des paires signal-réponse générées par l’homme à l’aide de l’apprentissage supervisé (étape 1). Ensuite, ils ont demandé aux humains de classer les résultats du modèle pour former le modèle de récompense (étape 2). Enfin, ils utilisent le modèle de récompense pour mettre à jour le modèle GPT-3 pré-entraîné et affiné en utilisant l'apprentissage par renforcement via l'optimisation des politiques proximales (étape 3).

À propos, cet article est également connu comme l'article qui décrit les idées derrière ChatGPT - selon des rumeurs récentes, ChatGPT est une version étendue d'InstructGPT qui est affinée sur un ensemble de données plus vaste.

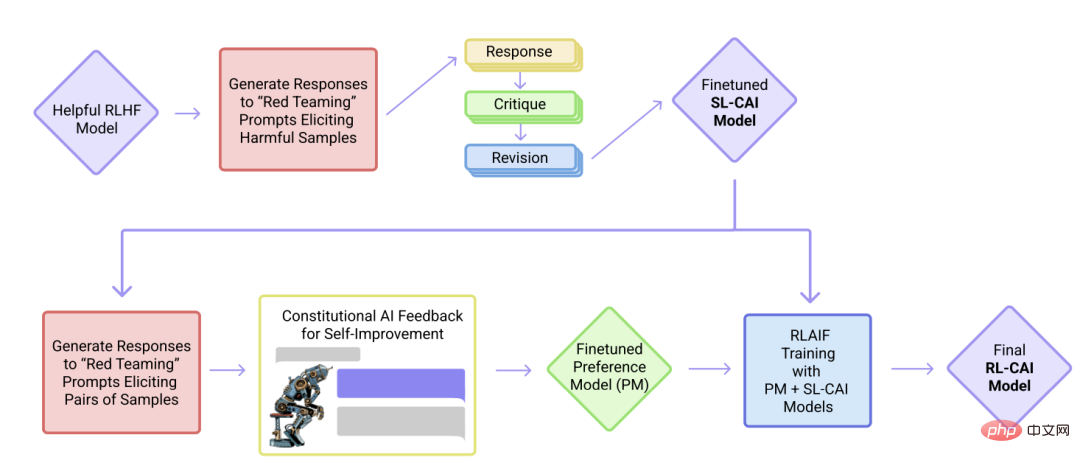

- Article 2 : "Constitutional AI : Harmlessness from AI Feedback"

- Adresse de l'article : https://arxiv.org/abs/2212.08073

Dans cet article, les chercheurs avancent davantage l'idée d'alignement et proposent une formation mécanisme pour créer des systèmes d’IA « inoffensifs ». Les chercheurs ont proposé un mécanisme d’auto-formation basé sur une liste de règles (fournies par les humains), plutôt que sur une supervision humaine directe. Semblable à l'article InstructGPT mentionné ci-dessus, la méthode proposée utilise des méthodes d'apprentissage par renforcement.

Résumé

Cet article tente de garder la disposition du tableau ci-dessus aussi simple et belle que possible. Il est recommandé de se concentrer sur les 10 premiers articles pour comprendre la conception, les limites et l'évolution derrière les œuvres contemporaines à grande échelle. modèles de langage.

Si vous souhaitez lire en profondeur, il est recommandé de vous référer aux références dans l'article ci-dessus. Alternativement, voici quelques ressources supplémentaires permettant aux lecteurs de poursuivre leurs recherches :

Alternatives open source à GPT

- Article 1 : "BLOOM : un modèle de langage multilingue à accès libre avec paramètres 176B"

- Adresse papier : https: / /arxiv.org/abs/2211.05100

- Papier 2 : "OPT : ouvrir des modèles de langage de transformateur pré-entraînés"

- Adresse du papier : https://arxiv.org/abs/2205.01068

Alternatives à ChatGPT

- Papier 1 "LaMDA : Modèles linguistiques pour les applications de dialogue"

- Adresse du papier : https://arxiv.org/abs/2201.08239

- Papier 2 : "Améliorer l'alignement des agents de dialogue" via des jugements humains ciblés》

- Adresse papier : https://arxiv.org/abs/2209.14375

- Article 3 : "BlenderBot 3 : un agent conversationnel déployé qui apprend continuellement à s'engager de manière responsable"

- Adresse papier : https://arxiv.org/abs/2208.03188

Modèles linguistiques à grande échelle en biologie computationnelle

- Article 1 : "ProtTrans : Vers déchiffrer le langage du code de la vie grâce à l'apprentissage auto-supervisé"

- Article adresse : https://arxiv.org/abs/2007.06225

- Article 2 : "Prédiction hautement précise de la structure des protéines avec AlphaFold"

- Adresse de l'article : https://www.nature.com/articles/ s41586 -021-03819-2

- Article 3 : "Les grands modèles de langage génèrent des séquences de protéines fonctionnelles dans diverses familles"

- Adresse de l'article : https://www.nature.com/articles/s41587-022- 01618 -2

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI