Maison >Opération et maintenance >Apache >Parlons de la façon d'analyser les données Apache Avro (explication avec exemples)

Parlons de la façon d'analyser les données Apache Avro (explication avec exemples)

- 青灯夜游avant

- 2022-02-22 10:47:163454parcourir

Comment analyser les données Apache Avro ? Cet article vous présentera les méthodes de sérialisation pour générer des données Avro, de désérialisation pour analyser les données Avro et d'utilisation de FlinkSQL pour analyser les données Avro. J'espère que cela vous sera utile !

Avec le développement rapide d'Internet, les technologies de pointe telles que le cloud computing, le big data, l'intelligence artificielle et l'Internet des objets sont devenues des technologies de haute technologie courantes à l'ère d'aujourd'hui, comme les sites Web de commerce électronique. , la reconnaissance faciale, les voitures sans conducteur et les téléphones intelligents. Les maisons, les villes intelligentes, etc. facilitent non seulement l'alimentation, l'habillement, le logement et le transport des gens, mais derrière eux se trouve une grande quantité de données qui sont collectées, effacées et analysées par diverses plates-formes système à tout moment, garantissant une faible latence et une qualité de données élevée. Le débit et la sécurité sont particulièrement importants. Apache Avro lui-même est sérialisé via Schema pour la transmission binaire, d'une part, et d'autre part. d'autre part, il garantit la sécurité des données. Avro est actuellement de plus en plus utilisé dans diverses industries, plus il est étendu, plus il est important de traiter et d'analyser les données avro. Cet article montrera comment générer des données avro via la sérialisation et. utilisez FlinkSQL pour l'analyse.

Cet article est une démonstration de l'analyse avro. Actuellement, FlinkSQL ne convient qu'à l'analyse de données avro simples. Les données avro imbriquées complexes ne sont pas prises en charge pour le moment.

Introduction à la scène

Cet article présente principalement les trois contenus clés suivants :

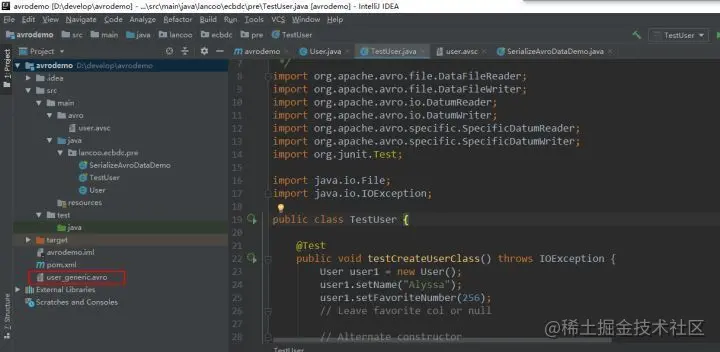

Comment sérialiser et générer des données Avro

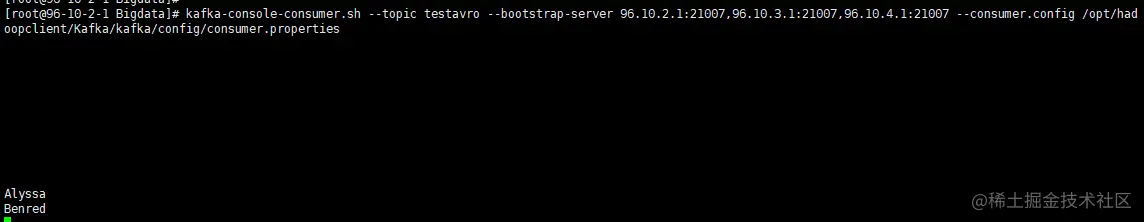

Comment désérialiser et analyser les données Avro

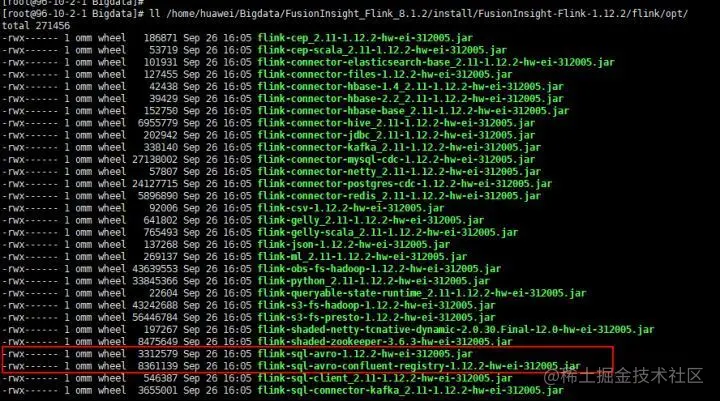

Comment utiliser FlinkSQL pour analyser les données Avro

Prérequis

Pour comprendre ce qu'est avro, vous pouvez vous référer au guide de démarrage rapide du site officiel d'Apache avro

Comprendre les scénarios d'application avro

Étapes de fonctionnement

1. Créer un nouveau maven avro. projetez et configurez les dépendances pom

Le contenu du fichier pom est le suivant :

<?xml version="1.0" encoding="UTF-8"?>

<project xmlns="http://maven.apache.org/POM/4.0.0"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

<modelVersion>4.0.0</modelVersion>

<groupId>com.huawei.bigdata</groupId>

<artifactId>avrodemo</artifactId>

<version>1.0-SNAPSHOT</version>

<dependencies>

<dependency>

<groupId>org.apache.avro</groupId>

<artifactId>avro</artifactId>

<version>1.8.1</version>

</dependency>

<dependency>

<groupId>junit</groupId>

<artifactId>junit</artifactId>

<version>4.12</version>

</dependency>

</dependencies>

<build>

<plugins>

<plugin>

<groupId>org.apache.avro</groupId>

<artifactId>avro-maven-plugin</artifactId>

<version>1.8.1</version>

<executions>

<execution>

<phase>generate-sources</phase>

<goals>

<goal>schema</goal>

</goals>

<configuration>

<sourceDirectory>${project.basedir}/src/main/avro/</sourceDirectory>

<outputDirectory>${project.basedir}/src/main/java/</outputDirectory>

</configuration>

</execution>

</executions>

</plugin>

<plugin>

<groupId>org.apache.maven.plugins</groupId>

<artifactId>maven-compiler-plugin</artifactId>

<configuration>

<source>1.6</source>

<target>1.6</target>

</configuration>

</plugin>

</plugins>

</build>

</project>Remarque : Le fichier pom ci-dessus est configuré avec le chemin d'accès à la classe générée automatiquement, c'est-à-dire b

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Que dois-je faire si Apache ne peut pas analyser PHP normalement ?

- Comment résoudre le problème d'erreur d'apache2.4 php5.6

- Un article explique comment déployer Apache et php sur un serveur Linux

- Que dois-je faire s'il n'y a pas de php7apache2_4.dll dans le php7 téléchargé ?

- Comment résoudre le problème de Yum Apache qui n'analyse pas PHP

- Que dois-je faire si Ubuntu Apache2 ne peut pas ouvrir PHP ?

- Apache Log4j 2.17.0 est sorti ! Vous voyez quel problème a été résolu ?