Maison >Opération et maintenance >exploitation et maintenance Linux >Exploitation et maintenance du Big Data Big Data

Exploitation et maintenance du Big Data Big Data

- 重铸original

- 2020-07-23 17:24:20352parcourir

Exploitation et maintenance du Big Data

1.HDFSExploitation et maintenance du système de fichiers distribués

1.Créer une récursivité dans le répertoire racine du HDFS Répertoire du système de fichiers "1daoyun/file", téléchargez le fichier BigDataSkills.txt ci-joint Aller dans le répertoire 1daoyun/file et utilisez les commandes appropriées pour afficher les fichiers dans le système 1daoyun/file Informations sur la liste du répertoire.

hadoop fs -mkdir -p /1daoyun/file

hadoop fs -put BigDataSkills.txt /1daoyun/file

hadoop fs -ls /1daoyun/file

2.dans HDFS Créez un répertoire récursif "1daoyun/file" dans le répertoire racine du système de fichiers, modifiez le BigDataSkills.txt , téléchargez-le dans le répertoire 1daoyun/file et utilisez HDFS Système de fichiers L'outil de vérification vérifie si les fichiers sont endommagés.

hadoop fs -mkdir -p /1daoyun/file

hadoop fs -put BigDataSkills.txt/1daoyun/file

hadoop fsck /1daoyun/file/BigDataSkills.txt

3. dans Créez un répertoire récursif "1daoyun/file" dans le répertoire racine du système de fichiers HDFS , et ajoutez le dans la pièce jointe Le fichier BigDataSkills.txt est téléchargé dans le répertoire 1daoyun/file , et le processus de téléchargement spécifie Les fichiers BigDataSkills.txt dans le système de fichiers HDFS ont un facteur de réplication de 2 et utilisent fsck ToolL'outil vérifie le nombre de copies d'un bloc de stockage.

hadoop fs -mkdir -p /1daoyun/file

hadoop fs -D dfs.replication=2 -put BigDataSkills.txt /1daoyun/file

hadoop fsck /1daoyun/file/BigDataSkills.txt

4.HDFS Il y a un système de fichiers à la racine répertoire /apps répertoire de fichiers, il est nécessaire d'activer la fonction de création d'instantané de ce répertoire et de créer un instantané pour le fichier de répertoire, le nom de l'instantané est apps_1daoyun, utilisez pour afficher les informations de liste du fichier d'instantané à l'aide des commandes associées.

hadoop dfsadmin -allowSnapshot /apps

hadoop fs -createSnapshot /apps apps_1daoyun

hadoop fs -ls /apps/.snapshot

5.quand Hadoop Lorsque le cluster démarre, il entrera d'abord en mode sans échec, qui se terminera après 30 secondes par défaut. Lorsque le système est en mode sans échec, le système de fichiers HDFS peut uniquement être lu et ne peut pas effectuer d'opérations telles que l'écriture, la modification, la suppression, etc. Supposons maintenant que le cluster Hadoop doit être maintenu, et qu'il est nécessaire de mettre le cluster en mode sans échec et vérifier son état.

hdfs dfsadmin -safemode enter

hdfs dfsadmin -safemode get

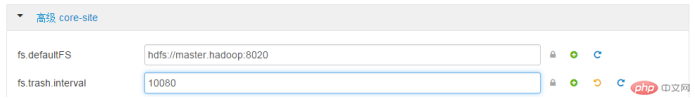

6.Afin d'éviter que les opérateurs ne suppriment accidentellement des fichiers, le système de fichiers HDFS fournit la fonction de corbeille, mais De nombreux fichiers indésirables occuperont beaucoup d'espace de stockage. Il est nécessaire que l'interface WEB de la plateforme Xiandian Big Data soit complètement supprimée du fichier HDFS corbeille du système. L'intervalle de temps est de 7 jours. Avancécore-sitefs.trash.interval : 10080

7.Afin d'empêcher les opérateurs de supprimer accidentellement des fichiers, le système de fichiers HDFS fournit une fonction de corbeille, mais trop de fichiers indésirables occuperont beaucoup d'espace de stockage. Il est nécessaire d'utiliser la commande "vi" dans Linux Shell pour modifier le fichier de configuration correspondant et les informations sur les paramètres. fonction corbeille. Une fois terminé, redémarrez le service correspondant . Avancécore-sitefs.trash.interval : 0vi /etc/hadoop/2.4.3.0 -227/0/core-site.xml

dfs.sh

8.Hadoop Les hôtes du cluster peuvent subir des temps d'arrêt ou des dommages au système dans certaines circonstances Une fois ces problèmes rencontrés, les fichiers de données dans

HDFS. Le système de fichiers sera inévitablement endommagé ou perdu

Afin d'assurer HDFS

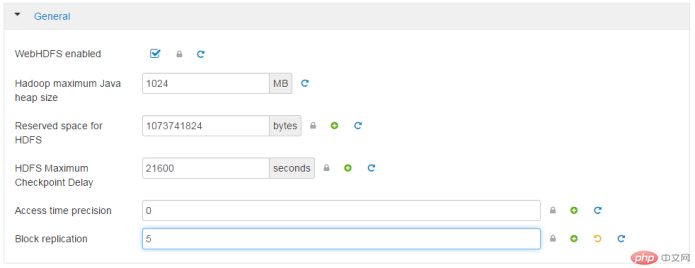

La fiabilité du système de fichiers nécessite désormais la réplication redondante du cluster. prendre en compte l'WEB

interface de la plateforme big data Xidian modifiée en 5. GénéralRéplication de bloc5

9.Hadoop Les hôtes du cluster peuvent subir des temps d'arrêt ou des dommages au système dans certaines circonstances Ces problèmes, <.>HDFS les fichiers de données dans le système de fichiers seront inévitablement endommagés ou perdus, Afin de garantir que HDFS Pour la fiabilité de le système de fichiers, le facteur de réplication de redondance du cluster doit être modifié à 5, dans Linux Shell Utilisez la commande "vi" pour modifier le fichier de configuration correspondant et les informations sur les paramètres. Une fois terminé, redémarrez le service correspondant.

ou

ou

vi/etc/hadoop/2.4.3.0-227/0/hdfs- site.xml

> /usr/hdp/current/hadoop-client/sbin/hadoop-daemon.sh --config /usr/hdp/current/hadoop-client/conf stop {namenode/datenode}

/usr/hdp/current/hadoop-client/sbin/hadoop-daemon.sh --config /usr/hdp/current/hadoop-client/conf start {namenode/datenode >

10.

Utilisez la commande pour afficher le système de fichiers hdfs

/tmp

Le nombre de répertoires sous le répertoire, le nombre de fichiers et la taille totale des fichiers . hadoop fs -count /tmp2.MapREDUCE Question de cas

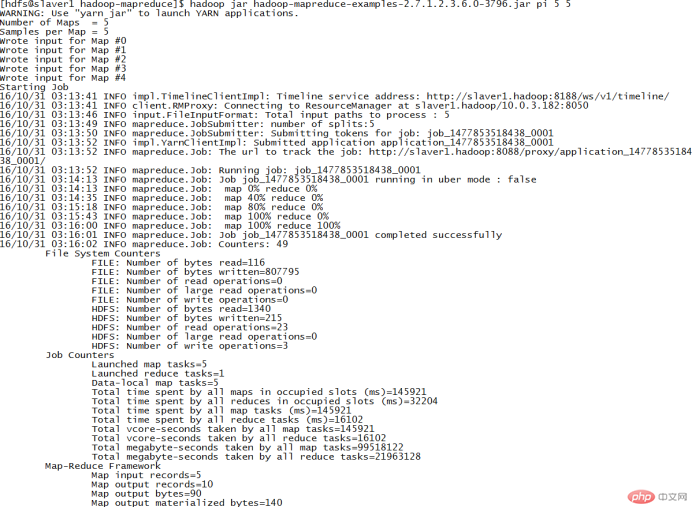

1.Dans le nœud du cluster/usr/hdp/2.4.3.0-227/hadoop-mapreduce/ répertoire, il existe un cas JAR package hadoop-mapreduce-examples.jar. Exécutez le programme PI dans le package JAR pour calculer Piπapproximation de , nécessite d'exécuter 5 fois pour chaque tâche Carte Le nombre de lancers pour la tâche est de 5. cd /usr/hdp/2.4.3.0-227/hadoop-mapreduce/

hadoop jar hadoop- mapreduce-examples-2.7.1.2.4.3.0-227.jar pi 5 5

2. Il existe un répertoire case

Il existe un répertoire case

/usr/hdp/2.4.3.0-227/hadoop-mapreduce/ 🎜>JAR Packagehadoop-mapreduce-examples.jar. Exécutez le programme wordcount dans le package JAR pour associer /1daoyun/file / BigDataSkills.txt compte les mots, affiche les résultats de l'opération dans le répertoire /1daoyun/output et utilise les commandes associées pour interroger les résultats du nombre de mots. hadoop jar/usr/hdp/2.4.3.0-227/hadoop-mapreduce/hadoop-mapreduce-examples-2.7.1.2.4.3.0-227.jar wordcount /1daoyun/ fichier/BigDataSkills.txt /1daoyun/output

3.Dans le nœud du cluster/usr/hdp/2.4.3.0-227/hadoop-mapreduce/ répertoire, il existe un cas JAR package hadoop-mapreduce-examples.jar. Exécutez le programme sudoku dans le package JAR pour calculer les résultats des problèmes de Sudoku dans le tableau ci-dessous . .

cat puzzle1.dta

hadoop jarhadoop-mapreduce-examples- 2.7.1.2.4.3.0-227.jar sudoku /root/puzzle1.dta

4.dans le nœud de cluster /usr/hdp/2.4.3.0-227/hadoop-mapreduce/ répertoire, il y a un cas JAR Package hadoop-mapreduce-examples.jar. Exécutez le programme grep dans le package JAR pour compter le système de fichiers / 1daoyun/file/BigDataSkills. txt Le nombre d'occurrences de "Hadoop" dans le fichier Après avoir compté , interrogez les informations du résultat statistique.

hadoop jarhadoop-mapreduce-examples-2.7.1.2.4.3.0-227.jar grep /1daoyun/file/BigDataSkills.txt /output hadoop

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Apprenez à installer le serveur Nginx sous Linux

- Introduction détaillée à la commande wget de Linux

- Explication détaillée d'exemples d'utilisation de yum pour installer Nginx sous Linux

- Explication détaillée des problèmes de connexions des travailleurs dans Nginx

- Explication détaillée du processus d'installation de python3 sous Linux