Maison >Les sujets >word >principe word2vector

principe word2vector

- (*-*)浩original

- 2020-01-10 10:54:573510parcourir

Mapper un mot dans un nouvel espace et le représenter comme un vecteur réel continu multidimensionnel est appelé « Représentation de mot » ou « Incorporation de mots ».

Depuis le 21e siècle, les gens sont progressivement passés de la représentation clairsemée originale des vecteurs de mots à la représentation dense actuelle dans un espace de faible dimension.

L'utilisation d'une représentation clairsemée se heurte souvent à la malédiction de la dimensionnalité lors de la résolution de problèmes pratiques, et les informations sémantiques ne peuvent pas être représentées et les connexions potentielles entre les mots ne peuvent pas être révélées.

L'utilisation de la représentation spatiale de basse dimension résout non seulement le problème du désastre de la dimensionnalité, mais explore également les attributs associés entre les mots, améliorant ainsi la précision de la sémantique vectorielle.

tâche d'apprentissage word2vec

Supposons qu'il existe une telle phrase : Aujourd'hui à 14 heures, le groupe des moteurs de recherche tiendra une réunion de groupe .

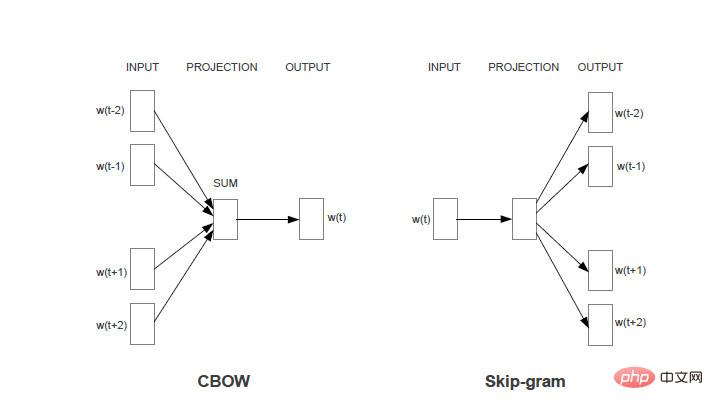

Tâche 1 : Pour chaque mot, utilisez les mots entourant le mot pour prédire la probabilité de générer le mot actuel. Par exemple, utilisez « aujourd'hui, après-midi, recherche, moteur, groupe » pour générer « 2 heures ».

Tâche 2 : Pour chaque mot, utilisez le mot lui-même pour prédire la probabilité de générer d'autres mots. Par exemple, utilisez « 2 heures » pour générer chaque mot dans « aujourd'hui, après-midi, recherche, moteur, groupe ».

La restriction commune aux deux tâches est la suivante : pour une même saisie, la somme des probabilités de sortie de chaque mot est de 1.

Le modèle Word2vec est un moyen d'améliorer la précision des tâches ci-dessus grâce à l'apprentissage automatique. Les deux tâches correspondent respectivement à deux modèles (CBOW et skim-gram). Si aucune instruction particulière n'est faite, CBOW, le modèle correspondant à la tâche 1, sera utilisé pour l'analyse ci-dessous.

La méthode d'analyse du modèle Skim-gram est la même.

Pour plus d'articles techniques liés à Word, veuillez visiter la colonne Tutoriel Word pour apprendre !

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!