Maison >développement back-end >Golang >À quel point l'architecture du « 12306 » est-elle impressionnante ?

À quel point l'architecture du « 12306 » est-elle impressionnante ?

- angryTomavant

- 2019-11-05 18:15:573174parcourir

À chaque jour de vacances, les gens qui rentrent chez eux ou sortent pour s'amuser dans les villes de premier et deuxième rang sont presque toujours confrontés à un problème : récupérer les billets de train !

12306 Récupération de billets, pensées provoquées par une concurrence extrême

Bien que les billets puissent être réservés dans la plupart des cas maintenant, aucun billet n'est disponible au moment où ils le sont libéré. Je crois que tout le monde a une compréhension profonde de la scène.

Surtout pendant la Fête du Printemps, les gens utilisent non seulement 12306, mais considèrent également « Zhixing » et d'autres logiciels de saisie de billets. Des centaines de millions de personnes à travers le pays récupèrent des billets pendant cette période.

Le "Service 12306" a un QPS qui ne peut être surpassé par aucun système de mise à mort instantanée au monde. Des millions de concurrence, ce n'est que normal !

L'auteur a spécialement étudié l'architecture du serveur "12306" et a appris de nombreux points forts de la conception de son système. Ici, je vais partager avec vous et simuler un exemple : comment obtenir 10 000 billets de train lorsqu'un million de personnes les prennent en même temps. temps. Le système fournit des services normaux et stables.

Adresse du code Github :

https://github.com/GuoZhaoran/spikeSystem

Haute efficacité à grande échelle Architecture du système de concurrence

L'architecture du système à haute concurrence adoptera le déploiement de clusters distribués. La couche supérieure du service a un équilibrage de charge couche par couche et fournit divers moyens de reprise après sinistre (salle informatique à double incendie, nœud tolérance aux pannes, reprise après sinistre du serveur, etc.) pour garantir la haute disponibilité du système, le trafic sera également équilibré vers différents serveurs en fonction de différentes capacités de charge et stratégies de configuration.

Ce qui suit est un diagramme schématique simple :

Équilibrage de charge simple

La figure ci-dessus décrit l'équilibrage de charge à trois couches que l'utilisateur demande au serveur subit. , ce qui suit est une brève introduction à ces trois types d'équilibrage de charge.

①OSPF (Open Shortest Link First) est un protocole de passerelle intérieure (IGP en abrégé)

OSPF annonce l'état des interfaces réseau entre les routeurs Pour établir la base de données d'état des liens et génère l'arborescence du chemin le plus court, OSPF calculera automatiquement la valeur du coût sur l'interface de routage, mais vous pouvez également spécifier manuellement la valeur du coût de l'interface. La valeur spécifiée manuellement a priorité sur la valeur calculée automatiquement.

Le coût calculé par OSPF est également inversement proportionnel à la bande passante de l'interface. Plus la bande passante est élevée, plus la valeur du coût est faible. Les chemins ayant la même valeur de coût vers la cible peuvent effectuer un équilibrage de charge, et jusqu'à 6 liens peuvent effectuer un équilibrage de charge en même temps.

②LVS (Linux Virtual Server)

Il s'agit d'une technologie de cluster (Cluster) qui utilise la technologie d'équilibrage de charge IP et la technologie de distribution de requêtes basée sur le contenu.

Le planificateur a un très bon débit et transfère uniformément les requêtes vers différents serveurs pour exécution. Le planificateur protège automatiquement les pannes de serveur, formant ainsi un groupe de serveurs en un serveur virtuel hautes performances et hautement disponible.

③Nginx

Tout le monde doit le connaître. Il s'agit d'un serveur proxy HTTP/proxy inverse très performant, qui est souvent utilisé dans le développement de services. .

Nginx dispose de trois méthodes principales pour réaliser l'équilibrage de charge : Interrogation Interrogation pondérée Interrogation par hachage IP

Ci-dessous, nous effectuerons une configuration et des tests spéciaux pour l'interrogation pondérée de Nginx.

Démonstration de l'interrogation pondérée Nginx

Nginx implémente l'équilibrage de charge via le module Upstream, dans lequel la configuration de l'interrogation pondérée peut ajouter une valeur de poids aux services associés, le correspondant La charge peut être définie en fonction des performances et de la capacité de charge du serveur lors de la configuration.

Ce qui suit est une configuration de charge d'interrogation pondérée. J'écouterai les ports 3001-3004 localement et configurerai les poids de 1, 2, 3 et 4 respectivement :

#配置负载均衡

upstream load_rule {

server 127.0.0.1:3001 weight=1;

server 127.0.0.1:3002 weight=2;

server 127.0.0.1:3003 weight=3;

server 127.0.0.1:3004 weight=4;

}

...

server {

listen 80;

server_name load_balance.com www.load_balance.com;

location / {

proxy_pass http://load_rule;

}

}Je suis local / L'adresse du nom de domaine virtuel www.load_balance.com est configurée dans le répertoire etc/hosts.

Ensuite, utilisez le langage Go pour ouvrir quatre services d'écoute de port HTTP. Voici le programme Go écoutant sur le port 3001. Les autres n'ont qu'à modifier le port :

package main

import (

"net/http"

"os"

"strings"

)

func main() {

http.HandleFunc("/buy/ticket", handleReq)

http.ListenAndServe(":3001", nil)

}

//处理请求函数,根据请求将响应结果信息写入日志

func handleReq(w http.ResponseWriter, r *http.Request) {

failedMsg := "handle in port:"

writeLog(failedMsg, "./stat.log")

}

//写入日志

func writeLog(msg string, logPath string) {

fd, _ := os.OpenFile(logPath, os.O_RDWR|os.O_CREATE|os.O_APPEND, 0644)

defer fd.Close()

content := strings.Join([]string{msg, "\r\n"}, "3001")

buf := []byte(content)

fd.Write(buf)

}Je demanderai. Les informations du journal du port sont écrites dans le fichier ./stat.log, puis l'outil de test de stress AB est utilisé pour les tests de stress : ab -n 1000 -

c 100 http://www.load_balance.com/buy/ticket

Selon les résultats du journal statistique, les ports 3001 à 3004 en ont obtenu 100, volume de requêtes de 200, 300, 400.

Ceci est cohérent avec le ratio de poids que j'ai configuré dans Nginx, et le trafic après chargement est très uniforme et aléatoire.

Pour une implémentation spécifique, vous pouvez vous référer au code source d'implémentation du module Upsteam de Nginx. Voici un article recommandé « Équilibrage de charge du mécanisme en amont dans Nginx » : https://www.kancloud.cn/digest/understandingnginx/. 202607

Sélection du système de vente flash

Retour à la question initiale que nous avons mentionnée : Comment le système de vente flash de billets de train peut-il fournir des performances normales et stables dans des conditions élevées conditions de concurrence ? Qu'en est-il du service ?

D'après l'introduction ci-dessus, nous savons que le trafic des ventes flash des utilisateurs est réparti uniformément sur différents serveurs via des couches d'équilibrage de charge. Néanmoins, le QPS supporté par une seule machine du cluster est également très élevé. Comment optimiser à l’extrême les performances autonomes ?

Pour résoudre ce problème, nous devons comprendre une chose : généralement, le système de réservation doit traiter trois étapes de base : la génération des commandes, la réduction des stocks et le paiement des utilisateurs.

Ce que notre système doit faire, c'est garantir que les commandes de billets de train ne sont pas survendues ou survendues. Chaque billet vendu doit être payé pour être valide. Nous devons également garantir que le système peut résister à une concurrence extrêmement élevée.

Comment répartir plus raisonnablement l’ordre de ces trois étapes ? Analysons-le :

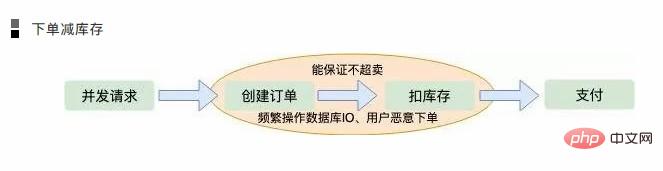

Passer une commande pour réduire l'inventaire

Lorsque des demandes d'utilisateurs simultanées arrivent au serveur, créez d'abord une commande, puis déduisez l'inventaire et attendez le paiement de l'utilisateur.

Cette commande est la première solution à laquelle la plupart d'entre nous penseront. Dans ce cas, elle peut également garantir que la commande ne sera pas survendue, car le stock sera réduit après la création de la commande, ce qui est le cas. une opération atomique.

Mais cela posera également quelques problèmes :

Dans le cas d'une concurrence extrême, les détails de toute opération de mémoire affecteront considérablement les performances, en particulier des choses comme la création de commandes. La logique doit généralement être stockée dans une base de données sur disque, et la pression sur la base de données est concevable.

Si un utilisateur passe une commande de manière malveillante et ne passe une commande sans payer, l'inventaire sera réduit et beaucoup de commandes seront moins vendues, bien que le serveur puisse limiter l'IP et le nombre de commandes d'achat des utilisateurs. , cela ne compte pas.

Payer pour réduire les stocks

Si vous attendez que l'utilisateur paie la commande et réduise les stocks, le premier sentiment est qu'il n'y en aura pas moins ventes. Mais c'est un tabou de l'architecture concurrente, car dans des conditions de concurrence extrême, les utilisateurs peuvent créer de nombreuses commandes.

Lorsque l'inventaire est réduit à zéro, de nombreux utilisateurs découvrent qu'ils ne peuvent pas payer les commandes qu'ils ont saisies. C'est ce qu'on appelle la « survente ». Les opérations simultanées d’E/S sur le disque de base de données ne peuvent pas non plus être évitées.

Retenue d'inventaire

Des considérations sur les deux solutions ci-dessus, nous pouvons conclure que tant qu'une commande est créée, la base de données IO doit être utilisée fréquemment.

Alors existe-t-il une solution qui ne nécessite pas de fonctionnement direct de la base de données IO : il s'agit de la retenue d'inventaire ? Tout d'abord, l'inventaire est déduit pour s'assurer qu'il n'est pas survendu, puis la commande de l'utilisateur est générée de manière asynchrone, de sorte que la réponse à l'utilisateur soit beaucoup plus rapide, alors comment s'assurer qu'il y a beaucoup de ventes ? Que doit faire l’utilisateur s’il ne paie pas après avoir reçu la commande ?

Nous savons tous que les commandes ont désormais une période de validité. Par exemple, si l'utilisateur ne paie pas dans les cinq minutes, la commande deviendra invalide. Une fois la commande expirée, un nouvel inventaire sera ajouté. de nombreuses entreprises de vente au détail en ligne garantissent désormais que les produits n'expireront pas. Vendez des solutions moins adoptées.

Les commandes sont générées de manière asynchrone et sont généralement traitées dans des files d'attente de consommation instantanée telles que MQ et Kafka. Lorsque le volume de commandes est relativement faible, les commandes sont générées très rapidement et les utilisateurs n'ont pratiquement pas à faire la queue.

L'art de retenir les stocks

D'après l'analyse ci-dessus, il est évident que la solution de retenue des stocks est la plus raisonnable. Analysons plus en détail les détails de la déduction des stocks. Il y a encore beaucoup de place à l'optimisation. Comment garantir une déduction correcte des stocks dans un contexte de concurrence élevée et de réponse rapide aux demandes des utilisateurs ?

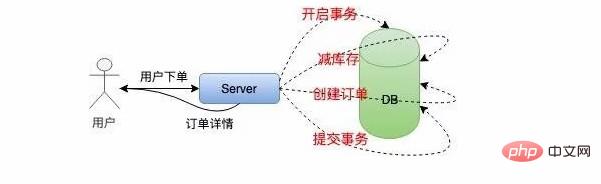

En cas de faible concurrence sur une seule machine, nous mettons généralement en œuvre une déduction d'inventaire comme ceci :

Afin de garantir déduction des stocks et génération de commandes L'atomicité nécessite le traitement des transactions, puis la récupération des stocks, la réduction des stocks et enfin la soumission des transactions. L'ensemble du processus implique beaucoup d'E/S et le fonctionnement de la base de données est bloqué.

Cette méthode ne convient pas du tout aux systèmes de vente flash à haute concurrence. Ensuite, nous optimisons le plan de déduction des stocks mono-machine : déduction des stocks locaux.

Nous allouons une certaine quantité d'inventaire à la machine locale, réduisons l'inventaire directement dans la mémoire, puis créons une commande de manière asynchrone selon la logique précédente.

Le système autonome amélioré ressemble à ceci :

Cela évite les opérations d'E/S fréquentes sur la base de données et n'effectue que des opérations en mémoire, ce qui est extrêmement efficace . Améliore considérablement la capacité d'une seule machine à résister à la concurrence.

Cependant, une seule machine ne peut pas supporter des millions de requêtes d'utilisateurs. Bien que Nginx utilise le modèle Epoll pour traiter les requêtes réseau, le problème c10k est résolu depuis longtemps dans l'industrie.

Cependant, sous le système Linux, toutes les ressources sont des fichiers, et il en va de même pour les requêtes réseau. Un grand nombre de descripteurs de fichiers empêcheront instantanément le système d'exploitation de répondre.

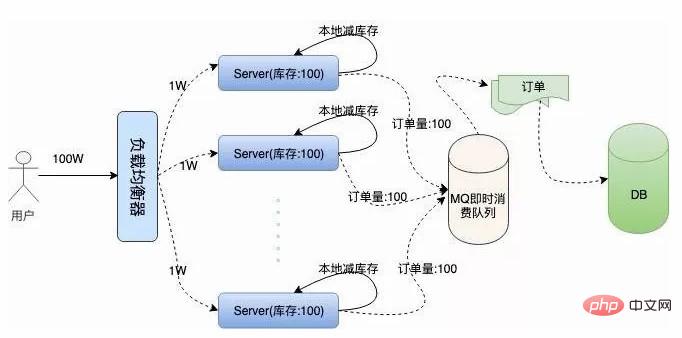

Nous avons mentionné ci-dessus la stratégie d'équilibrage pondéré de Nginx. Autant supposer qu'un million de requêtes d'utilisateurs sont équilibrées en moyenne sur 100 serveurs, de sorte que la quantité de concurrence supportée par une seule machine est beaucoup plus faible.

Ensuite, nous stockons 100 billets de train localement sur chaque machine, et l'inventaire total sur 100 serveurs est toujours de 10 000. Cela garantit que les commandes d'inventaire ne sont pas survendues. Voici l'architecture de cluster que nous décrivons :

问题接踵而至,在高并发情况下,现在我们还无法保证系统的高可用,假如这 100 台服务器上有两三台机器因为扛不住并发的流量或者其他的原因宕机了。那么这些服务器上的订单就卖不出去了,这就造成了订单的少卖。

要解决这个问题,我们需要对总订单量做统一的管理,这就是接下来的容错方案。服务器不仅要在本地减库存,另外要远程统一减库存。

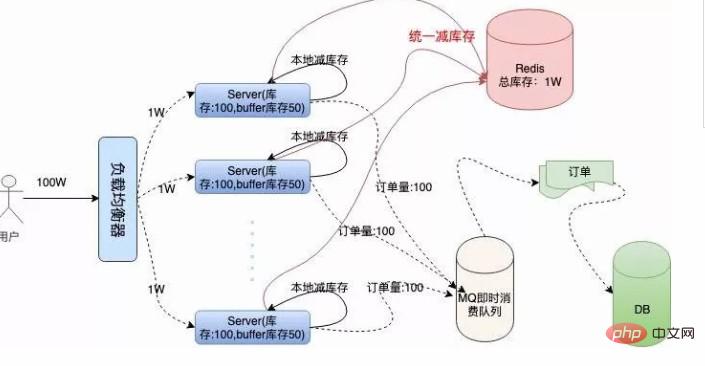

有了远程统一减库存的操作,我们就可以根据机器负载情况,为每台机器分配一些多余的“Buffer 库存”用来防止机器中有机器宕机的情况。

我们结合下面架构图具体分析一下:

我们采用 Redis 存储统一库存,因为 Redis 的性能非常高,号称单机 QPS 能抗 10W 的并发。

在本地减库存以后,如果本地有订单,我们再去请求 Redis 远程减库存,本地减库存和远程减库存都成功了,才返回给用户抢票成功的提示,这样也能有效的保证订单不会超卖。

当机器中有机器宕机时,因为每个机器上有预留的 Buffer 余票,所以宕机机器上的余票依然能够在其他机器上得到弥补,保证了不少卖。

Buffer 余票设置多少合适呢,理论上 Buffer 设置的越多,系统容忍宕机的机器数量就越多,但是 Buffer 设置的太大也会对 Redis 造成一定的影响。

虽然 Redis 内存数据库抗并发能力非常高,请求依然会走一次网络 IO,其实抢票过程中对 Redis 的请求次数是本地库存和 Buffer 库存的总量。

因为当本地库存不足时,系统直接返回用户“已售罄”的信息提示,就不会再走统一扣库存的逻辑。

这在一定程度上也避免了巨大的网络请求量把 Redis 压跨,所以 Buffer 值设置多少,需要架构师对系统的负载能力做认真的考量。

代码演示

Go 语言原生为并发设计,我采用 Go 语言给大家演示一下单机抢票的具体流程。

初始化工作

Go 包中的 Init 函数先于 Main 函数执行,在这个阶段主要做一些准备性工作。

我们系统需要做的准备工作有:初始化本地库存、初始化远程 Redis 存储统一库存的 Hash 键值、初始化 Redis 连接池。

另外还需要初始化一个大小为 1 的 Int 类型 Chan,目的是实现分布式锁的功能。

也可以直接使用读写锁或者使用 Redis 等其他的方式避免资源竞争,但使用 Channel 更加高效,这就是 Go 语言的哲学:不要通过共享内存来通信,而要通过通信来共享内存。

Redis 库使用的是 Redigo,下面是代码实现:...

//localSpike包结构体定义

package localSpike

type LocalSpike struct {

LocalInStock int64

LocalSalesVolume int64

}

...

//remoteSpike对hash结构的定义和redis连接池

package remoteSpike

//远程订单存储健值

type RemoteSpikeKeys struct {

SpikeOrderHashKey string //redis中秒杀订单hash结构key

TotalInventoryKey string //hash结构中总订单库存key

QuantityOfOrderKey string //hash结构中已有订单数量key

}

//初始化redis连接池

func NewPool() *redis.Pool {

return &redis.Pool{

MaxIdle: 10000,

MaxActive: 12000, // max number of connections

Dial: func() (redis.Conn, error) {

c, err := redis.Dial("tcp", ":6379")

if err != nil {

panic(err.Error())

}

return c, err

},

}

}

...

func init() {

localSpike = localSpike2.LocalSpike{

LocalInStock: 150,

LocalSalesVolume: 0,

}

remoteSpike = remoteSpike2.RemoteSpikeKeys{

SpikeOrderHashKey: "ticket_hash_key",

TotalInventoryKey: "ticket_total_nums",

QuantityOfOrderKey: "ticket_sold_nums",

}

redisPool = remoteSpike2.NewPool()

done = make(chan int, 1)

done <- 1

}本地扣库存和统一扣库存

本地扣库存逻辑非常简单,用户请求过来,添加销量,然后对比销量是否大于本地库存,返回 Bool 值:package localSpike

//本地扣库存,返回bool值

func (spike *LocalSpike) LocalDeductionStock() bool{

spike.LocalSalesVolume = spike.LocalSalesVolume + 1

return spike.LocalSalesVolume < spike.LocalInStock

}注意这里对共享数据 LocalSalesVolume 的操作是要使用锁来实现的,但是因为本地扣库存和统一扣库存是一个原子性操作,所以在最上层使用 Channel 来实现,这块后边会讲。

统一扣库存操作 Redis,因为 Redis 是单线程的,而我们要实现从中取数据,写数据并计算一些列步骤,我们要配合 Lua 脚本打包命令,保证操作的原子性:

package remoteSpike

......

const LuaScript = `

local ticket_key = KEYS[1]

local ticket_total_key = ARGV[1]

local ticket_sold_key = ARGV[2]

local ticket_total_nums = tonumber(redis.call('HGET', ticket_key, ticket_total_key))

local ticket_sold_nums = tonumber(redis.call('HGET', ticket_key, ticket_sold_key))

-- 查看是否还有余票,增加订单数量,返回结果值

if(ticket_total_nums >= ticket_sold_nums) then

return redis.call('HINCRBY', ticket_key, ticket_sold_key, 1)

end

return 0

`

//远端统一扣库存

func (RemoteSpikeKeys *RemoteSpikeKeys) RemoteDeductionStock(conn redis.Conn) bool {

lua := redis.NewScript(1, LuaScript)

result, err := redis.Int(lua.Do(conn, RemoteSpikeKeys.SpikeOrderHashKey, RemoteSpikeKeys.TotalInventoryKey, RemoteSpikeKeys.QuantityOfOrderKey))

if err != nil {

return false

}

return result != 0

}我们使用 Hash 结构存储总库存和总销量的信息,用户请求过来时,判断总销量是否大于库存,然后返回相关的 Bool 值。

在启动服务之前,我们需要初始化 Redis 的初始库存信息:

hmset ticket_hash_key "ticket_total_nums" 10000 "ticket_sold_nums" 0

响应用户信息

我们开启一个 HTTP 服务,监听在一个端口上:

package main

...

func main() {

http.HandleFunc("/buy/ticket", handleReq)

http.ListenAndServe(":3005", nil)

}上面我们做完了所有的初始化工作,接下来 handleReq 的逻辑非常清晰,判断是否抢票成功,返回给用户信息就可以了。

package main

//处理请求函数,根据请求将响应结果信息写入日志

func handleReq(w http.ResponseWriter, r *http.Request) {

redisConn := redisPool.Get()

LogMsg := ""

<-done

//全局读写锁

if localSpike.LocalDeductionStock() && remoteSpike.RemoteDeductionStock(redisConn) {

util.RespJson(w, 1, "抢票成功", nil)

LogMsg = LogMsg + "result:1,localSales:" + strconv.FormatInt(localSpike.LocalSalesVolume, 10)

} else {

util.RespJson(w, -1, "已售罄", nil)

LogMsg = LogMsg + "result:0,localSales:" + strconv.FormatInt(localSpike.LocalSalesVolume, 10)

}

done <- 1

//将抢票状态写入到log中

writeLog(LogMsg, "./stat.log")

}

func writeLog(msg string, logPath string) {

fd, _ := os.OpenFile(logPath, os.O_RDWR|os.O_CREATE|os.O_APPEND, 0644)

defer fd.Close()

content := strings.Join([]string{msg, "\r\n"}, "")

buf := []byte(content)

fd.Write(buf)

}前边提到我们扣库存时要考虑竞态条件,我们这里是使用 Channel 避免并发的读写,保证了请求的高效顺序执行。我们将接口的返回信息写入到了 ./stat.log 文件方便做压测统计。

单机服务压测

开启服务,我们使用 AB 压测工具进行测试:

ab -n 10000 -c 100 http://127.0.0.1:3005/buy/ticket

下面是我本地低配 Mac 的压测信息:

This is ApacheBench, Version 2.3 <$revision: 1826891="">

Copyright 1996 Adam Twiss, Zeus Technology Ltd, http://www.zeustech.net/

Licensed to The Apache Software Foundation, http://www.apache.org/

Benchmarking 127.0.0.1 (be patient)

Completed 1000 requests

Completed 2000 requests

Completed 3000 requests

Completed 4000 requests

Completed 5000 requests

Completed 6000 requests

Completed 7000 requests

Completed 8000 requests

Completed 9000 requests

Completed 10000 requests

Finished 10000 requests

Server Software:

Server Hostname: 127.0.0.1

Server Port: 3005

Document Path: /buy/ticket

Document Length: 29 bytes

Concurrency Level: 100

Time taken for tests: 2.339 seconds

Complete requests: 10000

Failed requests: 0

Total transferred: 1370000 bytes

HTML transferred: 290000 bytes

Requests per second: 4275.96 [#/sec] (mean)

Time per request: 23.387 [ms] (mean)

Time per request: 0.234 [ms] (mean, across all concurrent requests)

Transfer rate: 572.08 [Kbytes/sec] received

Connection Times (ms)

min mean[+/-sd] median max

Connect: 0 8 14.7 6 223

Processing: 2 15 17.6 11 232

Waiting: 1 11 13.5 8 225

Total: 7 23 22.8 18 239

Percentage of the requests served within a certain time (ms)

50% 18

66% 24

75% 26

80% 28

90% 33

95% 39

98% 45

99% 54

100% 239 (longest request)根据指标显示,我单机每秒就能处理 4000+ 的请求,正常服务器都是多核配置,处理 1W+ 的请求根本没有问题。

而且查看日志发现整个服务过程中,请求都很正常,流量均匀,Redis 也很正常://stat.log

... result:1,localSales:145 result:1,localSales:146 result:1,localSales:147 result:1,localSales:148 result:1,localSales:149 result:1,localSales:150 result:0,localSales:151 result:0,localSales:152 result:0,localSales:153 result:0,localSales:154 result:0,localSales:156 ...

总结回顾

总体来说,秒杀系统是非常复杂的。我们这里只是简单介绍模拟了一下单机如何优化到高性能,集群如何避免单点故障,保证订单不超卖、不少卖的一些策略

完整的订单系统还有订单进度的查看,每台服务器上都有一个任务,定时的从总库存同步余票和库存信息展示给用户,还有用户在订单有效期内不支付,释放订单,补充到库存等等。

我们实现了高并发抢票的核心逻辑,可以说系统设计的非常的巧妙,巧妙的避开了对 DB 数据库 IO 的操作。

对 Redis 网络 IO 的高并发请求,几乎所有的计算都是在内存中完成的,而且有效的保证了不超卖、不少卖,还能够容忍部分机器的宕机。

我觉得其中有两点特别值得学习总结:

①负载均衡,分而治之

通过负载均衡,将不同的流量划分到不同的机器上,每台机器处理好自己的请求,将自己的性能发挥到极致。

这样系统的整体也就能承受极高的并发了,就像工作的一个团队,每个人都将自己的价值发挥到了极致,团队成长自然是很大的。

②合理的使用并发和异步

自 Epoll 网络架构模型解决了 c10k 问题以来,异步越来越被服务端开发人员所接受,能够用异步来做的工作,就用异步来做,在功能拆解上能达到意想不到的效果。

这点在 Nginx、Node.JS、Redis 上都能体现,他们处理网络请求使用的 Epoll 模型,用实践告诉了我们单线程依然可以发挥强大的威力。

服务器已经进入了多核时代,Go 语言这种天生为并发而生的语言,完美的发挥了服务器多核优势,很多可以并发处理的任务都可以使用并发来解决,比如 Go 处理 HTTP 请求时每个请求都会在一个 Goroutine 中执行。

总之,怎样合理的压榨 CPU,让其发挥出应有的价值,是我们一直需要探索学习的方向。

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!