Maison >développement back-end >Tutoriel Python >Une explication de la méthode d'implémentation de la migration du style d'image Python+OpenCV

Une explication de la méthode d'implémentation de la migration du style d'image Python+OpenCV

- 不言avant

- 2018-10-16 14:21:405280parcourir

Le contenu de cet article est d'expliquer la méthode d'implémentation de la migration du style d'image Python+OpenCV. Il a une certaine valeur de référence. Les amis dans le besoin peuvent s'y référer.

Beaucoup de gens aiment désormais prendre des photos (selfies). Vous en aurez assez d'utiliser trop de filtres et de décorations limités, c'est pourquoi il existe des applications qui offrent la fonction d'imiter le style de peintures célèbres, comme prisma, versa, etc., qui peuvent transformer vos photos en Van Gogh, Les styles de maîtres tels que Picasso et Munch.

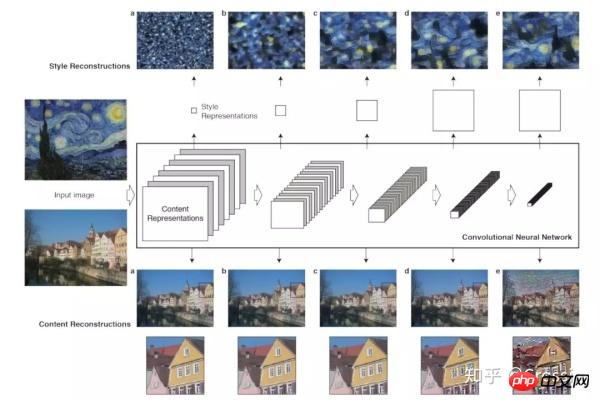

Cette fonction s'appelle "Image Style Transfer", qui est presque entièrement basée sur l'article CVPR 2015 "A Il a été développé sur la base des algorithmes proposés dans Neural Algorithm of Artistic Style et de l'article ECCV 2016 "Perceptual Losses for Real-Time Style Transfer and Super-Resolution", ainsi que des études connexes ultérieures. recherche.

En termes simples, il s'agit d'utiliser le réseau neuronal pour pré-entraîner les styles de peintures célèbres en modèles, puis de les appliquer sur différentes photos pour générer de nouvelles images stylisées.

De "Un algorithme neuronal de style artistique"

Et parce que les réseaux de neurones sont de plus en plus utilisés en vision par ordinateur, le fameux visuel bibliothèque de développement OpenCV a officiellement introduit DNN (Deep Neural Network) dans la version 3.3, prenant en charge les modèles de frameworks grand public tels que Caffe, TensorFlow, Torch/PyTorch, etc., qui peuvent être utilisés pour réaliser la reconnaissance, la détection, et classification, segmentation, coloration et autres fonctions.

J'ai récemment découvert qu'il existe un exemple Python de transfert de style d'image dans l'exemple de code OpenCV (pardonnez mon recul), qui est basé sur l'implémentation du modèle de réseau dans l'article ECCV 2016. Ainsi, même en tant que novice en intelligence artificielle, vous pouvez jouer avec des modèles formés par d’autres et découvrir les merveilles des réseaux de neurones.

(Voir la fin de l'article pour les codes et modèles pertinents)

Adresse officielle du code OpenCV : https://github.com/opencv/opencv/blob/3.4.0/samples/ dnn/fast_neural_style Exécutez le code en exécutant la commande dans le répertoire .py

:

python fast_neural_style.py --model starry_night.t7

model Le paramètre doit fournir le chemin d'accès au fichier de modèle pré-entraîné. ne fournit pas de téléchargements, mais fournit des projets de référence. Vous pouvez trouver

sur https://github.com/jcjohnson/fast-neural-style. Les autres paramètres réglables sont :

- .

inputVous pouvez spécifier l'image originale/ Si la vidéo n'est pas fournie, la caméra sera utilisée pour la capturer en temps réel par défaut. width,height, ajustez la taille de l'image traitée, la réduire peut améliorer la vitesse de calcul. Sur mon propre ordinateur, une vidéo convertie 300 x 200 peut atteindre 15 ips.median_filterLa taille de la fenêtre du filtre médian est utilisée pour lisser l'image résultat. Cela a peu d'impact sur le résultat.

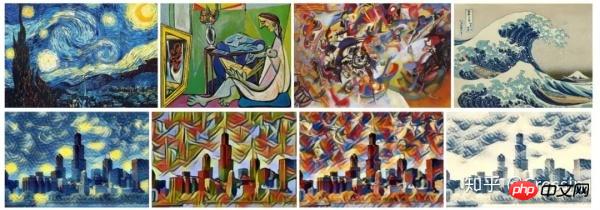

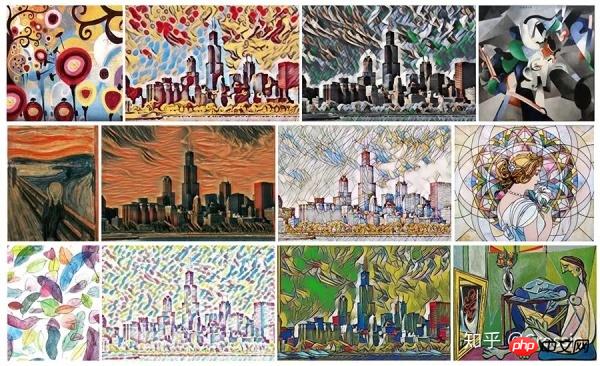

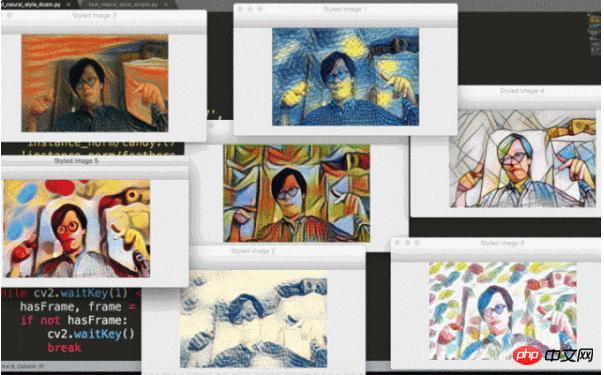

L'effet après exécution (tiré de jcjohnson/fast-neural-style) :

Original Image

Modèles ECCV16

modèles instance_norm

Le code de base est en fait très court, il suffit de charger le modèle-> lire l'image-> effectuer le calcul-> 🎜>

De plus, une version avec comparaison en temps réel de plusieurs effets a été modifiée (le montant du calcul est important et il est très lent), et elle a également été téléchargée dans le code.import cv2

# 加载模型

net = cv2.dnn.readNetFromTorch('the_scream.t7')

net.setPreferableBackend(cv2.dnn.DNN_BACKEND_OPENCV);

# 读取图片

image = cv2.imread('test.jpg')

(h, w) = image.shape[:2]

blob = cv2.dnn.blobFromImage(image, 1.0, (w, h), (103.939, 116.779, 123.680), swapRB=False, crop=False)

# 进行计算

net.setInput(blob)

out = net.forward()

out = out.reshape(3, out.shape[2], out.shape[3])

out[0] += 103.939

out[1] += 116.779

out[2] += 123.68

out /= 255

out = out.transpose(1, 2, 0)

# 输出图片

cv2.imshow('Styled image', out)

cv2.waitKey(0)

PS : Quand j'ai regardé le concert de Zhao Lei il y a deux jours, j'ai aussi dit : Il y a beaucoup de MV de fond pour son concert L'utilisation de la binarisation d'images, de la détection des contours et d'autres opérations me rappelle les grandes tâches des cours de traitement d'images numériques dans le passé... Maintenant que l'efficacité du transfert de style d'image a atteint le temps réel, je pense que ce sera utilisé fréquemment à l’avenir.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!