Maison >développement back-end >Tutoriel Python >Exemple détaillé de python3 utilisant le module de requêtes pour explorer le contenu de la page

Exemple détaillé de python3 utilisant le module de requêtes pour explorer le contenu de la page

- 巴扎黑original

- 2017-09-26 10:39:123509parcourir

Cet article présente principalement la pratique réelle de l'utilisation de python3 pour explorer le contenu d'une page à l'aide du module de requêtes. Il a une certaine valeur de référence. Ceux qui sont intéressés peuvent en savoir plus

1. >

Mon système de bureau personnel utilise Linuxmint. Le système n'a pas installé pip par défaut étant donné que pip sera utilisé pour installer le module de requêtes plus tard, j'installerai pip comme première étape ici.$ sudo apt install python-pipInstallation réussie, vérifiez la version PIP :

$ pip -V

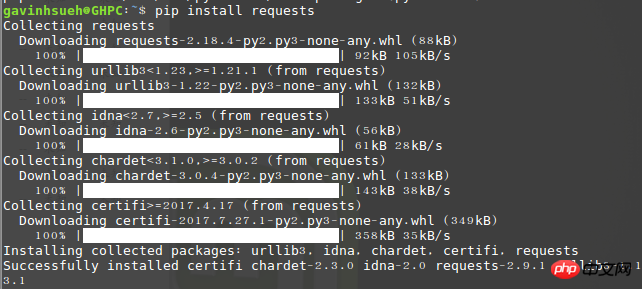

2. Demandes d'installation Module

Ici, je l'ai installé via pip :$ pip install requests

3. Installez beautifulsoup4

Beautiful Soup est un logiciel qui peut être téléchargé à partir de la bibliothèque HTML ou XML Python pour extraire les données des fichiers. Il permet une navigation habituelle dans les documents et des moyens de rechercher et de modifier des documents via votre convertisseur préféré. Beautiful Soup vous fera gagner des heures, voire des jours de travail.$ sudo apt-get install python3-bs4Remarque : j'utilise ici la méthode d'installation python3. Si vous utilisez python2, vous pouvez utiliser la commande suivante pour l'installer.

$ sudo pip install beautifulsoup4

4.Une brève analyse du module de requêtes

1) Envoyer une requête Tout d'abord, bien sûr, importez le module Requêtes :>>> import requestsEnsuite, récupérez la page Web explorée cible. Ici, je prends comme exemple ce qui suit :

>>> r = requests.get('http://www.jb51.net/article/124421.htm')Ici, un objet de réponse nommé r est renvoyé. Nous pouvons obtenir toutes les informations que nous souhaitons à partir de cet objet. Le get ici est la méthode de réponse de http, vous pouvez donc également le remplacer par put, delete, post et head par analogie. 2) Transmettre les paramètres de l'URL Parfois, nous souhaitons transmettre une sorte de données pour la chaîne de requête de l'URL. Si vous créez l'URL à la main, les données sont placées dans l'URL sous forme de paires clé/valeur, suivies d'un point d'interrogation. Par exemple, cnblogs.com/get?key=val. Les requêtes vous permettent d'utiliser l'argument mot-clé params pour fournir ces paramètres sous forme de dictionnaire de chaînes. Par exemple, lorsque nous recherchons sur Google le mot-clé "python crawler", des paramètres tels que newwindow (une nouvelle fenêtre s'ouvre), q et oq (mot-clé de recherche) peuvent être formés manuellement dans l'URL, vous pouvez alors utiliser le code suivant :

>>> payload = {'newwindow': '1', 'q': 'python爬虫', 'oq': 'python爬虫'}

>>> r = requests.get("https://www.google.com/search", params=payload)3) Contenu de la réponse Obtenez le contenu de la réponse de la page via r.text ou r.content.

>>> import requests

>>> r = requests.get('https://github.com/timeline.json')

>>> r.textLes requêtes décodent automatiquement le contenu du serveur. La plupart des jeux de caractères Unicode peuvent être décodés de manière transparente. Voici un petit ajout sur la différence entre r.text et r.content Pour faire simple : resp.text renvoie des données Unicode resp.content renvoie des données en octets. données binaires ; Donc, si vous souhaitez obtenir du texte, vous pouvez transmettre r.text, si vous souhaitez obtenir des images ou des fichiers, vous pouvez transmettre r.content. 4) Obtenez l'encodage de la page Web

>>> r = requests.get('http://www.cnblogs.com/') >>> r.encoding 'utf-8'5) Obtenez le code d'état de la réponse Nous pouvons détecter l'état de la réponse code :

>>> r = requests.get('http://www.cnblogs.com/') >>> r.status_code 200

5. Démonstration de cas

L'entreprise vient d'introduire un système OA récemment, ici j'utilise le page de documentation officielle Prenez ceci comme exemple et capturez uniquement les informations utiles telles que les titres des articles et le contenu de la page. Environnement de démonstrationSystème d'exploitation : linuxmintVersion Python : python 3.5.2Utilisation des modules : requêtes, beautifulsoup4Code Comme suit :#!/usr/bin/env python

# -*- coding: utf-8 -*-

_author_ = 'GavinHsueh'

import requests

import bs4

#要抓取的目标页码地址

url = 'http://www.ranzhi.org/book/ranzhi/about-ranzhi-4.html'

#抓取页码内容,返回响应对象

response = requests.get(url)

#查看响应状态码

status_code = response.status_code

#使用BeautifulSoup解析代码,并锁定页码指定标签内容

content = bs4.BeautifulSoup(response.content.decode("utf-8"), "lxml")

element = content.find_all(id='book')

print(status_code)

print(element)Le programme s'exécute et renvoie le résultat de l'exploration :

À propos du problème des résultats d'exploration tronqués

En fait, au début, j'utilisais directement le python2 fourni avec le système par défaut, mais j'ai longtemps eu du mal avec le problème de l'encodage tronqué du contenu renvoyé, j'ai recherché diverses solutions sur Google, mais toutes étaient inefficaces. Après avoir été "rendu fou" par python2, je n'ai eu d'autre choix que d'utiliser honnêtement python3. Concernant le problème du contenu tronqué dans les pages crawlées en python2, les seniors sont invités à partager leurs expériences pour aider les générations futures comme moi à éviter les détours.Postscript

Python possède de nombreux modules liés aux robots d'exploration, en plus du module de requêtes, il existe également urllib, pycurl et tornado, etc. En comparaison, j'estime personnellement que le module de requêtes est relativement simple et facile à utiliser. Grâce au texte, vous pouvez rapidement apprendre à utiliser le module de requêtes de Python pour explorer le contenu de la page. Mes capacités sont limitées. S'il y a des erreurs dans l'article, n'hésitez pas à m'éclairer. Deuxièmement, si vous avez des questions difficiles sur le contenu de la page explorée par Python, vous êtes également invités à communiquer et à discuter avec tout le monde.Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Déclaration:

Le contenu de cet article est volontairement contribué par les internautes et les droits d'auteur appartiennent à l'auteur original. Ce site n'assume aucune responsabilité légale correspondante. Si vous trouvez un contenu suspecté de plagiat ou de contrefaçon, veuillez contacter admin@php.cn