Maison >développement back-end >Tutoriel Python >Tutoriel d'implémentation du robot d'exploration Python converti en livre électronique PDF

Tutoriel d'implémentation du robot d'exploration Python converti en livre électronique PDF

- 高洛峰original

- 2017-02-21 17:06:151901parcourir

Cet article partage avec vous la méthode et le code d'utilisation du robot d'exploration Python pour convertir le "Tutoriel Python de Liao Xuefeng" en PDF. Les amis dans le besoin peuvent s'y référer

Écrire un robot ne semble pas être plus facile que de l'utiliser. Python. C'est approprié. Il y a tellement d'outils de robot d'exploration fournis par la communauté Python que vous serez ébloui. Avec diverses bibliothèques qui peuvent être utilisées directement, vous pouvez écrire un robot d'exploration en quelques minutes. Tutoriel Python de Liao Xuefeng. Créez un livre électronique PDF que tout le monde pourra lire hors ligne.

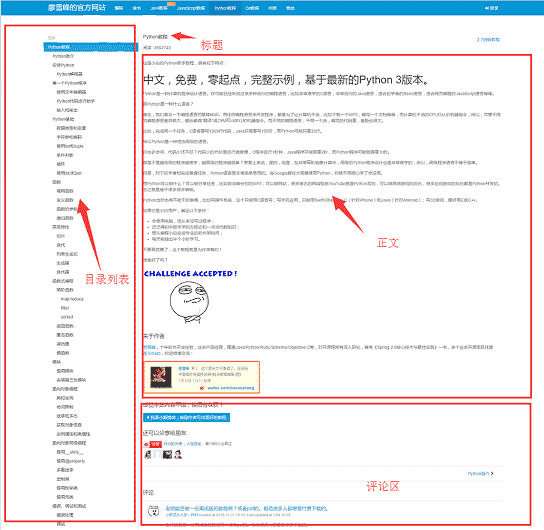

Avant de commencer à écrire un robot, analysons d'abord la structure des pages du site Web 1. Le côté gauche de la page Web est le plan du répertoire du tutoriel. Chaque URL correspond à un article en haut à droite. le côté droit est le titre de l'article, au milieu se trouve la partie texte de l'article, le contenu du texte est au centre de nos préoccupations, les données que nous voulons explorer sont la partie texte de toutes les pages Web, en dessous se trouve la zone de commentaires de l'utilisateur , la zone de commentaire ne nous est d'aucune utilité, nous pouvons donc l'ignorer.

Préparation des outils

Après avoir déterminé la structure de base du site Web, vous pouvez commencer à préparer les kits d'outils dont dépend le robot sur. request et beautifulsoup sont deux artefacts majeurs des robots d'exploration, reuqests est utilisé pour les requêtes réseau et beautifulsoup est utilisé pour exploiter les données HTML. Avec ces deux navettes, nous pouvons travailler rapidement. Nous n'avons pas besoin de frameworks d'exploration comme Scrapy. L'utiliser dans de petits programmes, c'est comme tuer un poulet avec un marteau. De plus, puisque vous convertissez des fichiers HTML en PDF, vous devez également disposer du support de bibliothèque correspondant. wkhtmltopdf est un très bon outil capable de convertir du HTML en PDF adapté à plusieurs plates-formes. pdfkit est le package Python de wkhtmltopdf. Installez d'abord les packages de dépendances suivants,

puis installez wkhtmltopdf

pip install requests pip install beautifulsoup pip install pdfkit

installez wkhtmltopdf

Pour la plate-forme Windows, téléchargez la version stable directement depuis le site officiel de wkhtmltopdf 2 et installez-la une fois l'installation terminée, ajoutez le chemin d'exécution du programme à la variable $PATH de l'environnement système. Sinon, pdfkit ne trouve pas wkhtmltopdf et l'erreur ". Aucun exécutable wkhtmltopdf trouvé" apparaîtra. Ubuntu et CentOS peuvent être installés directement à l'aide de la ligne de commande

$ sudo apt-get install wkhtmltopdf # ubuntu $ sudo yum intsall wkhtmltopdf # centos

Implémentation du Crawler

Quand tout est prêt Vous pouvez commencer à coder, mais vous devez faire le tri dans vos pensées avant d'écrire du code. Le but du programme est de sauvegarder localement les parties de texte html correspondant à toutes les URL, puis d'utiliser pdfkit pour convertir ces fichiers en fichier pdf. Divisons la tâche. Tout d'abord, enregistrons localement le texte html correspondant à une certaine URL, puis recherchons toutes les URL et effectuons la même opération.

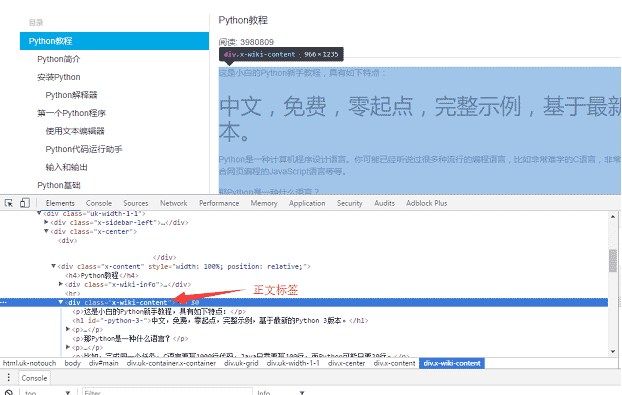

Utilisez le navigateur Chrome pour rechercher la balise dans la partie corps de la page, et appuyez sur F12 pour trouver la balise p correspondant au corps : 05ff9a9e18a7aecf8acff32163179ec7, où p est le contenu du corps de la page Web. Après avoir utilisé des requêtes pour charger la page entière localement, vous pouvez utiliser beautifulsoup pour faire fonctionner l'élément HTML dom afin d'extraire le contenu du texte.

Le code d'implémentation spécifique est le suivant : utilisez la fonction soupe.find_all pour rechercher la balise de texte, puis enregistrez le contenu de la partie texte dans le fichier a.html.

def parse_url_to_html(url):

response = requests.get(url)

soup = BeautifulSoup(response.content, "html5lib")

body = soup.find_all(class_="x-wiki-content")[0]

html = str(body)

with open("a.html", 'wb') as f:

f.write(html)

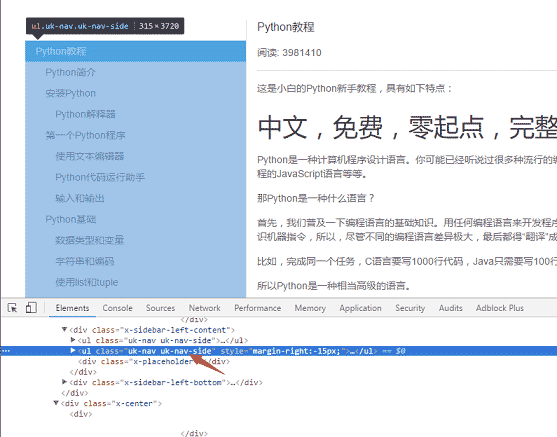

La deuxième étape consiste à analyser toutes les URL sur le côté gauche de la page. Utilisez la même méthode pour trouver l'étiquette du menu de gauche 818516a2aea8c5412fd444e4ed52d34a

La logique spécifique d'implémentation du code : car il existe deux attributs de classe de uk-nav et uk-nav-side sur la page, et la véritable liste du répertoire est la deuxième. Toutes les URL ont été obtenues et la fonction de conversion des URL en HTML a été écrite dans un premier temps.

def get_url_list():

"""

获取所有URL目录列表

"""

response = requests.get("http://www.liaoxuefeng.com/wiki/0014316089557264a6b348958f449949df42a6d3a2e542c000")

soup = BeautifulSoup(response.content, "html5lib")

menu_tag = soup.find_all(class_="uk-nav uk-nav-side")[1]

urls = []

for li in menu_tag.find_all("li"):

url = "http://www.liaoxuefeng.com" + li.a.get('href')

urls.append(url)

return urls

La dernière étape consiste à convertir le code HTML en fichier pdf. La conversion en fichier pdf est très simple, car pdfkit a encapsulé toute la logique. Il vous suffit d'appeler la fonction pdfkit.from_file

def save_pdf(htmls):

"""

把所有html文件转换成pdf文件

"""

options = {

'page-size': 'Letter',

'encoding': "UTF-8",

'custom-header': [

('Accept-Encoding', 'gzip')

]

}

pdfkit.from_file(htmls, file_name, options=options)

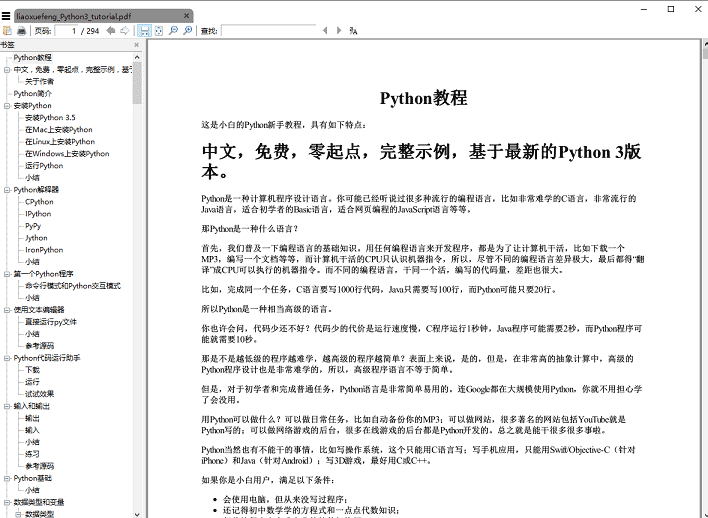

pour l'exécuter. la fonction save_pdf, le fichier pdf e-book est généré, le rendu :

Résumé

Le montant total du code s'additionne à moins de 50 lignes. Cependant, attendez une minute. En fait, le code donné ci-dessus omet certains détails, par exemple, comment obtenir le titre de l'article. La balise img du contenu du texte utilise un chemin relatif. pour afficher l'image normalement dans le PDF, vous devez changer le chemin relatif en Chemins absolus et les fichiers html temporaires enregistrés doivent être supprimés

Pour plus de tutoriels d'implémentation de robots d'exploration Python convertis en livres électroniques PDF, veuillez faire attention au site Web PHP chinois !