Périphériques technologiques

Périphériques technologiques IA

IA Construire un chiffon agentique multi-documents à l'aide de Llamaindex

Construire un chiffon agentique multi-documents à l'aide de LlamaindexIntroduction

Dans le domaine en évolution rapide de l'intelligence artificielle, la capacité de traiter et de comprendre de grandes quantités d'informations devient de plus en plus cruciale. Entrez le chiffon agentique multi-documents - une approche puissante qui combine la génération (RAG) (RAG) de la récupération avec des systèmes basés sur des agents pour créer une IA qui peut raisonner sur plusieurs documents. Ce guide vous guidera à travers le concept, la mise en œuvre et le potentiel de cette technologie passionnante.

Objectifs d'apprentissage

- Comprendre les principes fondamentaux des systèmes de chiffon agentiques à plusieurs documents et leur architecture.

- Découvrez comment les intégres et le raisonnement basé sur les agents améliorent la capacité d'AI à générer des réponses contextuellement précises.

- Explorez les mécanismes de récupération avancés qui améliorent l'extraction des informations dans les applications à forte intensité de connaissances.

- Gardez un aperçu des applications du chiffon agentique multi-documents dans des domaines complexes comme la recherche et l'analyse juridique.

- Développer la capacité d'évaluer l'efficacité des systèmes de RAG dans la génération et l'analyse du contenu axées sur l'IA.

Cet article a été publié dans le cadre du Blogathon de la science des données.

Table des matières

- Comprendre le chiffon et les agents multi-documents

- Pourquoi le chiffon agentique multi-documents change la donne?

- Forces clés des systèmes de chiffon agentiques multi-documents

- Blocs-Bloods of Multi-Document Agent Chag

- Implémentation d'un chiffon agentique de base à plusieurs documents

- Étape 1: Installation des bibliothèques requises

- Étape2: Configuration des clés API et des variables d'environnement

- Étape 3: Téléchargement des documents

- Étape 4: Création d'un vecteur et d'un outil de résumé

- Étape 5: Création de l'agent

- Étape 6: Analyser les réponses de l'agent

- Explication de l'interaction de l'agent avec les papiers Longlora

- Explication du comportement de l'agent: résumer l'auto-rag et Longlora

- Défis et considérations

- Questions fréquemment posées

Comprendre le chiffon et les agents multi-documents

La génération (RAG) de la récupération (RAG) est une technique qui améliore les modèles de langue en leur permettant d'accéder et d'utiliser des connaissances externes. Au lieu de s'appuyer uniquement sur leurs paramètres formés, les modèles de chiffon peuvent récupérer des informations pertinentes à partir d'une base de connaissances pour générer des réponses plus précises et éclairées.

Le chiffon agentique multi-documents va plus loin ce concept en permettant à un agent d'IA de travailler simultanément avec plusieurs documents. Cette approche est particulièrement précieuse pour les tâches qui nécessitent la synthèse d'informations provenant de diverses sources, telles que la recherche universitaire, l'analyse du marché ou l'examen des documents juridiques.

Pourquoi le chiffon agentique multi-documents change la donne?

Comprenons pourquoi le chiffon agentique multi-documents change la donne.

- Compréhension plus intelligente du contexte : Imaginez avoir un assistant super intelligent qui ne lise pas seulement un livre, mais une bibliothèque entière pour répondre à votre question. C'est ce que signifie une compréhension contextuelle améliorée. En analysant plusieurs documents, l'IA peut reconstituer une image plus complète, vous donnant des réponses qui capturent vraiment la vue d'ensemble.

- Boost de précision pour les tâches délicates : nous avons tous joué «Connect the Dots» en tant qu'enfants. Le chiffon agentique multi-documents fait quelque chose de similaire, mais avec des informations. En connectant les faits provenant de diverses sources, il peut s'attaquer aux problèmes complexes avec une plus grande précision. Cela signifie des réponses plus fiables, en particulier lorsqu'ils traitent des sujets complexes.

- Gestion de la surcharge d'informations comme un pro : Dans le monde d'aujourd'hui, nous nous noyons dans les données. Le chiffon agentique multi-documents est comme un filtre suralimenté, passant à travers des quantités massives d'informations pour trouver ce qui est vraiment pertinent. C'est comme avoir une équipe d'experts travaillant 24 heures sur 24 pour digérer et résumer de vastes bibliothèques de connaissances.

- Base de connaissances adaptable et grandissable : Considérez cela comme un cerveau numérique qui peut facilement apprendre et se développer. À mesure que de nouvelles informations deviennent disponibles, le chiffon agentique multi-documents peut les incorporer de manière transparente. Cela signifie que votre assistant d'IA est toujours à jour, prêt à répondre aux dernières questions avec les informations les plus fraîches.

Forces clés des systèmes de chiffon agentiques multi-documents

Nous allons désormais examiner les principales forces des systèmes de chiffon agentiques multi-documents.

- Recherche académique suralimente : Les chercheurs passent souvent des semaines ou des mois à synthétiser des informations de centaines d'articles. Le chiffon agentique multi-documents peut accélérer considérablement ce processus, aidant les chercheurs à identifier rapidement les tendances clés, les lacunes dans les connaissances et les percées potentielles dans de vastes corps de littérature.

- Révolutionner l'analyse des documents juridiques : les avocats traitent des montagnes de dossiers de cas, de contrats et de précédents juridiques. Cette technologie peut analyser rapidement des milliers de documents, repérer les détails critiques, les incohérences et la jurisprudence pertinents qui pourraient prendre des jours ou des semaines d'équipe humaine.

- Intelligence du marché de la turbocompression : les entreprises doivent rester en avance sur les tendances et la concurrence. Le chiffon agentique multi-documents peut en permanence des articles de presse, des médias sociaux et des rapports de l'industrie, fournissant des informations en temps réel et aidant les entreprises à prendre des décisions basées sur les données plus rapidement que jamais.

- Navigation de documentation technique avec facilité : pour les ingénieurs et les professionnels de l'informatique, trouver les bonnes informations dans la documentation technique tentaculaire peut être comme la recherche d'une aiguille dans une botte de foin. Cette approche alimentée par l'IA peut rapidement identifier les sections pertinentes sur plusieurs manuels, le dépannage des guides et des référentiels de code, économisant d'innombrables heures de frustration.

Blocs-Bloods of Multi-Document Agent Chag

Imaginez que vous construisez un assistant de bibliothèque numérique super intelligent. Cet assistant peut lire des milliers de livres, comprendre des questions complexes et vous donner des réponses détaillées en utilisant des informations provenant de plusieurs sources. C'est essentiellement ce que fait un système de chiffon agentique multi-documents. Décomposons les composants clés qui rendent cela possible:

Traitement des documents

Convertit tous les types de documents (PDF, pages Web, fichiers Word, etc.) en un format que notre IA peut comprendre.

Créer des intérêts

Transforme le texte traité en vecteurs numériques (séquences de nombres) qui représentent le sens et le contexte de l'information.

En termes simples, imaginez créer un résumé super condensé de chaque paragraphe de votre bibliothèque, mais au lieu de mots, vous utilisez un code unique. Ce code capture l'essence des informations d'une manière que les ordinateurs peuvent rapidement comparer et analyser.

Indexage

Il crée une structure efficace pour stocker et récupérer ces intérêts. C'est comme créer le catalogue de cartes le plus efficace au monde pour notre bibliothèque numérique. Il permet à notre IA de localiser rapidement les informations pertinentes sans avoir à scanner chaque document en détail.

Récupération

Il utilise la requête (votre question) pour trouver les informations les plus pertinentes des intérêts indexés. Lorsque vous posez une question, ce composant se déroule via notre bibliothèque numérique, en utilisant ce catalogue de cartes super efficace pour retirer toutes les informations potentiellement pertinentes.

Raisonnement basé sur des agents

Un agent d'IA interprète les informations récupérées dans le contexte de votre requête, décidant comment l'utiliser pour formuler une réponse. C'est comme avoir un agent de génie AI qui trouve non seulement les bons documents mais qui comprend également le sens plus profond de votre question. Ils peuvent connecter des points entre différentes sources et trouver la meilleure façon de vous répondre.

Génération

Il produit une réponse lisible par l'homme basée sur le raisonnement de l'agent et les informations récupérées. C'est là que notre agent de génie vous explique leurs résultats dans un langage clair et concis. Ils prennent toutes les informations complexes qu'ils ont recueillies et analysées, et les présentent d'une manière qui répond directement à votre question.

Cette combinaison puissante permet aux systèmes de chiffon agentiques multi-documents de fournir des informations et des réponses qui s'appuient sur un vaste bassin de connaissances, ce qui les rend incroyablement utiles pour des recherches complexes, des analyses et des tâches de résolution de problèmes dans de nombreux domaines.

Implémentation d'un chiffon agentique de base à plusieurs documents

Commençons par construire un chiffon agentique simple qui peut fonctionner avec trois papiers universitaires. Nous utiliserons la bibliothèque lama_index, qui fournit des outils puissants pour construire des systèmes de chiffon.

Étape 1: Installation des bibliothèques requises

Pour commencer avec la construction de votre agent d'IA, vous devez installer les bibliothèques nécessaires. Voici les étapes pour configurer votre environnement:

- Installez Python: assurez-vous que Python soit installé sur votre système. Vous pouvez le télécharger sur le site officiel de Python: Télécharger Python

- Configurez un environnement virtuel: il est bonne pratique pour créer un environnement virtuel pour que votre projet gére les dépendances. Exécutez les commandes suivantes pour configurer un environnement virtuel:

python -m venv ai_agent_env source ai_agent_env / bin / activer # sur windows, utilisez `ai_agent_env \ scripts \ active`

- Installez API Openai et Llamaindex:

pip install openai llama-index == 0.10.27 lama-index-llms-openai == 0,1,15 pip install lama-index-embeddings-openai == 0,1,7

Étape2: Configuration des clés API et des variables d'environnement

Pour utiliser l'API OpenAI, vous avez besoin d'une clé API. Suivez ces étapes pour configurer votre clé API:

- Obtenez une clé API: Inscrivez-vous à un compte sur le site Web OpenAI et obtenez votre clé API à la section API.

- Configurez les variables d'environnement: stockez votre clé API dans une variable d'environnement pour la sécuriser. Ajoutez la ligne suivante à votre fichier .bashrc ou .zshrc (ou utilisez la méthode appropriée pour votre système d'exploitation)

exporter openai_api_key = 'your_openai_api_key_here'

- Accédez à la clé API dans votre code: dans votre code Python, importez les bibliothèques nécessaires et accédez à la clé API à l'aide du module OS

Importer un système d'exploitation

Importer Openai

Importer Nest_asyncio

de lama_index.core.node_parser importation de phrasesplitter

De Llama_index.core.tools Import FunctionTool, QueryEnginetool

de lama_index.core.vector_stores Importer des métadatafilters, FilterCondition

De Llama_index.core.Agent Import FunctionCallingAgentworker

De Llama_index.core.Agent Import Agentrunner

à partir de la liste des importations, facultative

sous-processus d'importation

openai.api_key = os.getenv ('openai_api_key')

# optionnellement, vous pouvez simplement ajouter directement la clé Openai. (pas une bonne pratique)

# openai.api_key = 'your_openai_api_key_here'

nest_asyncio.apply ()

Étape 3: Téléchargement des documents

Comme indiqué précédemment, je n'utilise que trois articles pour faire ce chiffon agentique, nous réduisons plus tard ce chiffon agentique à plus de papiers dans un autre blog. Vous pouvez utiliser vos propres documents (éventuellement).

# Liste des URL à télécharger

URL = [

"https://openreview.net/pdf?id=vtmbagcn7o",

"https://openreview.net/pdf?id=6pmjorfdak",

"https://openreview.net/pdf?id=hsyw5go0v8",

]]

# Des noms de fichiers correspondants pour enregistrer les fichiers en tant que

papiers = [

"metagpt.pdf",

"longlora.pdf",

"selfrag.pdf",

]]

# Loop sur les deux listes et télécharger chaque fichier avec son nom respectif

Pour URL, papier dans ZIP (URL, papiers):

sub-process.run (["wget", url, "-o", papier])

Étape 4: Création d'un vecteur et d'un outil de résumé

La fonction ci-dessous, get_doc_tools, est conçue pour créer deux outils: un outil de requête vectorielle et un outil de requête récapitulative. Ces outils aident à interroger et à résumer un document à l'aide d'une approche de génération (RAG) basée sur des agents (RAG). Voici les étapes et leurs explications.

def get_doc_tools (

file_path: str,

Nom: Str,

) -> str:

"" "Obtenez des outils de requête vectorielle et de résumé d'un document." ""

Chargement des documents et préparation à l'indexation des vecteurs

La fonction commence par charger le document à l'aide de SimpledirectoryReader, qui prend le fichier fourni_path fourni et lit le contenu du document. Une fois le document chargé, il est traité par SentendingPlitter, qui divise le document en morceaux plus petits ou nœuds, chacun contenant jusqu'à 1024 caractères. Ces nœuds sont ensuite indexés à l'aide de VectorStoreIndex, un outil qui permet des requêtes efficaces basées sur un vecteur. Cet index sera plus tard utilisé pour effectuer des recherches sur le contenu du document en fonction de la similitude vectorielle, ce qui facilite la récupération des informations pertinentes.

# Chargez des documents à partir du chemin du fichier spécifié Documents = SimpleDirectoryReader (input_files = [file_path]). Load_data () # Divisez le document chargé en morceaux plus petits (nœuds) de 1024 caractères SPLITTER = SENDENSPLITTER (Chunk_Size = 1024) nœuds = splitter.get_nodes_from_documents (documents) # Créez un index vectoriel à partir des nœuds pour des requêtes efficaces basées sur un vecteur vector_index = vectorstoreIndex (nœuds)

Définition de la fonction de requête vectorielle

Ici, la fonction définit Vector_Query, qui est responsable de répondre à des questions spécifiques sur le document. La fonction accepte une chaîne de requête et une liste facultative des numéros de page. Si aucun numéro de page n'est fourni, l'ensemble du document est interrogé. La fonction vérifie d'abord si Page_numbers est fournie; Sinon, il est par défaut une liste vide.

Ensuite, il crée des filtres de métadonnées qui correspondent aux numéros de page spécifiés. Ces filtres aident à réduire la recherche vers des parties spécifiques du document. Le Query_Engine est créé à l'aide de l'index vectoriel et est configuré pour utiliser ces filtres, ainsi qu'un seuil de similitude, pour trouver les résultats les plus pertinents. Enfin, la fonction exécute la requête à l'aide de ce moteur et renvoie la réponse.

# fonction de requête vectorielle

DEF Vector_Query (

requête: str,

page_numbres: facultatif [list [str]] = aucun

) -> str:

"" "Utiliser pour répondre aux questions sur un papier donné.

Utile si vous avez des questions spécifiques sur le document.

Laissez toujours Page_numbers comme aucun à moins qu'il n'y ait une page spécifique que vous souhaitez rechercher.

Args:

requête (str): la requête de chaîne à intégrer.

Page_Numbers (facultatif [list [str]]): filtrez par jeu de pages. Partir comme aucun

Si nous voulons effectuer une recherche vectorielle

sur toutes les pages. Sinon, filtrez par l'ensemble des pages spécifiées.

"" "

page_numbers = page_numbers ou []

métadata_dicts = [

{"key": "page_label", "valeur": p} pour p dans page_numbers

]]

Query_Engine = vector_index.as_query_engine (

similitude_top_k = 2,

filtres = métadatafilters.from_dicts (

Metadata_dicts,

condition = filtercondition.or

)

)

réponse = query_engine.query (Query)

Réponse de retour

Création de l'outil de requête vectorielle

Cette partie de la fonction crée le vector_query_tool, un outil qui relie la fonction Vector_Query précédemment définie à un nom généré dynamiquement en fonction du paramètre de nom fourni lors de l'appel GET_DOC_TOOLS.

L'outil est créé à l'aide de functiontool.from_defaults, qui le configure automatiquement avec les valeurs par défaut nécessaires. Cet outil peut désormais être utilisé pour effectuer des requêtes basées sur des vecteurs via le document en utilisant la fonction définie précédemment.

# Création de l'outil de requête vectorielle

vector_query_tool = functiontool.from_defaults (

name = f "vector_tool_ {name}",

fn = vector_query

)

Création de l'outil de requête récapitulative

Dans cette dernière section, la fonction crée un outil pour résumer le document. Tout d'abord, il crée un résumé de l'Index à partir des nœuds qui étaient auparavant divisés et indexés. Cet index est conçu spécifiquement pour les tâches de résumé. Le Summary_Query_Engine est ensuite créé avec un mode de réponse de "Tree_Summaze", qui permet à l'outil de générer des résumés concis du contenu du document.

Le résumé_tool est finalement créé à l'aide de QueryEnginetool.from_defaults, qui relie le moteur de requête à un nom généré dynamiquement en fonction du paramètre de nom. L'outil reçoit également une description indiquant son objectif pour les requêtes liées au résumé. Cet outil de résumé peut désormais être utilisé pour générer des résumés du document en fonction des requêtes utilisateur.

# Outil de requête sommaire

résumé_index = résumé (nœuds)

Summary_Query_Engine = Summary_index.as_Query_Engine (

réponse_mode = "arbre_summarisé",

use_async = true,

)

résumé_tool = queryenginetool.from_defaults (

name = f "Summary_tool_ {name}",

Query_Engine = Summary_Query_Engine,

Description = (

f "Utile pour les questions de résumé liées à {nom}"

),

)

return vector_query_tool, résumé_tool

Fonction d'appel pour créer des outils pour chaque article

Paper_to_tools_dict = {}

pour le papier dans les papiers:

print (f "Obtenir des outils pour papier: {papier}")

vector_tool, résumé_tool = get_doc_tools (papier, chemin (papier) .stem)

Paper_to_tools_dict [papier] = [vector_tool, résumé_tool]

initial_tools = [t pour papier dans les papiers pour t dans papier_to_tools_dict [papier]]

Len (initial_tools)

Ce code traite chaque article et crée deux outils pour chacun: un outil vectoriel pour la recherche sémantique et un outil de résumé pour générer des résumés concis, dans ce cas 6 outils.

Étape 5: Création de l'agent

Plus tôt, nous avons créé des outils à utiliser pour l'agent, nous allons maintenant créer votre agent à l'aide de la classe FunctionCallAgentFormentor. Nous utiliserions «GPT-3.5-Turbo» comme notre LLM.

llm = openai (modèle = "gpt-3.5-turbo")

agent_worker = functioncallingagentworker.from_tools (

initial_tools,

llm = llm,

Verbose = vrai

)

agent = agentrunner (agent_worker)

Cet agent peut désormais répondre aux questions sur les trois articles que nous avons traités.

Étape 6: Analyser les réponses de l'agent

Nous avons posé à notre agent différentes questions des trois articles, et voici sa réponse. Voici des exemples et des explications de la façon dont il fonctionne à l'intérieur.

Explication de l'interaction de l'agent avec les papiers Longlora

Dans cet exemple, nous avons interrogé notre agent pour extraire des informations spécifiques de trois articles de recherche, en particulier sur l'ensemble de données d'évaluation et les résultats utilisés dans l'étude Longlora. L'agent interagit avec les documents à l'aide de l'outil de requête vectorielle, et voici comment il traite les informations étape par étape:

- Entrée de l'utilisateur: l'utilisateur a posé deux questions séquentielles concernant l'aspect d'évaluation de Longlora: d'abord sur l'ensemble de données d'évaluation, puis sur les résultats.

- Exécution de la requête de l'agent: l'agent identifie qu'il doit rechercher le document Longlora spécifiquement pour des informations sur l'ensemble de données d'évaluation. Il utilise la fonction vector_tool_longlora, qui est l'outil de requête vectorielle configuré spécifiquement pour Longlora.

=== Fonction d'appel ===

Fonction d'appel: vector_tool_longlora avec args: {"Query": "Ensemble de données d'évaluation"}

- Sortie de fonction pour l'évaluation de l'évaluation: l'agent récupère la section pertinente du document, identifiant que l'ensemble de données d'évaluation utilisé dans Longlora est la «division de test PG19», qui est un ensemble de données couramment utilisé pour l'évaluation du modèle de langue en raison de sa nature de texte longue.

- Deuxième exécution de la requête de l'agent: après la première réponse, l'agent traite ensuite la deuxième partie de la question de l'utilisateur, interrogeant le document sur les résultats d'évaluation de Longlora.

=== Fonction d'appel ===

Fonction d'appel: vector_tool_longlora avec args: {"Query": "Résultats de l'évaluation"}

- Sortie de fonction pour les résultats de l'évaluation: l'agent renvoie des résultats détaillés montrant comment les modèles fonctionnent mieux en termes de perplexité avec des tailles de contexte plus grandes. Il met en évidence les résultats clés, tels que des améliorations avec des fenêtres de contexte plus grandes et des longueurs de contexte spécifiques (100k, 65536 et 32768). Il note également un compromis, car les modèles étendus éprouvent une dégradation de perplexité sur des tailles de contexte plus petites en raison de l'interpolation de position - une limitation courante dans de tels modèles.

- Réponse LLM finale: l'agent synthétise les résultats en une réponse concise qui répond à la question initiale sur l'ensemble de données. Une explication plus approfondie des résultats de l'évaluation suivrait, résumant les résultats des performances et leurs implications.

Quelques autres exemples pour d'autres articles

Explication du comportement de l'agent: résumer l'auto-rag et Longlora

Dans ce cas, l'agent a été chargé de fournir des résumés à la fois sur l'auto-rag et Longlora. Le comportement observé dans ce cas diffère de l'exemple précédent:

Utilisation de l'outil de résumé

=== Fonction d'appel ===

Fonction d'appel: résumé_tool_selfrag avec args: {"entrée": "auto-rag"}

Contrairement à l'exemple précédent, qui impliquait d'interroger des détails spécifiques (comme les ensembles de données et les résultats d'évaluation), l'agent a directement utilisé les fonctions Summary_tool conçues pour l'auto-rag et Longlora. Cela montre la capacité de l'agent à basculer de manière adaptative entre les outils de requête en fonction de la nature de la question - optant pour une résumé lorsqu'un aperçu plus large est requis.

Appels distincts pour séparer les outils de résumé

=== Fonction d'appel ===

Fonction d'appel: résumé_tool_longlora avec args: {"entrée": "longlora"}

L'agent a appelé séparément résumé_tool_selfrag et résumé_tool_longlora pour obtenir les résumés, démontrant sa capacité à gérer efficacement les requêtes en plusieurs parties. Il identifie la nécessité d'engager des outils de résumé distincts adaptés à chaque article plutôt que d'exécuter une seule récupération combinée.

Concision et franchise des réponses

Les réponses fournies par l'agent étaient concises et adressées directement à l'invite. Cela indique que l'agent peut extraire efficacement les informations de haut niveau, contrastant avec l'exemple précédent où il a fourni des points de données plus granulaires basés sur des requêtes vectorielles spécifiques.

Cette interaction met en évidence la capacité de l'agent à fournir des aperçus de haut niveau par rapport aux réponses détaillées et spécifiques au contexte observées précédemment. Ce changement de comportement souligne la polyvalence du système de chiffon agentique dans l'ajustement de sa stratégie de requête en fonction de la nature de la question de l'utilisateur - qu'il s'agisse d'un besoin de détails approfondis ou d'un large résumé.

Défis et considérations

Bien que le chiffon agentique multi-documents soit puissant, il y a certains défis à garder à l'esprit:

- Évolutivité: à mesure que le nombre de documents augmente, l'indexation et la récupération efficaces deviennent cruciales.

- Cohérence: s'assurer que l'agent produit des réponses cohérentes lors de l'intégration d'informations provenant de plusieurs sources.

- Biais et précision: la sortie du système n'est aussi bonne que ses documents d'entrée et son mécanisme de récupération.

- Ressources informatiques: le traitement et l'intégration d'un grand nombre de documents peuvent être à forte intensité de ressources.

Conclusion

Le chiffon agentique multi-documents représente une progression significative dans le domaine de l'IA, permettant des réponses plus précises et consacrées au contexte en synthétisant des informations provenant de plusieurs sources. Cette approche est particulièrement précieuse dans des domaines complexes comme la recherche, l'analyse juridique et la documentation technique, où la récupération et le raisonnement précis sont cruciaux. En tirant parti des intérêts, du raisonnement basé sur des agents et des mécanismes de récupération robustes, ce système améliore non seulement la profondeur et la fiabilité du contenu généré par l'IA, mais ouvre également la voie à des applications plus sophistiquées dans les industries à forte intensité de connaissances. Alors que la technologie continue d'évoluer, le chiffon agentique multi-documents est prêt à devenir un outil essentiel pour extraire des informations significatives à partir de grandes quantités de données.

Principaux à retenir

- Le chiffon agentique multi-documents améliore la précision de la réponse de l'IA en intégrant les informations provenant de plusieurs sources.

- Les intégres et le raisonnement basé sur des agents améliorent la capacité du système à générer du contenu contextuel et fiable.

- Le système est particulièrement précieux dans des domaines complexes comme la recherche, l'analyse juridique et la documentation technique.

- Les mécanismes avancés de récupération garantissent une extraction précise d'informations, soutenant les industries à forte intensité de connaissances.

- Le chiffon agentique multi-documents représente un pas en avant significatif dans la génération de contenu et l'analyse des données basée sur l'IA.

Questions fréquemment posées

Q1. Qu'est-ce que le chiffon agentique multi-documents?A. Rag d'agence multi-documents combine la génération (RAG) de la récupération (RAG) avec des systèmes basés sur des agents pour permettre à l'IA de raisonner sur plusieurs documents.

Q2. Comment le chiffon agentique multi-documents améliore-t-il la précision?A. Il améliore la précision en synthétisant les informations provenant de diverses sources, permettant à l'IA de connecter des faits et de fournir des réponses plus précises.

Q3. Dans quels domaines le chiffon agentique multi-documents est-il le plus bénéfique?A. Il est particulièrement précieux dans la recherche universitaire, l'analyse des documents juridiques, l'intelligence du marché et la documentation technique.

Q4. Quels sont les composants clés d'un système de chiffon agentique multi-documents?A. Les composants clés incluent le traitement des documents, la création d'incorporation, l'indexation, la récupération, le raisonnement basé sur les agents et la génération.

Q5. Quel est le rôle des intérêts dans ce système?A. Les intérêts convertissent le texte en vecteurs numériques, capturant le sens et le contexte d'informations pour une comparaison et une analyse efficaces.

Les médias présentés dans cet article ne sont pas détenus par l'analytique vidhya et sont utilisés à la discrétion de l'auteur.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

7 L'IA puissante invite à chaque chef de projet doit maîtriser maintenantMay 08, 2025 am 11:39 AM

7 L'IA puissante invite à chaque chef de projet doit maîtriser maintenantMay 08, 2025 am 11:39 AML'IA générative, illustrée par des chatbots comme Chatgpt, offre aux chefs de projet des outils puissants pour rationaliser les workflows et s'assurer que les projets restent dans les horaires et dans le budget. Cependant, une utilisation efficace dépend de l'élaboration des bonnes invites. Précis, détail

Définir la signification mal définie de l'AGI insaisissable via l'assistance utile de l'IA elle-mêmeMay 08, 2025 am 11:37 AM

Définir la signification mal définie de l'AGI insaisissable via l'assistance utile de l'IA elle-mêmeMay 08, 2025 am 11:37 AMLe défi de définir l'intelligence générale artificielle (AGI) est significative. Les allégations de progrès AGI n'ont souvent pas de référence claire, avec des définitions adaptées à l'adaptation des instructions de recherche prédéterminées. Cet article explore une nouvelle approche de définir

IBM Think 2025 présente le rôle de Watsonx.Data dans l'IA générativeMay 08, 2025 am 11:32 AM

IBM Think 2025 présente le rôle de Watsonx.Data dans l'IA générativeMay 08, 2025 am 11:32 AMIBM Watsonx.Data: rationalisation de la pile de données de l'IA d'entreprise IBM positionne Watsonx.Data comme plate-forme pivot pour les entreprises visant à accélérer la livraison de solutions d'interface utilisateur génératrices précises et évolutives. Ceci est réalisé en simplifiant le complat

La montée des machines robotiques humanoïdes approche.May 08, 2025 am 11:29 AM

La montée des machines robotiques humanoïdes approche.May 08, 2025 am 11:29 AMLes progrès rapides de la robotique, alimentés par des percées dans l'IA et la science des matériaux, sont sur le point d'inaugurer une nouvelle ère de robots humanoïdes. Pendant des années, l'automatisation industrielle a été l'objectif principal, mais les capacités des robots sont rapidement exp

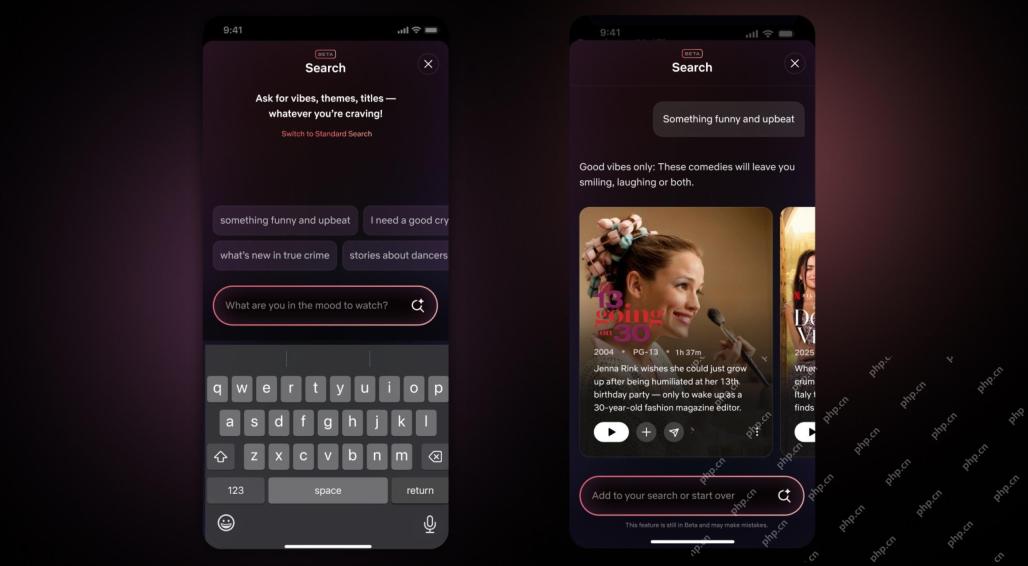

Interface Netflix Repamps - Débutant les outils de recherche AI et la conception de type TiktokMay 08, 2025 am 11:25 AM

Interface Netflix Repamps - Débutant les outils de recherche AI et la conception de type TiktokMay 08, 2025 am 11:25 AMLa plus grande mise à jour de l'interface Netflix en une décennie: plus intelligente, plus personnalisée, adoptant un contenu diversifié Netflix a annoncé sa plus grande refonte de son interface utilisateur en une décennie, non seulement un nouveau look, mais ajoute également plus d'informations sur chaque émission, et introduit des outils de recherche d'IA plus intelligents qui peuvent comprendre des concepts vagues tels que des événements "ambiants" et des structures plus flexibles pour mieux démontrer l'intérêt de l'entreprise pour les jeux vidéo émergents, les événements en direct, les événements sportifs et d'autres nouveaux types de contenu. Pour suivre la tendance, le nouveau composant vidéo vertical sur mobile permettra aux fans de faire défiler les bandes-annonces et de clips, de regarder le spectacle complet ou de partager du contenu avec d'autres. Cela vous rappelle le défilement infini et le site Web vidéo très réussi TI

Bien avant AGI: trois étapes de l'IA qui vous défierontMay 08, 2025 am 11:24 AM

Bien avant AGI: trois étapes de l'IA qui vous défierontMay 08, 2025 am 11:24 AMLa discussion croissante de l'intelligence générale (AGI) dans l'intelligence artificielle a incité beaucoup à réfléchir à ce qui se passe lorsque l'intelligence artificielle dépasse l'intelligence humaine. Que ce moment soit proche ou éloigné dépend de qui vous demandez, mais je ne pense pas que ce soit la jalon la plus importante sur laquelle nous devrions nous concentrer. Quels jalons d'IA antérieurs affecteront tout le monde? Quels jalons ont été franchis? Voici trois choses qui, selon moi. L'intelligence artificielle dépasse les faiblesses humaines Dans le film de 2022 "Social Dilemma", Tristan Harris du Center for Humane Technology a souligné que l'intelligence artificielle a dépassé les faiblesses humaines. Qu'est-ce que cela signifie? Cela signifie que l'intelligence artificielle a pu utiliser les humains

Venkat Achanta sur la transformation de la plate-forme de TransUnion et l'ambition de l'IAMay 08, 2025 am 11:23 AM

Venkat Achanta sur la transformation de la plate-forme de TransUnion et l'ambition de l'IAMay 08, 2025 am 11:23 AMLe CTO de TransUnion, Ranganath Achanta, a dirigé une transformation technologique importante depuis qu'il a rejoint la société à la suite de son acquisition de Neustar fin 2021. Sa direction de plus de 7 000 associés dans divers départements s'est concentrée sur U

Lorsque la confiance dans l'IA saute, la productivité suitMay 08, 2025 am 11:11 AM

Lorsque la confiance dans l'IA saute, la productivité suitMay 08, 2025 am 11:11 AML'édification de la confiance est primordiale pour une adoption réussie de l'IA dans les affaires. Cela est particulièrement vrai compte tenu de l'élément humain dans les processus commerciaux. Les employés, comme quiconque, abritent des préoccupations concernant l'IA et sa mise en œuvre. Les chercheurs de Deloitte sont SC

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

Video Face Swap

Échangez les visages dans n'importe quelle vidéo sans effort grâce à notre outil d'échange de visage AI entièrement gratuit !

Article chaud

Outils chauds

Télécharger la version Mac de l'éditeur Atom

L'éditeur open source le plus populaire

SublimeText3 version anglaise

Recommandé : version Win, prend en charge les invites de code !

Adaptateur de serveur SAP NetWeaver pour Eclipse

Intégrez Eclipse au serveur d'applications SAP NetWeaver.

PhpStorm version Mac

Le dernier (2018.2.1) outil de développement intégré PHP professionnel

MinGW - GNU minimaliste pour Windows

Ce projet est en cours de migration vers osdn.net/projects/mingw, vous pouvez continuer à nous suivre là-bas. MinGW : un port Windows natif de GNU Compiler Collection (GCC), des bibliothèques d'importation et des fichiers d'en-tête librement distribuables pour la création d'applications Windows natives ; inclut des extensions du runtime MSVC pour prendre en charge la fonctionnalité C99. Tous les logiciels MinGW peuvent fonctionner sur les plates-formes Windows 64 bits.