Périphériques technologiques

Périphériques technologiques IA

IA Amélioration des LLM avec des sorties structurées et des appels de fonction

Amélioration des LLM avec des sorties structurées et des appels de fonctionIntroduction

Supposons que vous interagiz avec un ami qui est bien informé, mais qui manque parfois de réponses concrètes / éclairées ou lorsqu'il ne répond pas couramment face à des questions compliquées. Ce que nous faisons ici est similaire aux perspectives qui existent actuellement avec des modèles de gros langues. Ils sont très utiles, bien que leur qualité et leur pertinence des réponses structurées livrées puissent être satisfaisantes ou de niche.

Dans cet article, nous explorerons comment les technologies futures comme l'appel des fonctions et la génération auprès de la récupération (RAG) peuvent améliorer les LLM. Nous discuterons de leur potentiel pour créer des expériences conversationnelles plus fiables et significatives. Vous apprendrez comment ces technologies fonctionnent, leurs avantages et les défis auxquels ils sont confrontés. Notre objectif est de vous doter à la fois de connaissances et des compétences nécessaires pour améliorer les performances de LLM dans différents scénarios.

Cet article est basé sur une conférence récente donnée par Ayush Thakur sur l'amélioration des LLM avec des sorties structurées et des appels de fonctions, dans le Datahack Summit 2024.

Résultats d'apprentissage

- Comprendre les concepts fondamentaux et les limites des modèles de grands langues.

- Découvrez comment les sorties structurées et les appels de fonction peuvent améliorer les performances des LLM.

- Explorez les principes et les avantages de la génération (RAG) de la récupération (RAG) dans l'amélioration des LLM.

- Identifiez efficacement les défis et les solutions clés pour évaluer efficacement les LLM.

- Comparez les capacités d'appel de fonction entre les modèles OpenAI et LLAMA.

Table des matières

- Introduction

- Que sont les LLM?

- Interagir avec LLM: inviter

- En quoi l'application LLM diffère-t-elle du développement du modèle?

- Fonction appelant avec LLMS

- Fonction Calling: Fonction

- RAG (GÉNÉRATION AUGURÉE DE RÉTUNATION) pour les LLM

- Évaluation des LLM

- Génération contrainte de sorties pour LLMS

- Abaisser la température pour les sorties plus structurées

- Chaîne de raisonnement de pensée pour les LLM

- Fonction appelant Openai vs Llama

- Trouver des LLM pour votre application

- Conclusion

- Questions fréquemment posées

Que sont les LLM?

Les modèles de grands langues (LLM) sont des systèmes AI avancés conçus pour comprendre et générer un langage naturel basé sur de grands ensembles de données. Des modèles comme GPT-4 et LLAMA utilisent des algorithmes d'apprentissage en profondeur pour traiter et produire du texte. Ils sont polyvalents, manipulant des tâches comme la traduction du langage et la création de contenu. En analysant de grandes quantités de données, les LLM apprennent les modèles de langue et appliquent ces connaissances pour générer des réponses à consonance naturelle. Ils prédisent le texte et le formater logiquement, leur permettant d'effectuer un large éventail de tâches sur différents champs.

Limites des LLM

Explorons maintenant les limitations des LLM.

- Précision incohérente: leurs résultats sont parfois inexacts ou ne sont pas aussi fiables que prévu, en particulier lorsqu'ils traitent des situations complexes.

- Manque de véritable compréhension: ils peuvent produire du texte qui peut sembler raisonnable mais peut être en fait la mauvaise information ou un spin-off en raison de leur manque de perspicacité.

- Contraintes de données de formation: les résultats qu'ils produisent sont restreints par leurs données de formation, qui peuvent parfois être biais ou contiennent des lacunes.

- Base de connaissances statiques: les LLM ont une base de connaissances statique qui ne met pas à jour en temps réel, ce qui les rend moins efficaces pour les tâches nécessitant des informations actuelles ou dynamiques.

Importance des sorties structurées pour les LLM

Nous allons maintenant examiner l'importance des sorties structurées des LLM.

- Cohérence améliorée: les sorties structurées fournissent un format clair et organisé, améliorant la cohérence et la pertinence des informations présentées.

- Une convivialité améliorée: ils facilitent l'interprétation et l'utilisation des informations, en particulier dans les applications ayant besoin d'une présentation précise des données.

- Données organisées: les formats structurés aident à organiser logiquement les informations, ce qui est bénéfique pour générer des rapports, des résumés ou des informations basées sur les données.

- Ambiguïté réduite: la mise en œuvre de sorties structurées permet de réduire l'ambiguïté et d'améliorer la qualité globale du texte généré.

Interagir avec LLM: inviter

Inviter les modèles de gros langues (LLMS) implique la fabrication d'une invite avec plusieurs composants clés:

- Instructions : Directives claires sur ce que le LLM devrait faire.

- Contexte : Informations générales ou précédents pour éclairer la réponse.

- Données d'entrée : le contenu principal ou l'interrogation que le LLM doit traiter.

- Indicateur de sortie : spécifie le format ou le type de réponse souhaité.

Par exemple, pour classer le sentiment, vous fournissez un texte comme «Je pense que la nourriture était correcte» et demandez au LLM de le classer en sentiments neutres, négatifs ou positifs.

En pratique, il existe diverses approches pour inciter:

- Entrée-sortie : saisit directement les données et reçoit la sortie.

- Chaîne de pensée (COT) : encourage le LLM à raisonner à travers une séquence d'étapes pour arriver à la sortie.

- L'auto-cohérence avec le COT (COT-SC) : utilise plusieurs chemins de raisonnement et agrégats les résultats pour une meilleure précision grâce au vote majoritaire.

Ces méthodes aident à affiner les réponses de la LLM et à garantir que les sorties sont plus précises et fiables.

En quoi l'application LLM diffère-t-elle du développement du modèle?

Examinons maintenant le tableau ci-dessous pour comprendre en quoi l'application LLM diffère du développement du modèle.

| Développement de modèles | Applications LLM | |

| Modèles | Architecture Sauvé des poids et des préjugés | Composition des fonctions, des API et de la configuration |

| Ensembles de données | Énorme, souvent étiqueté | Humain généré, souvent sans étiquette |

| Expérimentation | Optimisation coûteuse et longue de course | Interactions peu coûteuses et à haute fréquence |

| Suivi | Métriques: perte, précision, activations | Activité: achèvement, commentaires, code |

| Évaluation | Objectif et planifiable | Subjectif et nécessite une entrée humaine |

Fonction appelant avec LLMS

L'appel de fonction avec LLMS implique d'activer les modèles de langage de grands (LLM) pour exécuter des fonctions prédéfinies ou des extraits de code dans le cadre de leur processus de génération de réponse. Cette capacité permet aux LLMS d'effectuer des actions ou des calculs spécifiques au-delà de la génération de texte standard. En intégrant les appels de fonction, les LLM peuvent interagir avec des systèmes externes, récupérer des données en temps réel ou exécuter des opérations complexes, élargissant ainsi leur utilité et leur efficacité dans diverses applications.

Avantages de l'appel de fonction

- Interactivité améliorée: l'appel de la fonction permet aux LLM d'interagir dynamiquement avec les systèmes externes, facilitant la récupération et le traitement des données en temps réel. Ceci est particulièrement utile pour les applications nécessitant des informations à jour, telles que les requêtes de données en direct ou les réponses personnalisées basées sur les conditions actuelles.

- Polvalence accrue: en exécutant des fonctions, les LLM peuvent gérer une gamme plus large de tâches, de la réalisation de calculs à l'accès et à la manipulation de bases de données. Cette polyvalence améliore la capacité du modèle à répondre à divers besoins des utilisateurs et à fournir des solutions plus complètes.

- Précision améliorée: l'appel de fonction permet aux LLMS d'effectuer des actions spécifiques qui peuvent améliorer la précision de leurs sorties. Par exemple, ils peuvent utiliser des fonctions externes pour valider ou enrichir les informations qu'ils génèrent, conduisant à des réponses plus précises et fiables.

- Processus rationalisés: l'intégration de la fonction d'appel dans les LLM peut rationaliser les processus complexes en automatisant des tâches répétitives et en réduisant le besoin d'intervention manuelle. Cette automatisation peut conduire à des flux de travail plus efficaces et à des temps de réponse plus rapides.

Limites de la fonction appelant avec les LLM actuels

- Capacités d'intégration limitées: les LLM actuels peuvent faire face à des défis dans l'intégration de manière transparente à divers systèmes ou fonctions externes. Cette limitation peut restreindre leur capacité à interagir avec diverses sources de données ou à effectuer efficacement des opérations complexes.

- Concernant la sécurité et la confidentialité: l'appel des fonctions peut introduire des risques de sécurité et de confidentialité, en particulier lorsque les LLM interagissent avec des données sensibles ou personnelles. Assurer des garanties robustes et des interactions sécurisées est crucial pour atténuer les vulnérabilités potentielles.

- Contraintes d'exécution: L'exécution des fonctions par LLMS peut être limitée par des facteurs tels que les limitations des ressources, le temps de traitement ou les problèmes de compatibilité. Ces contraintes peuvent avoir un impact sur les performances et la fiabilité des fonctionnalités d'appel de fonction.

- Complexité dans la gestion: la gestion et la maintenance des capacités d'appel des fonctions peuvent ajouter de la complexité au déploiement et au fonctionnement de LLMS. Cela inclut la gestion des erreurs, la garantie de la compatibilité avec diverses fonctions et la gestion des mises à jour ou des modifications des fonctions appelées.

L'appel de fonction rencontre pydante

Les objets pydatiques simplifient le processus de définition et de conversion des schémas pour l'appel des fonctions, offrant plusieurs avantages:

- Conversion automatique du schéma : transforment facilement les objets pydatiques en schémas prêts pour les LLM.

- Qualité de code améliorée : la vérification, la validation et le flux de contrôle des poignées pydantiques, assurant du code propre et fiable.

- Gestion des erreurs robuste : mécanismes intégrés pour gérer les erreurs et les exceptions.

- Intégration du cadre : des outils comme Instructor, Marvin, Langchain et Llamaindex utilisent les capacités de Pyndantic pour la sortie structurée.

Fonction Calling: Fonction

L'amélioration de la fonction appelant les tâches de niche implique des petits LLM pour gérer les besoins spécifiques de conservation des données. En tirant parti des techniques telles que des jetons spéciaux et du réglage fin LORA, vous pouvez optimiser l'exécution des fonctions et améliorer les performances du modèle pour les applications spécialisées.

Curration des données : Concentrez-vous sur la gestion précise des données pour les appels de fonction efficaces.

- Appels forcés à un seul tour : implémentez les exécutions de fonctions simples et uniques.

- Appels parallèles : utilisez des appels de fonction simultanés pour l'efficacité.

- Appels imbriqués : gérer les interactions complexes avec les exécutions de fonctions imbriquées.

- CHAT multi-tours : gérez les dialogues étendus avec des appels de fonction séquentiels.

Tokens spéciaux : utilisez des jetons personnalisés pour marquer les appels de début et de fin de fonction pour une meilleure intégration.

Formation du modèle : Commencez par des modèles basés sur l'instruction formés sur des données de haute qualité pour une efficacité fondamentale.

LORA Fine-Tuning : Utilisez Lora Fineding pour améliorer les performances du modèle d'une manière gérable et ciblée.

Cela montre une demande de tracez les cours des actions de NVIDIA (NVDA) et d'Apple (AAPL) sur deux semaines, suivis par les appels de fonction qui ont obtenu les données de stock.

RAG (GÉNÉRATION AUGURÉE DE RÉTUNATION) pour les LLM

La génération de la récupération (RAG) combine des techniques de récupération avec des méthodes de génération pour améliorer les performances des modèles de grands langues (LLM). RAG améliore la pertinence et la qualité des sorties en intégrant un système de récupération dans le modèle génératif. Cette approche garantit que les réponses générées sont plus contextuellement riches et factuellement exactes. En incorporant des connaissances externes, RAG traite certaines limites des modèles purement génératifs, offrant des sorties plus fiables et éclairées pour les tâches nécessitant une précision et des informations à jour. Il comble l'écart entre la génération et la récupération, améliorant l'efficacité globale du modèle.

Comment fonctionne le chiffon

Les composants clés comprennent:

- Chargeur de documents : responsable du chargement des documents et de l'extraction du texte et des métadonnées pour le traitement.

- Stratégie de section : définit la taille du texte divisé en pièces plus petites et gérables (morceaux) pour l'intégration.

- Modèle d'incorporation : convertit ces morceaux en vecteurs numériques pour une comparaison et une récupération efficaces.

- Retriever : recherche les morceaux les plus pertinents en fonction de la requête, déterminant à quel point elles sont bonnes ou précises pour la génération de réponse.

- Analyseurs de nœuds et post-traitement : gérer le filtrage et le seuil, garantissant que seules des morceaux de haute qualité sont transmis.

- Response Synthesizer : génère une réponse cohérente à partir des morceaux récupérés, souvent avec des appels LLM multi-tours ou séquentiels.

- Évaluation : Le système vérifie la précision, la factualité et réduit l'hallucination dans la réponse, garantissant qu'elle reflète des données réelles.

Cette image représente comment les systèmes de chiffon combinent la récupération et la génération pour fournir des réponses précises et basées sur les données.

- Composant de récupération: Le cadre de chiffon commence par un processus de récupération lorsque des documents ou des données pertinents sont récupérés à partir d'une base de connaissances prédéfinie ou d'un moteur de recherche. Cette étape consiste à interroger la base de données à l'aide de la requête d'entrée ou du contexte pour identifier les informations les plus pertinentes.

- Intégration contextuelle: une fois les documents pertinents récupérés, ils sont utilisés pour fournir un contexte pour le modèle génératif. Les informations récupérées sont intégrées dans l'invite d'entrée, aidant le LLM à générer des réponses qui sont éclairées par les données du monde réel et le contenu pertinent.

- Composant de génération: le modèle génératif traite l'entrée enrichie, incorporant les informations récupérées pour produire une réponse. Cette réponse bénéficie du contexte supplémentaire, conduisant à des sorties plus précises et plus appropriées.

- Raffinement: Dans certaines implémentations, la sortie générée peut être affinée grâce à un traitement ou à une réévaluation ultérieure. Cette étape garantit que la réponse finale s'aligne sur les informations récupérées et répond aux normes de qualité.

Avantages de l'utilisation de chiffon avec LLMS

- Précision améliorée: en incorporant des connaissances externes, RAG améliore la précision factuelle des sorties générées. Le composant de récupération aide à fournir des informations à jour et pertinentes, réduisant le risque de générer des réponses incorrectes ou obsolètes.

- Pertenance contextuelle améliorée: RAG permet aux LLM de produire des réponses plus contextuelles en tirant parti des informations spécifiques récupérées à partir de sources externes. Il en résulte des sorties qui sont mieux alignées sur la requête ou le contexte de l'utilisateur.

- Couverture des connaissances accrue: avec RAG, les LLM peuvent accéder à un éventail plus large de connaissances au-delà de leurs données de formation. Cette couverture élargie aide à répondre aux requêtes sur des niches ou des sujets spécialisés qui peuvent ne pas être bien représentés dans les connaissances pré-formées du modèle.

- Une meilleure manipulation des requêtes à longue queue: le chiffon est particulièrement efficace pour la manipulation des requêtes à longue queue ou des sujets rares. En récupérant des documents pertinents, les LLM peuvent générer des réponses informatives même pour des requêtes moins courantes ou hautement spécifiques.

- Expérience utilisateur améliorée: l'intégration de la récupération et de la génération offre une réponse plus robuste et utile, améliorant l'expérience utilisateur globale. Les utilisateurs reçoivent des réponses non seulement cohérentes mais également fondées dans des informations pertinentes et à jour.

Évaluation des LLM

L'évaluation des modèles de langue importants (LLM) est un aspect crucial pour assurer leur efficacité, leur fiabilité et leur applicabilité dans diverses tâches. Une évaluation appropriée aide à identifier les forces et les faiblesses, guide les améliorations et garantit que les LLM répondent aux normes requises pour différentes applications.

Importance de l'évaluation dans les applications LLM

- Assure la précision et la fiabilité: l'évaluation des performances aide à comprendre à quel point un LLM complète les tâches telles que la génération de texte, le résumé ou la réponse aux questions. Et bien que je sois en faveur de faire pression pour une approche plus holistique en classe, les commentaires qui sont particuliers de cette manière sont très précieux pour un type d'application très spécifique qui se dépendait grandement des détails, dans des domaines comme la médecine ou le droit.

- Guides Modèles Améliorations: grâce à l'évaluation, les développeurs peuvent identifier des domaines spécifiques où un LLM peut échouer. Cette rétroaction est cruciale pour affiner les performances du modèle, ajuster les données de formation ou modifier les algorithmes pour améliorer l'efficacité globale.

- Mesures les performances par rapport aux références: l'évaluation des LLM contre les références établies permet une comparaison avec d'autres modèles et des versions précédentes. Ce processus d'analyse comparative nous aide à comprendre les performances du modèle et à identifier les domaines d'amélioration.

- Assure une utilisation éthique et sûre: elle a une part dans la détermination de la mesure dans laquelle les LLM respectent les principes éthiques et les normes concernant la sécurité. Il aide à identifier les biais, le contenu indésirable et tout autre facteur qui peut faire en sorte que l'utilisation responsable de la technologie soit compromise.

- Prend en charge les applications du monde réel: c'est pour cette raison qu'une évaluation appropriée et approfondie est requise afin de comprendre comment les LLM fonctionnent dans la pratique. Cela implique d'évaluer leurs performances dans la résolution de diverses tâches, le fonctionnement dans différents scénarios et la production de résultats précieux dans des cas du monde réel.

Défis dans l'évaluation des LLM

- La subjectivité dans les mesures d'évaluation: de nombreuses mesures d'évaluation, telles que le jugement humain de pertinence ou de cohérence, peuvent être subjectives. Cette subjectivité rend difficile d'évaluer les performances du modèle de manière cohérente et peut entraîner une variabilité des résultats.

- La difficulté à mesurer la compréhension nuancée: évaluer la capacité d'un LLM à comprendre les requêtes complexes ou nuancées est intrinsèquement difficile. Les mesures actuelles peuvent ne pas saisir pleinement la profondeur de compréhension requise pour les résultats de haute qualité, conduisant à des évaluations incomplètes.

- Problèmes d'évolutivité: l'évaluation des LLM devient de plus en plus coûteuse à mesure que ces structures se développent et deviennent plus complexes. Il est également important de noter que l'évaluation complète prend du temps et a besoin de beaucoup de puissance de calcul qui peut en quelque sorte gêner le processus de test.

- Les préjugés et les problèmes d'équité: il n'est pas facile d'évaluer les LLM pour les biais et l'équité, car le biais peut prendre différentes formes et formes. Pour garantir que la précision reste cohérente dans différentes données démographiques et situations, des méthodes d'évaluation rigoureuses et élaborées sont essentielles.

- Nature dynamique du langage: le langage est en constante évolution, et ce qui constitue des informations précises ou pertinentes peut changer avec le temps. Les évaluateurs doivent évaluer les LLM non seulement pour leurs performances actuelles, mais aussi pour leur adaptabilité aux tendances linguistiques en évolution, étant donné la nature dynamique des modèles.

Génération contrainte de sorties pour LLMS

La génération contrainte implique de diriger un LLM pour produire des sorties qui adhèrent à des contraintes ou des règles spécifiques. Cette approche est essentielle lorsque la précision et l'adhésion à un format particulier sont nécessaires. Par exemple, dans des applications telles que la documentation juridique ou les rapports formels, il est crucial que le texte généré suit des directives et des structures strictes.

Vous pouvez atteindre la génération contrainte en prédéfinissant les modèles de sortie, en définissant des limites de contenu ou en utilisant l'ingénierie rapide pour guider les réponses de la LLM. En appliquant ces contraintes, les développeurs peuvent s'assurer que les résultats de la LLM sont non seulement pertinents mais également conformes aux normes requises, réduisant la probabilité de réponses non pertinentes ou hors sujet.

Abaisser la température pour les sorties plus structurées

Le paramètre de température dans le LLMS contrôle le niveau d'aléatoire dans le texte généré. La baisse de la température entraîne des sorties plus prévisibles et structurées. Lorsque la température est définie sur une valeur inférieure (par exemple, 0,1 à 0,3), la génération de réponse du modèle devient plus déterministe, favorisant les mots et les phrases de plus grande probabilité. Cela conduit à des sorties plus cohérentes et alignées avec le format attendu.

Pour les applications où la cohérence et la précision sont cruciales, comme les résumés des données ou la documentation technique, la baisse de la température garantit que les réponses sont moins variées et plus structurées. À l'inverse, une température plus élevée introduit plus de variabilité et de créativité, qui pourraient être moins souhaitables dans des contextes nécessitant une adhésion stricte à formater et à la clarté.

Chaîne de raisonnement de pensée pour les LLM

Le raisonnement de la chaîne de pensée est une technique qui encourage les LLM à générer des sorties en suivant une séquence logique d'étapes, similaire aux processus de raisonnement humain. Cette méthode consiste à décomposer des problèmes complexes en composants plus petits et gérables et à articuler le processus de réflexion derrière chaque étape.

En utilisant un raisonnement de la chaîne de pensées, les LLM peuvent produire des réponses plus complètes et bien poursuivies, ce qui est particulièrement utile pour les tâches qui impliquent des explications de résolution de problèmes ou détaillées. Cette approche améliore non seulement la clarté du texte généré, mais aide également à vérifier la précision des réponses en fournissant une vue transparente du processus de raisonnement du modèle.

Fonction appelant Openai vs Llama

Les capacités d'appel de fonction diffèrent entre les modèles d'Openai et les modèles LLAMA de META. Les modèles d'OpenAI, tels que GPT-4, offrent des fonctionnalités d'appel de fonction avancées via leur API, permettant l'intégration avec des fonctions ou des services externes. Cette capacité permet aux modèles d'effectuer des tâches au-delà de la génération de texte, telles que l'exécution de commandes ou les bases de données de requête.

D'un autre côté, les modèles de lama de Meta ont leur propre ensemble de mécanismes d'appel de fonction, qui peuvent différer en matière d'implémentation et de portée. Bien que les deux types de modèles prennent en charge l'appel des fonctions, les spécificités de leur intégration, de leurs performances et de leurs fonctionnalités peuvent varier. Comprendre ces différences est crucial pour sélectionner le modèle approprié pour les applications nécessitant des interactions complexes avec des systèmes externes ou des opérations spécialisées basées sur les fonctions.

Trouver des LLM pour votre application

Le choix du bon modèle de langue grande (LLM) pour votre application nécessite d'évaluer ses capacités, son évolutivité et dans la façon dont il répond bien à vos besoins de données et d'intégration spécifiques.

Il est bon de se référer à des références de performance sur divers modèles de grande langue (LLMS) dans différentes séries comme Baichuan, ChatGlm, Deepseek et Interlm2. Ici. Évaluer leurs performances en fonction de la longueur du contexte et du nombre d'aiguilles. Cela aide à avoir une idée de quel LLMS choisir pour certaines tâches.

La sélection du bon modèle de langage grand (LLM) pour votre application implique d'évaluer des facteurs tels que les capacités du modèle, les exigences de traitement des données et le potentiel d'intégration. Considérez des aspects tels que la taille du modèle, les options de réglage fin et la prise en charge des fonctions spécialisées. La correspondance de ces attributs aux besoins de votre application vous aidera à choisir un LLM qui fournit des performances optimales et s'aligne sur votre cas d'utilisation spécifique.

Le classement LMSYS Chatbot Arena est une plate-forme de crowdsourced pour classer les modèles de grands langues (LLM) via des comparaisons par paires humaines. Il affiche des classements de modèles basés sur les votes, en utilisant le modèle Bradley-Terry pour évaluer les performances dans diverses catégories.

Conclusion

En résumé, les LLM évoluent avec des progrès comme l'appel de fonction et la génération auprès de la récupération (RAG). Ceux-ci améliorent leurs capacités en ajoutant des sorties structurées et une récupération de données en temps réel. Bien que les LLM présentent un grand potentiel, leurs limites de précision et les mises à jour en temps réel mettent en évidence la nécessité d'un raffinement supplémentaire. Des techniques comme la génération contrainte, la baisse de la température et le raisonnement de la chaîne de pensée aident à améliorer la fiabilité et la pertinence de leurs résultats. Ces progrès visent à rendre les LLM plus efficaces et plus précis dans diverses applications.

Comprendre les différences entre l'appel de fonction dans les modèles OpenAI et LLAMA aide à choisir le bon outil pour des tâches spécifiques. À mesure que la technologie LLM avance, relever ces défis et l'utilisation de ces techniques seront essentielles pour améliorer leurs performances dans différents domaines. Tirer parti de ces distinctions optimisera leur efficacité dans des applications variées.

Questions fréquemment posées

Q1. Quelles sont les principales limites des LLM?A. Les LLM ont souvent du mal avec l'exactitude, les mises à jour en temps réel et sont limitées par leurs données de formation, ce qui peut avoir un impact sur leur fiabilité.

Q2. Comment la génération (RAG) de la récupération (RAG) profite-t-elle aux LLMS?A. RAG améliore les LLM en incorporant la récupération des données en temps réel, améliorant la précision et la pertinence des sorties générées.

Q3. Qu'est-ce que la fonction appelle dans le contexte des LLMS?A. L'appel de fonction permet aux LLMS d'exécuter des fonctions ou des requêtes spécifiques pendant la génération de texte, améliorant leur capacité à effectuer des tâches complexes et à fournir des résultats précis.

Q4. Comment la baisse de la température affecte-t-elle la sortie LLM?A. La baisse de la température dans les LLM entraîne des sorties plus structurées et prévisibles en réduisant le caractère aléatoire dans la génération de texte, conduisant à des réponses plus claires et plus cohérentes.

Q5. Qu'est-ce que le raisonnement de la chaîne de pensée dans les LLM?A. Le raisonnement de la chaîne de pensée implique le traitement séquentiellement des informations pour construire un argument ou une explication logique et cohérente, améliorant la profondeur et la clarté des sorties LLM.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

7 L'IA puissante invite à chaque chef de projet doit maîtriser maintenantMay 08, 2025 am 11:39 AM

7 L'IA puissante invite à chaque chef de projet doit maîtriser maintenantMay 08, 2025 am 11:39 AML'IA générative, illustrée par des chatbots comme Chatgpt, offre aux chefs de projet des outils puissants pour rationaliser les workflows et s'assurer que les projets restent dans les horaires et dans le budget. Cependant, une utilisation efficace dépend de l'élaboration des bonnes invites. Précis, détail

Définir la signification mal définie de l'AGI insaisissable via l'assistance utile de l'IA elle-mêmeMay 08, 2025 am 11:37 AM

Définir la signification mal définie de l'AGI insaisissable via l'assistance utile de l'IA elle-mêmeMay 08, 2025 am 11:37 AMLe défi de définir l'intelligence générale artificielle (AGI) est significative. Les allégations de progrès AGI n'ont souvent pas de référence claire, avec des définitions adaptées à l'adaptation des instructions de recherche prédéterminées. Cet article explore une nouvelle approche de définir

IBM Think 2025 présente le rôle de Watsonx.Data dans l'IA générativeMay 08, 2025 am 11:32 AM

IBM Think 2025 présente le rôle de Watsonx.Data dans l'IA générativeMay 08, 2025 am 11:32 AMIBM Watsonx.Data: rationalisation de la pile de données de l'IA d'entreprise IBM positionne Watsonx.Data comme plate-forme pivot pour les entreprises visant à accélérer la livraison de solutions d'interface utilisateur génératrices précises et évolutives. Ceci est réalisé en simplifiant le complat

La montée des machines robotiques humanoïdes approche.May 08, 2025 am 11:29 AM

La montée des machines robotiques humanoïdes approche.May 08, 2025 am 11:29 AMLes progrès rapides de la robotique, alimentés par des percées dans l'IA et la science des matériaux, sont sur le point d'inaugurer une nouvelle ère de robots humanoïdes. Pendant des années, l'automatisation industrielle a été l'objectif principal, mais les capacités des robots sont rapidement exp

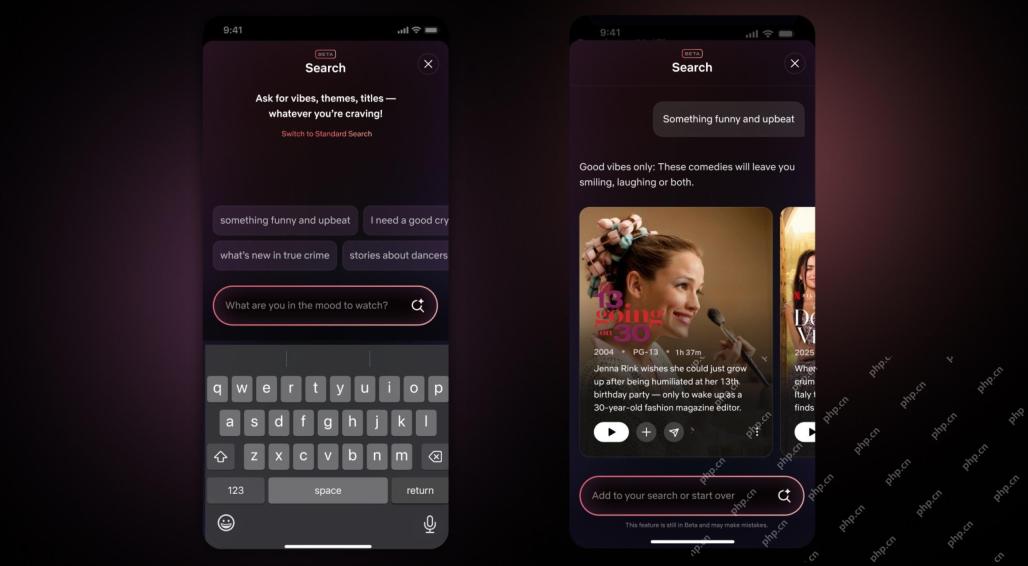

Interface Netflix Repamps - Débutant les outils de recherche AI et la conception de type TiktokMay 08, 2025 am 11:25 AM

Interface Netflix Repamps - Débutant les outils de recherche AI et la conception de type TiktokMay 08, 2025 am 11:25 AMLa plus grande mise à jour de l'interface Netflix en une décennie: plus intelligente, plus personnalisée, adoptant un contenu diversifié Netflix a annoncé sa plus grande refonte de son interface utilisateur en une décennie, non seulement un nouveau look, mais ajoute également plus d'informations sur chaque émission, et introduit des outils de recherche d'IA plus intelligents qui peuvent comprendre des concepts vagues tels que des événements "ambiants" et des structures plus flexibles pour mieux démontrer l'intérêt de l'entreprise pour les jeux vidéo émergents, les événements en direct, les événements sportifs et d'autres nouveaux types de contenu. Pour suivre la tendance, le nouveau composant vidéo vertical sur mobile permettra aux fans de faire défiler les bandes-annonces et de clips, de regarder le spectacle complet ou de partager du contenu avec d'autres. Cela vous rappelle le défilement infini et le site Web vidéo très réussi TI

Bien avant AGI: trois étapes de l'IA qui vous défierontMay 08, 2025 am 11:24 AM

Bien avant AGI: trois étapes de l'IA qui vous défierontMay 08, 2025 am 11:24 AMLa discussion croissante de l'intelligence générale (AGI) dans l'intelligence artificielle a incité beaucoup à réfléchir à ce qui se passe lorsque l'intelligence artificielle dépasse l'intelligence humaine. Que ce moment soit proche ou éloigné dépend de qui vous demandez, mais je ne pense pas que ce soit la jalon la plus importante sur laquelle nous devrions nous concentrer. Quels jalons d'IA antérieurs affecteront tout le monde? Quels jalons ont été franchis? Voici trois choses qui, selon moi. L'intelligence artificielle dépasse les faiblesses humaines Dans le film de 2022 "Social Dilemma", Tristan Harris du Center for Humane Technology a souligné que l'intelligence artificielle a dépassé les faiblesses humaines. Qu'est-ce que cela signifie? Cela signifie que l'intelligence artificielle a pu utiliser les humains

Venkat Achanta sur la transformation de la plate-forme de TransUnion et l'ambition de l'IAMay 08, 2025 am 11:23 AM

Venkat Achanta sur la transformation de la plate-forme de TransUnion et l'ambition de l'IAMay 08, 2025 am 11:23 AMLe CTO de TransUnion, Ranganath Achanta, a dirigé une transformation technologique importante depuis qu'il a rejoint la société à la suite de son acquisition de Neustar fin 2021. Sa direction de plus de 7 000 associés dans divers départements s'est concentrée sur U

Lorsque la confiance dans l'IA saute, la productivité suitMay 08, 2025 am 11:11 AM

Lorsque la confiance dans l'IA saute, la productivité suitMay 08, 2025 am 11:11 AML'édification de la confiance est primordiale pour une adoption réussie de l'IA dans les affaires. Cela est particulièrement vrai compte tenu de l'élément humain dans les processus commerciaux. Les employés, comme quiconque, abritent des préoccupations concernant l'IA et sa mise en œuvre. Les chercheurs de Deloitte sont SC

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

Video Face Swap

Échangez les visages dans n'importe quelle vidéo sans effort grâce à notre outil d'échange de visage AI entièrement gratuit !

Article chaud

Outils chauds

Adaptateur de serveur SAP NetWeaver pour Eclipse

Intégrez Eclipse au serveur d'applications SAP NetWeaver.

DVWA

Damn Vulnerable Web App (DVWA) est une application Web PHP/MySQL très vulnérable. Ses principaux objectifs sont d'aider les professionnels de la sécurité à tester leurs compétences et leurs outils dans un environnement juridique, d'aider les développeurs Web à mieux comprendre le processus de sécurisation des applications Web et d'aider les enseignants/étudiants à enseigner/apprendre dans un environnement de classe. Application Web sécurité. L'objectif de DVWA est de mettre en pratique certaines des vulnérabilités Web les plus courantes via une interface simple et directe, avec différents degrés de difficulté. Veuillez noter que ce logiciel

MinGW - GNU minimaliste pour Windows

Ce projet est en cours de migration vers osdn.net/projects/mingw, vous pouvez continuer à nous suivre là-bas. MinGW : un port Windows natif de GNU Compiler Collection (GCC), des bibliothèques d'importation et des fichiers d'en-tête librement distribuables pour la création d'applications Windows natives ; inclut des extensions du runtime MSVC pour prendre en charge la fonctionnalité C99. Tous les logiciels MinGW peuvent fonctionner sur les plates-formes Windows 64 bits.

SublimeText3 Linux nouvelle version

Dernière version de SublimeText3 Linux

Version Mac de WebStorm

Outils de développement JavaScript utiles