Périphériques technologiques

Périphériques technologiques IA

IA Fine Actionnement Google Gemma: Amélioration des LLM avec des instructions personnalisées

Fine Actionnement Google Gemma: Amélioration des LLM avec des instructions personnaliséesFine Actionnement Google Gemma: Amélioration des LLM avec des instructions personnalisées

GEMMA de Google Deepmind: une plongée profonde dans les LLMS open source

Le paysage de l'IA bourdonne d'activité, en particulier concernant les modèles de grande langue open source (LLM). Les géants de la technologie comme Google, Meta et Twitter adoptent de plus en plus le développement open-source. Google Deepmind a récemment dévoilé Gemma, une famille de LLMS légères et open-source construites en utilisant la même recherche et technologie sous-jacentes que les modèles Gémeaux de Google. Cet article explore les modèles GEMMA, leur accessibilité via des GPU cloud et des TPU, et fournit un guide étape par étape pour affiner le modèle Gemma 7b-it sur un ensemble de données de jeu.

Comprendre GEMMA de Google

GEMMA (ce qui signifie "pierre précieuse" en latin) est une famille de modèles ouverts de texte à texte uniquement au décodeur développés principalement par Google DeepMind. Inspiré par les modèles Gemini, Gemma est conçue pour un fonctionnement léger et une large compatibilité du cadre. Google a publié des poids de modèle pour deux tailles Gemma: 2b et 7b, chacune disponibles en variantes pré-formées et réglées par l'instruction (par exemple, Gemma 2B-It et Gemma 7b-it). Les performances de Gemma rivalisent avec d'autres modèles ouverts, surpassant notamment le LLAMA-2 de Meta à travers divers repères LLM.

source d'image

source d'image

La polyvalence de Gemma s'étend à sa prise en charge de plusieurs frameworks (Keras 3.0, Pytorch, Jax, Tablening Face Transformers) et un matériel divers (ordinateurs portables, ordinateurs de bureau, appareils IoT, mobile et cloud). L'inférence et le réglage fin supervisé (SFT) sont possibles sur les TPU cloud gratuits à l'aide de cadres d'apprentissage automatique populaires. En outre, Google fournit une boîte à outils générative d'IA responsable aux côtés de GEMMA, offrant des conseils et des outils pour les développeurs pour créer des applications d'IA plus sûres. Les débutants de l'IA et des LLM sont encouragés à explorer la piste de compétences fondamentales de l'IA pour les connaissances fondamentales.

Accès au modèle GEMMA de Google

L'accès à Gemma est simple. L'accès gratuit est disponible via HuggingChat et Poe. L'utilisation locale est également possible en téléchargeant des poids du modèle en étreignant le visage et en utilisant GPT4ALL ou LMStudio. Ce guide se concentre sur l'utilisation des GPU et des TPU gratuits de Kaggle pour l'inférence.

Exécution de l'inférence Gemma sur TPUS

Pour exécuter l'inférence Gemma sur les TPU à l'aide de keras, suivez ces étapes:

- Accédez à Keras / Gemma, sélectionnez la variante du modèle "Gemma_instruct_2b_en", puis cliquez sur "Nouveau ordinateur portable". "

- Dans le panneau de droite, sélectionnez "TPU VM V3-8" comme accélérateur.

- Installez les bibliothèques Python nécessaires:

!pip install -q tensorflow-cpu !pip install -q -U keras-nlp tensorflow-hub !pip install -q -U keras>=3 !pip install -q -U tensorflow-text

- Vérifiez la disponibilité TPU à l'aide de

jax.devices(). - Set

jaxcomme backend Keras:os.environ["KERAS_BACKEND"] = "jax" - Chargez le modèle à l'aide de

keras_nlpet générez du texte à l'aide de la fonctiongenerate.

source d'image

source d'image

Exécution de l'inférence Gemma sur les GPU

Pour l'inférence du GPU à l'aide des transformateurs, suivez ces étapes:

- Accédez à Google / Gemma, sélectionnez "Transformers", choisissez la variante "7b-it" et créez un nouveau ordinateur portable.

- Sélectionnez GPT T4 X2 comme accélérateur.

- Installez les packages requis:

%%capture %pip install -U bitsandbytes %pip install -U transformers %pip install -U accelerate

- Chargez le modèle en utilisant la quantification 4 bits avec des bitsandbytes pour la gestion VRAM.

- Chargez le tokenzer.

- Créer une invite, la tokenize, la transmettre au modèle, décoder la sortie et afficher le résultat.

source d'image

source d'image

Fonctionner Gemma de Google: un guide étape par étape

Cette section détaille les réglages GEMMA 7B-IT sur l'ensemble de données hieunguyenminh/roleplay à l'aide d'un GPU Kaggle P100

Configuration

- Installez les packages nécessaires:

%%capture %pip install -U bitsandbytes %pip install -U transformers %pip install -U peft %pip install -U accelerate %pip install -U trl %pip install -U datasets

- Importer des bibliothèques requises.

- Définir les variables pour le modèle de base, l'ensemble de données et le nom du modèle affiné.

- Connectez-vous à CLI pour les câlins en utilisant votre clé API.

- Initialiser les poids et biais (W&B) Espace de travail.

Chargement de l'ensemble de données

Chargez les 1000 premières lignes de l'ensemble de données de jeu de rôle.

Chargement du modèle et du tokenizer

Chargez le modèle GEMMA 7B-IT en utilisant une précision 4 bits avec des bitsandbytes. Chargez le jeton et configurez le jeton de pad.

ajoutant la couche adaptateur

Ajoutez une couche d'adaptateur LORA pour affiner efficacement le modèle.

Formation du modèle

Définissez des arguments de formation (hyperparamètres) et créez un SFTTRAINER. Former le modèle en utilisant .train().

Sauver le modèle

Enregistrez localement le modèle affiné et poussez-le vers le moyeu de face étreint.

Inférence du modèle

générer des réponses en utilisant le modèle affiné.

Gemma 7b Inférence avec l'adaptateur de jeu de rôle

Cette section montre comment charger le modèle de base et l'adaptateur qualifié, les fusionner et générer des réponses.

Réflexions finales

La sortie de Google de Gemma signifie un changement vers la collaboration open source dans l'IA. Ce tutoriel a fourni un guide complet pour utiliser et régler les modèles Gemma, mettant en évidence la puissance du développement open source et des ressources de cloud computing. L'étape suivante consiste à créer votre propre application basée sur LLM à l'aide de frameworks comme Langchain.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

7 L'IA puissante invite à chaque chef de projet doit maîtriser maintenantMay 08, 2025 am 11:39 AM

7 L'IA puissante invite à chaque chef de projet doit maîtriser maintenantMay 08, 2025 am 11:39 AML'IA générative, illustrée par des chatbots comme Chatgpt, offre aux chefs de projet des outils puissants pour rationaliser les workflows et s'assurer que les projets restent dans les horaires et dans le budget. Cependant, une utilisation efficace dépend de l'élaboration des bonnes invites. Précis, détail

Définir la signification mal définie de l'AGI insaisissable via l'assistance utile de l'IA elle-mêmeMay 08, 2025 am 11:37 AM

Définir la signification mal définie de l'AGI insaisissable via l'assistance utile de l'IA elle-mêmeMay 08, 2025 am 11:37 AMLe défi de définir l'intelligence générale artificielle (AGI) est significative. Les allégations de progrès AGI n'ont souvent pas de référence claire, avec des définitions adaptées à l'adaptation des instructions de recherche prédéterminées. Cet article explore une nouvelle approche de définir

IBM Think 2025 présente le rôle de Watsonx.Data dans l'IA générativeMay 08, 2025 am 11:32 AM

IBM Think 2025 présente le rôle de Watsonx.Data dans l'IA générativeMay 08, 2025 am 11:32 AMIBM Watsonx.Data: rationalisation de la pile de données de l'IA d'entreprise IBM positionne Watsonx.Data comme plate-forme pivot pour les entreprises visant à accélérer la livraison de solutions d'interface utilisateur génératrices précises et évolutives. Ceci est réalisé en simplifiant le complat

La montée des machines robotiques humanoïdes approche.May 08, 2025 am 11:29 AM

La montée des machines robotiques humanoïdes approche.May 08, 2025 am 11:29 AMLes progrès rapides de la robotique, alimentés par des percées dans l'IA et la science des matériaux, sont sur le point d'inaugurer une nouvelle ère de robots humanoïdes. Pendant des années, l'automatisation industrielle a été l'objectif principal, mais les capacités des robots sont rapidement exp

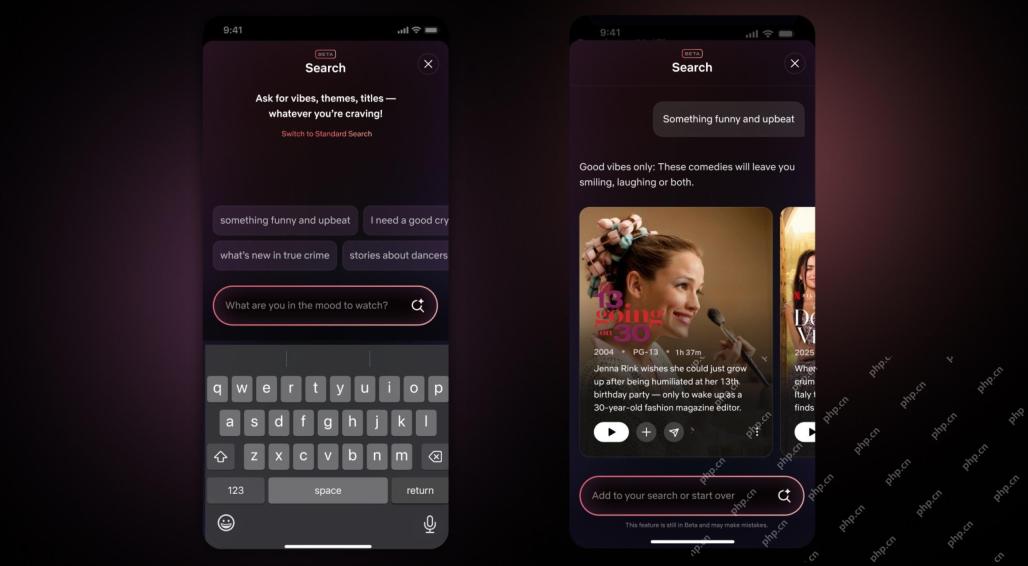

Interface Netflix Repamps - Débutant les outils de recherche AI et la conception de type TiktokMay 08, 2025 am 11:25 AM

Interface Netflix Repamps - Débutant les outils de recherche AI et la conception de type TiktokMay 08, 2025 am 11:25 AMLa plus grande mise à jour de l'interface Netflix en une décennie: plus intelligente, plus personnalisée, adoptant un contenu diversifié Netflix a annoncé sa plus grande refonte de son interface utilisateur en une décennie, non seulement un nouveau look, mais ajoute également plus d'informations sur chaque émission, et introduit des outils de recherche d'IA plus intelligents qui peuvent comprendre des concepts vagues tels que des événements "ambiants" et des structures plus flexibles pour mieux démontrer l'intérêt de l'entreprise pour les jeux vidéo émergents, les événements en direct, les événements sportifs et d'autres nouveaux types de contenu. Pour suivre la tendance, le nouveau composant vidéo vertical sur mobile permettra aux fans de faire défiler les bandes-annonces et de clips, de regarder le spectacle complet ou de partager du contenu avec d'autres. Cela vous rappelle le défilement infini et le site Web vidéo très réussi TI

Bien avant AGI: trois étapes de l'IA qui vous défierontMay 08, 2025 am 11:24 AM

Bien avant AGI: trois étapes de l'IA qui vous défierontMay 08, 2025 am 11:24 AMLa discussion croissante de l'intelligence générale (AGI) dans l'intelligence artificielle a incité beaucoup à réfléchir à ce qui se passe lorsque l'intelligence artificielle dépasse l'intelligence humaine. Que ce moment soit proche ou éloigné dépend de qui vous demandez, mais je ne pense pas que ce soit la jalon la plus importante sur laquelle nous devrions nous concentrer. Quels jalons d'IA antérieurs affecteront tout le monde? Quels jalons ont été franchis? Voici trois choses qui, selon moi. L'intelligence artificielle dépasse les faiblesses humaines Dans le film de 2022 "Social Dilemma", Tristan Harris du Center for Humane Technology a souligné que l'intelligence artificielle a dépassé les faiblesses humaines. Qu'est-ce que cela signifie? Cela signifie que l'intelligence artificielle a pu utiliser les humains

Venkat Achanta sur la transformation de la plate-forme de TransUnion et l'ambition de l'IAMay 08, 2025 am 11:23 AM

Venkat Achanta sur la transformation de la plate-forme de TransUnion et l'ambition de l'IAMay 08, 2025 am 11:23 AMLe CTO de TransUnion, Ranganath Achanta, a dirigé une transformation technologique importante depuis qu'il a rejoint la société à la suite de son acquisition de Neustar fin 2021. Sa direction de plus de 7 000 associés dans divers départements s'est concentrée sur U

Lorsque la confiance dans l'IA saute, la productivité suitMay 08, 2025 am 11:11 AM

Lorsque la confiance dans l'IA saute, la productivité suitMay 08, 2025 am 11:11 AML'édification de la confiance est primordiale pour une adoption réussie de l'IA dans les affaires. Cela est particulièrement vrai compte tenu de l'élément humain dans les processus commerciaux. Les employés, comme quiconque, abritent des préoccupations concernant l'IA et sa mise en œuvre. Les chercheurs de Deloitte sont SC

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

Video Face Swap

Échangez les visages dans n'importe quelle vidéo sans effort grâce à notre outil d'échange de visage AI entièrement gratuit !

Article chaud

Outils chauds

Télécharger la version Mac de l'éditeur Atom

L'éditeur open source le plus populaire

SublimeText3 version anglaise

Recommandé : version Win, prend en charge les invites de code !

Adaptateur de serveur SAP NetWeaver pour Eclipse

Intégrez Eclipse au serveur d'applications SAP NetWeaver.

PhpStorm version Mac

Le dernier (2018.2.1) outil de développement intégré PHP professionnel

MinGW - GNU minimaliste pour Windows

Ce projet est en cours de migration vers osdn.net/projects/mingw, vous pouvez continuer à nous suivre là-bas. MinGW : un port Windows natif de GNU Compiler Collection (GCC), des bibliothèques d'importation et des fichiers d'en-tête librement distribuables pour la création d'applications Windows natives ; inclut des extensions du runtime MSVC pour prendre en charge la fonctionnalité C99. Tous les logiciels MinGW peuvent fonctionner sur les plates-formes Windows 64 bits.