OLMO 2: Un puissant LLM open-source pour Ai accessible

Le domaine du traitement du langage naturel (PNL) a connu des progrès rapides, en particulier avec des modèles de langage grand (LLM). Alors que les modèles propriétaires ont historiquement dominé, les alternatives open source comblent rapidement l'écart. Olmo 2 représente un saut significatif en avant, offrant des performances comparables aux modèles de source fermée tout en maintenant une transparence et une accessibilité complètes. Cet article plonge dans OLMO 2, explorant sa formation, sa performance et son application pratique.

Points d'apprentissage clés:

- Saisissez l'importance des LLMS open source et de la contribution d'Olmo 2 à la recherche sur l'IA.

- Comprendre l'architecture d'Olmo 2, les méthodes de formation et les résultats de référence.

- Différencier entre les architectures de modèle ouvertes, partiellement ouvertes et entièrement ouvertes.

- Apprenez à exécuter OLMO 2 localement en utilisant Gradio et Langchain.

- Créez une application de chatbot en utilisant OLMO 2 avec des exemples de code Python.

(Cet article fait partie du blogathon de la science des données.)

Table des matières:

- La nécessité de LLMS open source

- Présentation de Olmo 2

- déconstruire la formation d'Olmo 2

- Exploration des capacités d'Olmo 2

- Construire un chatbot avec Olmo 2

- Conclusion

- Les questions fréquemment posées

La demande de LLMS open source

La domination initiale des LLM propriétaires a soulevé des préoccupations concernant l'accessibilité, la transparence et les biais. Les LLMS open-source abordent ces problèmes en favorisant la collaboration et en permettant un examen minutieux, une modification et une amélioration. Cette approche ouverte est vitale pour faire progresser le domaine et assurer un accès équitable à la technologie LLM.

Le projet OLMO de l'Allen Institute for AI (AI2) illustre cet engagement. Olmo 2 va au-delà de la simple libération des poids du modèle; Il fournit les données de formation, le code, les recettes de formation, les points de contrôle intermédiaires et les modèles réglés par l'instruction. Cette version complète favorise la reproductibilité et l'innovation supplémentaire.

Comprendre Olmo 2

OLMO 2 améliore considérablement son prédécesseur, OLMO-0424. Ses modèles de paramètres 7B et 13B démontrent des performances comparables ou dépassant, ou dépassant des modèles entièrement ouverts similaires, même rivalisant avec des modèles ouverts comme Llama 3.1 sur les références académiques anglaises - une réussite remarquable compte tenu de ses flops de formation réduits.

Les améliorations clés comprennent:

- Gains de performance substantiels: olmo-2 (7b et 13b) montre une amélioration marquée par rapport aux modèles OLMO antérieurs, indiquant les progrès de l'architecture, des données ou de la méthodologie de formation.

- compétitif avec map-neo-7b: olmo-2, en particulier la version 13B, atteint des scores comparables à MAP-neo-7b, une solide ligne de base parmi les modèles entièrement ouverts.

Méthodologie de formation d'Olmo 2

L'architecture d'Olmo 2 OLMO s'appuie sur l'OLMO d'origine, incorporant des raffinements pour une stabilité et des performances améliorées. Le processus de formation comprend deux étapes:

- Fondation Fondation: utilise l'ensemble de données OLMO-MIX-1124 (environ 3,9 billions de jetons provenant de diverses sources ouvertes) pour établir une base solide pour la compréhension du langage.

- Raffinement et spécialisation: utilise l'ensemble de données Dolmino-MIX-1124, un mélange organisé de données Web de haute qualité et de données spécifiques au domaine (contenu académique, forums de questions-réponses, données d'enseignement, manuels de mathématiques), pour affiner les connaissances et les compétences du modèle. "Modèle de soupe" améliore encore le point de contrôle final.

Niveaux d'ouverture dans LLMS

Étant donné que Olmo-2 est un modèle entièrement ouvert, clarifions les distinctions entre les différents niveaux d'ouverture du modèle:

- Modèles ouverts: Seuls les poids du modèle sont libérés.

- Modèles partiellement ouverts: Libérez des informations supplémentaires au-delà des poids, mais pas une image complète du processus de formation.

- Modèles entièrement ouverts: Fournir une transparence complète, y compris des poids, des données de formation, du code, des recettes et des points de contrôle. Cela permet une reproductibilité complète.

Explorer et exécuter Olmo 2 localement

OLMO 2 est facilement accessible. Les instructions pour télécharger le modèle et les données, ainsi que le code de formation et les mesures d'évaluation, sont disponibles. Pour exécuter Olmo 2 localement, utilisez Olllama. Après l'installation, exécutez simplement ollama run olmo2:7b dans votre ligne de commande. Les bibliothèques nécessaires (Langchain et Gradio) peuvent être installées via Pip.

Construire un chatbot avec Olmo 2

Le code Python suivant montre la construction d'un chatbot utilisant Olmo 2, Gradio et Langchain:

import gradio as gr

from langchain_core.prompts import ChatPromptTemplate

from langchain_ollama.llms import OllamaLLM

def generate_response(history, question):

template = """Question: {question}

Answer: Let's think step by step."""

prompt = ChatPromptTemplate.from_template(template)

model = OllamaLLM(model="olmo2")

chain = prompt | model

answer = chain.invoke({"question": question})

history.append({"role": "user", "content": question})

history.append({"role": "assistant", "content": answer})

return history

with gr.Blocks() as iface:

chatbot = gr.Chatbot(type='messages')

with gr.Row():

with gr.Column():

txt = gr.Textbox(show_label=False, placeholder="Type your question here...")

txt.submit(generate_response, [chatbot, txt], chatbot)

iface.launch()

Ce code fournit une interface de chatbot de base. Des applications plus sophistiquées peuvent être construites sur cette fondation. Les exemples de sorties et d'invites sont affichés dans l'article d'origine.

Conclusion

OLMO 2 représente une contribution significative à l'écosystème LLM open source. Ses fortes performances, combinées à sa transparence complète, en font un outil précieux pour les chercheurs et les développeurs. Bien qu'il ne soit pas universellement supérieur à toutes les tâches, sa nature ouverte favorise la collaboration et accélère les progrès dans le domaine de l'IA accessible et transparente

Prise des clés:

- Le modèle de paramètre 13B d'Olmo-2 montre d'excellentes performances sur divers repères, surperformant d'autres modèles ouverts.

- L'ouverture complète du modèle facilite le développement de modèles plus efficaces.

- L'exemple de chatbot présente la facilité d'intégration avec Langchain et Gradio.

Les questions fréquemment posées (FAQ) (Les FAQ de l'article d'origine sont incluses ici.)

(Remarque: Les URL de l'image restent inchangées.)

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Robovan de Tesla était le joyau caché du teaser robotaxi de 2024Apr 22, 2025 am 11:48 AM

Robovan de Tesla était le joyau caché du teaser robotaxi de 2024Apr 22, 2025 am 11:48 AMDepuis 2008, j'ai défendu la camionnette partagée - initialement surnommée le "Robotjitney", plus tard le "Vansit" - comme l'avenir du transport urbain. Je prévois ces véhicules en tant que solution de transit de nouvelle génération du 21e siècle, surpas

Le club de Sam parie sur l'IA pour éliminer les chèques de réception et améliorer la vente au détailApr 22, 2025 am 11:29 AM

Le club de Sam parie sur l'IA pour éliminer les chèques de réception et améliorer la vente au détailApr 22, 2025 am 11:29 AMRévolutionner l'expérience de paiement Le système innovant "Just Go" du Sam du Sam s'appuie sur sa technologie de numérisation "Scan & Go" existante, permettant aux membres de scanner des achats via l'application Sam's Club pendant leur voyage de shopping.

L'omniverse AI de Nvidia se dilate au GTC 2025Apr 22, 2025 am 11:28 AM

L'omniverse AI de Nvidia se dilate au GTC 2025Apr 22, 2025 am 11:28 AMLa prévisibilité améliorée de Nvidia et la gamme de nouveaux produits au GTC 2025 Nvidia, un acteur clé de l'infrastructure d'IA, se concentre sur une prévisibilité accrue pour ses clients. Cela implique une livraison cohérente de produits, de répondre aux attentes de performance et

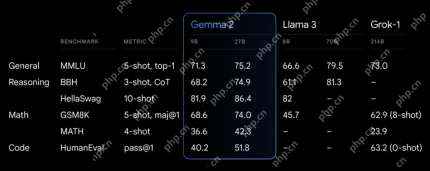

Explorer les capacités des modèles Google Gemma 2Apr 22, 2025 am 11:26 AM

Explorer les capacités des modèles Google Gemma 2Apr 22, 2025 am 11:26 AMGoogle's Gemma 2: un modèle de langage puissant et efficace La famille Gemma de modèles de langage de Google, célébrée pour l'efficacité et les performances, s'est développée avec l'arrivée de Gemma 2. Cette dernière version comprend deux modèles: un paramètre de 27 milliards

La prochaine vague de Genai: Perspectives avec le Dr Kirk Borne - Analytics VidhyaApr 22, 2025 am 11:21 AM

La prochaine vague de Genai: Perspectives avec le Dr Kirk Borne - Analytics VidhyaApr 22, 2025 am 11:21 AMCet épisode de direction avec des données présente le Dr Kirk Borne, un principal scientifique des données, astrophysicien et conférencier TEDX. Expert renommé en Big Data, IA et Machine Learning, le Dr Borne offre des informations inestimables sur l'état actuel et le futur traje

IA pour les coureurs et les athlètes: nous faisons d'excellents progrèsApr 22, 2025 am 11:12 AM

IA pour les coureurs et les athlètes: nous faisons d'excellents progrèsApr 22, 2025 am 11:12 AMIl y avait des perspectives très perspicaces dans ce discours - des informations sur le terrain sur l'ingénierie qui nous ont montré pourquoi l'intelligence artificielle est si bonne pour soutenir l'exercice physique des gens. Je vais décrire une idée de base du point de vue de chaque contributeur pour démontrer trois aspects de conception qui sont une partie importante de notre exploration de l'application de l'intelligence artificielle dans les sports. Dispositifs de bord et données personnelles brutes Cette idée de l'intelligence artificielle contient en fait deux composantes - l'une liée à l'endroit où nous placons de grands modèles de langue et l'autre est lié aux différences entre notre langage humain et la langue que nos signes vitaux «expriment» lorsqu'ils sont mesurés en temps réel. Alexander Amini en sait beaucoup sur la course et le tennis, mais il

Jamie Engstrom sur la technologie, le talent et la transformation à CaterpillarApr 22, 2025 am 11:10 AM

Jamie Engstrom sur la technologie, le talent et la transformation à CaterpillarApr 22, 2025 am 11:10 AMLe directeur de l'information de Caterpillar et vice-président principal de l'informatique, Jamie Engstrom, dirige une équipe mondiale de plus de 2 200 professionnels informatiques dans 28 pays. Avec 26 ans à Caterpillar, dont quatre ans et demi dans son rôle actuel, Engst

La nouvelle mise à jour de Google Photos fait apparaître n'importe quelle photo avec une qualité ultra hdrApr 22, 2025 am 11:09 AM

La nouvelle mise à jour de Google Photos fait apparaître n'importe quelle photo avec une qualité ultra hdrApr 22, 2025 am 11:09 AMLe nouvel outil Ultra HDR de Google Photos: un guide rapide Améliorez vos photos avec le nouvel outil ultra HDR de Google Photos, transformant des images standard en chefs-d'œuvre vibrants et à haut dynamique. Idéal pour les médias sociaux, cet outil augmente l'impact de toute photo,

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

Video Face Swap

Échangez les visages dans n'importe quelle vidéo sans effort grâce à notre outil d'échange de visage AI entièrement gratuit !

Article chaud

Outils chauds

mPDF

mPDF est une bibliothèque PHP qui peut générer des fichiers PDF à partir de HTML encodé en UTF-8. L'auteur original, Ian Back, a écrit mPDF pour générer des fichiers PDF « à la volée » depuis son site Web et gérer différentes langues. Il est plus lent et produit des fichiers plus volumineux lors de l'utilisation de polices Unicode que les scripts originaux comme HTML2FPDF, mais prend en charge les styles CSS, etc. et présente de nombreuses améliorations. Prend en charge presque toutes les langues, y compris RTL (arabe et hébreu) et CJK (chinois, japonais et coréen). Prend en charge les éléments imbriqués au niveau du bloc (tels que P, DIV),

SublimeText3 version anglaise

Recommandé : version Win, prend en charge les invites de code !

Version Mac de WebStorm

Outils de développement JavaScript utiles

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

SublimeText3 Linux nouvelle version

Dernière version de SublimeText3 Linux