Maison >Périphériques technologiques >IA >6 stratégies de personnalisation LLM communes ont brièvement expliqué

6 stratégies de personnalisation LLM communes ont brièvement expliqué

- 王林original

- 2025-02-25 16:01:08624parcourir

Cet article explore six stratégies clés pour personnaliser les modèles de grands langues (LLM), allant des techniques simples à des méthodes plus à forte intensité de ressources. Le choix de la bonne approche dépend de vos besoins spécifiques, des ressources et de l'expertise technique.

Pourquoi personnaliser les LLMS?

LLMS pré-formés, tandis que puissants, ne sont souvent pas des exigences commerciales ou de domaine spécifiques. La personnalisation d'un LLM vous permet d'adapter ses capacités à vos besoins exacts sans le coût prohibitif de la formation d'un modèle à partir de zéro. Ceci est particulièrement crucial pour les petites équipes dépourvues de ressources étendues.

Choisir le bon LLM:

Avant la personnalisation, la sélection du modèle de base approprié est critique. Les facteurs à considérer comprennent:

- Open-source vs propriétaire: Les modèles open source offrent une flexibilité et un contrôle, mais exigent des compétences techniques, tandis que les modèles propriétaires offrent une facilité d'accès et des performances souvent supérieures à un coût.

- Tâche et métriques: différents modèles excellent dans diverses tâches (réponse aux questions, résumé, génération de code). Les mesures de référence et les tests spécifiques au domaine sont essentiels.

- Architecture: Les modèles uniquement du décodeur (comme GPT) sont forts à la génération de texte, tandis que les modèles d'encodeur (comme T5) sont mieux adaptés à la traduction. Les architectures émergentes comme le mélange d'experts (MOE) sont prometteuses.

- Taille du modèle: Les modèles plus grands fonctionnent généralement mieux mais nécessitent plus de ressources de calcul.

six stratégies de personnalisation LLM (classées par intensité des ressources):

Les stratégies suivantes sont présentées dans l'ordre croissant de la consommation de ressources:

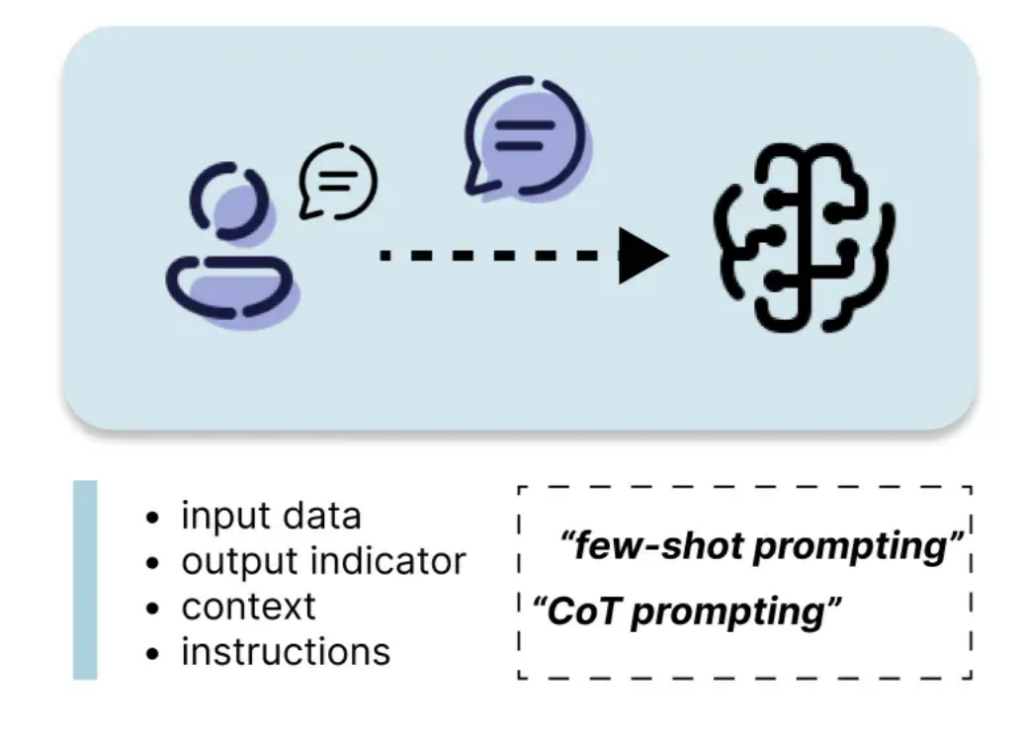

1. Ingénierie rapide

L'ingénierie rapide consiste à fabriquer soigneusement le texte d'entrée (invite) pour guider la réponse du LLM. Cela comprend les instructions, le contexte, les données d'entrée et les indicateurs de sortie. Des techniques comme les tirs zéro, une seule prise et à quelques coups, ainsi que des méthodes plus avancées comme la chaîne de pensée (COT), l'arbre de pensées, le raisonnement automatique et l'utilisation des outils (ART) et React, peuvent considérablement améliorer les performances . L'ingénierie rapide est efficace et facilement mise en œuvre.

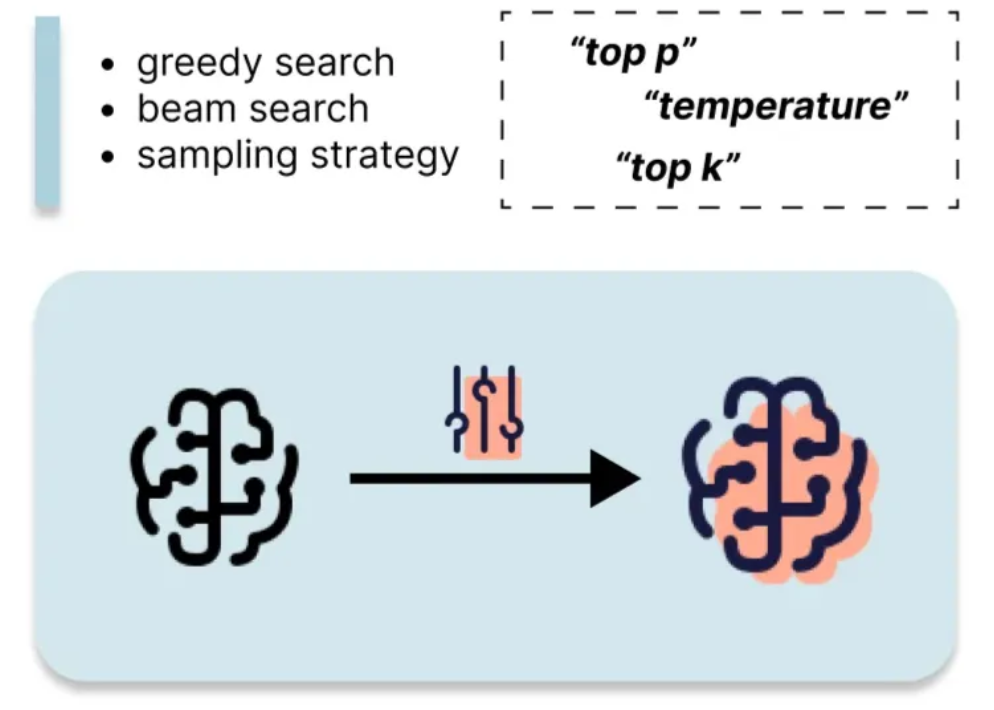

2. Stratégies de décodage et d'échantillonnage

Contrôle des stratégies de décodage (recherche gourmand, recherche de faisceau, échantillonnage) et paramètres d'échantillonnage (température, Top-K, Top-P) au moment de l'inférence vous permet d'ajuster le hasard et la diversité de la sortie de la LLM. Il s'agit d'une méthode à faible coût pour influencer le comportement du modèle.

3. Génération augmentée augmentée (RAG)

Rag améliore les réponses LLM en incorporant des connaissances externes. Il s'agit de récupérer des informations pertinentes à partir d'une base de connaissances et de les alimenter au LLM avec la requête de l'utilisateur. Cela réduit les hallucinations et améliore la précision, en particulier pour les tâches spécifiques au domaine. Le chiffon est relativement économe en ressources car il ne nécessite pas de recyclage du llm.

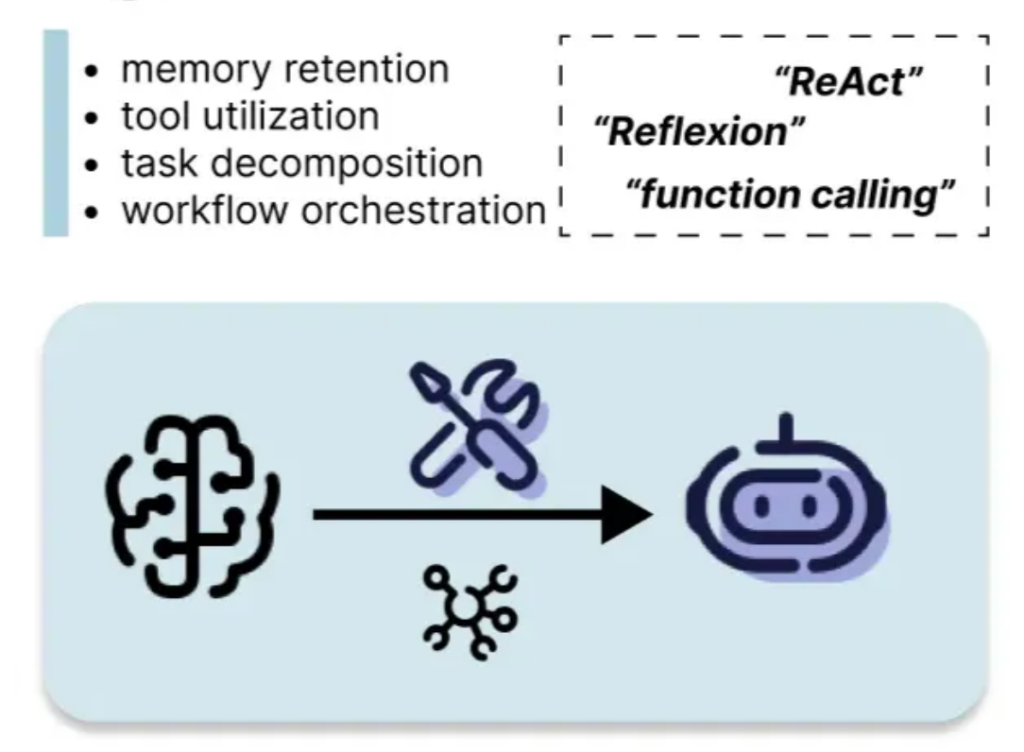

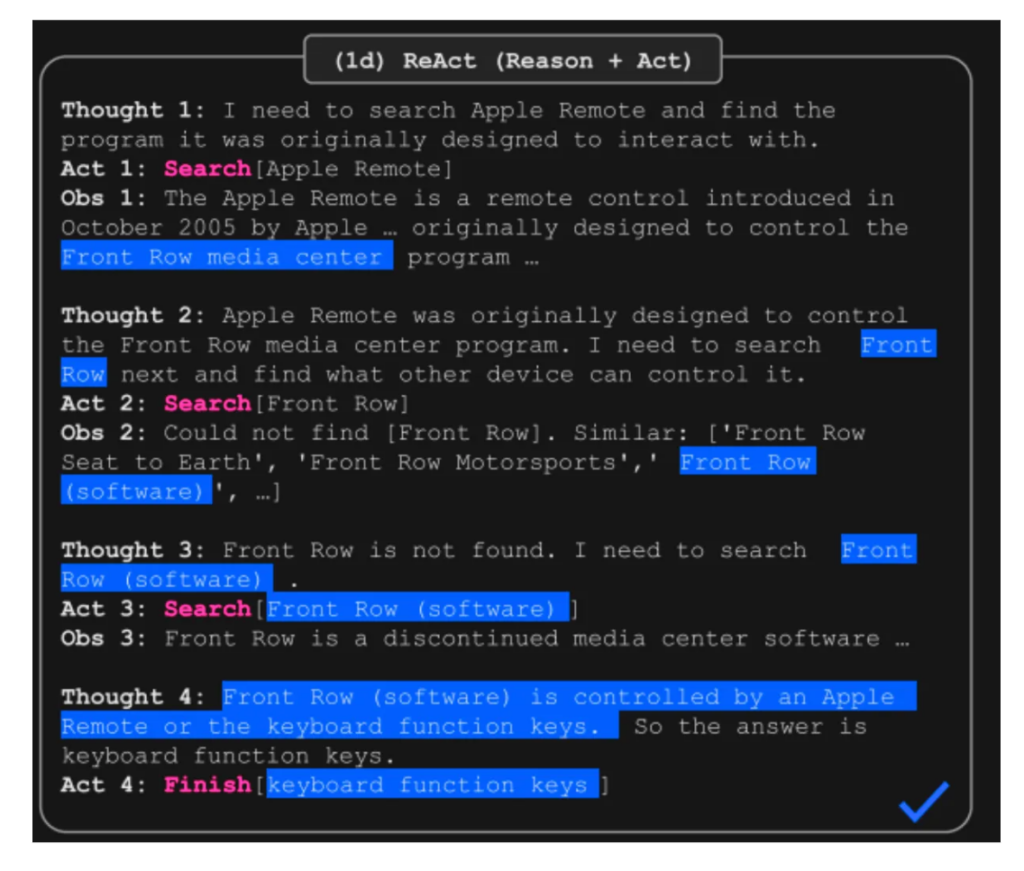

4. Systèmes basés sur des agents

Les systèmes basés sur les agents permettent aux LLMS d'interagir avec l'environnement, d'utiliser des outils et de maintenir la mémoire. Des cadres comme React (Synergising Reasoning and Agting) combinent le raisonnement avec les actions et les observations, améliorant les performances sur des tâches complexes. Les agents offrent des avantages importants dans la gestion des flux de travail complexes et l'utilisation des outils.

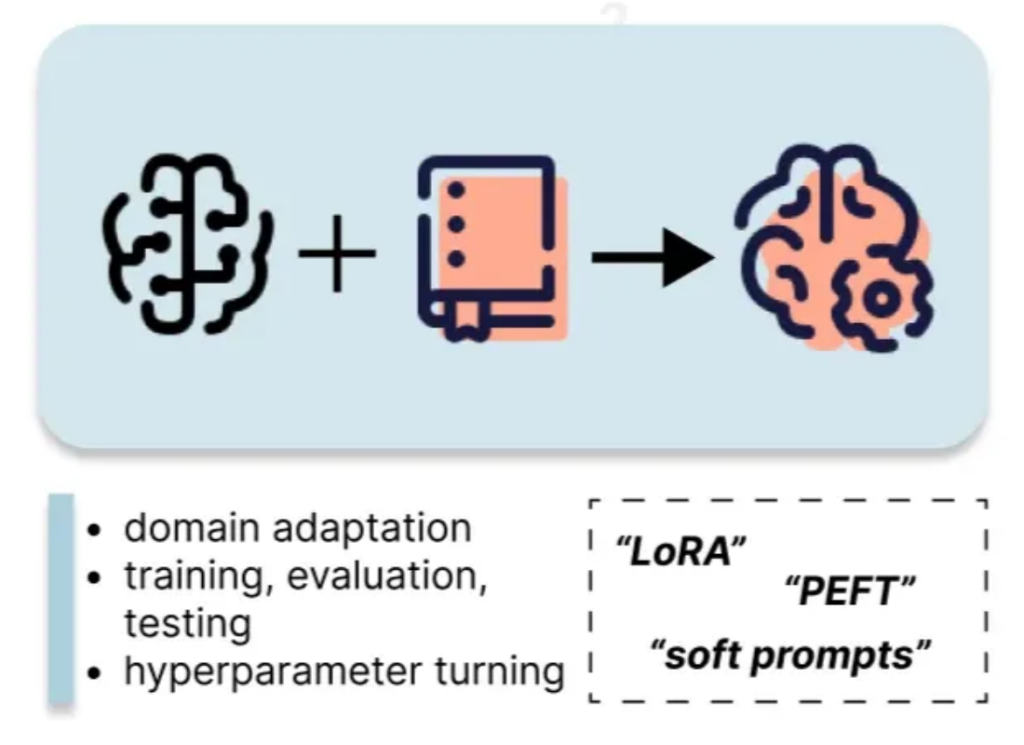

5. Dimension fine

Le réglage fin implique la mise à jour des paramètres de LLM à l'aide d'un ensemble de données personnalisé. Les méthodes de réglage fin et économes par les paramètres (PEFT), comme LORA, réduisent considérablement le coût de calcul par rapport au réglage fin complet. Cette approche nécessite plus de ressources que les méthodes précédentes mais fournit des gains de performance plus importants.

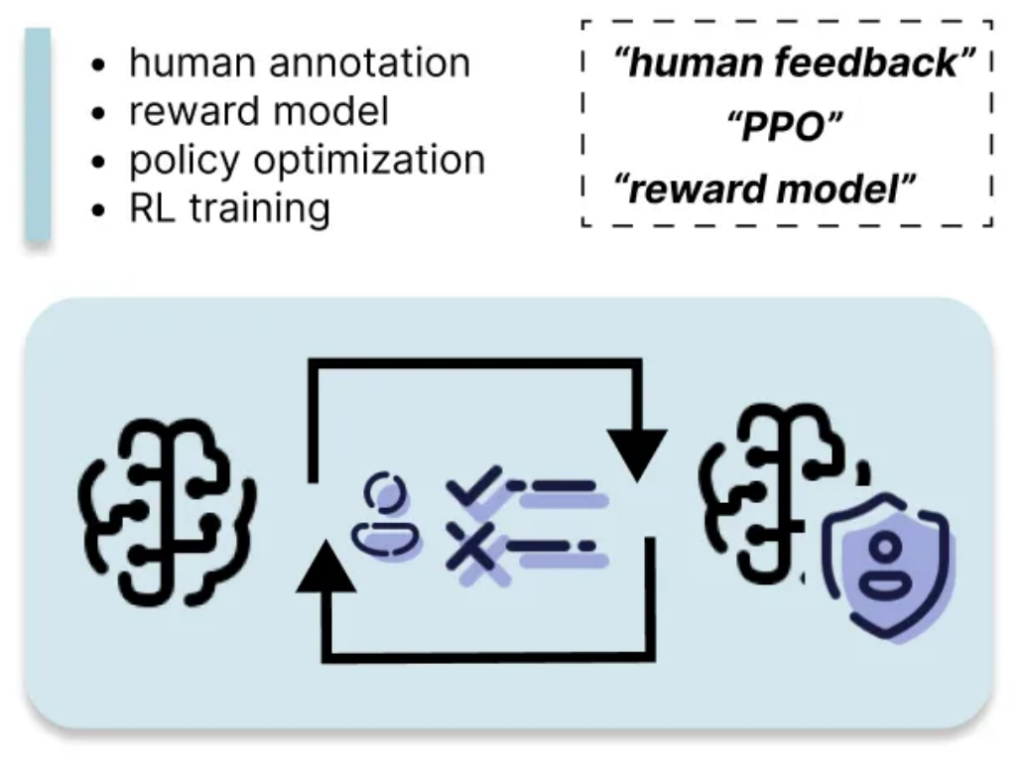

6. Renforcement d'apprentissage de la rétroaction humaine (RLHF)

RLHF aligne la sortie du LLM avec les préférences humaines en entraînant un modèle de récompense basé sur la rétroaction humaine. Il s'agit de la méthode la plus à forte intensité de ressources, nécessitant une annotation humaine et un pouvoir de calcul humaines importantes, mais cela peut entraîner des améliorations substantielles de la qualité de la réponse et de l'alignement avec le comportement souhaité.

Cet aperçu fournit une compréhension complète des différentes techniques de personnalisation LLM, vous permettant de choisir la stratégie la plus appropriée en fonction de vos exigences et ressources spécifiques. N'oubliez pas de considérer les compromis entre la consommation de ressources et les gains de performance lors de votre sélection.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI