Maison >Périphériques technologiques >IA >Llama 3 contre GPT-4 : quel est le meilleur ?

Llama 3 contre GPT-4 : quel est le meilleur ?

- William Shakespeareoriginal

- 2024-12-13 16:24:00847parcourir

Liens rapides

Llama 3 et GPT-4 sont deux des grands modèles de langage (LLM) les plus avancés disponibles au public. Voyons quel LLM est le meilleur en comparant les deux modèles en termes de multimodalité, de longueur de contexte, de performances et de coût.

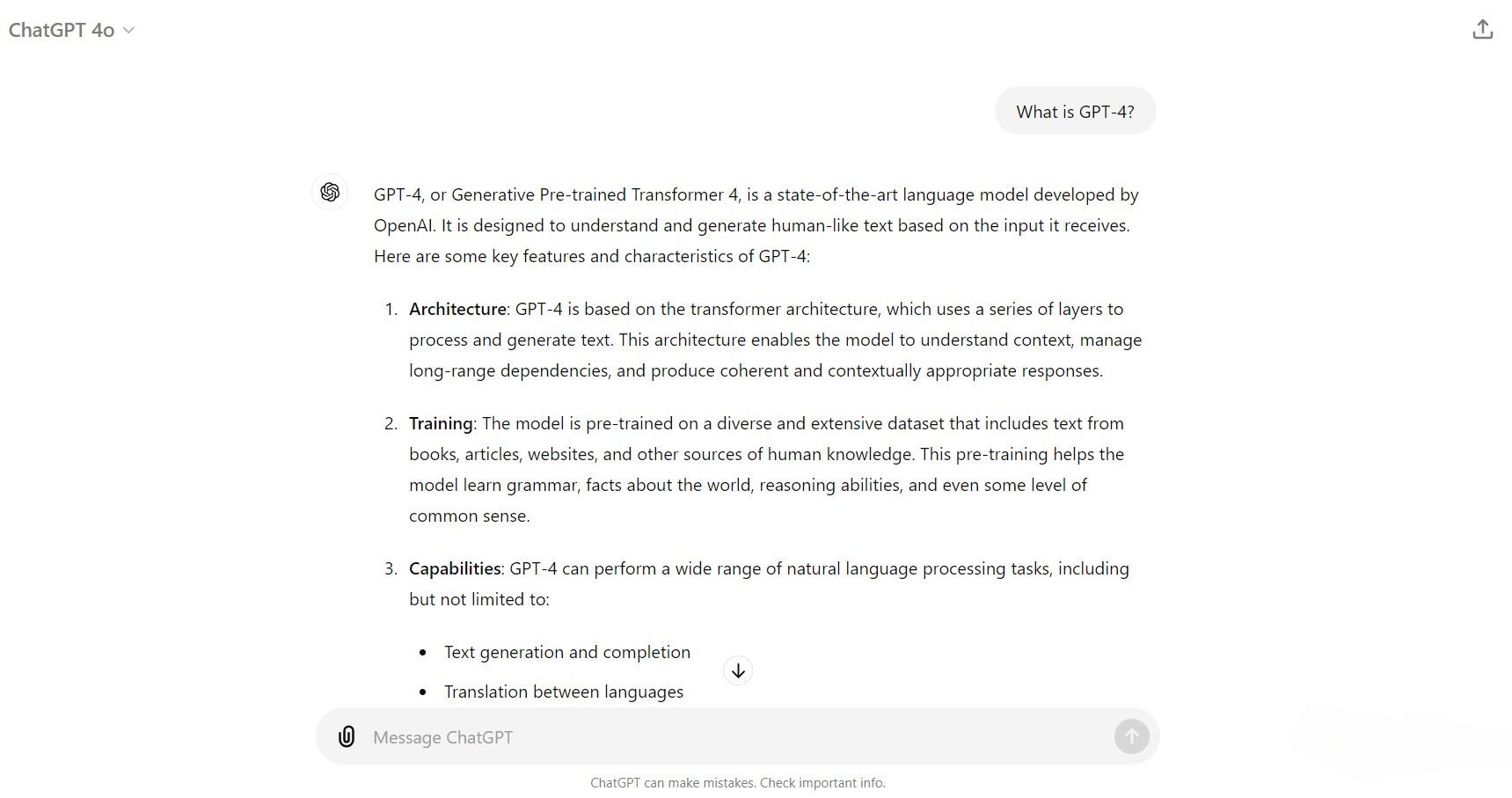

Qu'est-ce que GPT-4 ?

GPT-4 est le dernier grand modèle de langage (LLM) développé par OpenAI. Il s'appuie sur les fondations des anciens modèles GPT-3 tout en utilisant différentes techniques de formation et optimisations utilisant un ensemble de données beaucoup plus vaste. Cela a considérablement augmenté la taille des paramètres de GPT-4, qui aurait un total combiné de 1,7 billion de paramètres provenant de ses plus petits modèles experts. Grâce à la nouvelle formation, aux optimisations et au plus grand nombre de paramètres, GPT-4 apporte des améliorations dans le raisonnement, la résolution de problèmes, la compréhension du contexte et une meilleure gestion des instructions nuancées.

Il existe actuellement trois variantes du modèle :

- GPT-4 : Une évolution de GPT-3 avec des améliorations significatives en termes de vitesse, de précision et de base de connaissances.

- GPT-4 Turbo : Une version optimisée de GPT-4, conçue pour offrir des performances plus rapides tout en réduisant les coûts opérationnels.

- GPT-4o (Omni) : Étend les capacités de GPT-4 en intégrant des entrées et sorties multimodales, notamment du texte, de la vision et de l'audio.

Vous pouvez désormais accéder aux trois modèles GPT-4 en vous abonnant aux services API d'OpenAI, en interagissant avec ChatGPT ou via des services tels que Descript, Perplexity AI et les divers copilotes de Microsoft.

Qu'est-ce que Lama 3 ?

Llama 3 est un LLM open source développé par Meta AI (société mère de Facebook, Instagram et WhatsApp), formé en utilisant une combinaison de réglage fin supervisé, d'échantillonnage de rejet et d'optimisation de politiques avec un ensemble de données diversifié comprenant des millions de exemples annotés par des humains. Sa formation s'est concentrée sur des invites de haute qualité et des classements de préférences, dans le but de créer un modèle d'IA polyvalent et performant.

Il existe actuellement deux modèles Llama 3 disponibles au public : Llama 3 8B et Llama 3 70B. Le « B » signifie milliard, indiquant la taille des paramètres du modèle. Meta forme également un modèle Llama 3 400B, dont le lancement est prévu fin 2024.

Vous pouvez accéder à Llama 3 via Meta AI, son chatbot génératif d'IA. Alternativement, vous pouvez exécuter les LLM localement sur votre ordinateur en téléchargeant les modèles Llama 3 et en les chargeant via Ollama, Open WebUI ou LM Studio.

Multimodalité

La sortie de GPT-4o a enfin concrétisé la commercialisation initiale de GPT-4 ayant des capacités multimodales. Ces fonctionnalités multimodales sont désormais accessibles en interagissant avec ChatGPT à l'aide du modèle GPT-4o. Depuis juin 2024, GPT-4o ne dispose d'aucun moyen intégré de génération de vidéo et d'audio. Cependant, il a la capacité de générer du texte et des images basées sur des entrées vidéo et audio.

Llama 3 prévoit également de fournir un modèle multimodal pour le prochain Llama 3 400B. Il intégrera très probablement des technologies similaires à CLIP (Contrast Language-Imager Pre-Training) pour générer des images à l'aide de techniques d'apprentissage zéro-shot. Mais comme Llama 400B est encore en formation, la seule façon pour les modèles 8B et 70B de générer des images est d'utiliser des extensions telles que LLaVa, Visual-LLaMA et LLaMA-VID. Pour l'instant, Llama 3 est purement un modèle basé sur un langage qui peut prendre du texte, des images et de l'audio comme entrées pour générer du texte.

Longueur du contexte

La longueur du contexte fait référence à la quantité de texte qu'un modèle peut traiter à la fois. Il s'agit d'un facteur important lors de l'examen des capacités d'un LLM, car il dicte la quantité de contexte avec lequel le modèle peut fonctionner lors de l'interaction avec les utilisateurs. En général, une longueur de contexte plus élevée rend un LLM meilleur car il offre un niveau plus élevé de cohérence, de continuité et peut réduire les répétitions d'erreurs lors des interactions.

| Description des données de formation | Params | Longueur du contexte | GQA | Nombre de jetons | Seuil de connaissances | |||||||||||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| Llama 3 | Mélange de données en ligne accessibles au public | 8B | 8k | Oui | 15T | Mars 2023 | |||||||||||||||||||||

| Lama 3 | Mélange de données en ligne accessibles au public | 70B | 8k | Oui | 15T | Décembre 2023 |

Les modèles Llama 3 présentent une longueur de contexte effective de 8 000 jetons (environ 6 400 mots). Cela signifie qu'un modèle Llama 3 aura une mémoire contextuelle d'environ 6 400 mots au sein de votre interaction. Tous les mots dépassant la limite de 8 000 jetons seront oubliés et ne fourniront aucun autre contexte pendant l'interaction.

| Description | Fenêtre contextuelle | Données d'entraînement | ||||||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| GPT-4o | Modèle phare multimodal, moins cher et plus rapide que le GPT-4 Turbo.128 000 jetons (API) | Jusqu'en octobre 2023 | |||||||||||||||||

| GPT- 4-Turbo | Modèle GPT-4 Turbo simplifié avec des capacités de vision. | 128 000 jetons (API) | Jusqu'en décembre 2023 | ||||||||||||||||

| GPT-4 | Premier modèle GPT-4 | 8 192 jetons | Jusqu'en septembre 2021 |

En revanche, GPT-4 prend désormais en charge une longueur de contexte nettement plus grande de 32 000 jetons (environ 25 600 mots) pour les utilisateurs de ChatGPT et de 128 000 jetons (environ 102 400 mots) pour ceux qui utilisent des points de terminaison d'API. Cela donne aux modèles GPT-4 un avantage dans la gestion de conversations approfondies et la possibilité de lire de longs documents ou même un livre entier.

Performances

Comparons les performances en examinant le Llama 3 du 18 avril 2024, rapport de référence de Meta AI et le GPT-4 du 14 mai 2024, rapport GitHub par OpenAI. Voici les résultats :

| MMLU | GPQA | MATH | HumanEval | DROP | ||||||||||||||||||||||||||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| GPT-4o | 88,7 | 53,6 | 76,6 | 90,2 | 83,4 | ||||||||||||||||||||||||||||||||||||

| GPT-4 Turbo | 86,5 | 49,1 | 72,2 | 87,6 | 85,4 | ||||||||||||||||||||||||||||||||||||

| Llama3 8B | 68,4 | 34,2 | 30,0 | 62,2 | 58,4 | ||||||||||||||||||||||||||||||||||||

| Lama3 70B | 82,0 | 39,5 | 50,4 | 81,7 | 79,7 | ||||||||||||||||||||||||||||||||||||

| Llama3 400B | 86,1 | 48,0 | 57,8 | 84,1 | 83,5 |

Voici ce que chaque critère évalue :

- MMLU (Massive Multitask Language Understanding) : Évalue la capacité du modèle à comprendre et à répondre à des questions dans une variété de domaines académiques. sujets.

- GPTQA (General Purpose Question Answering) : Évalue les compétences du modèle à répondre à des questions factuelles de domaine ouvert

- MATH : Teste la capacité du modèle à résoudre des problèmes mathématiques.

- HumanEval : Mesure la capacité du modèle à générer un code correct en fonction des invites de programmation données par les humains.

- DROP (Discrete Reasoning Over Paragraphs) : Évalue la capacité du modèle à effectuer un raisonnement discret et à répondre à des questions basées sur des passages de texte.

Les récents benchmarks mettent en évidence la différence de performances entre les modèles GPT-4 et Llama 3. Bien que le modèle Llama 3 8B semble nettement à la traîne, les modèles 70B et 400B fournissent des résultats inférieurs mais similaires aux modèles GPT-4o et GPT-4 Turbo en termes de connaissances académiques et générales, de lecture et de compréhension, de raisonnement et de logique, et codage. Cependant, aucun modèle Llama 3 n'est encore proche des performances de GPT-4 en termes de mathématiques pures.

Coût

Le coût est un élément essentiel facteur pour de nombreux utilisateurs. Le modèle GPT-4o d'OpenAI est disponible gratuitement pour tous les utilisateurs de ChatGPT dans une limite de 16 messages toutes les 3 heures. Si vous avez besoin de plus, vous devrez vous abonner à ChatGPT Plus, qui coûte 20 USD par mois pour étendre la limite de messages de GPT-4o à 80 tout en ayant également accès aux autres modèles GPT-4.

Activé. d'un autre côté, les modèles Llama 3 8B et 70B sont gratuits et open source, ce qui peut constituer un avantage significatif pour les développeurs et les chercheurs à la recherche d'une solution rentable sans faire de compromis sur performances.

Accessibilité

Les modèles GPT-4 sont largement accessibles via le chatbot IA génératif ChatGPT d'OpenAI et via son API. Vous pouvez également utiliser GPT-4 sur Microsoft Copilot, ce qui est une façon d'utiliser GPT-4 gratuitement. Cette disponibilité généralisée garantit que les utilisateurs peuvent facilement exploiter ses capacités dans différents cas d'utilisation. En revanche, Llama 3 est un projet open source qui offre une flexibilité de modèle et encourage une expérimentation et une collaboration plus larges au sein de la communauté de l'IA. Cette approche en libre accès peut démocratiser la technologie de l'IA, la rendant accessible à un public beaucoup plus large.

Bien que les deux modèles soient facilement disponibles, GPT-4 est beaucoup plus facile à utiliser car il est intégré aux outils et services de productivité populaires. . D'un autre côté, Llama 3 est principalement intégré à des plateformes de recherche et commerciales comme Amazon Bedrock, Ollama et DataBricks (à l'exception de l'assistance de chat Meta AI), ce qui ne séduit pas le marché plus large des utilisateurs non techniques.

GPT-4 contre Llama 3 : quel est le meilleur ?

Alors, quel LLM est le meilleur ? Je dois dire que GPT-4 est le meilleur LLM. GPT-4 excelle dans la multimodalité avec des capacités avancées de gestion des entrées de texte, d'image et audio, tandis que les fonctionnalités similaires de Llama 3 sont encore en développement. GPT-4 offre également une longueur de contexte beaucoup plus grande et de meilleures performances et est largement accessible via des outils et services populaires, ce qui le rend plus convivial.

Cependant, il est important de souligner que les modèles Llama 3 ont fonctionné exceptionnellement bien. pour un projet gratuit et open-source. En conséquence, Llama 3 reste un LLM remarquable, privilégié par les chercheurs et les entreprises pour sa nature gratuite et open source tout en offrant des performances, une flexibilité et des fonctionnalités de confidentialité impressionnantes. Même si le grand public ne trouvera peut-être pas d'utilité immédiate à Llama 3, il reste l'option la plus viable pour de nombreux chercheurs et entreprises.

En conclusion, bien que GPT-4 se distingue par ses capacités multimodales avancées, sa plus grande longueur de contexte et Intégration transparente dans des outils largement utilisés, Llama 3 offre une alternative précieuse grâce à sa nature open source, permettant une plus grande personnalisation et des économies de coûts. Ainsi, en termes d'application, GPT-4 est idéal pour ceux qui recherchent une facilité d'utilisation et des fonctionnalités complètes dans un modèle, tandis que Llama 3 convient bien aux développeurs et aux chercheurs à la recherche de flexibilité et d'adaptabilité.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI