Maison >Périphériques technologiques >IA >Rapport technique Google Gemini 1.5 : prouvez facilement les questions de l'Olympiade mathématique, la version Flash est 5 fois plus rapide que GPT-4 Turbo

Rapport technique Google Gemini 1.5 : prouvez facilement les questions de l'Olympiade mathématique, la version Flash est 5 fois plus rapide que GPT-4 Turbo

- PHPzoriginal

- 2024-06-13 13:52:271334parcourir

En février de cette année, Google a lancé le grand modèle multimodal Gemini1.5, qui a considérablement amélioré les performances et la vitesse grâce à l'ingénierie et à l'optimisation de l'infrastructure, à l'architecture MoE et à d'autres stratégies. Avec un contexte plus long, des capacités de raisonnement plus fortes et une meilleure gestion du contenu multimodal.

Ce vendredi, Google DeepMind a officiellement publié le rapport technique de Gemini 1.5, qui couvre la version Flash et d'autres mises à jour récentes. Le document fait 153 pages.

Lien du rapport technique : https://storage.googleapis.com/deepmind-media/gemini/gemini_v1_5_report.pdf

Dans ce rapport, Google présente les modèles de la série Gemini 1.5. Il représente la prochaine génération de grands modèles multimodaux hautement efficaces sur le plan informatique, capables de rappeler des informations et des raisonnements fins à partir du contexte de millions de jetons, y compris plusieurs longs documents et des heures de vidéo. Les modèles de la série Gemini 1.5 ont de multiples capacités de raisonnement linguistique et visuel, ce qui les rend largement utilisés dans les domaines du traitement du langage naturel et de la vision par ordinateur. Le modèle est capable d'extraire des informations clés du texte et d'effectuer des inférences, ainsi qu'une analyse complète de plusieurs documents longs. De plus, il prend en charge le traitement de grandes quantités de données visuelles et est capable de traiter de grandes quantités de données visuelles en quelques heures

La série comprend deux nouveaux modèles :

- Le Gemini 1.5 Pro mis à jour avec la plupart des fonctionnalités et des tests de référence Février La version de

- Gemini 1.5 Flash, une variante plus légère conçue pour l'efficacité avec une pénalité de performances minimale.

Concernant la version Flash mentionnée lors de la conférence Google I/O cette semaine, le rapport indique que Gemini 1.5 Flash est un modèle de décodeur Transformer avec le même contexte 2M+ et les mêmes capacités multimodales que Gemini 1.5 Pro. Utilise efficacement les unités de traitement tensoriel (TPU) et présente une faible latence de service de modèle. Par exemple, Gemini 1.5 Flash peut calculer les composants d'attention et de rétroaction en parallèle, et est également un modèle Gemini 1.5 Pro avec des capacités d'extraction en ligne de réseau plus importantes. Il est formé à l’aide de méthodes de prétraitement d’ordre élevé pour améliorer la qualité.

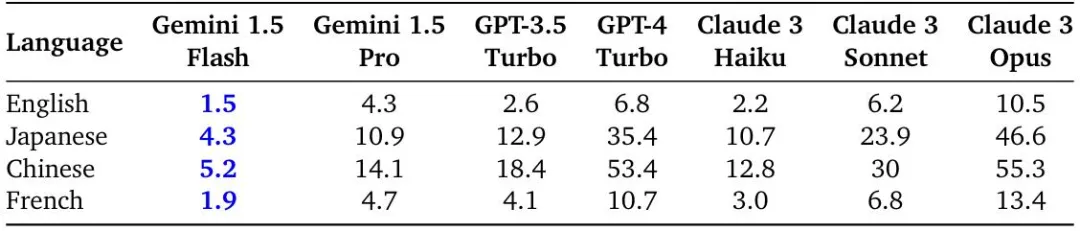

Le rapport évalue le temps moyen par caractère de sortie pour les requêtes en anglais, chinois, japonais et français extraites de Gemini 1.5 et de l'API Vertex AI Streaming.

Durée par caractère de sortie (ms) pour les réponses en anglais, chinois, japonais et français, avec 10 000 caractères saisis, Gemini 1.5 Flash a atteint la génération la plus rapide de toutes les langues testées.

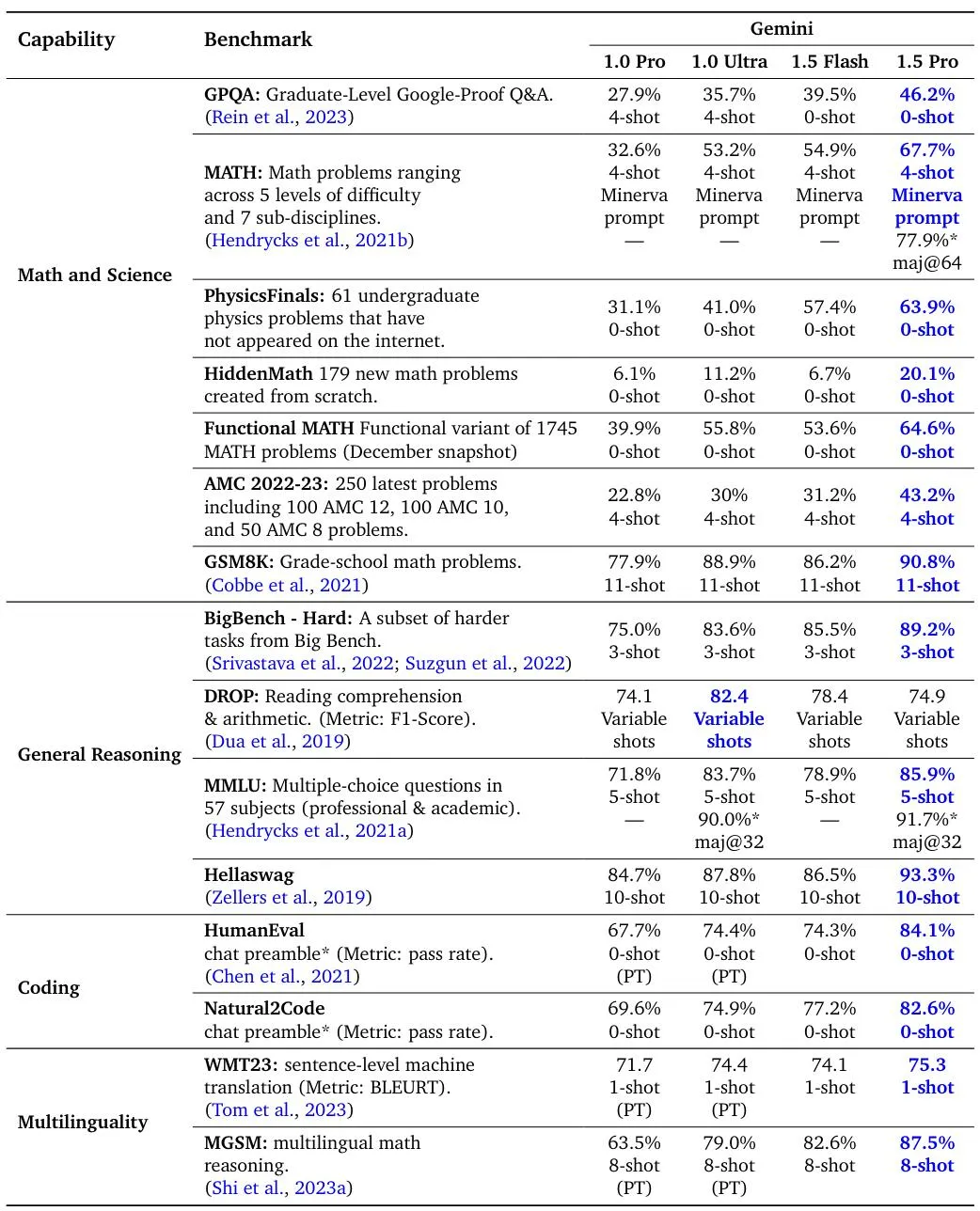

Résultats d'évaluation des modèles Gemini 1.5 Pro, 1.5 Flash et Gemini 1.0 sur des critères de codage standard, multilingues et mathématiques, scientifiques et de raisonnement. Tous les numéros pour les 1.5 Pro et 1.5 Flash sont obtenus après ajustements des commandes.

Gemini 1.5 Pro comparé à Gemini 1.0 Pro et Ultra sur les benchmarks de compréhension vidéo.

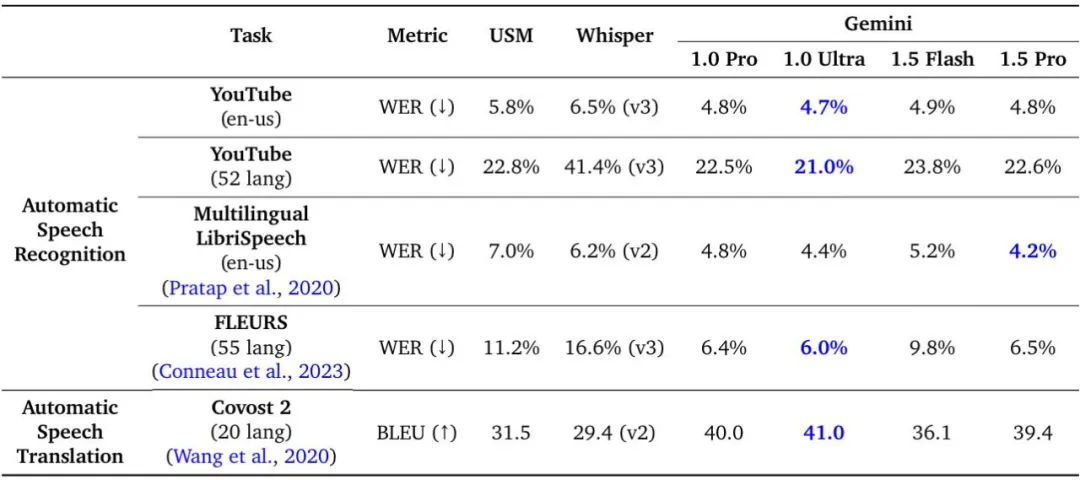

Comparaison de Gemini 1.5 Pro avec USM, Whisper, Gemini 1.0 Pro et Gemini 1.0 Ultra sur les tâches de compréhension audio.

Le modèle Gemini 1.5 atteint un rappel presque parfait sur les tâches de récupération de contexte long multimodal, améliore le niveau optimal d'assurance qualité des documents longs, d'assurance qualité des vidéos longues et d'ASR de contexte long, et correspond ou dépasse l'état de livraison de Gemini 1.0 Ultra. des performances de pointe sur un large éventail de références. En outre, Google a également déclaré qu'en mai de cette année, les performances de Gemini 1.5 avaient été considérablement améliorées par rapport à février.

Gemini 1.5 Pro (mai) par rapport à la version initiale (février) sur plusieurs benchmarks. Le dernier Gemini 1.5 Pro offre des améliorations dans tous les tests d'inférence, d'encodage, de vision et de vidéo, tandis que les performances audio et de traduction restent inchangées. Notez que pour FLEURS, les scores les plus bas sont meilleurs.

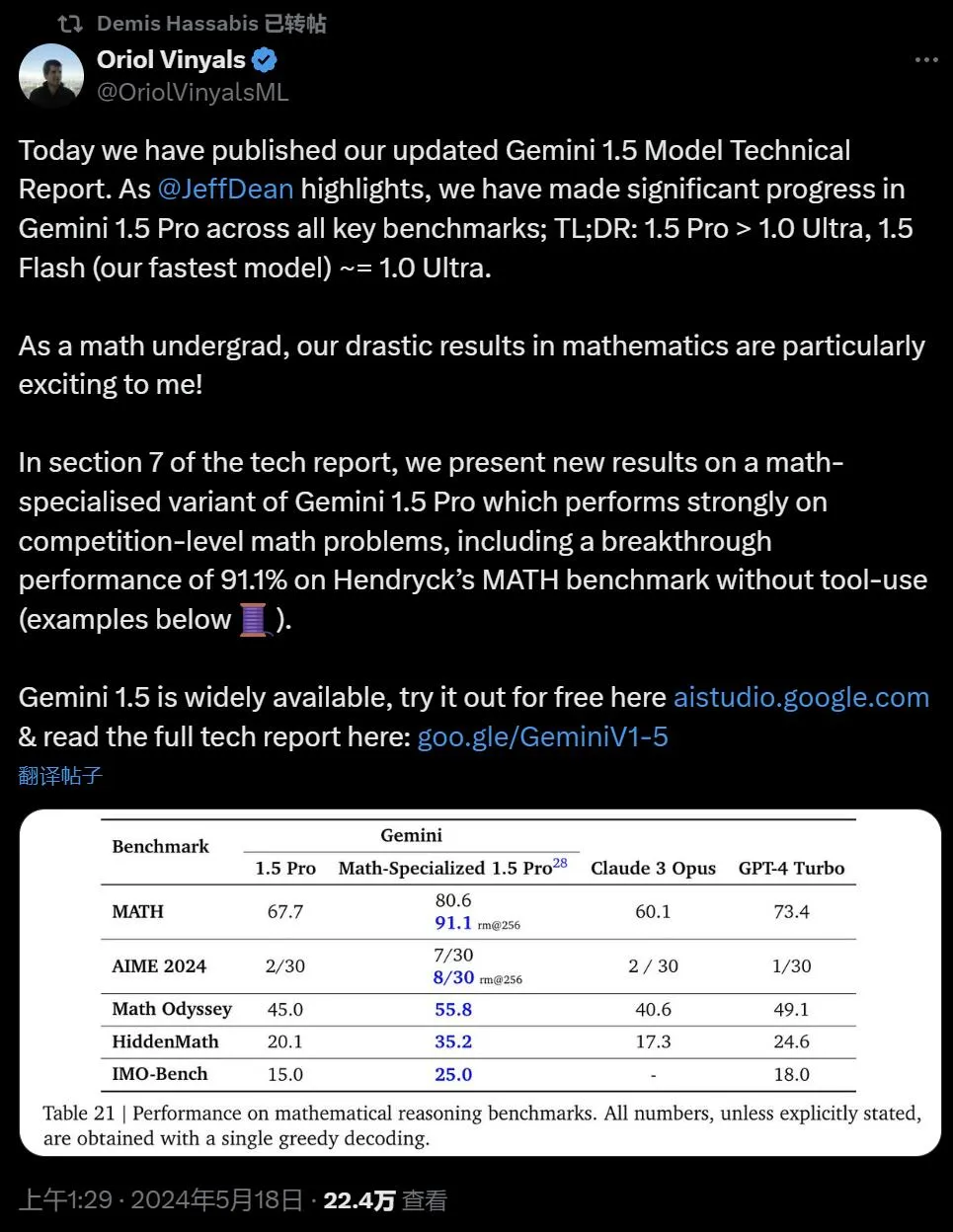

Oriol Vinyals, vice-président de Google DeepMind et co-responsable du projet Gemini, a conclu que Gemini 1.5 Pro > 1.0 Ultra, 1.5 Flash (actuellement le modèle le plus rapide) ~= 1.0 Ultra.

En étudiant les limites des capacités de contexte long de Gemini 1.5, nous pouvons constater des améliorations continues dans la prédiction du prochain jeton et une récupération presque parfaite (> 99 %). Un saut générationnel par rapport aux modèles existants tels que Claude 3.0 (200k) et GPT-4 Turbo (128k).

Dans le septième chapitre du rapport, Google présente les benchmarks de la version mathématique améliorée de Gemini 1.5 Pro, qui fonctionne bien sur les problèmes mathématiques de niveau compétition, y compris sur le benchmark MATH de Hendryck sans utiliser d'outils. de 91,1%.

Voici quelques exemples de modèles résolvant des problèmes de l'Olympiade mathématique de l'Asie-Pacifique (APMO) que les modèles précédents ne pouvaient clairement pas résoudre. Oriol Vinyals dit que cette réponse est excellente car c'est une preuve (plutôt qu'un calcul), la solution est pertinente et elle est « belle ».

Enfin, Google a mis en évidence des cas d'utilisation réels de grands modèles, tels que Gemini 1.5, qui travaille avec des professionnels pour accomplir des tâches et atteindre des objectifs, permettant ainsi d'économiser 26 à 75 % de temps dans 10 catégories d'emplois différentes.

Ce grand modèle de langage de pointe présente également de nouvelles fonctionnalités surprenantes. Lorsqu'on lui donne un manuel de grammaire pour le Kalamang, une langue parlée par moins de 200 personnes dans l'ouest de la Papouasie-Nouvelle-Guinée, le modèle pourrait apprendre à traduire l'anglais en Kalamang à un niveau similaire à celui des humains qui apprennent à partir du même contenu.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- À quel modèle la structure du réseau à 7 couches fait-elle référence ?

- Comment annuler le blocage des pop-ups dans Google Chrome

- Comment empêcher Google Chrome de se mettre à jour automatiquement

- Comment activer l'accès à la caméra dans Google Chrome

- Où se trouve l'entrée de la version Web de Google Chrome ? entrée du moteur de recherche Google Chrome