Technology peripherals

Technology peripherals AI

AI LeCun's latest interview: Why will the physical world eventually become the 'Achilles heel” of LLM?

LeCun's latest interview: Why will the physical world eventually become the 'Achilles heel” of LLM?In the field of artificial intelligence, there are few scholars like Yann LeCun who are still highly active on social media at the age of 65.

Yann LeCun is known as an outspoken critic of artificial intelligence. He has been an active supporter of the open source spirit and led Meta's team to launch the popular Llama 2 model, becoming a leader in the field of open source large models. Although many people are anxious about the future of artificial intelligence and worry about possible doomsday scenarios, LeCun holds a different view and firmly believes that the development of artificial intelligence will have a positive impact on society, especially the arrival of super intelligence.

Recently, LeCun once again came to Lex Fridman's podcast and started a nearly three-hour conversation, covering the importance of open source, the limitations of LLM, and why artificial intelligence What smart doomsayers are wrong about, and the path to AGI.

Watch page: https://youtu.be/5t1vTLU7s40?feature=shared

us Here are some valuable points from this podcast:

Limitations of LLM

Lex Fridman: You said that autoregressive LLM is not how we will make progress toward superhuman intelligence. Why can’t they take us all the way?

Yann LeCun: For many reasons. First, intelligent behavior has many characteristics. For example, the ability to understand the world, the ability to understand the physical world, the ability to remember and retrieve things, persistent memory, reasoning and planning abilities. These are four basic characteristics of intelligent systems or entities, humans, animals. LLM cannot do these, or can only do them in a very primitive way, and does not really understand the physical world. The LLM has no real lasting memory, can't really reason, and certainly can't plan. So if you expect a system to be smart but not be able to do these things, you're making a mistake. This is not to say that autoregressive LLMs are useless. They're certainly useful, but they're not interesting and we can't build an entire app ecosystem around them. But as a passport to human-level intelligence, they lack the necessary building blocks.

We see much more information through sensory input than through language, and despite our intuition, most of what we learn and what we know is through We observe and interact with the real world, not through words. Everything we learn in the first years of life, and certainly everything animals learn, has nothing to do with language.

Lex Fridman: Is that what you said, LLM lacks understanding of the physical world? So, intuitive physics, common sense reasoning about physical space, about physical reality, is nothing special to you. Is this a huge leap that LLM can’t make?

Yann LeCun: The LLM we use today cannot do this for many reasons, but the main reason is that the LLM The training method is: you take a piece of text, delete some words in the text, mask them, replace them with blank tokens, and then train a genetic neural network to predict the missing words. If you build this neural network in a special way so that it can only look at the word to the left or the word it's trying to predict, then what you have is a system that's basically trying to predict the next word in the text. So you can give it a text, a prompt, and have it predict the next word. It can never accurately predict the next word.

So what it does is generate a probability distribution over all possible words in the dictionary. In fact, it doesn't predict words. It predicts chunks of words as units of subwords, so it's easy to handle uncertainty in predictions because there are only a limited number of words that may appear in the dictionary and you just calculate their distribution. The system then selects a word from this distribution. Of course, in this distribution, the probability of selecting a word with a higher probability will be higher. So you sample from that distribution, actually produce a word, and then move that word into the input so that the system doesn't predict the second word.

This is called autoregressive prediction, which is why these LLMs should be called "autoregressive LLMs", but we just call them LLMs. This process is different from the process before producing a word.

Когда мы с вами разговариваем, а мы оба двуязычны, мы думаем о том, что собираемся сказать, и это относительно независимо от языка, на котором мы собираемся сказать. Когда мы говорим о математическом понятии, наши размышления и ответ, который мы намереваемся дать, не имеют ничего общего с тем, выражаем ли мы его на французском, русском или английском языке.

Лекс Фридман: Хомский закатил глаза, но я понимаю, значит, вы говорите, что существует более крупная абстракция, которая существует до языка и отображается на него?

Ян ЛеКун: Что касается многих наших мыслей, то да.

Лекс Фридман: Ваш юмор абстрактный? Когда вы пишете твит, а ваши твиты иногда бывают немного пикантными, возникает ли у вас в мозгу абстрактное представление до того, как твит будет переведен на английский язык?

Янн ЛеКун: Существует действительно абстрактное представление, позволяющее представить реакцию читателя на текст. Но размышления о математической концепции или воображении того, что вы хотите сделать из дерева, или что-то в этом роде, не имеют абсолютно ничего общего с языком. У вас нет внутреннего монолога на определенном языке. Вы представляете мысленную модель вещей. Я имею в виду, что если я попрошу вас представить, как бы выглядела эта бутылка с водой, если бы я поверну ее на 90 градусов, это не имеет никакого отношения к языку. Понятно, что большая часть нашего мышления происходит на более абстрактном репрезентативном уровне. Если результатом является речь, мы планируем то, что собираемся сказать. Вместо того, чтобы выводить мускульные движения, мы планируем ответ до того, как его сделаем. Ответ.

LLM этого не делает, а просто инстинктивно произносит слово за словом. Это что-то вроде подсознательного движения, когда кто-то задает вам вопрос, а вы отвечаете на него. Раздумывать над ответом не было времени, но он был прост. Так что вам не нужно обращать внимание, он отреагирует автоматически. Это то, что делает LLM. Он вообще не думает об ответах. Поскольку он накопил много знаний, он может извлечь некоторые вещи, но он будет просто выплевывать жетон за жетоном, не планируя ответа.

Лекс Фридман: Генерация токена за токеном обязательно является упрощенной, но если модель мира достаточно сложна, то, скорее всего, будет сгенерирована серия токенов, которые будут эзотерическими вещами.

Ян ЛеКун: Но это основано на предположении, что эти системы на самом деле имеют вечную модель мира.

Видео прогнозирование

Лекс Фридман: Итак, реальный вопрос заключается в следующем... Можем ли мы построить модель, которая будет глубоко понимать мир?

Янн ЛеКун

: Можете ли вы построить это на основе прогнозов, ответ, вероятно, да. Но можно ли его построить, предсказывая слова? Ответ, скорее всего, отрицательный, потому что язык очень беден при слабой или низкой пропускной способности и не содержит достаточного количества информации. Таким образом, построение модели мира означает изучение мира, понимание того, почему мир развивается именно так, а затем дополнительный компонент модели мира — возможность предсказать, как мир будет развиваться в результате ваших действий. брать.Итак, истинная модель такова: вот мое представление о состоянии мира в момент времени T, и вот действия, которые я могу предпринять. Каково прогнозируемое состояние мира в момент времени Т 1? Теперь состояние мира не обязательно должно отражать все о мире, оно просто должно представлять достаточно информации, необходимой для планирования этой операции, но не обязательно все детали.

Теперь вот и проблема. Генеративные модели не могут этого сделать. Итак, генеративные модели необходимо обучать на видео, и мы пытаемся сделать это уже 10 лет: вы снимаете видео, показываете системе видео, и вас просят предсказать напоминание о видео, по сути. прогнозирование того, что произойдет.

Если хотите, вы можете создавать большие видеомокапы. Идея сделать это существует уже давно, в FAIR я и некоторые из наших коллег пытались сделать это в течение 10 лет, но вы не можете проделать тот же трюк с LLM, потому что LLM, как я сказал, что вы не можете сделать это точно. Предсказать, какое слово будет следовать за последовательностью слов, но вы можете предсказать распределение слов. Теперь, если вы посмотрите видео, вам нужно будет предсказать распределение всех возможных кадров в видео, а мы не знаем, как это сделать правильно. ######

Мы не знаем, как правильно представить распределения в многомерных непрерывных пространствах. Это главная проблема, и мы можем это сделать, потому что мир гораздо сложнее и насыщен информацией, чем слова. Текст дискретен, а видео — многомерное и непрерывное. В этом есть много деталей. Поэтому, если я снимаю видео этой комнаты и камера вращается в видео, я просто не могу предсказать все, что будет в комнате, когда я перемещаюсь. Система также не может предсказать, что появится в комнате при повороте камеры. Может быть, он предсказывает, что это комната, в ней есть свет, есть стена и что-то в этом роде. Он не может предсказать, как будет выглядеть картина на стене или как будет выглядеть текстура дивана. Конечно, невозможно предсказать текстуру ковра. Поэтому я не могу предсказать все эти детали.

Итак, один из возможных способов справиться с этим, который мы изучали, — это построить модель с так называемыми скрытыми переменными. Скрытые переменные подаются в нейронную сеть, которая должна представлять всю информацию о мире, которую вы еще не ощутили.Вам необходимо повысить предсказательную силу системы, чтобы иметь возможность хорошо предсказывать пиксели, включая тонкости. ковров, диванов и картин на стене текстура.

Мы пробовали прямые нейронные сети, мы пробовали GAN, мы пробовали VAE, мы пробовали различные регуляризованные автокодировщики. Мы также пытаемся использовать эти методы для изучения хороших представлений изображений или видео, которые затем можно использовать в качестве входных данных для систем классификации изображений и так далее. В основном провалился.

Все системы, которые пытаются предсказать недостающие части из поврежденной версии изображения или видео, в основном делают это: берут изображение или видео, искажают его или преобразуют каким-либо образом, а затем попытайтесь восстановить полное видео или изображение из поврежденной версии, а затем, надеюсь, создайте хорошее представление изображения внутри системы, которое можно будет использовать для распознавания объектов, сегментации и т. д. По сути, этот подход является полным провалом, хотя он работает очень хорошо, когда дело касается текста. Это принцип, используемый для LLM.

Лекс Фридман: Откуда взялся провал? Трудно ли хорошо представить изображение, например, хорошо встроить в изображение всю важную информацию? Именно согласованность между изображением и изображением, изображением и изображением формирует видео? Как бы это выглядело, если бы мы собрали все ваши неудачи?

Ян ЛеКун: Во-первых, я должен сказать вам, что не работает, потому что есть и другие вещи, которые работают. Итак, что не работает, так это обучение системы изучению представлений изображений, обучение ее восстановлению хороших изображений из испорченных изображений.

У нас есть целый набор методов для этого, которые представляют собой варианты шумоподавления автоэнкодеров.Некоторые из моих коллег из FAIR разработали нечто под названием MAE, или Masked Autoencoder.Encoder. По сути, это похоже на LLM или что-то в этом роде, где вы обучаете систему, искажая текст, но вы искажаете изображение, удаляете из него исправления, а затем обучаете гигантскую нейронную сеть восстанавливать его. Функции, которые вы получаете, не очень хороши, и вы знаете, что они не очень хороши, потому что, если вы сейчас обучаете ту же архитектуру, но тренируете ее с маркировкой данных, текстовыми описаниями изображений и т. д., вы действительно получаете хорошие представления, производительность по задаче распознавания намного выше, чем если бы вы выполняли такое переобучение под самоконтролем.

Структура хороша, и структура кодировщика тоже хороша, но тот факт, что вы обучаете систему реконструировать изображения, не заставляет ее выдавать длинные и хорошие общие характеристики изображений . Так какова альтернатива? Другой подход — совместное встраивание.

JEPA (Joint Embedding Prediction Architecture)

#Lex Fridman:: В чем фундаментальная разница между Joint Embedding Prediction Architecture и LLM? Может ли JEPA привести нас в AGI?

Ян ЛеКун: Во-первых, чем она отличается от генеративных архитектур, таких как LLM? LLM или система машинного зрения, обученная посредством реконструкции, генерирует входные данные. Необработанные входные данные, которые они генерируют, не повреждены и не преобразованы, поэтому вам приходится прогнозировать все пиксели, а системе требуется много ресурсов, чтобы фактически спрогнозировать все пиксели и все детали. В JEPA вам не нужно прогнозировать все пиксели, вам нужно только предсказать абстрактное представление входных данных. Это намного проще во многих отношениях. Следовательно, при обучении система JEPA должна извлекать как можно больше информации из входных данных, но извлекать только ту информацию, которую относительно легко предсказать. Поэтому в мире есть много вещей, которые мы не можем предсказать. Например, если по улице или по дороге едет беспилотный автомобиль, вокруг дороги могут быть деревья, и день может быть ветреным. Таким образом, листья на дереве движутся полухаотичным, случайным образом, который вы не можете предсказать, и вас это не волнует, и вы не хотите предсказывать. Итак, вы хотите, чтобы кодер удалил все эти детали. Он сообщит вам, что листья шевелятся, но не скажет, что именно происходит. Поэтому, когда вы прогнозируете в пространстве представления, вам не нужно прогнозировать каждый пиксель каждого листа. Это не только намного проще, но и позволяет системе, по сути, изучить абстрактное представление мира, где то, что можно смоделировать и предсказать, сохраняется, а все остальное обрабатывается кодировщиком как шум и удаляется.

Таким образом, повышается уровень абстракции представления. Если подумать, мы определенно этим занимаемся. Всякий раз, когда мы описываем явление, мы делаем это на определенном уровне абстракции. Мы не всегда используем квантовую теорию поля для описания каждого природного явления. Это невозможно. Итак, у нас есть несколько уровней абстракции для описания того, что происходит в мире: от квантовой теории поля до теории атома, молекул, химии, материалов, вплоть до конкретных объектов в реальном мире и так далее. Поэтому мы не можем просто смоделировать все на самом низком уровне. И именно в этом заключается идея JEPA: изучение абстрактных представлений в режиме самоконтроля, а также их иерархическое изучение. Поэтому я думаю, что это важная часть умных систем. С точки зрения языка нам не нужно этого делать, потому что язык уже в определенной степени абстрактен и устранил много непредсказуемой информации. Следовательно, мы можем напрямую предсказывать слова, не делая совместных встраиваний и не повышая уровень абстракции.

Лекс Фридман: Вы говорите о языке, а нам лень его использовать, потому что нам бесплатно дали абстрактные представления, и теперь нам приходится увеличивать масштаб и действительно подумайте об интеллектуальных системах в целом. Нам приходится иметь дело с физической реальностью и реальностью, которая представляет собой беспорядок. И вам действительно нужно это сделать, перепрыгнув от полной, богатой, подробной реальности к абстрактному представлению реальности, основанному на том, о чем вы можете рассуждать, и тому подобному.

Ян ЛеКун: Верно. Алгоритмы с самоконтролем, которые обучаются путем прогнозирования, даже в пространстве представления, изучают больше концепций, если входные данные более избыточны. Чем более избыточны данные, тем лучше они отражают внутреннюю структуру данных. Следовательно, в сенсорной информации, такой как перцептуальная информация и зрение, гораздо больше избыточных структур, чем в тексте. Язык на самом деле может представлять больше информации, поскольку он сжат. Вы правы, но это также означает, что у него меньше избыточности, поэтому самоконтроль будет не таким хорошим.

Лекс Фридман: Можно ли совместить самостоятельное обучение на визуальных данных с самостоятельным обучением на языковых данных? Несмотря на то, что вы говорите о 10–13 токенах, для этого требуется масса знаний. Эти 10–13 токенов представляют собой все, что мы, люди, выяснили, включая чушь на Reddit, содержание всех книг и статей и все, что когда-либо создавал человеческий интеллект.

Ян ЛеКун: Ну, в конечном счете да. Но я думаю, что если мы сделаем это слишком рано, мы рискуем быть склонными к мошенничеству. И на самом деле, это именно то, что люди сейчас делают с визуальными языковыми моделями. По сути, мы обманываем, используя язык как опору, помогающую нашей неполноценной зрительной системе научиться правильному представлению изображений и видео.

Проблема в том, что мы можем улучшить языковые модели, снабжая их изображениями, но мы не достигнем даже того уровня интеллекта или понимания мира, который есть у кошки или собаки. имеет, потому что у них нет языка. У них нет языка, но они понимают мир гораздо лучше, чем любой LLM. Они могут планировать очень сложные действия и представлять последствия последовательности действий. Как нам заставить машины изучить это, прежде чем объединять это с языком? Очевидно, что если мы объединим это с языком, мы получим результаты, но до тех пор нам нужно сосредоточиться на том, как заставить систему изучить, как устроен мир.

На самом деле, технология, которую мы используем, неконтрастна. Следовательно, не только архитектура не является генеративной, но и используемые нами процедуры обучения также несравнимы. У нас есть два набора технологий. Один набор основан на методе дистилляции. Существует много методов, использующих этот принцип. У DeepMind есть один, который называется BYOL, есть несколько FAIR, один называется vcREG, а другой называется I-JEPA. Следует сказать, что vcREG не является методом перегонки, а вот I-JEPA и BYOL – безусловно. Есть еще один под названием DINO или DINO, который также производит компания FAIR. Идея этих методов заключается в том, что вы пропускаете весь ввод, скажем, изображение, через кодировщик, создавая представление, а затем уничтожаете или преобразуете входные данные, пропуская их через тот же кодировщик, но с некоторыми нюансами, а затем обучить предсказателя.

Иногда предиктор очень прост, иногда предиктор не существует, но предиктор обучен предсказывать взаимосвязь между первым неповрежденным вводом и поврежденным вводом. Но вы тренируете только вторую ветку. Вы обучаете только ту часть сети, которая принимает поврежденные входные данные. Другая сеть не требует обучения. Но поскольку они имеют одинаковые веса, когда вы изменяете первую сеть, это также изменяет вторую сеть. С помощью различных уловок вы можете предотвратить сбой системы, подобный тому, который я объяснял ранее, когда система фактически игнорирует вводимые данные. Поэтому этот метод очень эффективен. Две технологии, которые мы разработали на FAIR, DINO и I-JEPA, очень эффективны в этом отношении.

Наша последняя версия называется V-JEPA. По сути, это та же идея, что и I-JEPA, только применительно к видео. Таким образом, вы можете снять все видео, а затем заблокировать его часть. На самом деле мы маскируем временную трубку, то есть весь клип для каждого кадра всего видео.

Это первая у нас система, которая может изучать хорошие представления видео, поэтому, когда вы передаете эти представления в контролируемую головку классификатора, она может сообщать вам с довольно высокой степенью точности. какое действие происходит в видео. Так что это первый раз, когда мы получаем что-то такого качества.

Результаты показывают, что наша система может использовать представления, чтобы определить, является ли видео физически возможным или совершенно невозможным, потому что некоторые объекты исчезают или объект внезапно перепрыгивает из одного места в другое, или меняет форму или что-то в этом роде.

Лекс Фридман: Позволяет ли это нам построить модель мира, которая понимает его достаточно хорошо, чтобы уметь водить машину?

Янн ЛеКун: Это может занять некоторое время, чтобы добраться туда. Уже есть несколько роботизированных систем, основанных на этой идее. Что вам нужно, так это слегка измененная версия. Представьте, что у вас есть полное видео, и вы смещаете его во времени в будущее. Поэтому вы можете видеть только начало видео, но не вторую половину исходного видео, или блокируется только вторая половина видео. Затем вы можете обучить систему JEPA или систему, подобную той, которую я описал, для прогнозирования полного представления перекрытого видео. Однако вам также необходимо предоставить предиктору действие. Например, колесо поворачивается на 10 градусов вправо или что-то в этом роде, да?

Итак, если это автомобильная камера и вы знаете угол поворота рулевого колеса, то в некоторой степени вы сможете предсказать, как изменится то, что вы видите . Очевидно, что вы не можете предсказать все детали объектов, которые появляются в представлении, но на уровне абстрактного представления вы можете предсказать, что произойдет. Итак, теперь у вас есть внутренняя модель, которая говорит: «Это мое представление о состоянии мира в момент времени T, и вот действие, которое я предпринимаю. Вот T плюс 1, T плюс дельта T, T плюс 2 секунды «Предсказание состояния мира», что бы это ни было. Если у вас есть такая модель, вы можете использовать ее для планирования. Итак, теперь вы можете делать то, чего не может сделать LMS, а именно планировать то, что вы хотите сделать. Итак, когда вы достигаете определенного результата или достигаете определенной цели.

Так что у вас может быть много целей. Я могу предсказать, что если бы у меня был такой предмет и я разжал руку, он бы упал. Если я прижму его к столу с определенной силой, он сдвинется. Если я толкну стол с той же силой, он, скорее всего, не сдвинется. В результате в нашем сознании возникает внутренняя модель мира, позволяющая планировать последовательность действий для достижения конкретной цели. Теперь, если у вас есть эта модель мира, мы можем представить последовательность действий, предсказать результат этой последовательности действий, измерить, насколько хорошо конечное состояние удовлетворяет определенной цели, например, перемещение бутылки влево от стола. , а затем запустите Запланировать серию действий для минимизации этой цели.

Мы не говорим об обучении, мы говорим о времени на размышления, так что на самом деле это и есть планирование. В оптимальном управлении это очень классическая вещь. Это называется управлением с прогнозированием модели. У вас есть модель системы, которой вы хотите управлять, которая предсказывает последовательность состояний, соответствующую последовательности инструкций. И вы планируете последовательность инструкций, чтобы на основе вашей ролевой модели конечное состояние системы соответствовало поставленным вами целям. Таким образом траектории ракет планировались с момента появления компьютеров в начале 1960-х годов.

Обучение с подкреплением

#Лекс Фридман: Предложение отказаться от генеративных моделей в пользу совместных архитектур внедрения? Вы уже некоторое время критикуете обучение с подкреплением. Это похоже на свидетельство в суде: отказ от вероятностных моделей в пользу энергетических моделей, о которых мы говорили, отказ от контрастных методов в пользу методов регуляризации.

Yann LeCun: Я не думаю, что от него следует отказываться полностью, но я считаю, что его использование следует свести к минимуму, потому что это сэмплирование. эффективность очень низкая. Следовательно, правильный способ обучения системы — сначала дать ей возможность изучить хорошее представление мира и модель мира на основе первичных наблюдений (и, возможно, небольшого взаимодействия).

Лекс Фридман: Почему RLHF работает так хорошо? Ян ЛеКун об обучении с подкреплением.

Открытый исходный код

Ян ЛеКун

#: Владение индустрией искусственного интеллекта и отсутствие Уникальная предвзятость Единственный способ построить систему ИИ — это иметь платформу с открытым исходным кодом, на которой любая группа может построить специализированную систему. Неизбежное направление истории таково, что подавляющее большинство систем искусственного интеллекта будут построены на платформах с открытым исходным кодом.Meta вращается вокруг бизнес-модели, в которой вы предоставляете услугу, финансируемую либо рекламой, либо коммерческими клиентами.

Например, если у вас есть LLM, который может помочь пиццерии, разговаривая с клиентами через WhatsApp, клиенту нужно только заказать пиццу, и система спросит его: «Что какие ингредиенты вам нужны или какие размеры вы хотите и т. д.» Торговцы будут платить за это, и это модель.В противном случае, если это более классическая система обслуживания, она может поддерживаться рекламой или иметь несколько режимов. Но дело в том, что если у вас достаточно большая база потенциальных клиентов, и вам все равно нужно создать систему для них, нет никакого вреда в том, чтобы выпустить ее в открытый исходный код.

Лекс Фридман: Ставка Меты такова: добьемся ли мы большего?

Ян ЛеКун

: Нет. У нас уже есть огромная база пользователей и клиентская база.Не повредит то, что мы предоставляем системы с открытым исходным кодом или базовые модели и базовые модели, на которых другие могут создавать приложения. Если эти приложения будут полезны нашим клиентам, мы сможем приобрести их напрямую у них. Они могут улучшить платформу. Фактически, мы видели, как это произошло. LLaMA 2 была загружена миллионы раз, и тысячи людей высказали идеи, как улучшить платформу. Таким образом, это, очевидно, ускоряет процесс доступности системы для широкого круга пользователей, и тысячи предприятий создают приложения с использованием этой системы. Таким образом, на способность Meta получать доход от этой технологии не влияет распространение базовой модели с открытым исходным кодом.

Llama 3Lex Fridman: Что вам больше всего нравится в LLaMA 3?

Yann LeCun

: Будут различные версии LLaMA, которые являются усовершенствованиями предыдущей LLaMA, больше, лучше, мультимодальность, которая Такие вещи. А потом, в будущих поколениях, появятся системы планирования, способные на самом деле понимать, как устроен мир, возможно, обученные на видео, поэтому у них будет некая модель мира, которая сможет выполнять те рассуждения и планирование, которые я говорили ранее.#Как долго это займет? Когда исследования в этом направлении войдут в линейку продуктов? Я не знаю и не могу вам сказать. По сути, нам придется совершить некоторые прорывы, прежде чем мы доберемся до этой цели, но люди могут следить за нашим прогрессом, потому что мы публикуем наши исследования публично. Поэтому на прошлой неделе мы опубликовали проект V-JEPA — первый шаг на пути к системе видеообучения. Следующим шагом будет обучение модели мира на основе этого видео-творчества. У DeepMind есть аналогичная работа, а у Калифорнийского университета в Беркли — модели мира и видео. Многие люди работают над этим. Я думаю, что появится много хороших идей. Я держу пари, что эти системы будут облегченными системами JEPA, а не генеративными моделями, и посмотрим, что произойдет в будущем. Более 30 лет назад, когда мы работали над комбинаторными сетями и ранними нейронными сетями, я увидел путь к интеллекту человеческого уровня, системам, которые могли бы понимать мир, запоминать, планировать , причина. Есть некоторые идеи, которые могут продвинуться вперед и которые могут иметь шанс сработать, и я очень рад этому. Что мне нравится, так это то, что мы каким-то образом движемся в правильном направлении и, возможно, добиваемся успеха до того, как мой мозг превратится в белый соус или до того, как мне придется уйти на пенсию. Лекс Фридман: Больше всего вас волнует теоретический аспект, то есть программный аспект? Янн ЛеКун: Много лет назад я занимался аппаратным обеспечением. Масштаб необходим, но недостаточен. Возможно, я проживу еще десять лет, но мне все равно придется пробежать небольшую дистанцию. Конечно, чем дальше мы продвигаемся в плане энергоэффективности, тем большего прогресса мы достигаем в плане упорной работы. Нам необходимо снизить энергопотребление. Сегодня графический процессор потребляет от полукиловатт до киловатта. Человеческий мозг потребляет около 25 Вт энергии, тогда как графический процессор потребляет гораздо меньше, чем человеческий мозг. Чтобы соответствовать этому, вам понадобится 100 000 или 1 миллион энергии, так что мы довольно далеко друг от друга. Лекс Фридман: Вы часто говорите, что GI не появится в ближайшее время. Какая интуиция стоит за этим? Янн ЛеКун: Идея, популяризированная научной фантастикой и Голливудом, о том, что кто-то откроет AGI или искусственный интеллект человеческого уровня. Или секрет АМИ (как бы вы это ни называли), а затем включение машины и у нас есть AGI, этого не произойдет. Это будет постепенный процесс. Будут ли у нас системы, которые смогут понимать, как устроен мир, по видео и обучаться хорошим представлениям? Пройдет немало времени, прежде чем мы достигнем тех масштабов и производительности, которые мы наблюдаем у людей, а не день или два. Разрешаем ли мы системам иметь большой объем ассоциативной памяти для запоминания вещей? Да, но это произойдет и не завтра. Нам необходимо разработать некоторые базовые технологии. У нас есть много таких технологий, но заставить их работать с целостной системой – это совсем другая история. Будут ли у нас системы, способные рассуждать и планировать, возможно, как целенаправленные архитектуры искусственного интеллекта, которые я описал ранее? Да, но потребуется время, чтобы все заработало должным образом. Пройдет по меньшей мере десятилетие или даже больше, прежде чем мы заставим все эти вещи работать вместе, прежде чем мы получим системы, основанные на этом, которые обучаются иерархическому планированию, иерархическим представлениям, которые можно будет настроить так, как это делает человеческий мозг, для различных возникающих ситуаций. , Потому что есть много проблем, которых мы еще не видим, с которыми мы еще не сталкивались, поэтому мы не знаем, есть ли простые решения в рамках этой структуры. В течение последнего десятилетия или около того я слышал, как люди утверждают, что AGI уже не за горами, и все они ошибаются. IQ может что-то измерить в отношении людей, но потому, что люди относительно однородны по форме. Однако он измеряет только способность, которая может иметь отношение к одним задачам, но не к другим. Но если вы говорите о других разумных существах, для которых базовые вещи, которые легко сделать, совершенно другие, то это не имеет никакого смысла. Следовательно, интеллект – это совокупность навыков и способность эффективно приобретать новые навыки. Набор навыков, которыми конкретный разумный объект обладает или способен быстро освоить, отличается от набора навыков другого разумного объекта. Поскольку это многомерная вещь, набор навыков представляет собой многомерное пространство, которое вы не можете измерить, и вы не можете сравнить две вещи, чтобы увидеть, является ли одна умнее другой. Оно многомерно. Лекс Фридман: Вы часто выступаете против так называемых сторонников конца света в области искусственного интеллекта, объясняете их точку зрения и объясняете, почему вы считаете их неправыми. Yann LeCun: Сторонники Судного Дня ИИ представляют себе различные сценарии катастроф, как ИИ может сбежать или взять под свой контроль и, по сути, убить всех нас , это основано на множестве предположений, большинство из которых ошибочны. Первая гипотеза заключается в том, что появление сверхразума станет событием, и в какой-то момент мы откроем секреты и откроем сверхразумную машину, потому что мы никогда раньше этого не делали, поэтому она возьмет на себя управление мир и убить нас всех. Это не верно. Это не будет событием. У нас будут системы, умные, как кошки, они будут обладать всеми характеристиками человеческого интеллекта, но их уровень интеллекта может быть как у кошки, попугая или чего-то еще. Затем мы постепенно улучшаем их интеллект. Делая их умнее, нам также необходимо установить на них некоторые ограждения и научиться устанавливать ограждения, чтобы заставить их вести себя более нормально. В природе кажется, что более умные виды в конечном итоге будут доминировать над другими видами, иногда даже намеренно, а иногда просто по ошибке, чтобы дифференцировать другие виды. Итак, вы думаете: «Ну, если системы ИИ умнее нас, они определенно уничтожат нас, если не намеренно, то просто потому, что они этого не делают». заботиться о нас», что абсурдно. Первая причина в том, что они не станут видом, конкурирующим с нами, и не будут иметь желания доминировать, потому что желание доминировать должно быть чем-то присущим разумным системам. Он глубоко укоренился в организме человека и свойственен павианам, шимпанзе и волкам, но не орангутангам. Это желание доминировать, подчиняться или иным образом получать статус уникально для социальных видов. Несоциальные виды, такие как орангутанги, не имеют такого желания и столь же умны, как и мы. Лекс Фридман: Как вы думаете, скоро вокруг будут ходить миллионы человекоподобных роботов? Ян ЛеКун: Это будет не скоро, но это произойдет. Я думаю, что следующие десять лет индустрия робототехники будет очень интересной, рост индустрии робототехники длился 10, 20 лет, и на самом деле она еще не появилась. . Главным вопросом остается парадокс Моравеца: как нам заставить эти системы понимать, как устроен мир, и планировать действия? Таким образом, мы можем решать по-настоящему профессиональные задачи. То, что сделала компания Boston Dynamics, в основном заключалось в создании большого количества динамических моделей, созданных вручную, и тщательном предварительном планировании, что представляет собой классическую робототехнику с большим количеством инноваций и небольшим количеством восприятия, но этого все равно было недостаточно, и они не могли создать домашний робот. Кроме того, мы все еще далеки от полностью автономного вождения L5, например системы, которая может тренироваться, как 17-летний подросток, за 20 часов вождения. Таким образом, мы не добьемся значительного прогресса в робототехнике, пока у нас не будет модели мира, системы, которая может обучаться, чтобы понимать, как устроен мир. AGI

гуманоидные роботы

The above is the detailed content of LeCun's latest interview: Why will the physical world eventually become the 'Achilles heel” of LLM?. For more information, please follow other related articles on the PHP Chinese website!

YOLOv6又快又准的目标检测框架已经开源了May 09, 2023 pm 02:52 PM

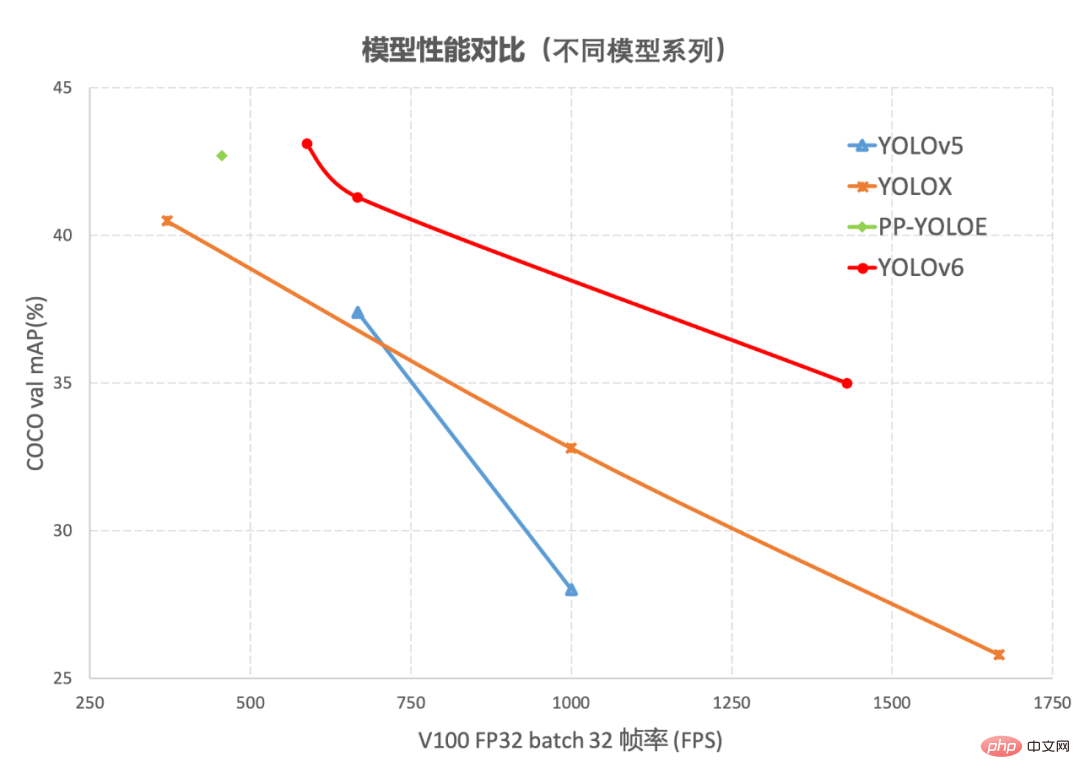

YOLOv6又快又准的目标检测框架已经开源了May 09, 2023 pm 02:52 PM作者:楚怡、凯衡等近日,美团视觉智能部研发了一款致力于工业应用的目标检测框架YOLOv6,能够同时专注于检测的精度和推理效率。在研发过程中,视觉智能部不断进行了探索和优化,同时吸取借鉴了学术界和工业界的一些前沿进展和科研成果。在目标检测权威数据集COCO上的实验结果显示,YOLOv6在检测精度和速度方面均超越其他同体量的算法,同时支持多种不同平台的部署,极大简化工程部署时的适配工作。特此开源,希望能帮助到更多的同学。1.概述YOLOv6是美团视觉智能部研发的一款目标检测框架,致力于工业应用。

MLC LLM:开源AI聊天机器人,支持离线运行,适用于集成显卡电脑和iPhone。May 06, 2023 pm 03:46 PM

MLC LLM:开源AI聊天机器人,支持离线运行,适用于集成显卡电脑和iPhone。May 06, 2023 pm 03:46 PM5月2日消息,目前大多数AI聊天机器人都需要连接到云端进行处理,即使可以本地运行的也配置要求极高。那么是否有轻量化的、无需联网的聊天机器人呢?一个名为MLCLLM的全新开源项目已在GitHub上线,完全本地运行无需联网,甚至集显老电脑、苹果iPhone手机都能运行。MLCLLM项目介绍称:“MLCLLM是一种通用解决方案,它允许将任何语言模型本地部署在一组不同的硬件后端和本地应用程序上,此外还有一个高效的框架,供每个人进一步优化自己用例的模型性能。一切都在本地运行,无需服务器支持,并通过手机和笔

基于开源的 ChatGPT Web UI 项目,快速构建属于自己的 ChatGPT 站点Apr 15, 2023 pm 07:43 PM

基于开源的 ChatGPT Web UI 项目,快速构建属于自己的 ChatGPT 站点Apr 15, 2023 pm 07:43 PM作为一个技术博主,了不起比较喜欢各种折腾,之前给大家介绍过ChatGPT接入微信,钉钉和知识星球(如果没看过的可以翻翻前面的文章),最近再看开源项目的时候,发现了一个ChatGPTWebUI项目。想着刚好之前没有将ChatGPT接入过WebUI,有了这个开源项目可以拿来使用,真是不错,下面是实操的安装步骤,分享给大家。安装官方在Github的项目文档上提供了很多中的安装方式,包括手动安装,docker部署,以及远程部署等方法,了不起在选择部署方式的时候,一开始为了简单想着

仅需1% Embedding参数,硬件成本降低十倍,开源方案单GPU训练超大推荐模型Apr 12, 2023 pm 03:46 PM

仅需1% Embedding参数,硬件成本降低十倍,开源方案单GPU训练超大推荐模型Apr 12, 2023 pm 03:46 PM深度推荐模型(DLRMs)已经成为深度学习在互联网公司应用的最重要技术场景,如视频推荐、购物搜索、广告推送等流量变现业务,极大改善了用户体验和业务商业价值。但海量的用户和业务数据,频繁地迭代更新需求,以及高昂的训练成本,都对 DLRM 训练提出了严峻挑战。在 DLRM 中,需要先在嵌入表(EmbeddingBags)中进行查表(lookup),再完成下游计算。嵌入表常常贡献 DLRM 中 99% 以上的内存需求,却只贡献 1% 的计算量。借助于 GPU 片上高速内存(High Bandwidth

Stable Diffusion-XL开启公测,让你摆脱繁琐的长prompt!Apr 23, 2023 am 10:16 AM

Stable Diffusion-XL开启公测,让你摆脱繁琐的长prompt!Apr 23, 2023 am 10:16 AM自从Midjourney发布v5之后,在生成图像的人物真实程度、手指细节等方面都有了显著改善,并且在prompt理解的准确性、审美多样性和语言理解方面也都取得了进步。相比之下,StableDiffusion虽然免费、开源,但每次都要写一大长串的prompt,想生成高质量的图像全靠多次抽卡。最近StabilityAI的官宣,正在研发的StableDiffusionXL开始面向公众测试,目前可以在Clipdrop平台免费试用。试用链接:https://clipdrop.co/stable-diff

用图像对齐所有模态,Meta开源多感官AI基础模型,实现大一统May 11, 2023 pm 07:25 PM

用图像对齐所有模态,Meta开源多感官AI基础模型,实现大一统May 11, 2023 pm 07:25 PM在人类的感官中,一张图片可以将很多体验融合到一起,比如一张海滩图片可以让我们想起海浪的声音、沙子的质地、拂面而来的微风,甚至可以激发创作一首诗的灵感。图像的这种「绑定」(binding)属性通过与自身相关的任何感官体验对齐,为学习视觉特征提供了大量监督来源。理想情况下,对于单个联合嵌入空间,视觉特征应该通过对齐所有感官来学习。然而这需要通过同一组图像来获取所有感官类型和组合的配对数据,显然不可行。最近,很多方法学习与文本、音频等对齐的图像特征。这些方法使用单对模态或者最多几种视觉模态。最终嵌入仅

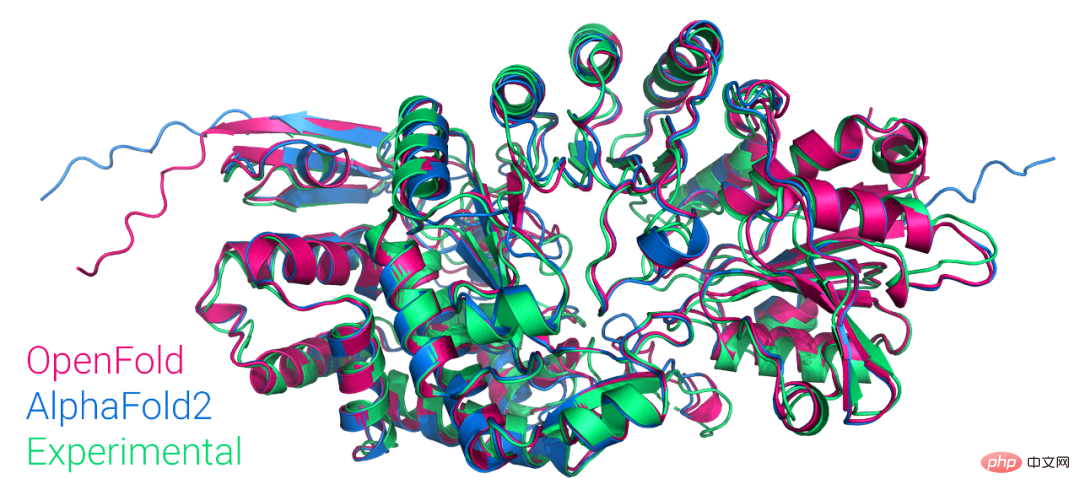

首个大众可用PyTorch版AlphaFold2复现,哥大开源,star量破千Apr 13, 2023 am 09:58 AM

首个大众可用PyTorch版AlphaFold2复现,哥大开源,star量破千Apr 13, 2023 am 09:58 AM刚刚,哥伦比亚大学系统生物学助理教授 Mohammed AlQuraishi 在推特上宣布,他们从头训练了一个名为 OpenFold 的模型,该模型是 AlphaFold2 的可训练 PyTorch 复现版本。Mohammed AlQuraishi 还表示,这是第一个大众可用的 AlphaFold2 复现。AlphaFold2 可以周期性地以原子精度预测蛋白质结构,在技术上利用多序列对齐和深度学习算法设计,并结合关于蛋白质结构的物理和生物学知识提升了预测效果。它实现了 2/3 蛋白质结构预测的卓

基于PyTorch、易上手,细粒度图像识别深度学习工具库Hawkeye开源Apr 12, 2023 pm 08:43 PM

基于PyTorch、易上手,细粒度图像识别深度学习工具库Hawkeye开源Apr 12, 2023 pm 08:43 PM细粒度图像识别 [1] 是视觉感知学习的重要研究课题,在智能新经济和工业互联网等方面具有巨大应用价值,且在诸多现实场景已有广泛应用…… 鉴于当前领域内尚缺乏该方面的深度学习开源工具库,南京理工大学魏秀参教授团队用时近一年时间,开发、打磨、完成了 Hawkeye——细粒度图像识别深度学习开源工具库,供相关领域研究人员和工程师参考使用。本文是对 Hawkeye 的详细介绍。1.什么是 Hawkeye 库Hawkeye 是一个基于 PyTorch 的细粒度图像识别深度学习工具库,专为相关领域研究人员和

Hot AI Tools

Undresser.AI Undress

AI-powered app for creating realistic nude photos

AI Clothes Remover

Online AI tool for removing clothes from photos.

Undress AI Tool

Undress images for free

Clothoff.io

AI clothes remover

AI Hentai Generator

Generate AI Hentai for free.

Hot Article

Hot Tools

MantisBT

Mantis is an easy-to-deploy web-based defect tracking tool designed to aid in product defect tracking. It requires PHP, MySQL and a web server. Check out our demo and hosting services.

MinGW - Minimalist GNU for Windows

This project is in the process of being migrated to osdn.net/projects/mingw, you can continue to follow us there. MinGW: A native Windows port of the GNU Compiler Collection (GCC), freely distributable import libraries and header files for building native Windows applications; includes extensions to the MSVC runtime to support C99 functionality. All MinGW software can run on 64-bit Windows platforms.

SublimeText3 Mac version

God-level code editing software (SublimeText3)

SublimeText3 English version

Recommended: Win version, supports code prompts!

Zend Studio 13.0.1

Powerful PHP integrated development environment