Heim >Technologie-Peripheriegeräte >IT Industrie >Alibaba Cloud kündigte die Einführung seines selbst entwickelten EMO-Modells auf der Tongyi-App an, das Fotos + Audio verwendet, um Gesangsvideos zu erstellen

Alibaba Cloud kündigte die Einführung seines selbst entwickelten EMO-Modells auf der Tongyi-App an, das Fotos + Audio verwendet, um Gesangsvideos zu erstellen

- 王林nach vorne

- 2024-04-26 08:00:381126Durchsuche

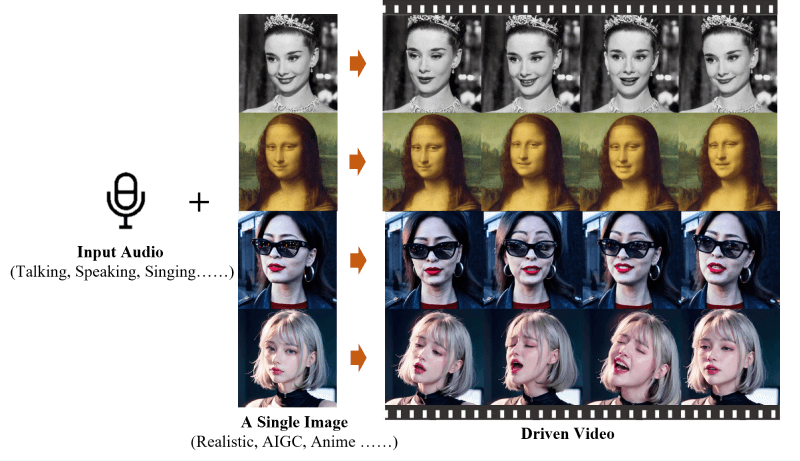

„Neuigkeiten von dieser Website am 25. April: EMO (Emote Portrait Alive) ist ein vom Alibaba Group Intelligent Computing Research Institute entwickeltes Framework, ein audiogesteuertes KI-Porträtvideo-Generierungssystem, das ein einzelnes Referenzbild eingeben und Sprachaudio generieren kann Videos mit ausdrucksstarken Gesichtsausdrücken und verschiedenen Kopfhaltungen.“

Alibaba Cloud gab heute bekannt, dass EMO, ein im Labor entwickeltes KI-Modell, offiziell in der allgemeinen App eingeführt wird und allen Benutzern kostenlos zur Verfügung steht. Mit dieser Funktion können Benutzer eine Vorlage aus Liedern, heißen Memes und Emoticons auswählen und dann ein Porträtfoto hochladen, damit EMO ein Gesangsvideo synthetisieren kann.

Laut Einführung hat die Tongyi App im ersten Stapel mehr als 80 EMO-Vorlagen veröffentlicht, darunter die beliebten Songs „Shangchunshan“, „Wild Wolf Disco“ usw. sowie die angesagten Internet-Memes „Bobo Chicken“ und „Backhand“, „Draw“ usw., aber benutzerdefiniertes Audio ist derzeit nicht verfügbar.

Diese Seite ist an die offizielle EMO-Website angehängt:

Offizielle Projekt-Homepage: https://humanaigc.github.io/emote-portrait-alive/

arXiv-Forschungspapier: https:/ /arxiv.org/abs/2402.17485

GitHub:https://github.com/HumanAIGC/EMO(Modell und Quellcode müssen Open Source sein)

Hauptfunktionen von EMO

Videos mit EMO-Audio generieren: EMO ist in der Lage, Videos direkt aus Eingangsaudio, wie Dialogen oder Liedern, zu generieren, ohne auf zuvor aufgezeichnete Videoclips oder 3D-Gesichtsmodelle angewiesen zu sein.

Sehr ausdrucksstark und realistisch: EMO-generierte Videos sind äußerst ausdrucksstark und in der Lage, die Nuancen menschlicher Gesichtsausdrücke, einschließlich subtiler Mikroausdrücke, und Kopfbewegungen, die zum Rhythmus des Audios passen, einzufangen und wiederzugeben.

Nahtloser Bildübergang: EMO stellt sicher, dass der Übergang zwischen Videobildern natürlich und reibungslos ist, vermeidet Probleme mit Gesichtsverzerrungen oder Jitter zwischen Bildern und verbessert so die Gesamtqualität des Videos.

Identitätserhaltung: Durch das FrameEncoding-Modul ist EMO in der Lage, die Konsistenz der Identität des Charakters während des Videogenerierungsprozesses aufrechtzuerhalten und sicherzustellen, dass das Erscheinungsbild des Charakters mit dem eingegebenen Referenzbild übereinstimmt.

Stabiler Kontrollmechanismus: EMO verwendet stabile Kontrollmechanismen wie Geschwindigkeitsregler und Gesichtsbereichsregler, um die Stabilität während der Videoerzeugung zu verbessern und Probleme wie Videoabstürze zu vermeiden.

Flexible Videodauer: EMO kann Videos beliebiger Länge basierend auf der Länge des Eingangsaudios generieren und bietet Benutzern so flexiblen kreativen Raum.

Sprach- und stilübergreifend: Der Trainingsdatensatz von EMO deckt eine Vielzahl von Sprachen und Stilen ab, darunter Chinesisch und Englisch, sowie Realismus-, Anime- und 3D-Stile, wodurch EMO sich an verschiedene Kulturen anpassen kann Kunststile.

Das obige ist der detaillierte Inhalt vonAlibaba Cloud kündigte die Einführung seines selbst entwickelten EMO-Modells auf der Tongyi-App an, das Fotos + Audio verwendet, um Gesangsvideos zu erstellen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- So überprüfen Sie die Remote-Warehouse-Adresse in Git

- So konvertieren Sie Zweige in Git

- [Zusammenstellung und Weitergabe] Alibabas 15 Top-Front-End-Open-Source-Projekte, sehen Sie, welche Sie verwendet haben!

- Das Alibaba Beijing Headquarters Park-Projekt schreitet reibungslos voran: Es wird voraussichtlich im Oktober fertiggestellt und bis Ende Dezember geliefert