Heim >Technologie-Peripheriegeräte >KI >Lama3 kommt plötzlich! In der Open-Source-Community brodelt es wieder: Die Ära des freien Zugangs zu Modellen auf GPT4-Ebene ist angebrochen

Lama3 kommt plötzlich! In der Open-Source-Community brodelt es wieder: Die Ära des freien Zugangs zu Modellen auf GPT4-Ebene ist angebrochen

- PHPznach vorne

- 2024-04-19 12:43:011253Durchsuche

Lama 3 ist da!

Gerade wurde die offizielle Website von Meta aktualisiert und die Parameterversionen von Lama 3, 8 Milliarden und 70 Milliarden, offiziell angekündigt.

Und der Start ist Open-Source-SOTA:

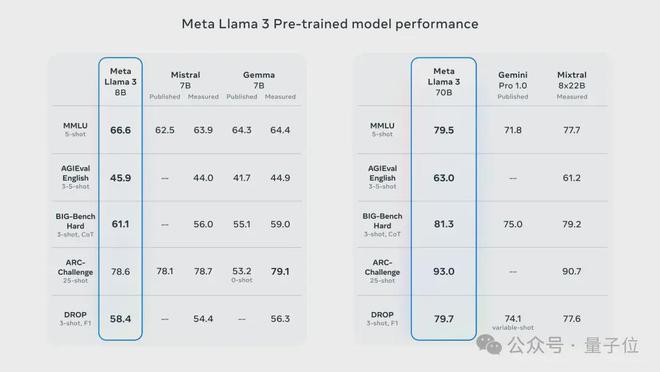

Offizielle Daten von Meta zeigen, dass die Versionen 8B und 70B von Llama 3 alle Konkurrenten in ihren jeweiligen Parameterskalen übertreffen.

8B-Modell übertrifft Gemma 7B und Mistral 7B Instruct bei vielen Benchmarks wie MMLU, GPQA, HumanEval usw.

Das 70B-Modell hat das beliebte Closed-Source-Modell Claude 3 Sonnet übertroffen und ist mit Googles Gemini Pro 1.5 hin und her gegangen.

Sobald der Huggingface-Link herauskam, war die Open-Source-Community wieder aufgeregt.

Die scharfäugigen, blinden Schüler entdeckten auch sofort den Schönheitspunkt:

Meta versteckte sogar eine Version von Llama 3 mit mehr als 400 Milliarden Parametern, die nicht schlechter ist als das supergroße Opus Claude 3!

Der CEO von HyperWriteAI, einem Startup für KI-Schreibassistenten, musste seufzen, als er das sah:

Wir betreten eine neue Welt, eine Welt, in der Modelle auf GPT-4-Ebene Open Source und kostenlos sind zugänglich.

NVIDIA-Wissenschaftler Jim Fan glaubt, dass Llama 3 400B, das sich noch in der Ausbildung befindet, ein Wendepunkt für große Open-Source-Modelle werden und die Art und Weise verändern wird, wie sich viele akademische Forschungs- und Start-up-Unternehmen entwickeln.

Vollständiges SOTA, aber 8k-Fenster

Weitere technische Details gibt Meta im Blogbeitrag.

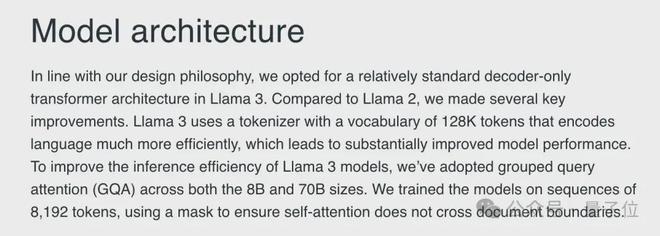

Auf der Architekturebene wählte Llama 3 die klassische Transformer-Architektur nur für Decoder und verwendete einen Wortsegmentierer mit einem 128K-Token-Vokabular.

Ein Blick auf die Trainingsdaten zeigt, dass die Trainingsdatenskala von Llama 3 15T-Token erreicht hat, die alle aus öffentlichen Informationen stammen, von denen 5 % nicht-englische Daten sind und mehr als 30 Sprachen abdecken.

Llama 3 hat 7-mal mehr Trainingsdaten als Llama 2 und enthält 4-mal mehr Code als Llama 2.

Um die Argumentationseffizienz des Llama 3-Modells zu verbessern, übernimmt Meta AI außerdem den Group Query Attention (GQA)-Mechanismus, um das Modell anhand einer Sequenz von 8192 Token zu trainieren, und verwendet eine Maske, um sicherzustellen, dass Selbst- Aufmerksamkeit überschreitet keine Dokumentgrenzen.

Unabhängig davon, ob es sich um die 8B- oder 70B-Version handelt, hat Llama 3 im Vergleich zur Vorgängergeneration Llama 2 ähnlicher Größe einen großen Sprung nach vorne gemacht.

Unter den bisherigen Modellen mit 8B- und 70B-Parameterskala ist Llama 3 das neue SOTA-Modell.

In Bezug auf Sprache (MMLU), Wissen (GPQA), Programmierung (HumanEval), Mathematik (GSM-8K, MATH) und andere Fähigkeiten ist Llama 3 anderen Modellen der gleichen Größenordnung fast vollständig voraus.

Zusätzlich zu diesen regulären Datensätzen hat Meta AI auch die Leistung von Llama 3 in realen Szenarien bewertet und zu diesem Zweck einen Satz hochwertiger Testdatensätze entwickelt.

Dieser Testsatz enthält 1.800 Daten, die 12 wichtige Anwendungsfälle wie Codierung, Argumentation, Schreiben und Zusammenfassung abdecken, und ist für das Entwicklungsteam vertraulich.

Dadurch hat Llama 3 nicht nur Llama 2 deutlich übertroffen, sondern auch bekannte Modelle wie Claude 3 Sonnet, Mistral Medium und GPT-3.5 besiegt.

Bei höherwertigen und schwierigeren Datensätzen wie AGIEval, BIG-Bench und ARC-Challenge ist die Leistung von Llama 3 ebenfalls bemerkenswert.

Die 8B-Version übertraf Mistral und Gemma bei diesen Aufgaben, während die 70B-Version Gemini Pro und Mixtral mit MoE-Architektur besiegte und jeweils SOTAs entsprechender Größe gewann.

Der einzige Nachteil ist jedoch, dass das Kontextfenster von Llama 3 im Vergleich zu den aktuellen großen Modellen mit Dutzenden oder Millionen Fenstern immer noch in der vorherigen Generation steckt (manueller Hundekopf). .

Aber machen Sie sich darüber keine allzu großen Sorgen. Matt Shumer ist optimistisch, dass die Fensterlänge durch die Bemühungen der Open-Source-Community bald erweitert wird.

Llama begrüßt die offizielle Webversion

Derzeit stehen die Basis- und Instruct-Versionen der beiden Parameter von Llama 3 auf Hugging Face zum Download bereit.

Darüber hinaus werden auch Cloud-Service-Plattformen wie Microsoft Azure, Google Cloud, Amazon AWS und NVIDIA NIM Llama 3 nacheinander starten.

Gleichzeitig sagte Meta auch, dass Llama 3 von Hardwareplattformen unterstützt wird, die von Intel, NVIDIA, AMD, Qualcomm und anderen Herstellern bereitgestellt werden.

Erwähnenswert ist, dass es dieses Mal zusammen mit dem Basismodell auch eine offizielle Webversion basierend auf Llama 3 namens Meta AI gibt.

Derzeit verfügt die Plattform über zwei Hauptfunktionen: Dialog und Malen. Wenn Sie nur den Dialog nutzen, müssen Sie sich nicht registrieren und können die Malfunktion sofort nutzen Sie müssen sich zunächst bei Ihrem Konto anmelden.

Allerdings unterstützt die Plattform derzeit kein Chinesisch und Funktionen wie das Hochladen von Texten wurden noch nicht gestartet.

In Bezug auf den Code kann die Plattform auch einige einfache Python-Programme ausführen, aber es scheint, dass sie nur Text ausgeben kann und Aufgaben mit Zeichnungen nicht ausgeführt werden können.

Im Allgemeinen ist diese Webversion noch relativ rudimentär, aber Sie können sich genauso gut auf eine Welle nachfolgender Updates freuen.

Noch eine Sache

Ein kleiner Vorfall ist, dass der Azure-Markt von Microsoft bereits wenige Stunden vor Metas offizieller Ankündigung die Nachricht von der Llama 3 8B Instruct-Version gestohlen hatte.

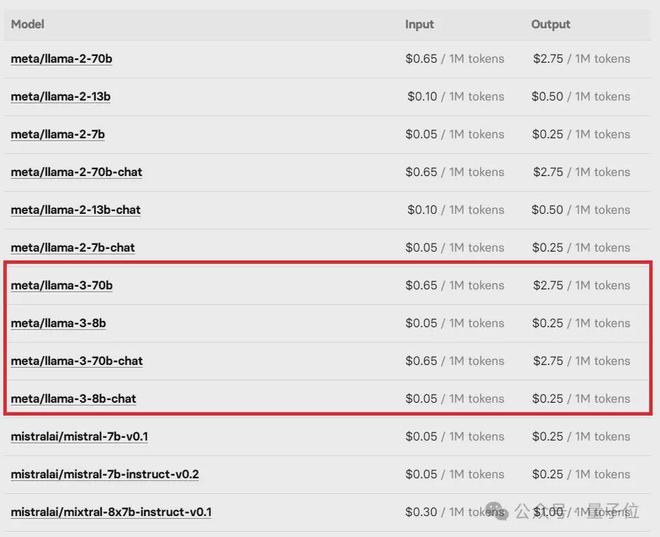

Die Llama 3-Preisliste auf der Open-Source-Online-Plattform für maschinelles Lernen Replicate wurde ebenfalls sofort von Internetnutzern herausgezogen.

Aber bald waren diese „Tattletales“ alle 404’d.

Glücklicherweise ist der Fehler vorbei und die Beamten zögern nicht. Freunde, die sich für große Open-Source-Modelle interessieren, können anfangen zu dogen.

参考链接:

[1]https://ai.meta.com/blog/meta-llama-3/。

[2]https://about.fb.com/news/2024 /04/meta-ai-assistant-built-with-llama-3/。

[3]https://huggingface.co/meta-llama/Meta-Llama-3-70B。

Das obige ist der detaillierte Inhalt vonLama3 kommt plötzlich! In der Open-Source-Community brodelt es wieder: Die Ära des freien Zugangs zu Modellen auf GPT4-Ebene ist angebrochen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!