Von der Speicherung der Vergangenheit bis zur Berechnung der Zukunft: AO-Hyperparallelrechner

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2024-04-04 08:13:011358Durchsuche

Autor: YBB Capital Researcher Zeke

Vorwort

Die beiden Mainstream-Blockchain-Architekturdesigns, die Web3 jetzt differenziert hat, haben unweigerlich zu einer gewissen ästhetischen Ermüdung geführt, sei es die überwältigende modulare Öffentlichkeit. Die Kette ist immer noch eine Neuer Typ von L1, der immer die Leistung in den Vordergrund stellt, aber keine Leistungsvorteile widerspiegelt. Man kann sagen, dass seine Ökologie eine Nachbildung oder leichte Verbesserung der Ethereum-Ökologie ist. Die sehr homogene Erfahrung hat dazu geführt, dass Benutzer seit langem ihren Sinn für Frische verloren haben. Das neueste von Arweave vorgeschlagene AO-Protokoll ist ein Hingucker, da es ultrahochleistungsfähiges Computing in der öffentlichen Speicherkette und sogar ein Quasi-Web2-Erlebnis ermöglicht. Dies scheint sich stark von den Erweiterungsmethoden und dem Architekturdesign zu unterscheiden, mit denen wir derzeit vertraut sind. Was genau ist AO? Woher kommt die Logik zur Unterstützung seiner Leistung?

Wie man AO versteht

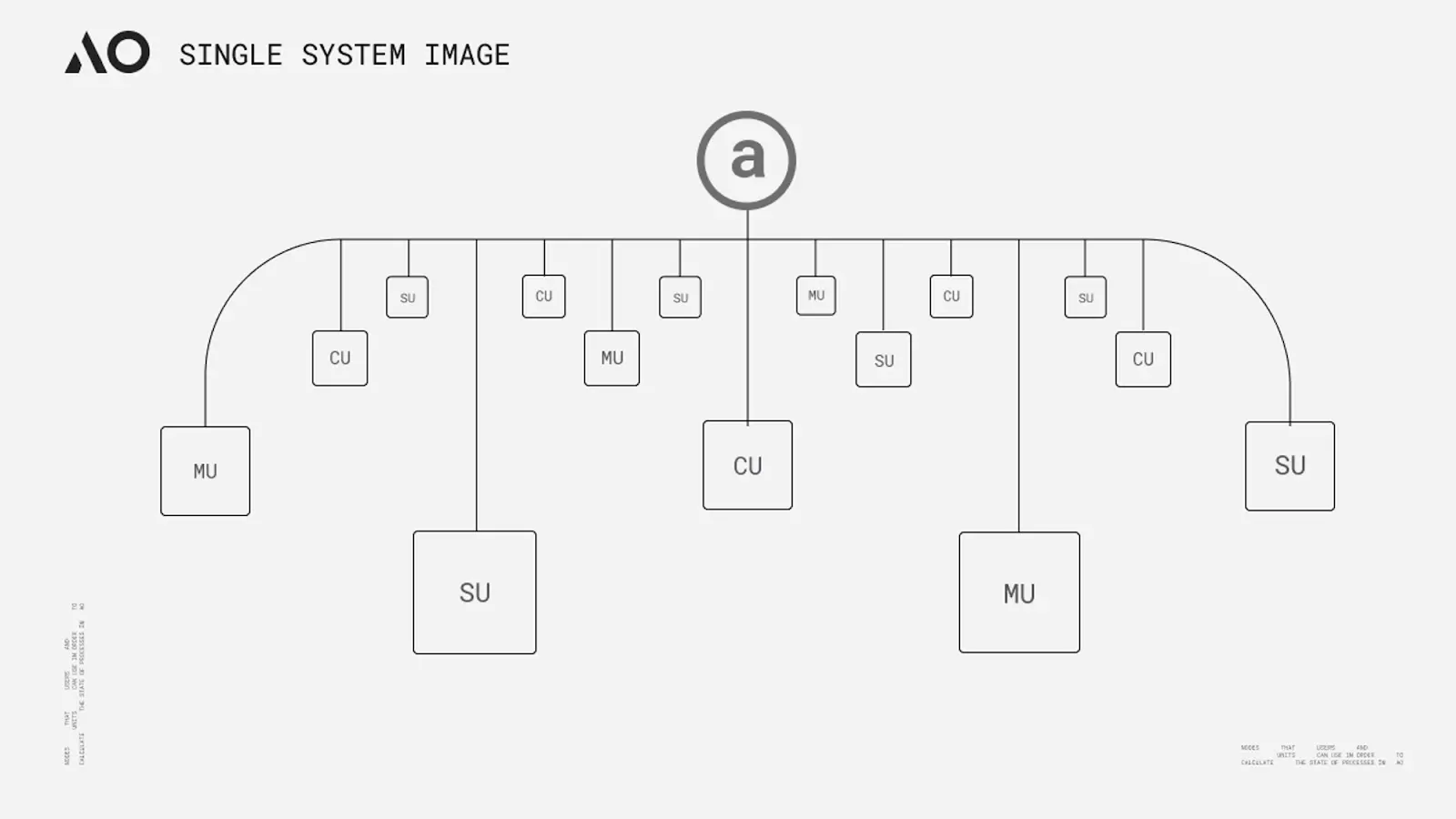

Der Name AO stammt von der Abkürzung für Actor Oriented, einem Programmierparadigma im Concurrent-Computing-Modell Actor Model. Seine allgemeine Designidee stammt aus der Erweiterung von Smart Weave und folgt auch Das Akteurmodell ist das Kernkonzept. Einfach ausgedrückt können wir AO durch Nachrichtenübermittlung und Datenverarbeitung als „Supercomputer“ verstehen. Aus Sicht der Implementierung ist AO eigentlich nicht unsere gemeinsame modulare Ausführungsschicht, sondern ein Kommunikationsprotokoll, das die Nachrichtenübermittlung und Datenverarbeitung standardisiert. Das Kernziel des Protokolls besteht darin, durch Informationsübertragung die Zusammenarbeit zwischen verschiedenen „Akteuren“ innerhalb des Netzwerks zu ermöglichen. Dies ermöglicht ein kollaboratives Netzwerk mit unendlich verbesserter Leistung, zentralisierter Geschwindigkeit auf Cloud-Ebene, skalierbarer Rechenleistung und Skalierbarkeit. Das Protokoll verfügt über die Geschwindigkeit, skalierbare Rechenleistung und Skalierbarkeit verschiedener zentralisierter Cloud-Ebenen in einer Kommunikationsumgebung. Schließlich wird eine riesige Festplatte realisiert, die zentralisierte Geschwindigkeit auf Cloud-Ebene, skalierbare Rechenleistung und Skalierbarkeit in einer dezentralen Cloud-Umgebung bieten kann.

AOs Architektur

AOs Konzept scheint der von Gavin Wood auf der letztjährigen Polkadot Decoded-Konferenz vorgeschlagenen „Core Time“-Segmentierung und -Rekombination zu ähneln. Beide basieren auf Berechnungen, Planung und Koordination von Ressourcen um den sogenannten „Hochleistungs-Weltcomputer“ zu erreichen. Es gibt jedoch einige wesentliche Unterschiede zwischen den beiden. Die Dekonstruktion und Neuorganisation der Relay-Chain-Ressourcen hat die Obergrenze der Rechenleistung natürlich nicht überschritten Eine Parachain ist immer noch durch die maximale Anzahl an Kernen von Polkadot begrenzt. Theoretisch kann AO die Sortierung, Planung und Berechnung von Informationen über drei Netzwerkeinheiten (Subnetzwerke) durch Knotendatenverarbeitungsmethoden und Nachrichtenausdrücke vervollständigen. Seine Standardisierungsmethode und die Funktionen verschiedener Einheiten hängen von der offiziellen Ressourcenanalyse ab, die zusammengefasst werden kann folgende Punkte:

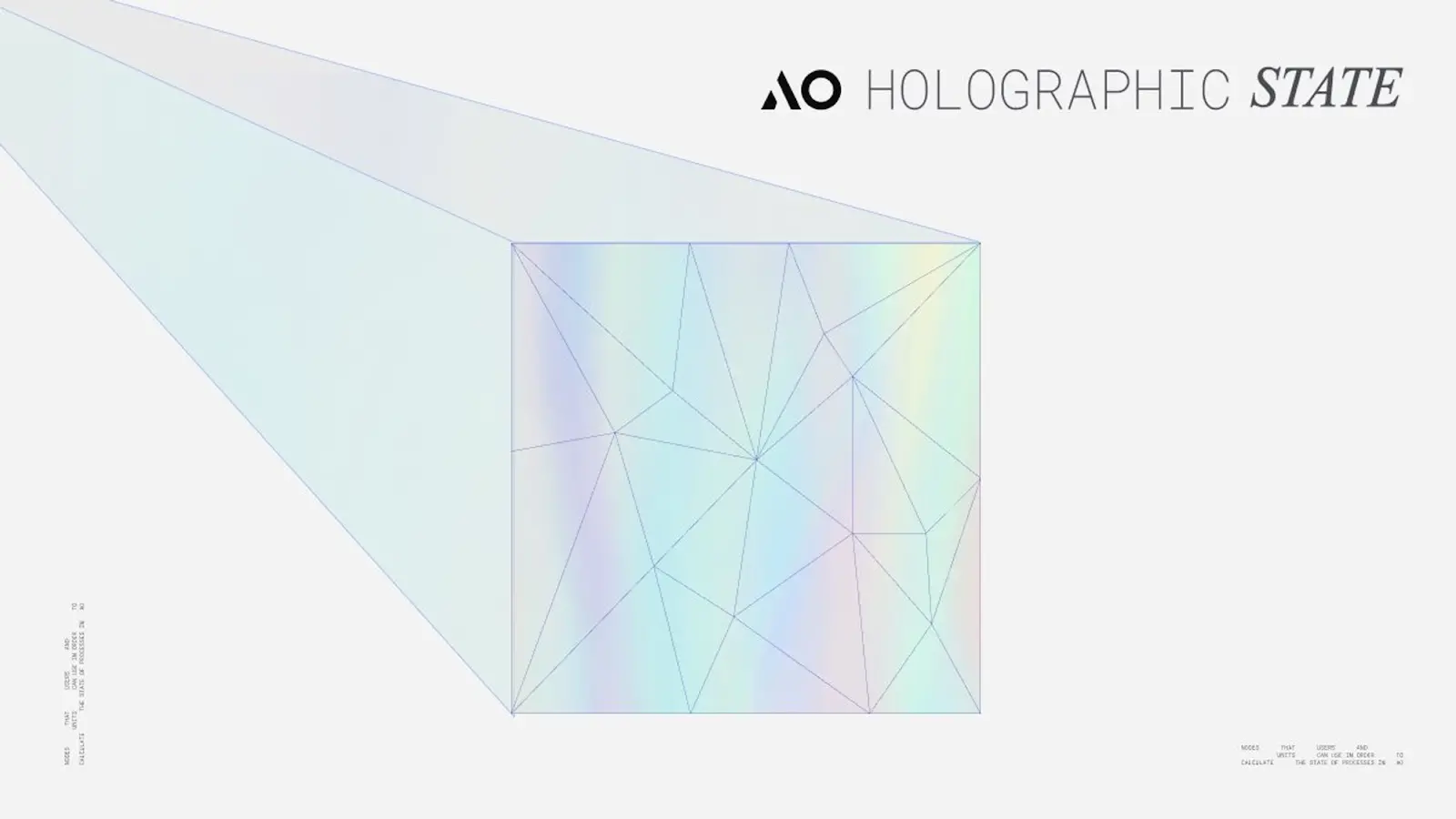

Prozess: Ein Prozess kann als eine Sammlung von Ausführungsanweisungen in AO betrachtet werden. Wenn ein Prozess initialisiert wird, kann er die erforderliche Computerumgebung definieren, einschließlich virtueller Maschinen, Scheduler, Speicheranforderungen und notwendiger Erweiterungen. Diese Prozesse behalten einen „holografischen“ Zustand bei (jede Prozessdaten können unabhängig im Nachrichtenprotokoll von Arweave gespeichert werden. Der holografische Zustand wird im Abschnitt „Überprüfbare Probleme“ unten ausführlich erläutert. Der holografische Zustand bedeutet, dass der Prozess unabhängig funktionieren kann. und die Ausführung ist dynamisch und kann von entsprechenden Recheneinheiten durchgeführt werden. Prozesse können nicht nur Nachrichten von Benutzer-Wallets empfangen, sondern auch Nachrichten von anderen Prozessen über die Messenger-Einheit weiterleiten Die durch eine Nachricht dargestellte Nachricht muss den nativen ANS-104-Datenelementen von Arweave entsprechen, um eine konsistente native Struktur aufrechtzuerhalten und die Speicherung von Informationen durch Arweave zu erleichtern. Aus einer verständlicheren Perspektive ähnelt die Nachricht etwas der Transaktions-ID (TX-ID) in der traditionellen Blockchain, aber die beiden sind nicht genau gleich

Messenger Unit (MU): MU ist für die Übermittlung der Kommunikation im System verantwortlich, indem es Nachrichten über einen Prozess namens „Cranking“ weiterleitet, um nahtlose Interaktionen sicherzustellen. Sobald eine Nachricht gesendet wurde, leitet die MU sie an das entsprechende Ziel (SU) innerhalb des Netzwerks weiter, koordiniert die Interaktion und verarbeitet alle resultierenden Postausgangsnachrichten rekursiv. Dieser Vorgang wird fortgesetzt, bis alle Nachrichten verarbeitet wurden. Zusätzlich zur Nachrichtenweiterleitung bietet MU auch verschiedene Funktionen, einschließlich der Verwaltung von Prozessabonnements und der Abwicklung geplanter Cron-Interaktionen.

Scheduler Unit (SU):

Scheduler Unit (SU):

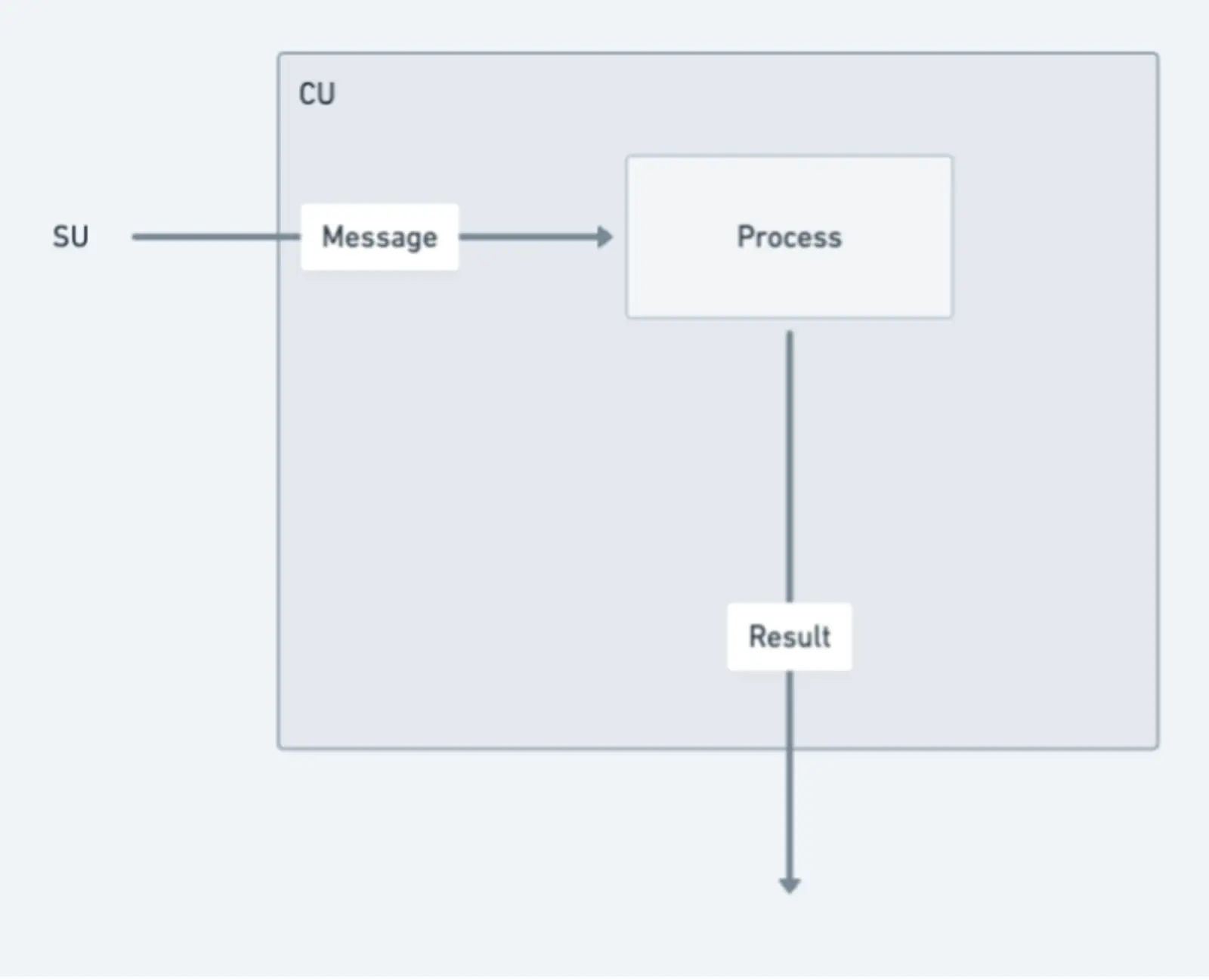

- Wenn eine Nachricht empfangen wird, startet die SU eine Reihe kritischer Vorgänge um die Kontinuität und Integrität des Prozesses aufrechtzuerhalten. Beim Empfang einer Nachricht weist die SU eine eindeutige Inkrement-Nonce zu, um die Reihenfolge relativ zu anderen Nachrichten im selben Prozess sicherzustellen. Dieser Zuordnungsprozess wird durch kryptografische Signaturen formalisiert und garantiert Authentizität und Sequenzintegrität. Um die Zuverlässigkeit des Prozesses weiter zu verbessern, lädt SU Signaturzuordnungen und Nachrichten in die Arweave-Datenschicht hoch. Dies stellt die Verfügbarkeit und Unveränderlichkeit von Nachrichten sicher und verhindert Datenmanipulation oder -verlust; Prozessstatusdienst. Sobald die Statusberechnung abgeschlossen ist, sendet CU ein signiertes Zertifikat mit dem spezifischen Nachrichtenergebnis an den Anrufer zurück. Darüber hinaus kann CU auch Signaturstatuszertifikate generieren und veröffentlichen, die von anderen Knoten geladen werden können. Dafür ist natürlich auch die Zahlung eines bestimmten Prozentsatzes an Gebühren erforderlich.

-

Betriebssystem AOS

AOS kann als Betriebssystem oder Terminaltool im AO-Protokoll betrachtet werden, mit dem Threads heruntergeladen, ausgeführt und verwaltet werden können. Es bietet eine Umgebung, in der Entwickler Anwendungen entwickeln, bereitstellen und ausführen können. Unter AOS können Entwickler das AO-Protokoll verwenden, um Anwendungen zu entwickeln und bereitzustellen und mit dem AO-Netzwerk zu interagieren.

Operatorlogik

Actor Model vertritt eine philosophische Sichtweise namens „Alles ist ein Schauspieler“. Alle Komponenten und Entitäten innerhalb dieses Modells können als „Akteure“ betrachtet werden. Jeder Akteur hat seinen eigenen Status, sein eigenes Verhalten und seine eigene Mailbox. Sie kommunizieren und arbeiten durch asynchrone Kommunikation zusammen, sodass das gesamte System verteilt arbeiten und funktionieren kann eine gleichzeitige Art und Weise. Dasselbe gilt für die Betriebslogik des AO-Netzwerks. Komponenten und sogar Benutzer können als „Akteure“ abstrahiert werden und über die Nachrichtenübermittlungsschicht miteinander kommunizieren, sodass Prozesse miteinander verknüpft werden können parallel berechnet werden und keinen gemeinsamen Zustand haben, der miteinander verflochten ist.

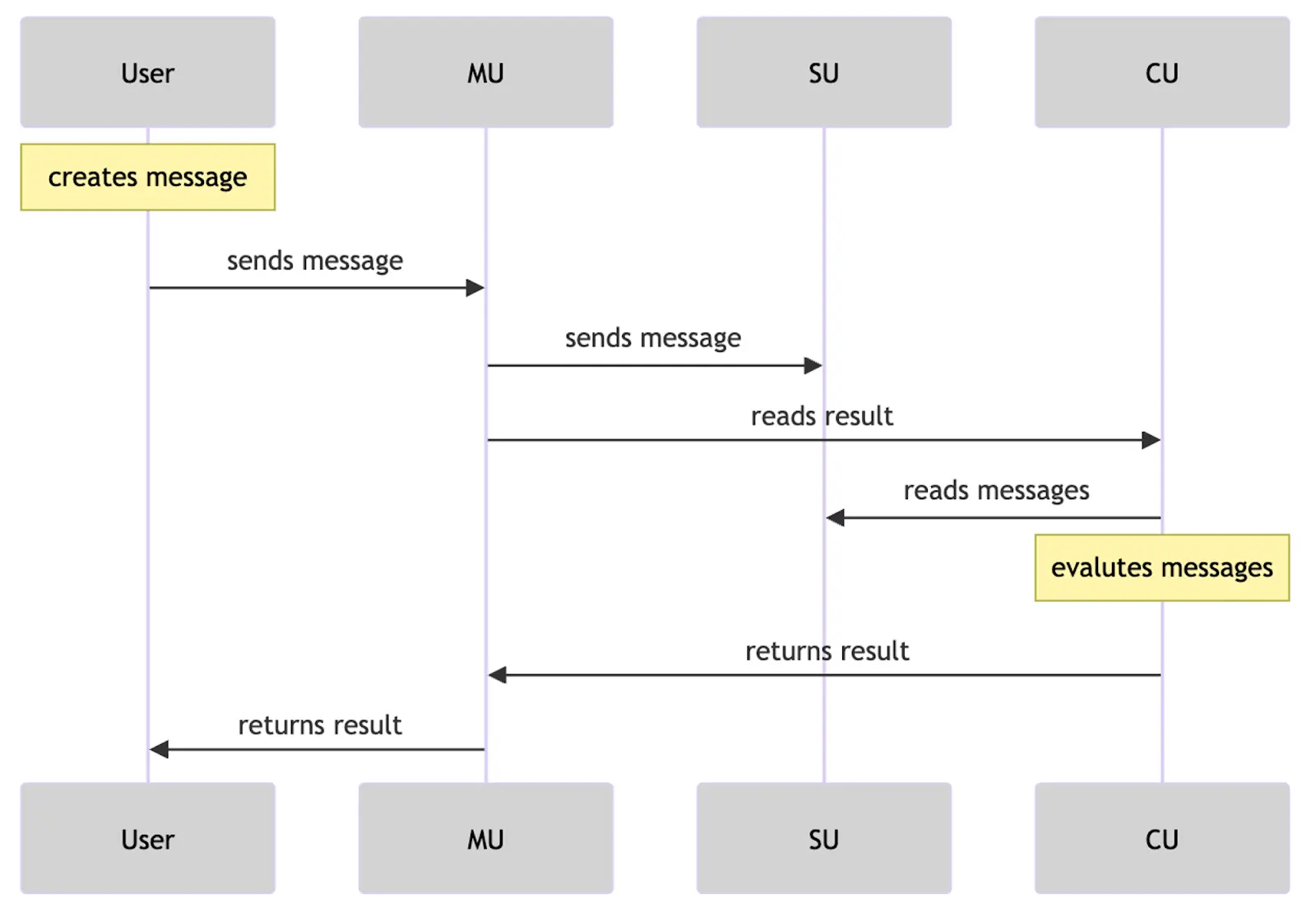

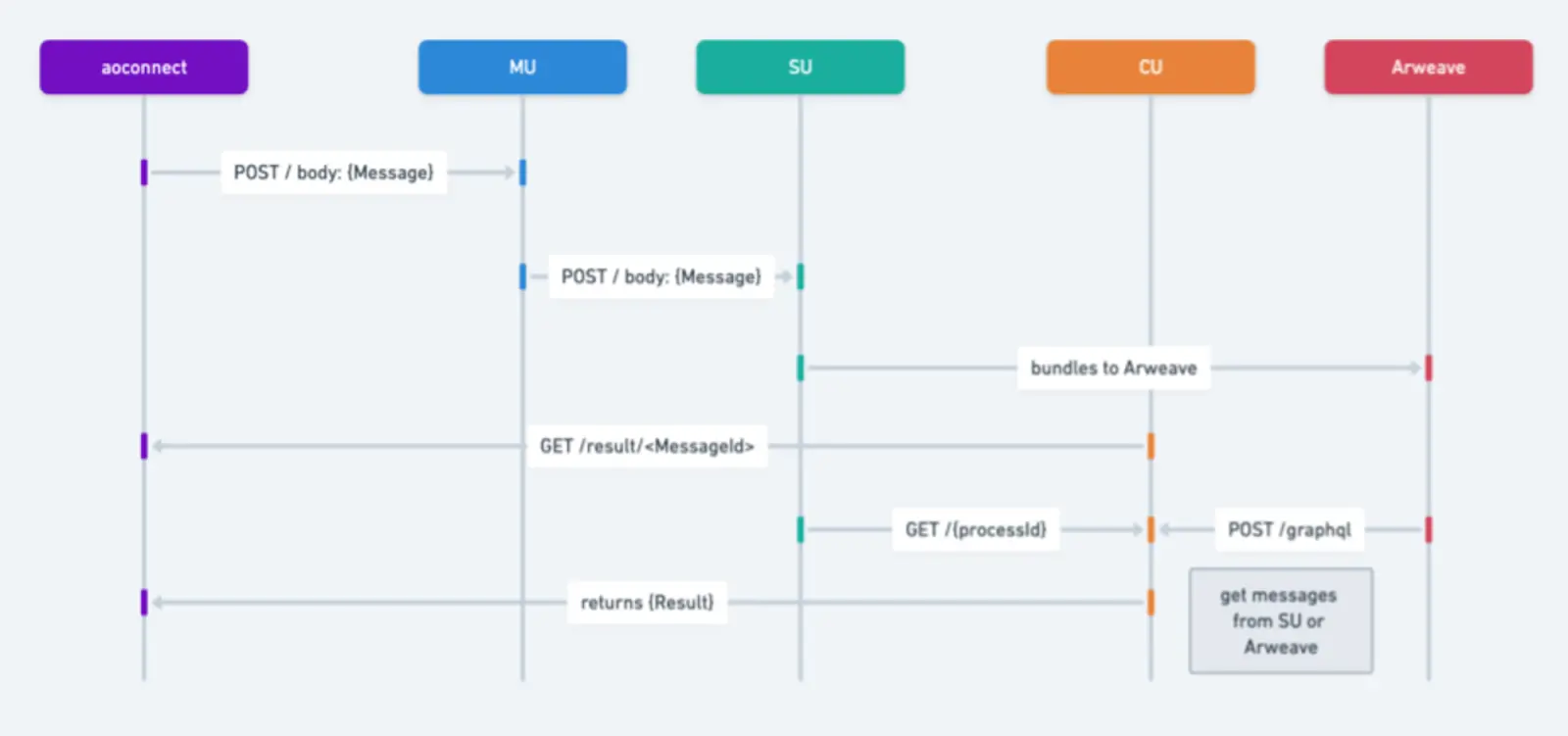

Die Folgende ist eine kurze Beschreibung der Schritte des Nachrichtenübertragungsablaufdiagramms:

Initiation der Nachricht :

a Benutzer oder Prozess erstellt eine Nachricht an eine Nachricht Senden Sie eine Anfrage an andere Prozesse.

MU (Messenger Unit) empfängt die Nachricht und sendet sie per POST-Anfrage an andere Dienste.

Verarbeitung und Weiterleitung von Nachrichten :

MU verarbeitet die POST-Anfrage und leitet die Nachricht an SU (Scheduling Unit) weiter.

SU interagiert mit der Arweave-Speicher- oder Datenschicht, um Nachrichten zu speichern.

Ergebnisse basierend auf der Nachrichten-ID abrufen:

CU (compute) empfängt die GET-Anfrage, ruft die Ergebnisse basierend auf der Nachrichten-ID ab und wertet den Status der Nachricht im Prozess aus. Es kann Ergebnisse basierend auf einer einzelnen Nachrichtenkennung zurückgeben.

Informationen abrufen :

SU erhält eine GET-Anfrage zum Abrufen von Nachrichteninformationen basierend auf dem angegebenen Zeitbereich und der Prozess-ID.

Postausgangsnachrichten pushen:

Der letzte Schritt besteht darin, alle Postausgangsnachrichten zu pushen.

In diesem Schritt erfolgt die Überprüfung der Nachricht und Generierung im Ergebnisobjekt.

Basierend auf den Ergebnissen dieser Prüfung können die Schritte 2, 3 und 4 für jede relevante Nachricht oder jeden relevanten Build wiederholt werden.

Was hat AO verändert? 「1」

Unterschiede zu herkömmlichen Netzwerken:

Parallele Verarbeitungsfunktionen: Im Gegensatz zu Netzwerken wie Ethereum werden die Basisschicht und jedes Rollup tatsächlich als ein einzelner Prozess ausgeführt. AO ermöglicht eine beliebige Anzahl von Prozessen laufen parallel ab und stellen gleichzeitig sicher, dass die Überprüfbarkeit der Berechnung gewahrt bleibt. Darüber hinaus arbeiten diese Netzwerke in einem global synchronisierten Zustand, während die AO-Prozesse ihren eigenen unabhängigen Zustand beibehalten. Diese Unabhängigkeit ermöglicht es dem AO-Prozess, eine höhere Anzahl von Interaktionen und rechnerischer Skalierbarkeit zu bewältigen, was ihn besonders für Anwendungen geeignet macht, die eine hohe Leistung und Zuverlässigkeit erfordern Das Peer-to-Peer-System Urbit bietet zwar große Rechenleistung, im Gegensatz zu AO bieten sie keine überprüfbare Reproduzierbarkeit von Interaktionen oder verlassen sich auf nicht persistente Speicherlösungen, um ihre Interaktionsprotokolle zu speichern.

Der Unterschied zwischen dem Knotennetzwerk von AO und der herkömmlichen Computerumgebung:

Kompatibilität: AO unterstützt verschiedene Formen von Threads, unabhängig davon, ob sie auf WASM oder EVM basieren, und kann durch bestimmte technische Mittel implementiert werden. Von AO erhalten.

Projekte zur gemeinsamen Erstellung von Inhalten: AO unterstützt auch Projekte zur gemeinsamen Erstellung von Inhalten. Sie können atomare NFTs auf AO veröffentlichen, Daten hochladen und diese mit UDL kombinieren, um NFTs auf AO zu erstellen.

Datenzusammensetzbarkeit: NFT auf AR und AO kann Datenzusammensetzbarkeit erreichen, sodass ein Artikel oder Inhalt auf mehreren Plattformen geteilt und angezeigt werden kann, während die Konsistenz und die ursprünglichen Eigenschaften der Datenquelle erhalten bleiben. Wenn Inhalte aktualisiert werden, kann das AO-Netzwerk diese Aktualisierungsstatus an alle relevanten Plattformen senden, um die Synchronisierung der Inhalte und die Verbreitung des neuesten Status sicherzustellen.

Wert-Feedback und Eigentum: Inhaltsersteller können ihre Werke als NFTs verkaufen und Eigentumsinformationen über das AO-Netzwerk übertragen, um Wert-Feedback für die Inhalte zu erzielen.

Unterstützung für das Projekt:

Auf Arweave aufgebaut: AO nutzt die Funktionen von Arweave, um Schwachstellen im Zusammenhang mit zentralisierten Anbietern wie Single Points of Failure, Datenlecks und Zensur zu beseitigen. Die Berechnungen auf AO sind transparent und können durch dezentrale Vertrauensminimierungsfunktionen und reproduzierbare Nachrichtenprotokolle überprüft werden, die auf Arweave gespeichert sind. Jeder kann ganz einfach von seinem Terminal aus einen AO-Prozess erstellen, ohne dass dafür spezielle Kenntnisse, Tools oder Infrastruktur erforderlich sind. Dadurch wird sichergestellt, dass auch Einzelpersonen und kleine Unternehmen eine globale Reichweite und Beteiligung haben.

Überprüfbare Probleme von AO

Laut der Aussage von Hill und Outprog kann man sich AO als ein Einschreibungsberechnungsrahmen vorstellen, der auf einem superparallelen Indexer basiert, wenn die Verifizierungslogik einfacher ist. Wir alle wissen, dass der Bitcoin-Inskriptionsindexer JSON-Informationen aus der Inschrift extrahieren muss, um die Inschrift zu überprüfen, die Kontostandinformationen in der Off-Chain-Datenbank aufzuzeichnen und die Überprüfung durch eine Reihe von Indexierungsregeln abzuschließen. Obwohl der Indexer außerhalb der Kette überprüft wird, können Benutzer die Inschrift überprüfen, indem sie mehrere Indexer ändern oder den Index selbst ausführen, sodass sie sich keine Sorgen machen müssen, dass der Indexer Böses tut. Wir haben oben erwähnt, dass Daten wie die Sortierung von Nachrichten und der holografische Status des Prozesses auf Arweave hochgeladen werden. Dann muss es nur noch auf dem SCP-Paradigma (Speicherkonsens-Paradigma) basieren. Hier kann einfach verstanden werden, dass SCP der Indexer ist der Indexierungsregeln in der Kette. Darüber hinaus ist anzumerken, dass SCP viel früher als der Indexer erschien und jeder AO oder jeden Thread auf AO über die holografischen Daten auf Arweave wiederherstellen kann. Benutzer müssen nicht den gesamten Knoten ausführen, um den vertrauenswürdigen Status zu überprüfen. Genau wie beim Ändern des Index müssen Benutzer über SU nur Abfrageanforderungen an einzelne oder mehrere CU-Knoten stellen. Arweave verfügt über eine hohe Speicherkapazität und niedrige Kosten, sodass AO-Entwickler nach dieser Logik eine Supercomputing-Schicht implementieren können, die die Funktionen von Bitcoin-Inschriften bei weitem übertrifft.

AO und ICP

Lassen Sie uns einige Schlüsselwörter verwenden, um die Eigenschaften von AO zusammenzufassen: riesige native Festplatte, unbegrenzte Parallelität, unbegrenzte Rechenleistung, modulare Gesamtarchitektur und holographischer Zustandsprozess. Das hört sich alles sehr gut an, aber Freunde, die mit verschiedenen Public-Chain-Projekten in der Blockchain vertraut sind, werden vielleicht feststellen, dass AO besonders einem „Death-Level“-Projekt ähnelt, dem einst beliebten „Internet Computer“ ICP.

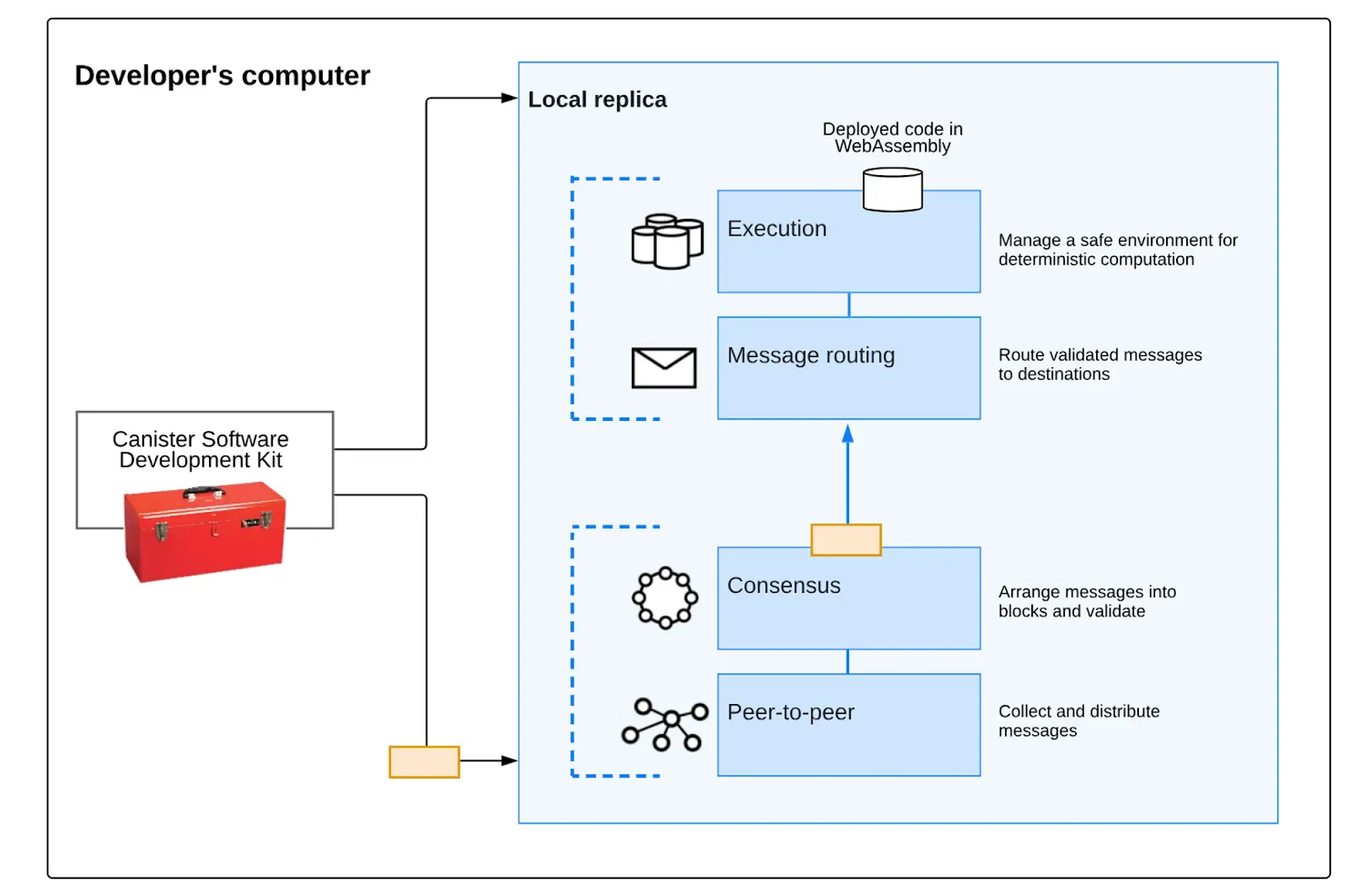

ICP wurde einst als das letzte Königsprojekt in der Blockchain-Welt gefeiert. Es erfreute sich großer Beliebtheit bei Top-Institutionen und erreichte in den 21 Jahren verrückter Bullen einen FDV von 200 Milliarden US-Dollar. Doch als die Welle nachließ, sank auch der Token-Wert von ICP. Bis zum Bärenmarkt im Jahr 2023 war der Wert der ICP-Token im Vergleich zu seinem historischen Höchststand um fast das 260-fache gesunken. Wenn jedoch die Entwicklung des Token-Preises nicht berücksichtigt wird, weisen seine technischen Eigenschaften, selbst wenn ICP zu diesem Zeitpunkt erneut überprüft wird, immer noch viele einzigartige Merkmale auf. Viele der erstaunlichen Vorteile und Funktionen von AO heute besaß auch ICP damals. Wird AO also genauso scheitern wie ICP? Lassen Sie uns zunächst verstehen, warum die beiden so ähnlich sind. ICP und AO basieren beide auf dem Akteurmodell und konzentrieren sich auf lokal ausgeführte Blockchains, sodass die Eigenschaften der beiden viele Ähnlichkeiten aufweisen. Die ICP-Subnetz-Blockchain besteht aus einer Reihe unabhängiger und kontrollierter Hochleistungs-Hardwaregeräte (Knotenmaschinen), auf denen das Internet Computer Protocol (ICP) ausgeführt wird. Das Internet Computer Protocol wird durch eine Reihe von Softwarekomponenten implementiert, die als Bündel Replikate darstellen, indem sie den Zustand und die Berechnung über alle Knoten in einer Subnetz-Blockchain hinweg replizieren.

Die Replikationsarchitektur von ICP kann von oben nach unten in vier Schichten unterteilt werden:

Peer-to-Peer (P2P) Netzwerkschicht : Wird zum Sammeln und Benachrichtigen von Daten von Benutzern und anderen Knoten in ihrer Subnetz-Blockchain verwendet und Neuigkeiten aus anderen Subnetz-Blockchains. Von der Peer-Schicht empfangene Nachrichten werden auf alle Knoten im Subnetz repliziert, um Sicherheit, Zuverlässigkeit und Ausfallsicherheit zu gewährleistenKonsensschicht: Wählt und sortiert von Benutzern und verschiedenen Subnetzen empfangene Nachrichten aus, um Blockchain-Blöcke zu erstellen, die durch einen byzantinischen fehlertoleranten Konsens, der die sich entwickelnde Blockchain bildet, notariell beglaubigt und finalisiert werden können. Diese finalisierten Blöcke werden an die Nachrichtenrouting-Schicht übergeben;

Nachrichtenrouting-Schicht: werden verwendet, um vom Benutzer und vom System generierte Nachrichten zwischen Subnetzen weiterzuleiten, die Eingabe- und Ausgabewarteschlangen des Dapp zu verwalten und die Nachrichtenausführung zu planen; Ausführungsumgebungsschicht:

Berechnet die deterministischen Berechnungen, die bei der Ausführung eines Smart Contracts erforderlich sind, indem die von der Nachrichtenroutingschicht empfangenen Nachrichten verarbeitet werden.

Subnetz-Blockchain

Ein sogenanntes Subnetz ist eine Sammlung interagierender Replikate, die separate Instanzen des Konsensmechanismus ausführen, um eine eigene Blockchain zu erstellen, auf der eine Reihe von „Containern“ ausgeführt werden. Jedes Subnetz kann mit anderen Subnetzen kommunizieren und wird vom Root-Subnetz gesteuert, das mithilfe der Kettenschlüsselkryptografie seine Berechtigungen an einzelne Subnetze delegiert. ICP verwendet Subnetze, um eine unbegrenzte Erweiterung zu ermöglichen. Das Problem bei herkömmlichen Blockchains (und einzelnen Subnetzen) besteht darin, dass sie durch die Rechenleistung einer einzelnen Knotenmaschine begrenzt sind, da jeder Knoten alles ausführen muss, was auf der Blockchain geschieht, um am Konsensalgorithmus teilzunehmen. Der parallele Betrieb mehrerer unabhängiger Subnetze ermöglicht es ICP, diese Ein-Maschine-Barriere zu durchbrechen.

Warum es gescheitert ist

Wie oben erwähnt, ist das, was die ICP-Architektur erreichen will, vereinfacht gesagt, ein dezentraler Cloud-Server. Vor ein paar Jahren war diese Idee genauso schockierend wie AO, aber warum scheiterte sie? Vereinfacht ausgedrückt bedeutet dies, dass Sie keine gute Balance zwischen Web3 und Ihren eigenen Ideen finden, wenn Sie keine hohen oder niedrigen Ziele erreichen, was letztendlich zu der peinlichen Situation führt, dass das Projekt weder Web3 noch so einfach ist Zusammenfassend gibt es drei Probleme. Erstens ähnelt das ICP-Programmsystem Canister, der oben erwähnte „Container“, tatsächlich etwas AOS und den Prozessen in AO, aber sie sind nicht gleich. ICP-Programme werden durch Canister-Kapselung implementiert und sind für die Außenwelt nicht sichtbar. Sie müssen über bestimmte Schnittstellen auf Daten zugreifen. Asynchrone Kommunikation ist für Vertragsaufrufe in DeFi-Protokollen sehr unfreundlich, daher hat ICP im DeFi Summer nicht den entsprechenden finanziellen Wert erfasst.

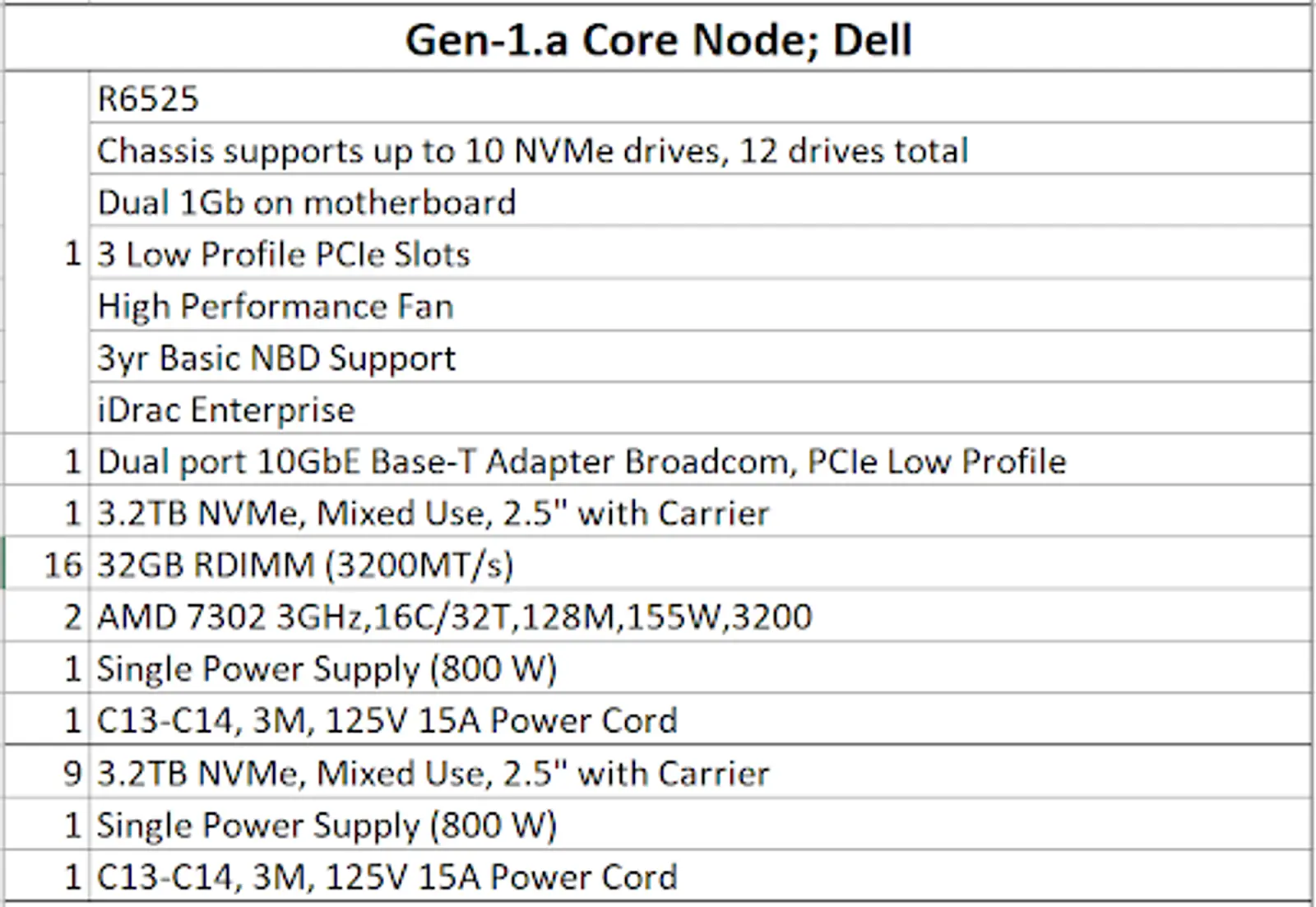

Der zweite Punkt ist, dass die Hardwareanforderungen extrem hoch sind, was dazu führt, dass das Projekt nicht dezentralisiert ist. Das Bild unten ist das von ICP angegebene minimale Hardwarekonfigurationsdiagramm Sehr übertrieben, übersteigt die Konfiguration von Solana bei weitem und sogar die Speicheranforderungen sind höher als bei öffentlichen Speicherketten.

Der dritte Punkt ist der Mangel an Ökologie. Auch jetzt noch ist ICP eine sehr leistungsstarke öffentliche Kette. Wenn es keine DeFi-Anwendungen gibt, wie sieht es dann mit anderen Anwendungen aus? Leider hat ICP seit seiner Einführung keine Killeranwendung entwickelt. Sein Ökosystem hat weder Web2-Benutzer noch Web3-Benutzer erfasst. Warum also bei so wenig Dezentralisierung nicht einfach umfangreiche und ausgereifte zentralisierte Anwendungen nutzen? Aber am Ende ist es unbestreitbar, dass die Technologie von ICP immer noch erstklassig ist und dass ihre Vorteile wie Umkehrgas, hohe Kompatibilität und unbegrenzte Erweiterung immer noch notwendig sind, um die nächste Milliarde Benutzer anzulocken. Unter der aktuellen KI-Welle, wenn ICP dies kann gut darin Es kann möglich sein, die eigenen strukturellen Vorteile zu nutzen.

Also zurück zur obigen Frage: Wird AO wie ICP scheitern? Ich persönlich denke, dass AO nicht die gleichen Fehler wiederholen wird. Die letzten beiden Punkte, die zum Scheitern von ICP geführt haben, sind für AO bereits eine gute ökologische Grundlage und lösen das Zentralisierungsproblem. Hinsichtlich der Kompatibilität ist AO auch flexibler. Weitere Herausforderungen könnten sich auf die Gestaltung des Wirtschaftsmodells, die Unterstützung von DeFi und ein jahrhundertealtes Problem konzentrieren: Welche Form sollte Web3 im nichtfinanziellen Bereich und im Speicherbereich annehmen?

Web3 sollte nicht bei der Erzählung stehen bleiben

Das Wort, das in der Welt von Web3 am häufigsten vorkommt, muss „Erzählung“ sein, und wir haben uns sogar daran gewöhnt, die Erzählperspektive zu verwenden, um den Wert zu messen der meisten Token. Dies ist natürlich auf das Dilemma zurückzuführen, dass die meisten Web3-Projekte eine großartige Vision haben, deren Verwendung jedoch sehr umständlich ist. Im Vergleich dazu verfügt Arweave bereits über viele vollständig implementierte Anwendungen, die alle auf ein Erlebnis auf Web2-Ebene abzielen. Zum Beispiel Mirror und ArDrive. Wenn Sie diese Projekte verwendet haben, wird es schwierig sein, den Unterschied zu herkömmlichen Anwendungen zu spüren. Allerdings weist Arweave als öffentliche Speicherkette immer noch große Einschränkungen bei der Wertschöpfung auf, und Berechnung ist möglicherweise der einzige Weg. Insbesondere in der heutigen Außenwelt ist KI zu einem allgemeinen Trend geworden. Derzeit gibt es noch viele natürliche Hindernisse für die Integration von Web3, über die wir auch in früheren Artikeln gesprochen haben. Jetzt verwendet Arweaves AO eine nicht-Ethereum-modulare Lösungsarchitektur, wodurch Web3 x AI eine gute neue Infrastruktur erhält. Von der Bibliothek von Alexandria bis hin zu superparallelen Computern folgt Arweave einem ganz eigenen Paradigma. 🔜

X Weltraumereignisrekord|Ist AO der Killer von Ethereum? Wie wird es das neue Narrativ der Blockchain fördern? : https://medium.com/@permadao/x-space-Activity Record-ao-Ist es ein Ethereum-Killer? Wie wird es die neue Erzählung der Blockchain fördern?-bea5a22d462c

ICP White Paper : https://internetcomputer.org/docs/current/concepts/subnet-types

AO Kochbuch: https://cookbook_ao.arweave.dev/concepts/tour.html

AO — — Hyperparallele Computer, die Sie sich nicht vorstellen können: https:/ /medium.com/@permadao/ao-Ein superparalleler Computer, den Sie sich nicht vorstellen können-1949f5ef038f

Analyse der Gründe für den Niedergang von ICP aus mehreren Blickwinkeln: Außenseitertechnologie und ein dünnes Ökosystem: https://www.chaincatcher.com/article/2098499

Konsensschicht: Wählt und sortiert von Benutzern und verschiedenen Subnetzen empfangene Nachrichten aus, um Blockchain-Blöcke zu erstellen, die durch einen byzantinischen fehlertoleranten Konsens, der die sich entwickelnde Blockchain bildet, notariell beglaubigt und finalisiert werden können. Diese finalisierten Blöcke werden an die Nachrichtenrouting-Schicht übergeben;

Nachrichtenrouting-Schicht: werden verwendet, um vom Benutzer und vom System generierte Nachrichten zwischen Subnetzen weiterzuleiten, die Eingabe- und Ausgabewarteschlangen des Dapp zu verwalten und die Nachrichtenausführung zu planen; Ausführungsumgebungsschicht:

Berechnet die deterministischen Berechnungen, die bei der Ausführung eines Smart Contracts erforderlich sind, indem die von der Nachrichtenroutingschicht empfangenen Nachrichten verarbeitet werden.

Subnetz-Blockchain

Ein sogenanntes Subnetz ist eine Sammlung interagierender Replikate, die separate Instanzen des Konsensmechanismus ausführen, um eine eigene Blockchain zu erstellen, auf der eine Reihe von „Containern“ ausgeführt werden. Jedes Subnetz kann mit anderen Subnetzen kommunizieren und wird vom Root-Subnetz gesteuert, das mithilfe der Kettenschlüsselkryptografie seine Berechtigungen an einzelne Subnetze delegiert. ICP verwendet Subnetze, um eine unbegrenzte Erweiterung zu ermöglichen. Das Problem bei herkömmlichen Blockchains (und einzelnen Subnetzen) besteht darin, dass sie durch die Rechenleistung einer einzelnen Knotenmaschine begrenzt sind, da jeder Knoten alles ausführen muss, was auf der Blockchain geschieht, um am Konsensalgorithmus teilzunehmen. Der parallele Betrieb mehrerer unabhängiger Subnetze ermöglicht es ICP, diese Ein-Maschine-Barriere zu durchbrechen.

Warum es gescheitert ist

Wie oben erwähnt, ist das, was die ICP-Architektur erreichen will, vereinfacht gesagt, ein dezentraler Cloud-Server. Vor ein paar Jahren war diese Idee genauso schockierend wie AO, aber warum scheiterte sie? Vereinfacht ausgedrückt bedeutet dies, dass Sie keine gute Balance zwischen Web3 und Ihren eigenen Ideen finden, wenn Sie keine hohen oder niedrigen Ziele erreichen, was letztendlich zu der peinlichen Situation führt, dass das Projekt weder Web3 noch so einfach ist Zusammenfassend gibt es drei Probleme. Erstens ähnelt das ICP-Programmsystem Canister, der oben erwähnte „Container“, tatsächlich etwas AOS und den Prozessen in AO, aber sie sind nicht gleich. ICP-Programme werden durch Canister-Kapselung implementiert und sind für die Außenwelt nicht sichtbar. Sie müssen über bestimmte Schnittstellen auf Daten zugreifen. Asynchrone Kommunikation ist für Vertragsaufrufe in DeFi-Protokollen sehr unfreundlich, daher hat ICP im DeFi Summer nicht den entsprechenden finanziellen Wert erfasst.

Der zweite Punkt ist, dass die Hardwareanforderungen extrem hoch sind, was dazu führt, dass das Projekt nicht dezentralisiert ist. Das Bild unten ist das von ICP angegebene minimale Hardwarekonfigurationsdiagramm Sehr übertrieben, übersteigt die Konfiguration von Solana bei weitem und sogar die Speicheranforderungen sind höher als bei öffentlichen Speicherketten.

Der dritte Punkt ist der Mangel an Ökologie. Auch jetzt noch ist ICP eine sehr leistungsstarke öffentliche Kette. Wenn es keine DeFi-Anwendungen gibt, wie sieht es dann mit anderen Anwendungen aus? Leider hat ICP seit seiner Einführung keine Killeranwendung entwickelt. Sein Ökosystem hat weder Web2-Benutzer noch Web3-Benutzer erfasst. Warum also bei so wenig Dezentralisierung nicht einfach umfangreiche und ausgereifte zentralisierte Anwendungen nutzen? Aber am Ende ist es unbestreitbar, dass die Technologie von ICP immer noch erstklassig ist und dass ihre Vorteile wie Umkehrgas, hohe Kompatibilität und unbegrenzte Erweiterung immer noch notwendig sind, um die nächste Milliarde Benutzer anzulocken. Unter der aktuellen KI-Welle, wenn ICP dies kann gut darin Es kann möglich sein, die eigenen strukturellen Vorteile zu nutzen.

Also zurück zur obigen Frage: Wird AO wie ICP scheitern? Ich persönlich denke, dass AO nicht die gleichen Fehler wiederholen wird. Die letzten beiden Punkte, die zum Scheitern von ICP geführt haben, sind für AO bereits eine gute ökologische Grundlage und lösen das Zentralisierungsproblem. Hinsichtlich der Kompatibilität ist AO auch flexibler. Weitere Herausforderungen könnten sich auf die Gestaltung des Wirtschaftsmodells, die Unterstützung von DeFi und ein jahrhundertealtes Problem konzentrieren: Welche Form sollte Web3 im nichtfinanziellen Bereich und im Speicherbereich annehmen?

Web3 sollte nicht bei der Erzählung stehen bleiben

Das Wort, das in der Welt von Web3 am häufigsten vorkommt, muss „Erzählung“ sein, und wir haben uns sogar daran gewöhnt, die Erzählperspektive zu verwenden, um den Wert zu messen der meisten Token. Dies ist natürlich auf das Dilemma zurückzuführen, dass die meisten Web3-Projekte eine großartige Vision haben, deren Verwendung jedoch sehr umständlich ist. Im Vergleich dazu verfügt Arweave bereits über viele vollständig implementierte Anwendungen, die alle auf ein Erlebnis auf Web2-Ebene abzielen. Zum Beispiel Mirror und ArDrive. Wenn Sie diese Projekte verwendet haben, wird es schwierig sein, den Unterschied zu herkömmlichen Anwendungen zu spüren. Allerdings weist Arweave als öffentliche Speicherkette immer noch große Einschränkungen bei der Wertschöpfung auf, und Berechnung ist möglicherweise der einzige Weg. Insbesondere in der heutigen Außenwelt ist KI zu einem allgemeinen Trend geworden. Derzeit gibt es noch viele natürliche Hindernisse für die Integration von Web3, über die wir auch in früheren Artikeln gesprochen haben. Jetzt verwendet Arweaves AO eine nicht-Ethereum-modulare Lösungsarchitektur, wodurch Web3 x AI eine gute neue Infrastruktur erhält. Von der Bibliothek von Alexandria bis hin zu superparallelen Computern folgt Arweave einem ganz eigenen Paradigma. 🔜

X Weltraumereignisrekord|Ist AO der Killer von Ethereum? Wie wird es das neue Narrativ der Blockchain fördern? : https://medium.com/@permadao/x-space-Activity Record-ao-Ist es ein Ethereum-Killer? Wie wird es die neue Erzählung der Blockchain fördern?-bea5a22d462c

ICP White Paper : https://internetcomputer.org/docs/current/concepts/subnet-types

AO Kochbuch: https://cookbook_ao.arweave.dev/concepts/tour.html

AO — — Hyperparallele Computer, die Sie sich nicht vorstellen können: https:/ /medium.com/@permadao/ao-Ein superparalleler Computer, den Sie sich nicht vorstellen können-1949f5ef038f

Analyse der Gründe für den Niedergang von ICP aus mehreren Blickwinkeln: Außenseitertechnologie und ein dünnes Ökosystem: https://www.chaincatcher.com/article/2098499

Das obige ist der detaillierte Inhalt vonVon der Speicherung der Vergangenheit bis zur Berechnung der Zukunft: AO-Hyperparallelrechner. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Die kryptografische Technologie der Blockchain umfasst den Algorithmus für digitale Signaturen und welchen Algorithmus

- Welche Verwendungszwecke und Möglichkeiten gibt es, physische Bitcoin-Münzen umzutauschen?

- Wie hoch kann Ethereum im Jahr 2024 steigen?

- Das Transaktionsvolumen von Ethereum NFT nähert sich einem neuen Jahreshoch! Pudgy Penguins liegt hinsichtlich der Marktkapitalisierung an dritter Stelle, dicht hinter Boring Ape