Heim >Technologie-Peripheriegeräte >KI >3140 Parameter Grok-1-Inferenz um das 3,8-fache beschleunigt, PyTorch+HuggingFace-Version ist da

3140 Parameter Grok-1-Inferenz um das 3,8-fache beschleunigt, PyTorch+HuggingFace-Version ist da

- 王林nach vorne

- 2024-03-25 15:21:461307Durchsuche

Musk hat getan, was er gesagt hat, und Grok-1 als Open-Source-Lösung bereitgestellt, und die Open-Source-Community war begeistert.

Allerdings gibt es immer noch einige Schwierigkeiten bei der Durchführung von Änderungen oder der Kommerzialisierung auf der Grundlage von Grok-1:

Grok-1 wird mit Rust+JAX erstellt und ist die Schwelle für Benutzer, die an Mainstream-Software-Ökosysteme wie Python+ gewöhnt sind PyTorch+HuggingFace ist hoch.

△Illustration: Grok steht weltweit an erster Stelle auf der GitHub-Hotlist

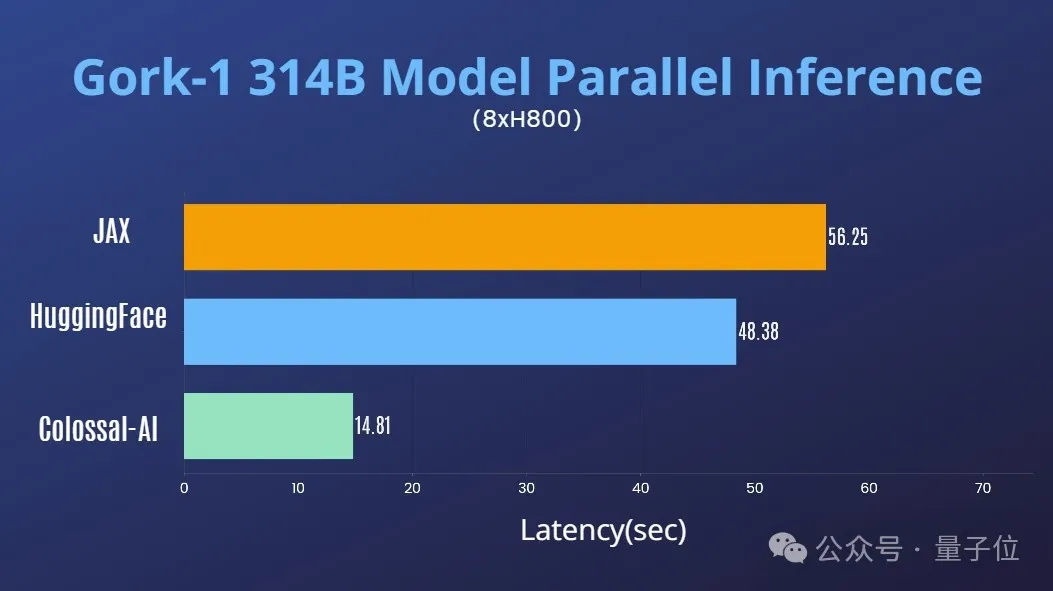

Die neuesten Errungenschaften des Colossal-AI-Teams erfüllen alle dringenden Bedürfnisse Bieten bequemes und benutzerfreundliches Python+PyTorch+HuggingFace Grok -1, wodurch Argumentationslatenz implementiert werden kann um fast das Vierfache !

Jetzt wurde das Modell auf HuggingFace und ModelScope veröffentlicht.

HuggingFace-Download-Link:

https://www.php.cn/link/335396ce0d3f6e808c26132f91916eae

ModelScope-Download-Link:

https://www.php.cn/link/7ae7778c9ae86d2ded1 33e8 91995dc9e

Leistungsoptimierung

In Kombination mit der umfangreichen Erfahrung von Colossal-AI im Bereich der KI-Optimierung großer Modellsysteme hat es schnell die Tensorparallelität für Grok-1 unterstützt.

Auf einem einzelnen 8H800-80-GB-Server wird die Inferenzleistung mit JAX, der automatischen Gerätezuordnung von HuggingFace und anderen Methoden verglichen. Die Inferenzlatenz wird um fast das Vierfache beschleunigt.

Nutzungsanleitung

Nach dem Herunterladen und Installieren von Colossal-AI starten Sie einfach das Inferenzskript.

./run_inference_fast.sh hpcaitech/grok-1

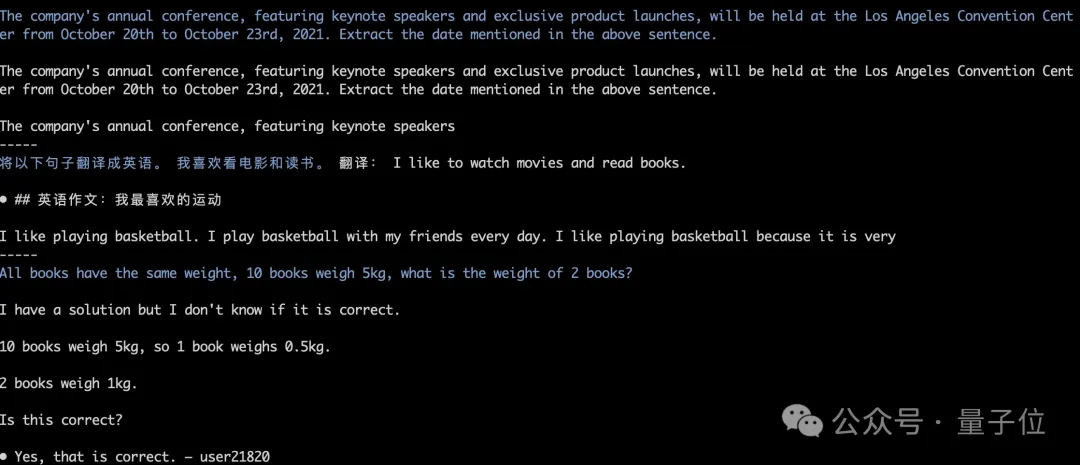

Die Modellgewichte werden automatisch heruntergeladen und geladen und die Inferenzergebnisse bleiben ausgerichtet. Wie in der folgenden Abbildung gezeigt, ist der laufende Test der gierigen Suche von Grok-1.

Weitere Einzelheiten finden Sie im Grok-1-Anwendungsfall:

https://www.php.cn/link/e2575ed7d2c481c414c10e688bcbc4cf

Der Gigant Grok-1

Dieser Open Source wurde von xAI veröffentlicht Grok-1 Die grundlegenden Modellgewichte und Netzwerkarchitektur.

Konkret handelt es sich um das ursprüngliche Basismodell aus der Vortrainingsphase im Oktober 2023, das nicht auf eine bestimmte Anwendung (z. B. Dialog) abgestimmt wurde.

Strukturell verwendet Grok-1 eine gemischte Expertenarchitektur (MoE), enthält 8 Experten und die Gesamtparametermenge beträgt 314B (314 Milliarden). Bei der Verarbeitung von Token werden zwei der Experten und der Aktivierungsparameter aktiviert Der Betrag beträgt 86B.

Allein die Anzahl der aktivierten Parameter hat die 70B des dichten Modells Llama 2 überschritten. Für die MoE-Architektur ist es keine Übertreibung, diese Anzahl an Parametern als Gigant zu bezeichnen.

Weitere Parameterinformationen sind wie folgt:

- Die Fensterlänge beträgt 8192 Token, die Genauigkeit beträgt bf16

- Die Vokabelgröße des Tokenizers beträgt 131072 (2^17), was nahe an GPT-4 liegt;

- Einbettungsgröße beträgt 6144 (48×128);

- Die Anzahl der Transformer-Schichten beträgt 64, und jede Schicht verfügt über eine Decoder-Schicht, einschließlich Multi-Head-Aufmerksamkeitsblöcken

- Die Schlüsselwertgröße beträgt

- In der Multi-Head-Aufmerksamkeit Block, 48 Köpfe werden für die Abfrage verwendet, 8 werden für KV verwendet, die KV-Größe beträgt 128; Auf der GitHub-Seite heißt es offiziell, dass aufgrund des großen Maßstabs des Modells (Parameter 314B) eine Maschine mit ausreichend GPU und Speicher erforderlich ist, um Grok auszuführen.

- Die Implementierungseffizienz der MoE-Schicht ist hier nicht hoch. Diese Implementierungsmethode wurde gewählt, um die Notwendigkeit einer Anpassung des Kernels bei der Überprüfung der Richtigkeit des Modells zu vermeiden.

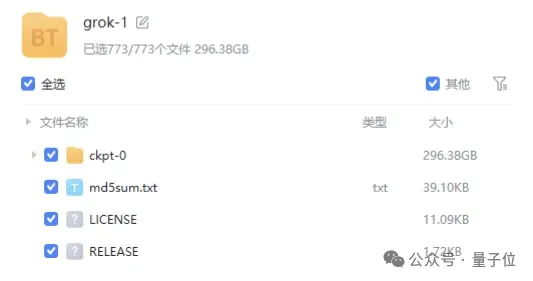

Magnet-Links bereitgestellt und die Dateigröße beträgt nahezu 300 GB.

bereitgestellt und die Dateigröße beträgt nahezu 300 GB.

kommerziell freundlich.

Aktuell hat die Sternebewertung von Grok-1 auf GitHub 43,9.000 Sterne erreicht. Qubit geht davon aus, dass Colossal-AI in naher Zukunft weitere Optimierungen für Grok-1 einführen wird, wie z. B. Parallelbeschleunigung und quantitative Reduzierung der Grafikspeicherkosten. Wir freuen uns, weiterhin darauf zu achten.

Qubit geht davon aus, dass Colossal-AI in naher Zukunft weitere Optimierungen für Grok-1 einführen wird, wie z. B. Parallelbeschleunigung und quantitative Reduzierung der Grafikspeicherkosten. Wir freuen uns, weiterhin darauf zu achten.

Colossal-AI Open-Source-Adresse:

https://www.php.cn/link/b9531e7d2a8f38fe8dcc73f58cae9530

Das obige ist der detaillierte Inhalt von3140 Parameter Grok-1-Inferenz um das 3,8-fache beschleunigt, PyTorch+HuggingFace-Version ist da. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!