Heim >Technologie-Peripheriegeräte >KI >Google veröffentlicht „Vlogger'-Modell: Ein einzelnes Bild erzeugt ein 10-Sekunden-Video

Google veröffentlicht „Vlogger'-Modell: Ein einzelnes Bild erzeugt ein 10-Sekunden-Video

- 王林nach vorne

- 2024-03-20 16:41:48655Durchsuche

Google hat ein neues Video-Framework veröffentlicht:

Sie benötigen nur ein Bild von Ihnen und eine Aufzeichnung Ihrer Rede, und Sie können ein lebensechtes Video Ihrer Rede erhalten.

Die Videodauer ist variabel und beträgt im aktuellen Beispiel bis zu 10 Sekunden.

Sie können sehen, dass es sehr natürlich ist, egal ob Mundform oder Gesichtsausdruck.

Wenn das Eingabebild den gesamten Oberkörper abdeckt, kann es auch mit reichhaltigen Gesten verwendet werden:

Nachdem die Internetnutzer es gelesen hatten, sagten sie:

Damit müssen wir uns nicht mehr festhalten Online-Videokonferenzen in der Zukunft Machen Sie Ihre Frisur fertig und ziehen Sie sich an, bevor Sie gehen.

Nun, machen Sie einfach ein Porträt und nehmen Sie das Sprachaudio auf (manueller Hundekopf)

Verwenden Sie Ihre Stimme, um das Porträt zu steuern, um ein Video zu erstellen

Dieses Framework heißt VLOGGER.

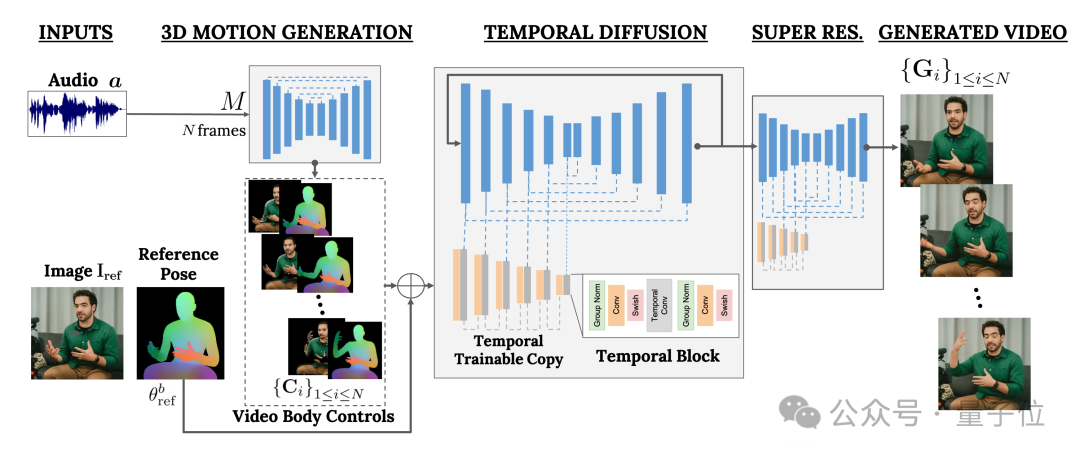

Es basiert hauptsächlich auf dem Diffusionsmodell und besteht aus zwei Teilen:

Einer ist das Diffusionsmodell „Zufällige Mensch-zu-3D-Bewegung“ (Mensch-zu-3D-Bewegung). Das andere ist eine neue Diffusionsarchitektur zur Verbesserung von Text-zu-Bild-Modellen.

Unter ihnen ist ersterer dafür verantwortlich, die Audiowellenform als Eingabe zu verwenden, um die Körperkontrollaktionen des Charakters zu generieren, einschließlich Augen, Ausdrücke und Gesten, allgemeine Körperhaltung usw.

Unter ihnen ist ersterer dafür verantwortlich, die Audiowellenform als Eingabe zu verwenden, um die Körperkontrollaktionen des Charakters zu generieren, einschließlich Augen, Ausdrücke und Gesten, allgemeine Körperhaltung usw.

Letzteres ist ein Bild-zu-Bild-Modell mit zeitlicher Dimension, das verwendet wird, um das groß angelegte Bilddiffusionsmodell zu erweitern und die gerade vorhergesagten Aktionen zum Generieren entsprechender Frames zu verwenden.

Um die Ergebnisse an ein bestimmtes Charakterbild anzupassen, verwendet VLOGGER auch das Posendiagramm des Parameterbilds als Eingabe.

Das Training von VLOGGER wird an einem sehr großen Datensatz

(mit dem Namen MENTOR)abgeschlossen. Wie groß ist es?

Es ist 2200 Stunden lang und enthält 800.000 Charaktervideos. Unter anderem beträgt die Videodauer des Testsets ebenfalls 120 Stunden mit insgesamt 4.000 Zeichen.

Google stellte fest, dass die herausragendste Leistung von VLOGGER seine Vielfalt ist:

Wie im Bild unten gezeigt, sind die Aktionen umso reichhaltiger, je dunkler

(rot)der Teil des endgültigen Pixelbilds ist.

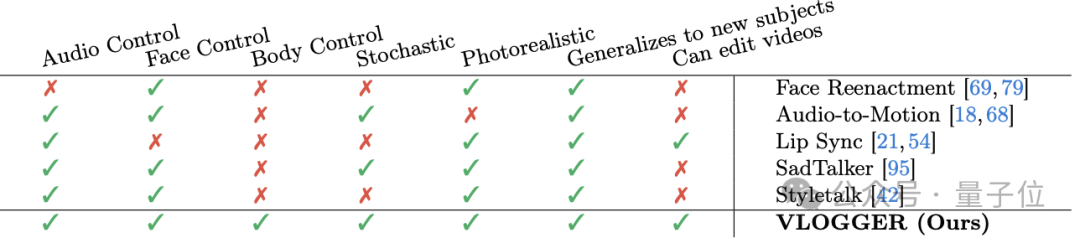

Im Vergleich zu früheren ähnlichen Methoden in der Branche besteht der größte Vorteil von VLOGGER darin, dass nicht jeder geschult werden muss, nicht auf Gesichtserkennung und -zuschnitt angewiesen ist und das generierte Video sehr vollständig ist (einschließlich Gesichter und Lippen, einschließlich Körperbewegungen)

Im Vergleich zu früheren ähnlichen Methoden in der Branche besteht der größte Vorteil von VLOGGER darin, dass nicht jeder geschult werden muss, nicht auf Gesichtserkennung und -zuschnitt angewiesen ist und das generierte Video sehr vollständig ist (einschließlich Gesichter und Lippen, einschließlich Körperbewegungen)

Im Einzelnen, wie in der folgenden Tabelle gezeigt:

Apropos Videobearbeitung: Wie im Bild unten gezeigt, ist eine der Anwendungen des VLOGGER-Modells folgende: Es kann dazu führen, dass der Charakter den Mund hält, die Augen schließt, nur das linke Auge schließt oder das ganze Auge öffnet mit einem Klick:

Eine weitere Anwendung ist die Videoübersetzung:

Ist das das Niveau von Google?

Der Name „VLOGGER“ tut mir ein bisschen leid.

——Verglichen mit Sora von OpenAI ist die Aussage des Internetnutzers tatsächlich nicht unvernünftig. .

Was meint ihr?

Weitere Effekte:https://enriccorona.github.io/vlogger/

Vollständiges Paper: https://enriccorona.github.io/vlogger/paper.pdf

Das obige ist der detaillierte Inhalt vonGoogle veröffentlicht „Vlogger'-Modell: Ein einzelnes Bild erzeugt ein 10-Sekunden-Video. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!