Heim >Hardware-Tutorial >Hardware-Rezension >Trainieren Sie Ihren Roboterhund in Echtzeit mit Vision Pro! Das Open-Source-Projekt eines MIT-Doktoranden ist beliebt

Trainieren Sie Ihren Roboterhund in Echtzeit mit Vision Pro! Das Open-Source-Projekt eines MIT-Doktoranden ist beliebt

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2024-03-12 21:40:02746Durchsuche

Vision Pro hat ein weiteres heißes neues Gameplay, dieses Mal ist es mit verkörperter Intelligenz verbunden~

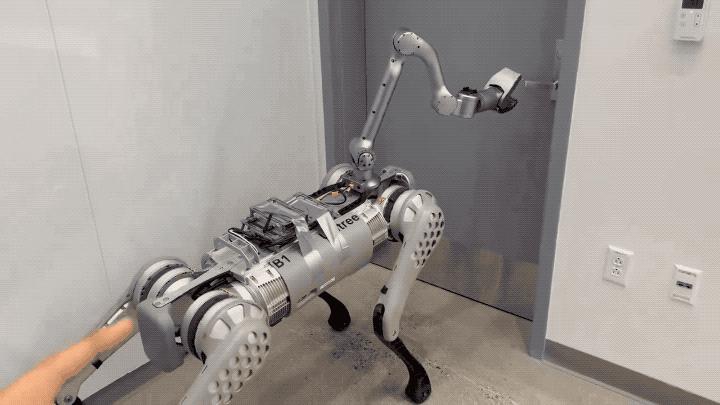

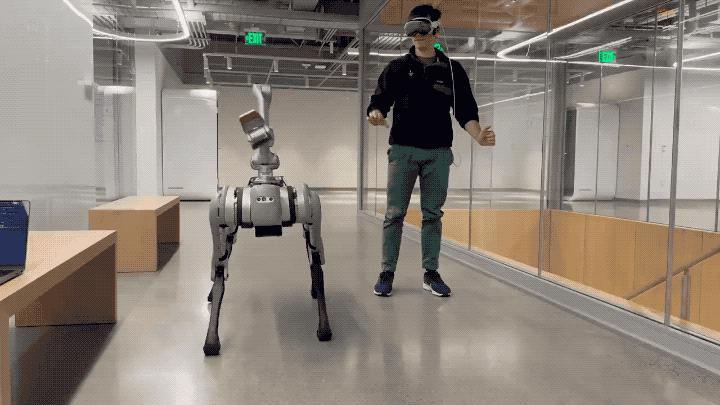

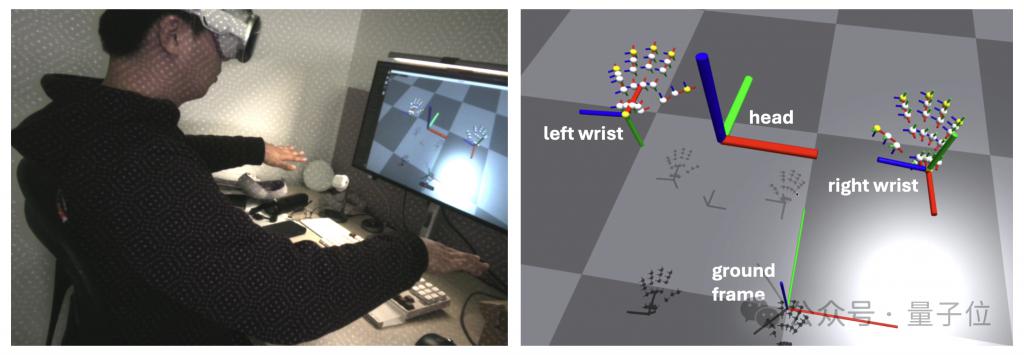

Einfach so nutzte der MIT-Typ die Handverfolgungsfunktion von Vision Pro, um erfolgreich eine Echtzeitsteuerung des Roboterhundes zu erreichen.

Aktionen wie das Öffnen einer Tür können nicht nur präzise erfolgen, es gibt auch nahezu keine Verzögerung.

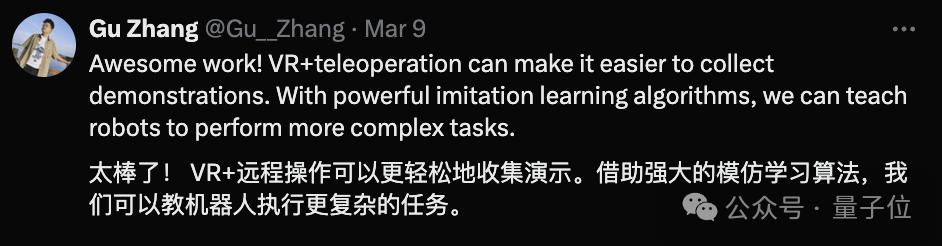

Sobald die Demo herauskam, lobten nicht nur Internetnutzer Goose Girl, sondern auch verschiedene verkörperte Intelligenzforscher waren begeistert.

Zum Beispiel dieser angehende Doktorand an der Tsinghua-Universität:

Manche sagen mutig voraus: So werden wir mit der nächsten Generation von Maschinen interagieren.

Werfen wir einen genaueren Blick auf die vom Autor entwickelte App – Tracking Steamer.

Werfen wir einen genaueren Blick auf die vom Autor entwickelte App – Tracking Steamer.

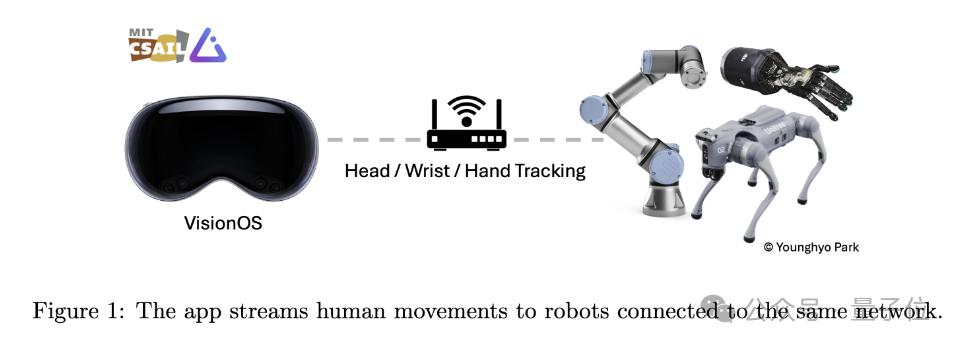

Wie der Name schon sagt, ist diese Anwendung darauf ausgelegt, mithilfe von Vision Pro menschliche Bewegungen zu verfolgen und diese Bewegungsdaten in Echtzeit an andere Robotergeräte über dasselbe WLAN zu übertragen.

Der Bewegungsverfolgungsteil basiert hauptsächlich auf der ARKit-Bibliothek von Apple.

Das Head-Tracking ruft queryDeviceAnchor auf. Benutzer können den Kopfrahmen auf seine aktuelle Position zurücksetzen, indem sie die Digital Crown gedrückt halten.

In Bezug auf die Netzwerkkommunikation verwendet diese App gRPC als Netzwerkkommunikationsprotokoll zum Streamen von Daten. Dadurch können Daten auf mehr Geräten abonniert werden, einschließlich Linux-, Mac- und Windows-Geräten.

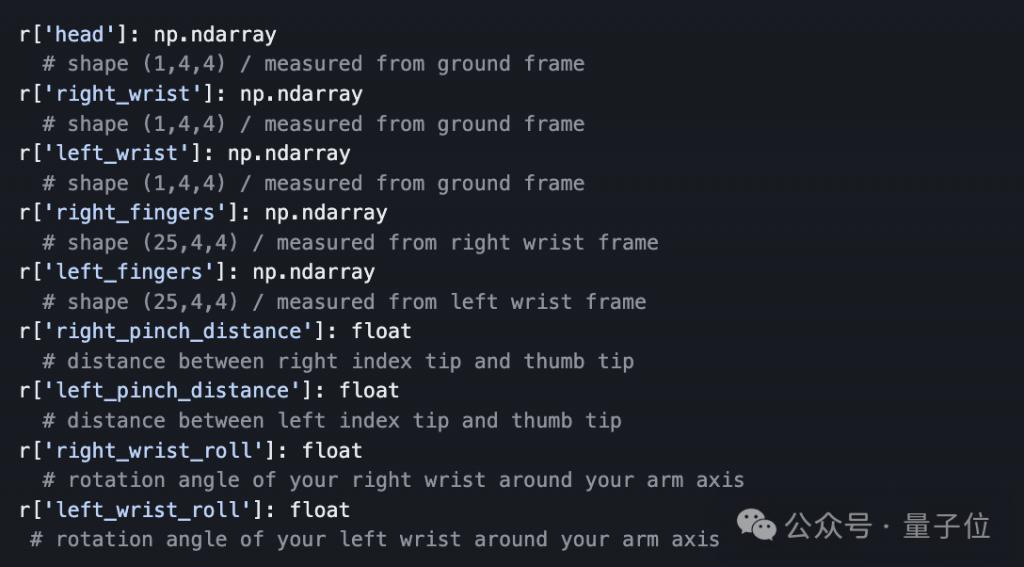

Um die Datenübertragung zu erleichtern, hat der Autor außerdem eine Python-API vorbereitet, die es Entwicklern ermöglicht, von Vision Pro gestreamte Tracking-Daten programmgesteuert zu abonnieren und zu empfangen.

Wie viele Fachleute betont haben, sind Menschen unabhängig davon, ob die Bewegungen des Roboterhundes immer noch von Menschen gesteuert werden, im Vergleich zur „Kontrolle“ selbst in Kombination mit dem Nachahmungslernalgorithmus in der Lage Dieser Prozess ist wie ein Robotertrainer.

Vision Pro bietet eine intuitive und einfache Interaktionsmethode, indem es die Bewegungen des Benutzers verfolgt und es Laien ermöglicht, genaue Trainingsdaten für Roboter bereitzustellen.

Das obige ist der detaillierte Inhalt vonTrainieren Sie Ihren Roboterhund in Echtzeit mit Vision Pro! Das Open-Source-Projekt eines MIT-Doktoranden ist beliebt. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Was ist der Unterschied zwischen Mac und Windows?

- So deinstallieren Sie Software auf dem Mac

- Habe eine Vision! Huawei hat vor vier Jahren die Marke Vision Pro angemeldet: Apple AR muss in China umbenannt werden

- Neue Funktionen enthüllt: Apple VisionOS Beta veröffentlicht „Reisemodus'

- So löschen Sie Zeichen in Meitu Xiuxiu