Heim >Technologie-Peripheriegeräte >IT Industrie >Intel Open-Source-NPU-Beschleunigungsbibliothek, Core-Ultra-Prozessor AI-PC kann leichte, große Sprachmodelle ausführen

Intel Open-Source-NPU-Beschleunigungsbibliothek, Core-Ultra-Prozessor AI-PC kann leichte, große Sprachmodelle ausführen

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2024-03-05 11:13:021437Durchsuche

Laut Nachrichten vom 4. März hat Intel kürzlich seine NPU-Beschleunigungsbibliothek auf GitHub veröffentlicht. Dieser Schritt ermöglicht es KI-PCs, die mit Core-Ultra-Prozessoren ausgestattet sind, leichte, große Sprachmodelle wie TinyLlama und Gemma-2b reibungsloser auszuführen.

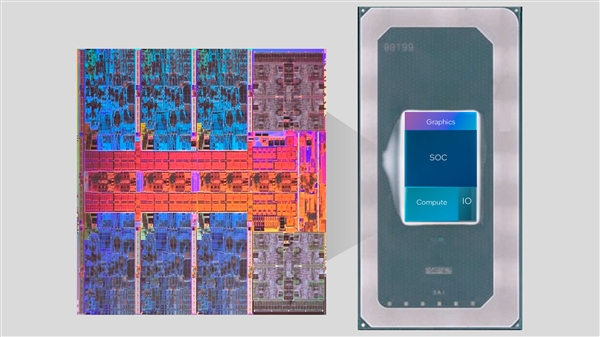

Die Core Ultra-Serie integriert zum ersten Mal die NPU-KI-Engine. Diese Engine kann einige leichte KI-Inferenzaufgaben bewältigen und mit der CPU und der GPU zusammenarbeiten, um die Anforderungen verschiedener KI-Anwendungen zu erfüllen.

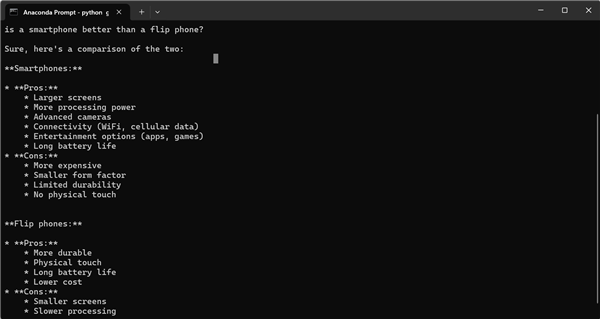

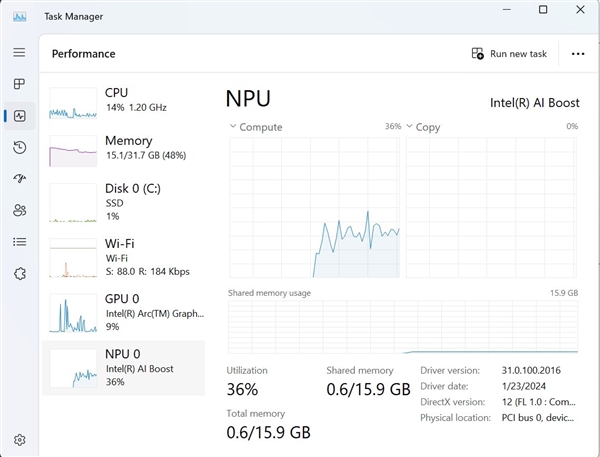

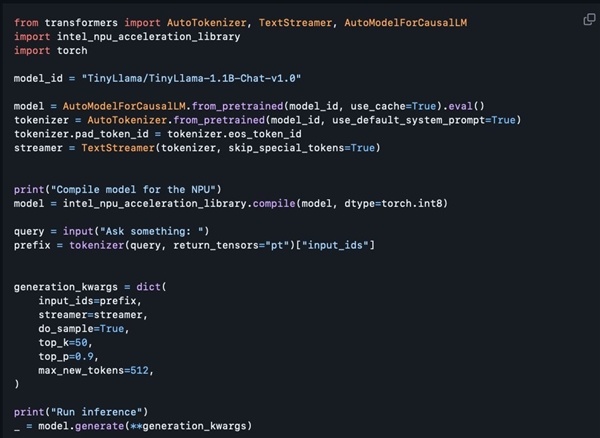

Es versteht sich, dass die diesmal veröffentlichte NPU-Beschleunigungsbibliothek zwar hauptsächlich für Entwickler gedacht ist, Benutzer mit gewisser Programmiererfahrung jedoch auch versuchen können, sie zu verwenden. Tony Mongkolsmai, ein Softwarearchitekt bei Intel, demonstrierte, wie man einen KI-Chatbot basierend auf dem 1,1 Milliarden Parameter umfassenden TinyLlama-Großmodell auf einem MSI Monarch 14 AI Evo-Laptop ausführt, der einfache Gespräche führen kann. Gleichzeitig zeigt der Windows Task-Manager auch gültige Aufrufe an die NPU an.

Die aktuelle Open-Source-NPU-Beschleunigungsbibliothek weist jedoch noch einige Funktionsmängel auf. Sie unterstützt 8-Bit-Quantisierung und FP16-Präzision, unterstützt jedoch noch keine erweiterten Funktionen wie 4-Bit-Quantisierung, BF16-Präzision und NPU /GPU-Hybrid-Computing und entsprechende technische Dokumentation wurden noch nicht bereitgestellt. Allerdings hat Intel versprochen, seine Funktionen in Zukunft schrittweise zu erweitern, wodurch die bestehenden Funktionen voraussichtlich verdoppelt werden, was den KI-Entwicklern zweifellos mehr Komfort und Möglichkeiten bringen wird.

Das obige ist der detaillierte Inhalt vonIntel Open-Source-NPU-Beschleunigungsbibliothek, Core-Ultra-Prozessor AI-PC kann leichte, große Sprachmodelle ausführen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Schritte zum Erstellen eines JavaWeb-Projekts mit IntelliJ IDEA auf einem Mac

- Grafische Einführung in die Verwendung von Debug in Intellij IDEA

- Der Unterschied zwischen Intel Core i7-8700 und 8700K

- Neuer Intel TSX-Fix für Linux-Kernel-Warteschlangen, erzwingt das Ausschalten des TSX-„Entwicklungsmodus'

- Was ist Intel TXT?