Heim >Technologie-Peripheriegeräte >KI >Elastische Containerinstanz der Volcano Engine: ein leistungsstarkes Tool für die Transformation von einer knotenzentrierten Architektur zu einer serverlosen Architektur

Elastische Containerinstanz der Volcano Engine: ein leistungsstarkes Tool für die Transformation von einer knotenzentrierten Architektur zu einer serverlosen Architektur

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2024-03-01 20:04:19614Durchsuche

Mit der zunehmenden Reife von Kubernetes und der Container-Technologie beginnen immer mehr Unternehmen, ihre Geschäftsanwendungen in die Cloud zu migrieren. Durch die Einführung einer Cloud-nativen Architektur können diese Unternehmen die schnelle Entwicklung und den stabilen Betrieb ihrer Unternehmen besser unterstützen.

Mit der tiefgreifenden Entwicklung von Cloud Computing in den Entwicklungsprozess hat die Reife der Serverless-Architektur die Cloud-native-Technologie auf eine neue Stufe gebracht – Serverless hat die elastische Skalierbarkeit, betriebsfreie Wartung, schnellen Zugriff und mehr der öffentlichen Cloud maximiert Funktionen, die die Kosten für die Benutzernutzung erheblich reduzieren, ermöglichen es Benutzern und Unternehmen, sich nur auf ihre Geschäftslogik zu konzentrieren und eine agile Entwicklung im wahrsten Sinne des Wortes zu erreichen.

Um Unternehmen besser bei der Implementierung des neuen Cloud-Native-Konzepts von Serverless in Geschäftsanwendungen zu unterstützen, aktualisiert und innoviert das Cloud-Native-Team von Volcano Engine Produkte umfassend und deckt dabei viele Aspekte wie Konzept, Systemdesign und Architekturdesign ab. Sie sind bestrebt, die Vorteile und den Wert der serverlosen Technologie voll auszuschöpfen, um Unternehmen dabei zu helfen, Geschäftsanwendungen effizienter auszuführen.

Vom Knotenzentrum zur serverlosen Architektur

Die traditionelle Kubernetes-Architektur verwendet normalerweise Knoten als Kern, was bedeutet, dass das Team Cluster auf Ressourcenknoten wie Cloud-Servern aufbauen und das Betriebs- und Wartungsmanagement durchführen muss um diese Knoten herum. Die traditionelle Kubernetes-Cluster-Architektur erfordert die Verwaltung der Bereitstellung, Überwachung und Wartung von Containeranwendungen auf verschiedenen Knoten. Dieser Ansatz erfordert mehr Personal und Zeitaufwand, um die Stabilität und Zuverlässigkeit des gesamten Clusters aufrechtzuerhalten. Mit der Entwicklung der Technologie ist jedoch eine neue Art von Kubernetes-Architektur entstanden, nämlich eine auf Service Mesh basierende Architektur. In einer auf einem Service-Grid basierenden Architektur werden Netzwerkfunktionen durch spezialisierte Service-Grid-Komponenten abstrahiert und vereinheitlicht. Mit zunehmender Geschäftsgröße und zunehmender Anzahl von Knoten ist diese Architektur bei der Bereitstellung und dem Betrieb von Containeranwendungen weniger effektiv Einige Herausforderungen, hauptsächlich einschließlich der folgenden Aspekte:

- Komplexer Knotenbetrieb und -wartung

- : Benutzer müssen Knoten selbst verwalten und warten, einschließlich Knotenkonfiguration und -initialisierung, Betriebssystemaktualisierungen und -aktualisierungen, Sicherheitsmanagement, komplexer und langwieriger Knotenbetrieb Betriebs- und Wartungsarbeiten wie Überwachung und Protokollerfassung und -analyse, Fehlerbeseitigung, Netzwerkverwaltung, Speicherverwaltung, -erweiterung und -verkleinerung, Ressourcenplanung und -zuweisung sowie Ressourcenkostenmanagement Geringe Ressourcenauslastung

- : Knotenreservierung Feste Ressourcen, sogar Wenn die tatsächliche Arbeitslast weniger Ressourcen erfordert, ist die Fragmentierungsrate der Knotenressourcen hoch, und einige ungenutzte Ressourcen, die auf verschiedene Knoten verteilt sind, können nicht vollständig genutzt werden, um eine Überlastung zu vermeiden Engpässe, Ressourcen werden oft entsprechend der maximalen Auslastung geplant. Es ist schwierig, den tatsächlichen Bedarf vorherzusagen und kann zu einer großen Menge ungenutzter Ressourcen führen. Auf erhöhte Belastung reagieren. In der herkömmlichen knotenzentrierten Architektur erfordert die Erweiterung der Rechenressourcen häufig die Erstellung und Konfiguration neuer Cloud-Serverknoten. Dieser Vorgang kann mehrere Minuten dauern und kann nicht sofort erweitert werden. Volcan Engine

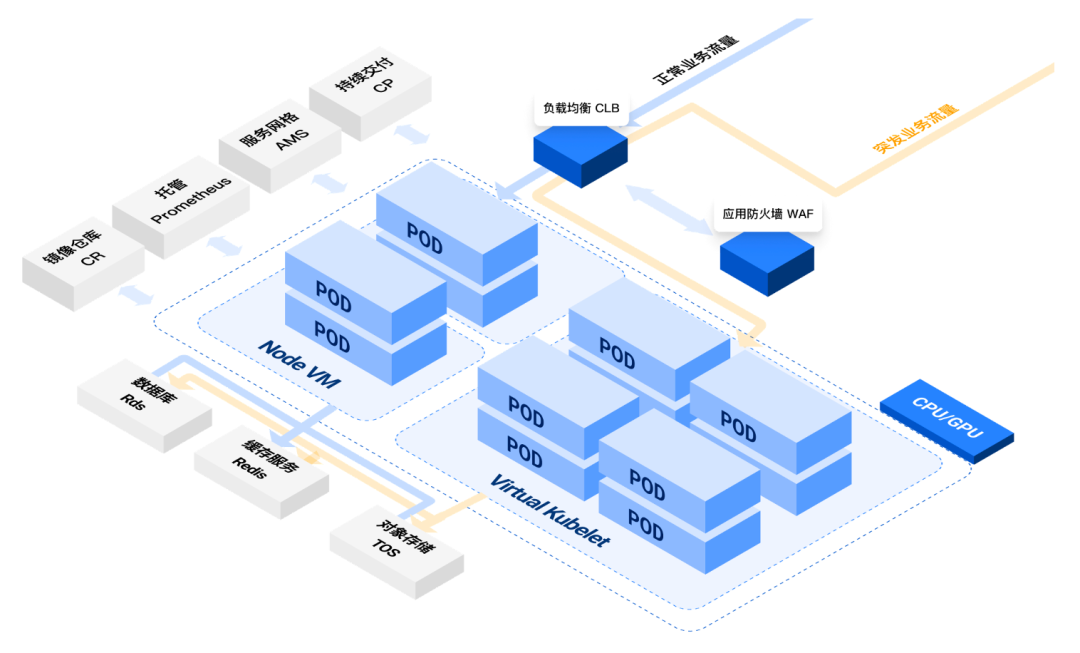

- Elastic Container Instance (Volcengine Container Instance, kurz VCI genannt) ist eine neue cloudnative Lösung, die für die oben genannte Situation eingeführt wurde. Sie ist seit vielen Jahren von der Cloud-nativen Technologiesammlung innerhalb von ByteDance abstrahiert und serverlos und Container-Lösung. Die elastische Container-Instanz VCI ist über die Virtual Kubelet-Technologie eng in den Volcano Engine-Container-Service VKE integriert und kann Benutzern flexible Computing- und Kubernetes-Orchestrierungsfunktionen bieten, die einen schnellen Start, eine hohe Parallelitätserstellung und eine sichere Sandbox unterstützen Containerisolierung.

Durch die Integration der Vorteile von Serverless und Containern kann Elastic Container Instance (VCI) Unternehmen eine effiziente, zuverlässige und sichere Betriebsumgebung bieten, sodass sich Benutzer auf die Entwicklung und Ausführung cloudnativer Architekturanwendungen konzentrieren können, ohne sich um die zugrunde liegende Infrastruktur kümmern zu müssen. Verwaltung und Wartung sowie die Zahlung nur der Ressourcen, die für den tatsächlichen Geschäftsbetrieb erforderlich sind, helfen Unternehmen, die Cloud-Kosten besser zu kontrollieren.

Kein Betrieb und Wartung der Infrastruktur, keine Planung von RechenressourcenIn der traditionellen selbst erstellten Kubernetes-Cluster-Architektur, unabhängig davon, ob es sich um die Steuerungsebene oder die Datenebene handelt, als Träger für die Ausführung des Containergruppen-Pods, Die Knoten befinden sich im Kern der Kubernetes-Architektur. Wenn die Rechenressourcen der Knoten nicht ausreichen, müssen die Rechenressourcen durch das Hinzufügen von Knoten ergänzt werden, um die Bereitstellung oder Erweiterung von Geschäftsarbeitslasten zu unterstützen.

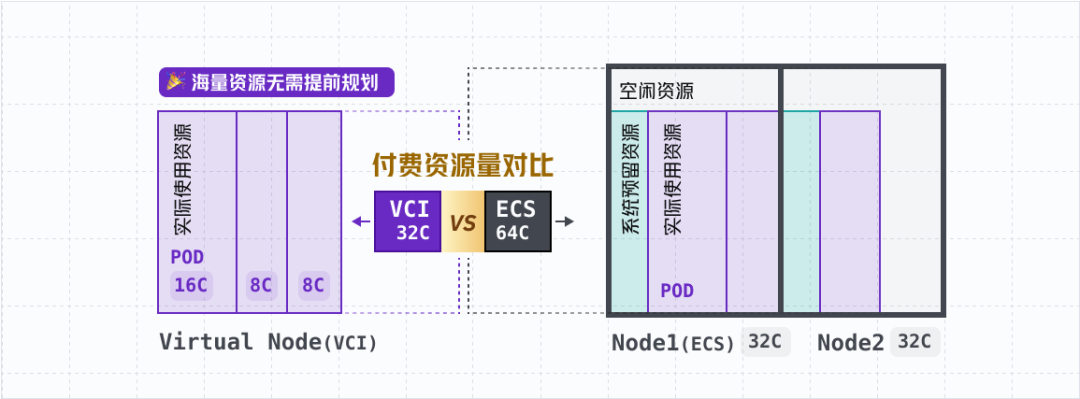

In der Cloud werden verschiedene verwaltete Kubernetes-Dienste, die von Volcano Engine Container Service VKE vertreten werden, Benutzer bei der Verwaltung und dem Betrieb der Kubernetes-Steuerungsebene ersetzen und verwaltete Dienste mit SLA-Garantien bereitstellen. Für die Datenebene, auf der die tatsächlichen Geschäftsarbeitslasten der Benutzer ausgeführt werden, müssen Benutzer normalerweise Arbeitsknoten selbst betreiben und warten, und die von den Knoten bereitgestellten Rechenressourcen müssen im Voraus entsprechend den Geschäftsmerkmalen geplant werden, wenn beispielsweise Geschäftsspitzen erforderlich sind Expansion vorantreiben, Geschäftsabschwünge erfordern eine Verkleinerung. Daher erfordert der Knotenbetrieb und die Wartung in der traditionellen knotenzentrierten Kubernetes-Architektur häufig gleichzeitig viel Energie vom technischen Team, und es ist auch zu einem Problem geworden, die Frage der fortgeschrittenen Ressourcenplanung und der Ressourcenkosten in Einklang zu bringen für Unternehmen, die in die Ära der „Verfeinerten Cloud-Nutzung“ eintreten. Fragen, über die ich später nachdenken muss. Elastic Container Instance VCI bietet serverlose und Container-Computing-Dienste. Jedes VCI stellt nur die Betriebsumgebung und die Computing-Ressourcen für einen einzelnen Pod bereit. Benutzer müssen sich nicht um den Betrieb, die Wartung und die Kapazitätsplanung der zugrunde liegenden Knoten kümmern Sie müssen Containeranwendungen nach Bedarf bereitstellen. Wenn Sie VCI zum Bereitstellen von Containeranwendungen verwenden, können Sie die native Kubernetes-Semantik verwenden, die sich nicht von der Node-Center-Architektur unterscheidet. Auf Ressourcenebene nutzt die elastische Containerinstanz VCI die Computing-Infrastruktur von Volcano Engine als Ressourcenpool, um Container-Computing-Ressourcen mehrerer Ressourcentypen bereitzustellen und Benutzern die flexible Auswahl entsprechend den Geschäftsanforderungen zu erleichtern. Gleichzeitig müssen Benutzer sich nicht um Probleme bei der Ressourcenkapazitätsplanung kümmern. VCI stellt enorme Rechenressourcen bereit und verursacht keine Phänomene wie Pod-Drift und Neuplanung, die in herkömmlichen knotenzentrierten Architekturen üblich sind und weitere Dienstunterbrechungen verursachen , Leistungsschwankungen, Probleme wie Dateninkonsistenz und Planungsverzögerungen. Schließlich realisiert die nahtlose Integration des Container-Dienstes VKE und der elastischen Container-Instanz VCI nicht nur das vollständige Hosting der Kubernetes-Cluster-Steuerungsebene, sondern bietet Benutzern auch serverloses vollständiges Hosting und kostenlosen Betrieb der Datenebene (d. h. der elastischen Container-Instanz VCI). Durch Wartung und Sicherheitsisolation werden die Betriebs- und Wartungskosten der Kubernetes-Infrastruktur erheblich reduziert und die Komplexität der Kapazitätsplanung beseitigt, sodass sich Benutzer mehr auf ihre Geschäftsanwendungen konzentrieren können. Ultimative Elastizität, Sie bekommen, was Sie brauchen Flexibel und sparen Laut den von Flexera im „2022 Cloud State Report“ veröffentlichten Umfragedaten haben die befragten Unternehmen selbst eingeschätzt, dass die Kostenverschwendung in der Cloud 32 % erreicht hat. „Kosten“ ist seit drei Jahren zu einer der größten Cloud-Herausforderungen für Unternehmen geworden – der „verfeinerten Cloud-Nutzung“ wird von Unternehmen immer mehr Aufmerksamkeit geschenkt ein Unternehmen Eine wichtige Herausforderung, die bei der Nutzung der Cloud gelöst werden muss. Elastic Container Instance VCI hat sich von Beginn des Produktdesigns an auf die Anforderungen des Unternehmens an die „Cloud-Kostenkontrolle“ konzentriert und dabei Wert auf eine verfeinerte Abrechnung basierend auf der tatsächlich genutzten Ressourcenmenge gelegt, mehrere Abrechnungsmodelle unterstützt und Unternehmen dabei geholfen, die Cloud-Kosten wirklich sinnvoll zu nutzen Wolke. Verfeinerte Abrechnung: Elastic Container Instance VCI wird entsprechend den tatsächlich von der Benutzercontainergruppe (Pod) genutzten Ressourcen abgerechnet. Die Abrechnungsressourcen umfassen vCPU, Speicher, GPU usw. Gleichzeitig ist die Abrechnungszeit der VCI-Instanz ihre Laufzeit, also die Zeit, die der Benutzer-Pod vom Herunterladen des Container-Images bis zum Stoppen der Ausführung benötigt. Sie ist bis zur zweiten Ebene genau und realisiert tatsächlich eine Abrechnung basierend auf der tatsächlichen Nutzung . Verbesserung der Packrate: In der Cloud-nativen Architektur besteht ein weiterer Vorteil von elastischen Containerinstanzen im Vergleich zu herkömmlichen Rechenressourcen darin, ungenutzte Ressourcen zu reduzieren und die Packrate zu erhöhen, wodurch die Kosten für die Nutzung der Rechenressourcen des Benutzers gesenkt werden. Insbesondere wenn ein Kubernetes-Cluster Cloud-Server-ECS als Arbeitsknoten verwendet, muss er die von Kubernetes benötigten Systemkomponenten auf dem Knoten ausführen. Daher müssen einige Rechenressourcen reserviert werden, und es fallen gewisse zusätzliche Kosten an Als Rechenressource wird die Containerinstanz VCI verwendet. Sie müssen nur für die tatsächlich von den Business-Pods genutzten Ressourcen bezahlen: Kann gespielt werden Elastic Container Instance VCI integriert die Rechenressourcen-Infrastruktur von Volcano Engine vollständig für die Rechenleistungsversorgung und bietet eine Vielzahl von Instanzspezifikationsfamilien, die Benutzer basierend auf unterschiedlichen zugrunde liegenden Hardwarefunktionen auswählen können, wodurch differenzierte Rechen-, Speicher- und Netzwerkleistung bereitgestellt und Cover unterstützt werden eine Vielzahl von Geschäftsanwendungen und Serviceszenarien. CPU Allzweck-Spezifikationsfamilie: Zum Beispiel der Allzweck-Computing-Typ u1, der Allzweck-N3i usw., die ausgewogene vCPU-, Speicher- und Netzwerkfunktionen bieten, um die Serviceanforderungen in den meisten Szenarien zu erfüllen. GPU Computing-Typ-Spezifikationsfamilie: wie GPU-Computing-Typ gni2 (ausgestattet mit NVIDIA A10-GPU-Grafikkarte), GPU-Computing-Typ g1v (ausgestattet mit NVIDIA V100-GPU-Grafikkarte) usw., die verwendet werden können Großes Modelltraining, Text- und Bildgenerierung, Aufgaben Bietet eine kostengünstige Erfahrung in verschiedenen KI-Computing-Szenarien wie Argumentation. Der neueste allgemeine Computertyp u1 Instanzspezifikationsfamilie basiert auf der Volcano Engine-Ressourcenpooling-Technologie und dem intelligenten Planungsalgorithmus für dynamisches Ressourcenmanagement, die Unternehmen eine stabile Versorgung mit Rechenleistung bieten und eine Vielzahl von unterstützen können Verarbeitung Flexibles Verhältnis von Prozessor und Prozessorspeicher, von feinkörnigen kleinen Spezifikationen wie 0,25C-0,5Gi, 0,5C-1Gi, 1C-2Gi bis hin zu großen Spezifikationen wie 24C-48Gi, 32C-256Gi usw. mit extrem hohen Gutes Preis-Leistungs-Verhältnis! Unterstützt durch ein riesiges Angebot an Rechenressourcen bietet Elastic Container Instance VCI Benutzern auch eine branchenführende Elastische Ressourcenprioritätsplanungsstrategie: In Kombination mit dem Containerdienst VKE unterstützen wir Benutzer bei der Verwendung benutzerdefinierter Ressourcenrichtlinien (ResourcePolicy) für eine elastische Planung an verschiedene Arten von Computerressourcenpools wie Cloud-Server ECS, elastische Containerinstanzen VCI usw. sowie Planung und Zuweisung gemäß prozentualen Schwellenwerten, Prioritätskontrolle und anderen Strategien gemäß tatsächlichen Geschäftsszenarien. Das bedeutet, dass Benutzer den ECS-Rechenressourcenpool des Cloud-Servers und den VCI-Rechenressourcenpool der elastischen Containerinstanz kombinieren können, um gleichzeitig riesige Rechenressourcen der Volcano Engine zu nutzen, kombiniert mit der Cluster-Autoscaler-Funktion und VCI im Container-Cluster. Sogar der Container-Cluster Ohne sich im Voraus um Rechenressourcen zu bewerben, können Benutzer zeitnah elastische Ressourcen erhalten, um Geschäftsanwendungen effizient zu unterstützen. Schnelle Sprungkraft Angesichts unvorhersehbarer Geschäftsverkehrsspitzen in Online-Unternehmen ist es von entscheidender Bedeutung, in kritischen Momenten der Geschäftsentwicklung einen stabilen Geschäftsbetrieb und ein stabiles Benutzererlebnis sicherzustellen Geschäftsanwendungen schnell aktivieren. Für diese Szenarien eignen sich natürlich auch Elastic-Container-Instanzen. Einerseits kann die elastische Fähigkeit der Volcano Engine Elastic Container Instance (VCI) den Bedarf an Zehntausenden Kernen pro Minute vCPU-Rechenressourcen decken und so sicherstellen, dass ausreichend Rechenressourcen schnell ausgeworfen werden können wenn das Geschäft es braucht. Wenn die Verkehrsspitze vorbei ist und die Arbeitslast des Unternehmens abnimmt, können elastische Rechenressourcen schnell freigegeben werden, wodurch die Cloud-Kosten wirtschaftlicher werden. Andererseits dauert das Ziehen von Containerbildern oft lange, was noch schwerwiegender ist, wenn große Pods gleichzeitig gestartet werden. Die elastische Containerinstanz VCI verfügt nicht nur über eine Vielzahl von Container-Image-Beschleunigungsfunktionen, die von VKE bereitgestellt werden, wie z. B. verzögertes Laden von Container-Images, P2P-Container-Image-Verteilung usw., sondern auch über einzigartige Beschleunigungsfunktionen, wie z. B. Caching-Funktionen für Container-Images Laut tatsächlichen Testdaten kann das Container-Image-Caching die Gesamtstartzeit von Pods mit Container-Images (Datenvolumen innerhalb von 100 G) auf das Niveau von zehn Sekunden steuern und so den Benutzern helfen, die Effizienz erheblich zu verbessern und die Cloud-Kosten zu senken. Fazit Seit seiner offiziellen Einführung im Jahr 2022 hat Elastic Container Instance VCI viele große und mittlere Unternehmenskunden bedient und wurde in den internen und externen Geschäftsszenarien von ByteDance vollständig getestet. Das Cloud-native-Team von Volcano Engine verbessert außerdem kontinuierlich die Produktfähigkeiten basierend auf der Erfahrung im Kundenservice und verbessert weiterhin die Qualität und Stabilität der Produktdienstleistungen: Mit Blick auf 2024 wird sich Elastic Container Instance VCI im Rahmen der Produktarchitektur und -form von Serverless Kubernetes weiter verbessern und erforschen, um mehr internen und externen Kunden serverlose Containerprodukte bereitzustellen, die keinen Betrieb und keine Wartung der Infrastruktur, keine Planung von Rechenressourcen usw. erfordern extreme Flexibilität und Dienste zur besseren Unterstützung der verschiedenen GPU- und CPU-Rechenleistungsanforderungen der Kunden in Geschäftsszenarien wie AIGC, wissenschaftlichem Rechnen in der Bioinformatik und sozialem E-Commerce.

Das obige ist der detaillierte Inhalt vonElastische Containerinstanz der Volcano Engine: ein leistungsstarkes Tool für die Transformation von einer knotenzentrierten Architektur zu einer serverlosen Architektur. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Tesla plant die Errichtung einer Elektrofahrzeugfabrik in Indien, um die indische Elektrofahrzeugindustrie anzukurbeln

- Ronglian Cloud wurde in die Global Generative AI Industry Map 2023 aufgenommen

- Die Nachfrage nach KI-Rechenleistung ist stark gestiegen, und Shanghai Lingang wird eine Rechenleistungsindustrie im zweistelligen Milliardenbereich aufbauen

- Anwendung vertrauenswürdiger Computertechnologie im Bereich der industriellen Sicherheit

- Inländische humanoide Allzweckroboter werden auf den Markt kommen und die Branche wird Durchbrüche beschleunigen