Technologie-Peripheriegeräte

Technologie-Peripheriegeräte KI

KI Neues Werk des Autors von ControlNet: KI-Malerei kann in Ebenen unterteilt werden! Das Projekt erhielt 660 Sterne, ohne Open Source zu sein

Neues Werk des Autors von ControlNet: KI-Malerei kann in Ebenen unterteilt werden! Das Projekt erhielt 660 Sterne, ohne Open Source zu sein„Es ist keineswegs ein einfacher Ausschnitt.“

ControlNet-Autor Die neueste Forschung hat eine Welle hoher Aufmerksamkeit erhalten –

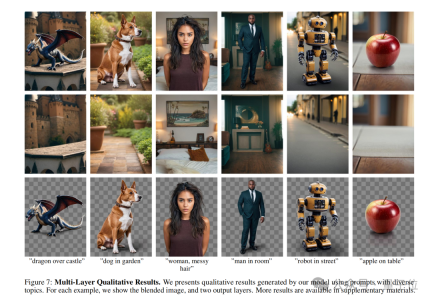

Geben Sie mir eine Aufforderung, Sie können Stable Diffusion verwenden, um direkt einzelne oder mehrere zu generieren transparente Ebenen (PNG) !

Zum Beispiel:

Eine Frau mit unordentlichen Haaren im Schlafzimmer.

Frau mit unordentlichen Haaren, im Schlafzimmer.

Sie können sehen, dass die KI nicht nur ein vollständiges Bild erzeugt hat, das der Eingabeaufforderung entspricht, sondern sogar der Hintergrund und die Zeichen können getrennt werden.

Und wenn Sie das Charakter-PNG-Bild vergrößern und genauer betrachten, können Sie erkennen, dass die Haarsträhnen klar definiert sind.

Schauen Sie sich ein anderes Beispiel an:

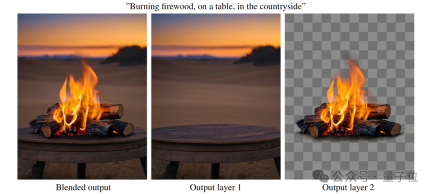

Brennendes Brennholz, auf einem Tisch, auf dem Land.

Brennendes Brennholz, auf einem Tisch, auf dem Land.

In ähnlicher Weise kann durch Vergrößern des PNG des „brennenden Streichholzes“ sogar der schwarze Rauch um die Flamme herum abgetrennt werden:

Das ist das Autor von ControlNet Die vorgeschlagene neue Methode LayerDiffusion ermöglicht es groß angelegten vorab trainierten latenten Diffusionsmodellen, transparente Bilder zu erzeugen.

Es lohnt sich noch einmal zu betonen, dass LayerDiffusion keineswegs so einfach ist wie das Ausschneiden von Bildern, der Fokus liegt auf der Generierung.

Wie Internetnutzer sagten:

Dies ist heutzutage einer der Kernprozesse in der Animations- und Videoproduktion. Wenn dieser Schritt bestanden werden kann, kann man sagen, dass die SD-Konsistenz kein Problem mehr darstellt.

Einige Internetnutzer dachten, dass eine solche Arbeit nicht schwierig sei, es gehe nur darum, „übrigens einen Alphakanal hinzuzufügen“, aber was ihn überraschte, war:

Es dauerte so lange, bis die Ergebnisse herauskamen.

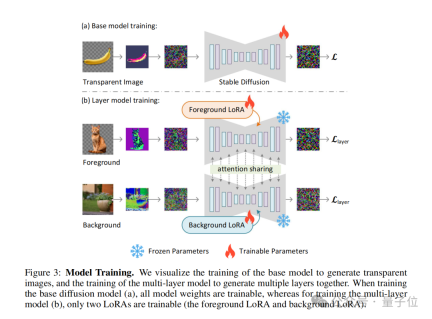

Wie wird LayerDiffusion implementiert?

PNG beginnt nun mit der Erzeugungsroute

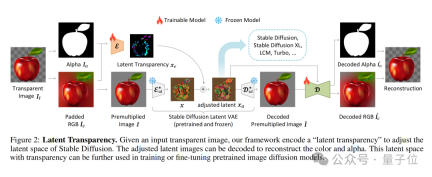

Der Kern von LayerDiffusion ist eine Methode namens latente Transparenz(latente Transparenz).

Einfach ausgedrückt ermöglicht es das Hinzufügen von Transparenz zum Modell, ohne die latente Verteilung des vorab trainierten latenten Diffusionsmodells (z. B. Stable Diffusion) zu zerstören.

In Bezug auf die konkrete Implementierung kann es als Hinzufügen einer sorgfältig entworfenen kleinen Störung (Offset) zum latenten Bild verstanden werden. Diese Störung wird als zusätzlicher Kanal codiert, der zusammen mit dem RGB-Kanal ein vollständiges latentes Bild darstellt.

Um die Kodierung und Dekodierung von Transparenz zu erreichen, hat der Autor zwei unabhängige neuronale Netzwerkmodelle trainiert: eines ist der Latent-Transparenz-Encoder(Latent-Transparenz-Encoder) und das andere ist der Latent-Transparenz-Decoder(Latent Transparenzdecoder).

Der Encoder empfängt den RGB-Kanal und den Alpha-Kanal des Originalbilds als Eingabe und wandelt die Transparenzinformationen in einen Offset im latenten Raum um.

Der Decoder empfängt das angepasste latente Bild und das rekonstruierte RGB-Bild und extrahiert die Transparenzinformationen aus dem latenten Raum, um das ursprüngliche transparente Bild zu rekonstruieren.

Um sicherzustellen, dass die zusätzliche potenzielle Transparenz die zugrunde liegende Verteilung des vorab trainierten Modells nicht zerstört, schlagen die Autoren eine „Harmlosigkeit“-Metrik (Harmlosigkeit) vor.

Diese Metrik bewertet die Auswirkung der latenten Transparenz, indem sie die Decodierungsergebnisse des angepassten latenten Bildes durch den Decoder des ursprünglichen vorab trainierten Modells mit dem Originalbild vergleicht.

Während des Trainingsprozesses verwendet der Autor auch eine Gelenkverlustfunktion (Gelenkverlustfunktion) , die Rekonstruktionsverlust (Rekonstruktionsverlust) , Identitätsverlust (Identitätsverlust) und Diskriminatorverlust (Diskriminatorverlust) kombiniert ).

Ihre Funktionen sind:

- Rekonstruktionsverlust: wird verwendet, um sicherzustellen, dass das dekodierte Bild dem Originalbild so ähnlich wie möglich ist;

- Identitätsverlust: wird verwendet, um sicherzustellen, dass das angepasste latente Bild vom Vorbild korrekt dekodiert werden kann; trainierter Decoder ;

- Diskriminatorverlust: Wird verwendet, um den Realismus des erzeugten Bildes zu verbessern.

Mit diesem Ansatz kann jedes latente Diffusionsmodell in einen transparenten Bildgenerator umgewandelt werden, indem es einfach an den angepassten latenten Raum angepasst wird.

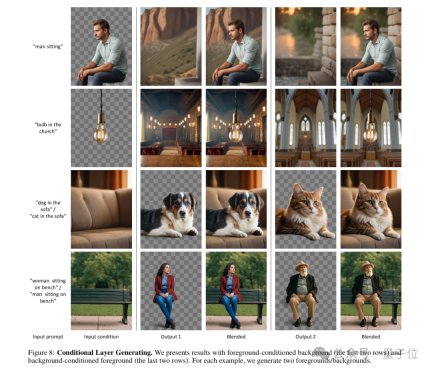

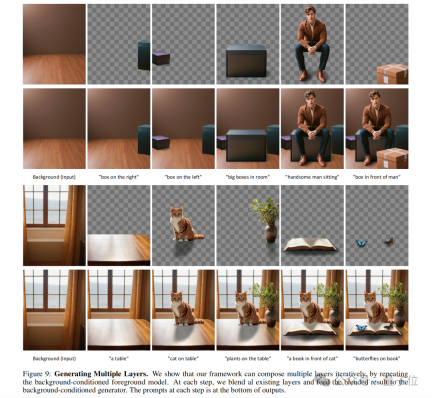

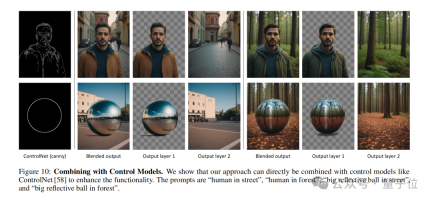

Das Konzept der latenten Transparenz kann auch erweitert werden, um mehrere transparente Ebenen zu generieren, und mit anderen bedingten Kontrollsystemen kombiniert werden, um komplexere Bildgenerierungsaufgaben zu erfüllen, wie z. B. die Generierung von Vordergrund-/Hintergrundbedingungen, die Generierung gemeinsamer Ebenen und die Inhaltsstruktur von Ebenen Kontrolle usw. Es ist erwähnenswert, dass der Autor auch zeigt, wie man ControlNet einführt, um die Funktionen von LayerDiffusion zu bereichern: in den folgenden Punkten zusammengefasst werden.

Native Generierung vs. Nachbearbeitung

Native Generierung vs. Nachbearbeitung

LayerDiffusion ist eine native Methode zur Generierung transparenter Bilder, die Transparenzinformationen direkt während des Generierungsprozesses berücksichtigt und kodiert. Das bedeutet, dass das Modell beim Generieren des Bildes einen Alphakanal  erstellt und so ein Bild mit Transparenz erzeugt.

erstellt und so ein Bild mit Transparenz erzeugt.

Traditionelle Ausschnittmethoden umfassen in der Regel zunächst das Erzeugen oder Erhalten eines Bildes und das anschließende Trennen von Vorder- und Hintergrund mithilfe von Bildbearbeitungstechniken

(z. B. Chroma Key, Kantenerkennung, benutzerdefinierte Masken usw.). Dieser Ansatz erfordert häufig zusätzliche Schritte zur Handhabung der Transparenz und kann bei komplexen Hintergründen oder Kanten zu unnatürlichen Übergängen führen.

Latente Raumoperationen vs. Pixelraumoperationen

LayerDiffusion arbeitet im latenten Raum (latenter Raum), einer Zwischendarstellung, die es dem Modell ermöglicht, komplexere Bildmerkmale zu lernen und zu generieren. Durch die Kodierung der Transparenz im latenten Raum kann das Modell die Transparenz während der Generierung auf natürliche Weise verarbeiten, ohne dass komplexe Berechnungen auf Pixelebene erforderlich sind.

Traditionelle Ausschnitttechnologie wird normalerweise im Pixelraum durchgeführt, was eine direkte Bearbeitung des Originalbildes beinhalten kann, wie z. B. Farbersetzung, Kantenglättung usw. Bei diesen Methoden kann es zu Schwierigkeiten bei der Handhabung durchscheinender Effekte (z. B. Feuer, Rauch) oder komplexer Kanten kommen.

Datensatz und Training

LayerDiffusion verwendet für das Training einen großen Datensatz, der transparente Bildpaare enthält, sodass das Modell die komplexe Verteilung erlernen kann, die zum Generieren hochwertiger transparenter Bilder erforderlich ist.

Herkömmliche Mattierungsmethoden stützen sich möglicherweise auf kleinere Datensätze oder spezifische Trainingssätze, was ihre Fähigkeit zur Bewältigung verschiedener Szenarien einschränken kann.

Flexibilität und Kontrolle

LayerDiffusion bietet mehr Flexibilität und Kontrolle, da es dem Benutzer ermöglicht, die Generierung von Bildern durch Textaufforderungen zu steuern und mehrere Ebenen generieren kann, die gemischt und kombiniert werden können, um komplexe Szenen zu erstellen.

Herkömmliche Ausschneidemethoden haben möglicherweise eine eingeschränktere Kontrolle, insbesondere wenn es um komplexe Bildinhalte und Transparenz geht.Qualitätsvergleich

Benutzeruntersuchungen zeigen, dass von LayerDiffusion generierte transparente Bilder in den meisten Fällen von Benutzern bevorzugt werden(97 %) , was darauf hindeutet, dass der generierte transparente Inhalt optisch mit kommerziellen transparenten Assets vergleichbar und möglicherweise sogar besser ist .

Herkömmliche Ausschneidemethoden erzielen in manchen Fällen möglicherweise nicht die gleiche Qualität, insbesondere bei schwierigen Transparenzen und Kanten. Alles in allem bietet LayerDiffusion eine fortschrittlichere und flexiblere Methode zum Generieren und Verarbeiten transparenter Bilder. Es kodiert Transparenz direkt während des Generierungsprozesses und ist in der Lage, qualitativ hochwertige Ergebnisse zu erzielen, die mit herkömmlichen Ausschnittmethoden nur schwer zu erreichen sind. Über den AutorWie wir gerade erwähnt haben, ist einer der Autoren dieser Studie der Erfinder des berühmten ControlNet –Zhang Lumin.

Er schloss sein Bachelor-Studium an der Universität Suzhou ab. Als Student im ersten Jahr veröffentlichte er zehn hochkarätige Arbeiten. Zhang Lumin studiert derzeit an der Stanford University für seinen Doktortitel, aber man kann sagen, dass er sehr zurückhaltend ist und sich noch nicht einmal bei Google Scholar registriert hat.

Das obige ist der detaillierte Inhalt vonNeues Werk des Autors von ControlNet: KI-Malerei kann in Ebenen unterteilt werden! Das Projekt erhielt 660 Sterne, ohne Open Source zu sein. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

KI -Therapeuten sind hier: 14 bahnbrechende Instrumente für psychische Gesundheit, die Sie wissen müssenApr 30, 2025 am 11:17 AM

KI -Therapeuten sind hier: 14 bahnbrechende Instrumente für psychische Gesundheit, die Sie wissen müssenApr 30, 2025 am 11:17 AMObwohl es nicht die menschliche Verbindung und Intuition eines ausgebildeten Therapeuten herstellen kann, hat die Forschung gezeigt, dass viele Menschen sich wohl fühlen, wenn sie ihre Sorgen und Bedenken mit relativ gesichtslosen und anonymen AI -Bots teilen. Ob dies immer ein gutes Ich ist

Rufen Sie die KI zum Lebensmittelgang anApr 30, 2025 am 11:16 AM

Rufen Sie die KI zum Lebensmittelgang anApr 30, 2025 am 11:16 AMKünstliche Intelligenz (KI), eine Technologie -Jahrzehnte in der Herstellung, revolutioniert die Lebensmitteleinzelhandel. Von groß angelegten Effizienzgewinnen und Kostensenkungen bis hin zu optimierten Prozessen über verschiedene Geschäftsfunktionen hinweg sind die Auswirkungen von AI unzählig

PEP -Gespräche von generativen KI erhalten, um Ihren Geist zu hebenApr 30, 2025 am 11:15 AM

PEP -Gespräche von generativen KI erhalten, um Ihren Geist zu hebenApr 30, 2025 am 11:15 AMReden wir darüber. Diese Analyse eines innovativen KI -Durchbruchs ist Teil meiner laufenden Forbes -Säulenberichterstattung über die neueste in der KI, einschließlich der Identifizierung und Erklärung verschiedener wirksamer KI -Komplexitäten (siehe Link hier). Außerdem für meinen Comp comp

Warum AI-betriebene Hyperpersonalisierung ein Muss für alle Unternehmen istApr 30, 2025 am 11:14 AM

Warum AI-betriebene Hyperpersonalisierung ein Muss für alle Unternehmen istApr 30, 2025 am 11:14 AMDie Aufrechterhaltung eines professionellen Images erfordert gelegentliche Kleiderschrank -Updates. Während Online-Shopping bequem ist, fehlt es die Gewissheit von persönlichen Try-Ons. Meine Lösung? KI-betriebene Personalisierung. Ich stelle mir einen KI -Assistenten vor

Vergessen Sie Duolingo: Die neue KI -Funktion von Google Translate lehrt SprachenApr 30, 2025 am 11:13 AM

Vergessen Sie Duolingo: Die neue KI -Funktion von Google Translate lehrt SprachenApr 30, 2025 am 11:13 AMGoogle Translate fügt die Funktion des Sprachlernens hinzu Laut Android Authority hat App Expert AssembleDeBug festgestellt, dass die neueste Version der Google Translate App eine neue "Praxis" -Modus des Testcode enthält, mit denen Benutzer ihre Sprachkenntnisse durch personalisierte Aktivitäten verbessern können. Diese Funktion ist derzeit für Benutzer unsichtbar, aber AssembleDeBug kann sie teilweise aktivieren und einige seiner neuen Elemente der Benutzeroberfläche anzeigen. Bei der Aktivierung fügt die Funktion am unteren Rand des Bildschirms ein neues Abschlusskapellymbol hinzu, das mit einem "Beta" -Anzeichen markiert wird, das anfällt, dass die Funktion "Praxis" anfänglich in experimenteller Form veröffentlicht wird. Die zugehörige Popup-Eingabeaufforderung zeigt "Üben Sie die für Sie zugeschnittenen Aktivitäten!", Dies bedeutet, dass Google individuell generiert wird

Sie machen TCP/IP für KI und heißt NandaApr 30, 2025 am 11:12 AM

Sie machen TCP/IP für KI und heißt NandaApr 30, 2025 am 11:12 AMMIT -Forscher entwickeln Nanda, ein bahnbrechendes Webprotokoll für KI -Agenten. Nanda, kurz für vernetzte Agenten und dezentrale KI

Die Eingabeaufforderung: DeepFake -Erkennung ist ein boomendes GeschäftApr 30, 2025 am 11:11 AM

Die Eingabeaufforderung: DeepFake -Erkennung ist ein boomendes GeschäftApr 30, 2025 am 11:11 AMMETAs neuestes Unternehmen: Eine KI -App zum Konkurrenz von Chatgpt Meta, die Muttergesellschaft von Facebook, Instagram, WhatsApp und Threads, startet eine neue AI-betriebene Anwendung. Diese eigenständige App, Meta AI, zielt darauf ab, direkt mit Openai's Chatgpt zu konkurrieren. Hebel

Die nächsten zwei Jahre in der KI -Cybersicherheit für GeschäftsführerApr 30, 2025 am 11:10 AM

Die nächsten zwei Jahre in der KI -Cybersicherheit für GeschäftsführerApr 30, 2025 am 11:10 AMNavigation der steigenden Flut von AI -Cyber -Angriffen In jüngster Zeit unterstrich Jason Clinton, Ciso für anthropische, die aufkommenden Risiken, die mit nichtmenschlichen Identitäten gebunden sind-als Kommunikation mit Maschine zu Maschinen, die diese "Identitäten" schützen, werden werden

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

EditPlus chinesische Crack-Version

Geringe Größe, Syntaxhervorhebung, unterstützt keine Code-Eingabeaufforderungsfunktion

PHPStorm Mac-Version

Das neueste (2018.2.1) professionelle, integrierte PHP-Entwicklungstool

SecLists

SecLists ist der ultimative Begleiter für Sicherheitstester. Dabei handelt es sich um eine Sammlung verschiedener Arten von Listen, die häufig bei Sicherheitsbewertungen verwendet werden, an einem Ort. SecLists trägt dazu bei, Sicherheitstests effizienter und produktiver zu gestalten, indem es bequem alle Listen bereitstellt, die ein Sicherheitstester benötigen könnte. Zu den Listentypen gehören Benutzernamen, Passwörter, URLs, Fuzzing-Payloads, Muster für vertrauliche Daten, Web-Shells und mehr. Der Tester kann dieses Repository einfach auf einen neuen Testcomputer übertragen und hat dann Zugriff auf alle Arten von Listen, die er benötigt.

Sicherer Prüfungsbrowser

Safe Exam Browser ist eine sichere Browserumgebung für die sichere Teilnahme an Online-Prüfungen. Diese Software verwandelt jeden Computer in einen sicheren Arbeitsplatz. Es kontrolliert den Zugriff auf alle Dienstprogramme und verhindert, dass Schüler nicht autorisierte Ressourcen nutzen.

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung