Technologie-Peripheriegeräte

Technologie-Peripheriegeräte KI

KI Ein paar Codezeilen stabilisieren UNet! Die Sun Yat-sen University und andere schlugen das ScaleLong-Diffusionsmodell vor: von der Infragestellung der Skalierung zur Skalierung

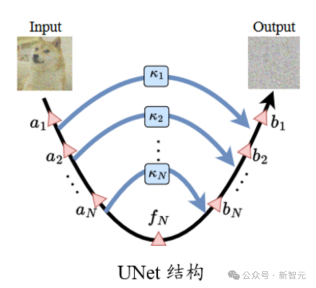

Ein paar Codezeilen stabilisieren UNet! Die Sun Yat-sen University und andere schlugen das ScaleLong-Diffusionsmodell vor: von der Infragestellung der Skalierung zur SkalierungIn der Standard-UNet-Struktur beträgt der Skalierungskoeffizient  auf der Long-Skip-Verbindung im Allgemeinen 1.

auf der Long-Skip-Verbindung im Allgemeinen 1.

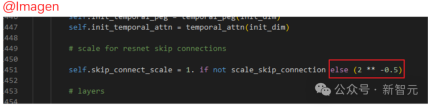

In einigen bekannten Diffusionsmodellarbeiten wie Imagen, Score-basiertes generatives Modell und SR3 usw. haben sie jedoch alle  festgelegt und festgestellt, dass solche Einstellungen das Diffusionstraining effektiv beschleunigen können Modelle.

festgelegt und festgestellt, dass solche Einstellungen das Diffusionstraining effektiv beschleunigen können Modelle.

Skalierung in Frage stellenIm Originalpapier gibt es jedoch keine spezifische Analyse des Skalierungsvorgangs der Sprungverbindung in Imagen und anderen Modellen, es wird jedoch gesagt, dass diese Einstellung zur Beschleunigung beiträgt das Training des Diffusionsmodells.

Zuallererst macht uns diese Art der empirischen Darstellung unklar, welche Rolle dieses Setting spielt?

Außerdem wissen wir nicht, ob wir nur  festlegen können oder ob wir andere Konstanten verwenden können?

festlegen können oder ob wir andere Konstanten verwenden können?

Sind die „Status“ von Skip-Verbindungen an verschiedenen Standorten gleich? Warum dieselbe Konstante verwenden?

Der Autor hat viele Fragezeichen dazu ...

Bilder

Bilder

Skalierung verstehen

Im Allgemeinen ist UNet im Vergleich zu ResNet- und Transformer-Strukturen in der tatsächlichen Verwendung nicht „tief“. Da es nicht tief ist, ist es weniger anfällig für Optimierungsprobleme wie verschwindende Gradienten, die in anderen „tiefen“ neuronalen Netzwerkstrukturen häufig auftreten.

Darüber hinaus werden aufgrund der Besonderheit der UNet-Struktur flache Features durch lange Sprungverbindungen mit tiefen Standorten verbunden, wodurch Probleme wie das Verschwinden des Gradienten weiter vermieden werden.

Denken Sie andersherum: Wenn eine solche Struktur nicht beachtet wird, führt dies dann zu Problemen wie übermäßigen Steigungen und Parameter-(Merkmals-)Schwankungen aufgrund von Aktualisierungen?

Bilder

Bilder

Durch die Visualisierung der Merkmale und Parameter der Diffusionsmodellaufgabe während des Trainingsprozesses kann festgestellt werden, dass tatsächlich Instabilität vorliegt.

Die Instabilität von Parametern (Features) wirkt sich auf den Gradienten aus, was wiederum Auswirkungen auf Parameteraktualisierungen hat. Letztendlich besteht bei diesem Prozess ein höheres Risiko unerwünschter Beeinträchtigungen der Leistung. Deshalb müssen wir Wege finden, diese Instabilität zu kontrollieren.

Ferner für das Diffusionsmodell. Die Eingabe von UNet ist ein verrauschtes Bild. Wenn das Modell das zusätzliche Rauschen genau vorhersagen soll, erfordert dies, dass das Modell eine hohe Robustheit gegenüber der Eingabe gegenüber zusätzlichen Störungen aufweist.

Papier: https://arxiv.org/abs/2310.13545

Code: https://github.com/sail-sg/ScaleLong

Forscher haben die oben genannten Probleme gefunden, die in Long zu finden sind Verbindung überspringen Die Skalierung wird auf dem System zur einheitlichen Schadensbegrenzung durchgeführt.

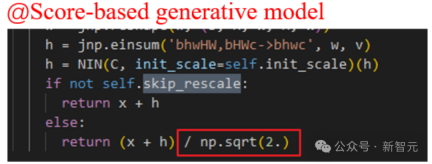

Aus Satz 3.1 steht der Schwingungsbereich des Merkmals der mittleren Schicht (die Breite der Ober- und Untergrenze) in direktem Zusammenhang mit der Summe der Quadrate des Skalierungskoeffizienten. Geeignete Skalierungskoeffizienten tragen dazu bei, die Instabilität von Merkmalen zu verringern.

Allerdings ist zu beachten, dass der Schock tatsächlich optimal gemildert wird, wenn der Skalierungskoeffizient direkt auf 0 gesetzt wird. (Manueller Hundekopf)

Aber wenn UNet zu einer Situation ohne Sprünge degradiert, ist das Instabilitätsproblem gelöst, aber auch die Darstellungsfähigkeit geht verloren. Dies ist ein Kompromiss zwischen Modellstabilität und Darstellungsfähigkeiten.

Bilder

Bilder

Ähnlich aus der Perspektive des Parametergradienten. Satz 3.3 zeigt auch, dass der Skalierungskoeffizient die Größe des Gradienten steuert.

Bild

Bild

Darüber hinaus zeigt Satz 3.4 auch, dass die Skalierung der Long-Skip-Verbindung auch die robuste Obergrenze des Modells gegenüber Eingangsstörungen beeinflussen und die Stabilität des Diffusionsmodells gegenüber Eingangsstörungen verbessern kann.

Become Scaling

Durch die obige Analyse verstehen wir, wie wichtig die Skalierung auf Long-Skip-Verbindungen für ein stabiles Modelltraining ist.  gilt auch für die obige Analyse.

gilt auch für die obige Analyse.

Als nächstes analysieren wir, welche Art von Skalierung eine bessere Leistung erzielen kann. Schließlich kann die obige Analyse nur zeigen, dass die Skalierung gut ist, aber sie kann nicht bestimmen, welche Art von Skalierung die beste oder bessere ist.

Eine einfache Möglichkeit besteht darin, ein lernbares Modul für eine lange Sprungverbindung einzuführen, um die Skalierung adaptiv anzupassen. Diese Methode wird als Learnable Scaling (LS)-Methode bezeichnet. Wir übernehmen eine SENet-ähnliche Struktur, die wie folgt aussieht (die hier betrachtete U-ViT-Struktur ist sehr gut organisiert!) Training von Diffusionsmodellen! Darüber hinaus versuchen wir, die in LS gelernten Koeffizienten zu visualisieren.

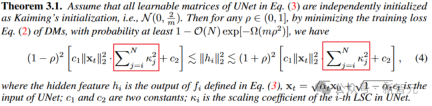

Wie in der folgenden Abbildung gezeigt, werden wir feststellen, dass diese Koeffizienten einen exponentiellen Abwärtstrend aufweisen (beachten Sie, dass sich die erste lange Sprungverbindung hier auf die Verbindung bezieht, die das erste und letzte Ende von UNet verbindet), und der erste Koeffizient liegt fast nahe beieinander zu 1. Das Phänomen ist auch erstaunlich! Bild

Bild

Basierend auf dieser Beobachtungsreihe (weitere Einzelheiten finden Sie im Artikel) haben wir außerdem die Constant Scaling (CS)-Methode vorgeschlagen, die keine lernbaren Parameter erfordert:

Die CS-Strategie erfordert keine zusätzlichen Parameter wie die ursprüngliche Skalierungsoperation mit

, sodass fast kein zusätzlicher Rechenaufwand entsteht. Obwohl CS im Stalltraining die meiste Zeit nicht so gut abschneidet wie LS, ist es für die bestehenden

Obwohl CS im Stalltraining die meiste Zeit nicht so gut abschneidet wie LS, ist es für die bestehenden

Strategien dennoch einen Versuch wert.

Die oben genannten Implementierungen von CS und LS sind sehr einfach und erfordern nur wenige Codezeilen. Für jede (hua)-Formel (li) und jede (hu)-artige (shao) UNet-Struktur müssen die Merkmalsabmessungen möglicherweise angepasst werden. (Manueller Hundekopf +1)

Kürzlich haben auch einige Folgearbeiten wie FreeU, SCEdit und andere gezeigt, wie wichtig die Skalierung bei Skip-Verbindungen ist. Jeder ist herzlich eingeladen, es zu versuchen und zu fördern.

Das obige ist der detaillierte Inhalt vonEin paar Codezeilen stabilisieren UNet! Die Sun Yat-sen University und andere schlugen das ScaleLong-Diffusionsmodell vor: von der Infragestellung der Skalierung zur Skalierung. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Sie müssen KI am Arbeitsplatz hinter einem Schleier der Unwissenheit bauenApr 29, 2025 am 11:15 AM

Sie müssen KI am Arbeitsplatz hinter einem Schleier der Unwissenheit bauenApr 29, 2025 am 11:15 AMIn John Rawls 'wegweisendem Buch von 1971 schlug er ein Gedankenexperiment vor, das wir als Kern des heutigen KI-Designs und der Entscheidungsfindung verwenden sollten: den Schleier der Unwissenheit. Diese Philosophie bietet ein einfaches Instrument zum Verständnis von Eigenkapital und bietet auch eine Entwurf für Führungskräfte, um dieses Verständnis zu nutzen, um KI auf gerechte Weise zu entwerfen und umzusetzen. Stellen Sie sich vor, Sie treffen Regeln für eine neue Gesellschaft. Aber es gibt eine Prämisse: Sie wissen nicht im Voraus, welche Rolle Sie in dieser Gesellschaft spielen werden. Möglicherweise sind Sie reich oder arm, gesund oder behindert, gehören einer Mehrheit oder einer marginalen Minderheit. Der Betrieb unter diesem "Schleier der Unwissenheit" verhindert, dass Regelmacher Entscheidungen treffen, die selbst zugute kommen. Im Gegenteil, die Menschen werden motivierter sein, die Öffentlichkeit zu formulieren

Entscheidungen, Entscheidungen… nächste Schritte für die praktische angewandte KIApr 29, 2025 am 11:14 AM

Entscheidungen, Entscheidungen… nächste Schritte für die praktische angewandte KIApr 29, 2025 am 11:14 AMZahlreiche Unternehmen sind auf Roboterprozessautomatisierung (RPA) spezialisiert und bieten Bots, um sich wiederholende Aufgaben zu automatisieren - Uipath, Automatisierung überall, blaues Prisma und andere. In der Zwischenzeit verarbeiten Sie Mining, Orchestrierung und intelligente Dokumentenverarbeitung Speciali

Die Agenten kommen - mehr darüber, was wir neben AI -Partnern tun werdenApr 29, 2025 am 11:13 AM

Die Agenten kommen - mehr darüber, was wir neben AI -Partnern tun werdenApr 29, 2025 am 11:13 AMDie Zukunft der KI bewegt sich über die einfache Wortvorhersage und die Konversationsimulation hinaus. KI -Agenten sind aufgetaucht, in der Lage, unabhängige Handlungen und Aufgabenabschluss zu erledigen. Diese Verschiebung zeigt sich bereits in Tools wie dem Claude von Anthropic. KI -Agenten: Forschung a

Warum Empathie wichtiger ist als die Kontrolle für Führungskräfte in einer KI-gesteuerten ZukunftApr 29, 2025 am 11:12 AM

Warum Empathie wichtiger ist als die Kontrolle für Führungskräfte in einer KI-gesteuerten ZukunftApr 29, 2025 am 11:12 AMSchnelle technologische Fortschritte erfordern eine zukunftsweisende Perspektive auf die Zukunft der Arbeit. Was passiert, wenn die KI nur die Produktivitätsverstärkung überschreitet und unsere gesellschaftlichen Strukturen prägt? Topher McDougals bevorstehendes Buch Gaia Wakes:

KI für die Produktklassifizierung: Können Maschinen das Steuergesetz meistern?Apr 29, 2025 am 11:11 AM

KI für die Produktklassifizierung: Können Maschinen das Steuergesetz meistern?Apr 29, 2025 am 11:11 AMDie Produktklassifizierung, die häufig komplexe Codes wie "HS 8471.30" aus Systemen wie dem harmonisierten System (HS) umfasst, ist für den internationalen Handel und den Inlandsumsatz von entscheidender Bedeutung. Diese Codes gewährleisten den korrekten Steuerantrag und wirken sich auf jeden Inv aus

Könnte die Nachfrage des Rechenzentrums einen Klima -Tech -Rebound auslösen?Apr 29, 2025 am 11:10 AM

Könnte die Nachfrage des Rechenzentrums einen Klima -Tech -Rebound auslösen?Apr 29, 2025 am 11:10 AMDie Zukunft des Energieverbrauchs in Rechenzentren und Klimaschutzinvestitionen In diesem Artikel wird der Anstieg des Energieverbrauchs in Rechenzentren untersucht, die von KI und ihren Auswirkungen auf den Klimawandel angetrieben werden, und analysiert innovative Lösungen und politische Empfehlungen, um diese Herausforderung zu befriedigen. Herausforderungen des Energiebedarfs: Zentren im großen und ultra-großen Maßstab verbrauchen enorme Macht, vergleichbar mit der Summe von Hunderttausenden gewöhnlicher nordamerikanischer Familien und aufstrebende AI-Zentren im Bereich Ultra-Large-Scale-Zentren verbrauchen Dutzende von Zeiten mehr mehr Macht als diese. In den ersten acht Monaten des 2024 haben Microsoft, Meta, Google und Amazon rund 125 Milliarden US -Dollar in den Bau und den Betrieb von AI -Rechenzentren investiert (JP Morgan, 2024) (Tabelle 1). Der wachsende Energiebedarf ist sowohl eine Herausforderung als auch eine Chance. Laut Kanarischen Medien der drohende Elektrizität

AI und Hollywoods nächstes goldenes ZeitalterApr 29, 2025 am 11:09 AM

AI und Hollywoods nächstes goldenes ZeitalterApr 29, 2025 am 11:09 AMGenerative AI revolutioniert die Film- und Fernsehproduktion. Das Ray 2-Modell von Luma sowie das Gen-4 von Runway, Openai von Sora, Google's VEO und andere neue Modelle verbessern die Qualität der generierten Videos mit beispielloser Geschwindigkeit. Diese Modelle können problemlos komplexe Spezialeffekte und realistische Szenen erzeugen, selbst kurze Videoclips und Kameraser-Bewegungseffekte wurden erreicht. Während die Manipulation und Konsistenz dieser Tools noch verbessert werden müssen, ist die Geschwindigkeit des Fortschritts erstaunlich. Generatives Video wird zu einem unabhängigen Medium. Einige Modelle sind gut in der Animationsproduktion, andere sind gut in Live-Action-Bildern. Es ist erwähnenswert, dass Adobe's Firefly und Moonvalleys MA

Wird Chatgpt langsam AIs größtes Ja-Mann?Apr 29, 2025 am 11:08 AM

Wird Chatgpt langsam AIs größtes Ja-Mann?Apr 29, 2025 am 11:08 AMChatGPT -Benutzererfahrung lehnt ab: Ist es ein Modellverschlechterungs- oder Benutzererwartungen? In jüngster Zeit haben sich eine große Anzahl von ChatGPT bezahlten Nutzern über ihre Leistungsverschlechterung beschwert, die weit verbreitete Aufmerksamkeit erregt hat. Die Benutzer berichteten über langsamere Antworten auf Modelle, kürzere Antworten, mangelnde Hilfe und noch mehr Halluzinationen. Einige Benutzer äußerten Unzufriedenheit in den sozialen Medien und wiesen darauf hin, dass ChatGPT zu „zu schmeichelhaft“ geworden ist, und neigt dazu, Benutzeransichten zu überprüfen, anstatt ein kritisches Feedback zu geben. Dies wirkt sich nicht nur auf die Benutzererfahrung aus, sondern verleiht Unternehmenskunden auch tatsächliche Verluste, wie z. B. reduzierte Produktivität und Rechenressourcenverschwendung. Nachweis der Leistungsverschlechterung Viele Benutzer haben einen signifikanten Verschlechterung der Chatgpt-Leistung gemeldet, insbesondere in älteren Modellen wie GPT-4 (die Ende dieses Monats bald vom Service abgebrochen werden). Das

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

MinGW – Minimalistisches GNU für Windows

Dieses Projekt wird derzeit auf osdn.net/projects/mingw migriert. Sie können uns dort weiterhin folgen. MinGW: Eine native Windows-Portierung der GNU Compiler Collection (GCC), frei verteilbare Importbibliotheken und Header-Dateien zum Erstellen nativer Windows-Anwendungen, einschließlich Erweiterungen der MSVC-Laufzeit zur Unterstützung der C99-Funktionalität. Die gesamte MinGW-Software kann auf 64-Bit-Windows-Plattformen ausgeführt werden.

SublimeText3 Englische Version

Empfohlen: Win-Version, unterstützt Code-Eingabeaufforderungen!

SublimeText3 Linux neue Version

SublimeText3 Linux neueste Version

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Herunterladen der Mac-Version des Atom-Editors

Der beliebteste Open-Source-Editor