1. Einleitung

Nachdem letztes Jahr der Tucson AI Day stattfand, kam mir immer wieder die Idee, unsere Arbeit in der Fernwahrnehmung in Textform zusammenzufassen. Da ich kürzlich etwas Zeit hatte, beschloss ich, einen Artikel zu schreiben, um den Forschungsprozess der letzten Jahre aufzuzeichnen. Der in diesem Artikel behandelte Inhalt ist im Tucson AI Day-Video [0] und in unseren öffentlich veröffentlichten Artikeln zu finden, enthält jedoch keine spezifischen technischen Details oder technischen Geheimnisse.

Wie wir alle wissen, konzentriert sich Tucson auf autonome Lkw-Fahrtechnologie. Lkw haben längere Bremswege und längere Spurwechsel als Pkw. Dadurch verfügt Tucson über einen einzigartigen Wettbewerbsvorteil gegenüber anderen Unternehmen für autonomes Fahren. Als Mitglied von Tucson bin ich für die LiDAR-Erfassungstechnologie verantwortlich und werde nun die damit verbundenen Inhalte der Verwendung von LiDAR für die Fernerfassung im Detail vorstellen.

Als das Unternehmen zum ersten Mal beitrat, war die gängige LiDAR-Sensorlösung normalerweise die BEV-Lösung (Bird's Eye View). Allerdings ist BEV hier nicht die Abkürzung des bekannten Battery Electric Vehicle, sondern bezieht sich auf eine Lösung, die LiDAR-Punktwolken in den BEV-Raum projiziert und 2D-Faltung und 2D-Erkennungsköpfe zur Zielerkennung kombiniert. Ich persönlich denke, dass die von Tesla verwendete LiDAR-Sensortechnologie als „die Fusionstechnologie von Multi-View-Kameras im BEV-Bereich“ bezeichnet werden sollte. Soweit ich das beurteilen kann, ist die früheste Aufzeichnung der BEV-Lösung das von Baidu auf der CVPR17-Konferenz veröffentlichte Papier „MV3D“ [1]. Viele nachfolgende Forschungsarbeiten, einschließlich der Lösungen, die tatsächlich von vielen mir bekannten Unternehmen verwendet werden, verwenden alle die Methode, LiDAR-Punktwolken zur Zielerkennung in den BEV-Raum zu projizieren, und können als BEV-Lösungen klassifiziert werden. Diese Lösung wird in der Praxis häufig eingesetzt. Zusammenfassend lässt sich sagen, dass die gängige LiDAR-Sensorlösung, als ich zum ersten Mal zum Unternehmen kam, normalerweise die LiDAR-Punktwolke in den BEV-Raum projizierte und dann 2D-Faltung und einen 2D-Erkennungskopf zur Zielerkennung kombinierte. Die von Tesla verwendete LiDAR-Sensortechnologie kann als „die Fusionstechnologie von Multi-View-Kameras im BEV-Bereich“ bezeichnet werden. Das von Baidu auf der CVPR17-Konferenz veröffentlichte Papier „MV3D“ war eine frühe Aufzeichnung der BEV-Lösung. Anschließend führten viele Unternehmen auch ähnliche Lösungen zur Zielerkennung ein.

Die von MV3D verwendete BEV-Perspektivfunktion[1]

Die von MV3D verwendete BEV-Perspektivfunktion[1]

Ein großer Vorteil der BEV-Lösung besteht darin, dass sie ausgereifte 2D-Detektoren direkt anwenden kann, sie weist jedoch auch einen schwerwiegenden Nachteil auf: Sie begrenzt den Erfassungsbereich. Wie Sie dem Bild oben entnehmen können, muss ein 2D-Detektor erstellt werden. Zu diesem Zeitpunkt muss ein Entfernungsschwellenwert dafür festgelegt werden. Tatsächlich gibt es immer noch LiDAR-Punkte außerhalb des Bereichs des Bildes oben, wurde aber durch diese Kürzungsoperation verworfen. Ist es möglich, den Entfernungsschwellenwert zu erhöhen, bis der Standort abgedeckt ist? Dies ist nicht unmöglich, aber LiDAR weist aufgrund von Problemen wie Scanmodus, Reflexionsintensität (Abschwächung mit der Entfernung zur vierten Potenz), Okklusion usw. nur sehr wenige Punktwolken in der Ferne auf, sodass es nicht kosteneffektiv ist.

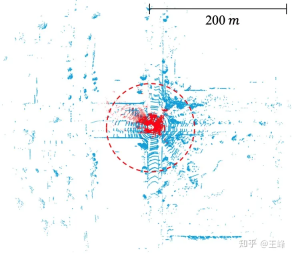

Die akademische Gemeinschaft hat diesem Thema des BEV-Systems nicht viel Aufmerksamkeit geschenkt, hauptsächlich aufgrund der Einschränkungen des Datensatzes. Der Annotationsbereich aktueller Mainstream-Datensätze beträgt normalerweise weniger als 80 Meter (z. B. 50 Meter von nuScenes, 70 Meter von KITTI und 80 Meter von Waymo). Innerhalb dieses Entfernungsbereichs muss die Größe der BEV-Feature-Map nicht groß sein. Allerdings kann in der Industrie der verwendete Mittelstrecken-LiDAR im Allgemeinen eine Scanreichweite von 200 Metern erreichen, und in den letzten Jahren wurden einige Langstrecken-LiDARs auf den Markt gebracht, die eine Scanreichweite von 500 Metern erreichen können. Es ist zu beachten, dass die Fläche und der Berechnungsumfang der Feature-Map mit zunehmender Entfernung quadratisch zunehmen. Im Rahmen des BEV-Systems ist der Rechenaufwand für die Bewältigung einer Reichweite von 200 Metern bereits beträchtlich, ganz zu schweigen von einer Reichweite von 500 Metern. Daher bedarf dieses Problem mehr Aufmerksamkeit und Lösung in der Branche.

Der Scanbereich von LIDAR im öffentlichen Datensatz. KITTI (roter Punkt, 70 m) vs. Argoverse 2 (blauer Punkt, 200 m)

Nachdem wir die Einschränkungen der BEV-Lösung erkannt hatten, fanden wir nach jahrelanger Forschung endlich eine praktikable Alternative. Der Rechercheprozess war nicht einfach und wir erlebten viele Rückschläge. Im Allgemeinen werden in Aufsätzen und Berichten nur Erfolge hervorgehoben und Misserfolge nicht erwähnt, aber auch die Erfahrung von Misserfolgen ist sehr wertvoll. Deshalb haben wir uns entschieden, unsere Forschungsreise in einem Blog zu teilen. Als nächstes werde ich es Schritt für Schritt anhand der Zeitleiste beschreiben.

2. Punktbasierte Lösung

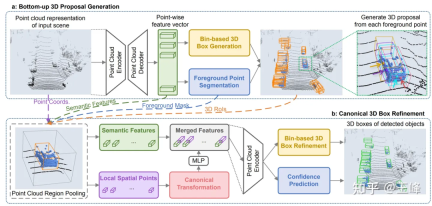

Auf der CVPR19 veröffentlichte Hong Kong Chinese einen Punktwolkendetektor namens PointRCNN [2]. Im Gegensatz zu herkömmlichen Methoden führt PointRCNN Berechnungen direkt anhand von Punktwolkendaten durch, ohne diese in die BEV-Form (Vogelperspektive) umzuwandeln. Daher kann diese punktwolkenbasierte Lösung theoretisch eine Fernerfassung ermöglichen.

Aber wir haben ein Problem festgestellt. Die Anzahl der Punktwolken in einem Frame von KITTI kann zur Erkennung ohne großen Punktverlust heruntergesampelt werden. Allerdings hat unsere LiDAR-Kombination mehr als 100.000 Punkte in einem Frame 10-mal wird die Erkennungsgenauigkeit offensichtlich stark beeinträchtigt. Wenn kein Downsampling durchgeführt wird, gibt es im Backbone von PointRCNN sogar O(n^2)-Operationen. Obwohl kein Bev benötigt wird, ist der Rechenaufwand dennoch unerträglich. Diese zeitaufwändigen Vorgänge sind hauptsächlich auf die ungeordnete Natur der Punktwolke selbst zurückzuführen, was bedeutet, dass alle Punkte durchlaufen werden müssen, unabhängig davon, ob es sich um Downsampling oder Nachbarschaftsabruf handelt. Da viele Operationen beteiligt sind und es sich bei allen um Standardoperationen handelt, die nicht optimiert wurden, besteht kurzfristig keine Hoffnung auf eine Optimierung auf Echtzeit, weshalb dieser Weg aufgegeben wurde.

Diese Forschung ist jedoch keine Verschwendung. Obwohl die Berechnungsmenge des Rückgrats zu groß ist, wird die zweite Stufe nur im Vordergrund durchgeführt, sodass die Berechnungsmenge immer noch relativ gering ist. Nach direkter Anwendung der zweiten Stufe von PointRCNN auf den Detektor der ersten Stufe des BEV-Schemas wird die Genauigkeit des Erkennungsrahmens erheblich verbessert. Während des Bewerbungsprozesses haben wir auch ein kleines Problem entdeckt. Nachdem wir es gelöst haben, haben wir es in einem Artikel [3] veröffentlicht, der auf CVPR21 veröffentlicht wurde:

Wang Feng: LiDAR R-CNN: Ein schneller und vielseitiger zweistufiger 3D-Detektor

3. Range-View-Lösung

Nach dem Scheitern der punktbasierten Lösung richteten wir unsere Aufmerksamkeit auf Range View. Die LiDARs waren damals alle mechanisch Rotierende Punkte: Ein 64-Linien-Lidar scannt beispielsweise 64 Linien von Punktwolken mit unterschiedlichen Neigungswinkeln. Wenn jede Linie beispielsweise 2048 Punkte scannt, kann ein 64*2048-Entfernungsbild erstellt werden.

Vergleich von RV, BEV und PV

Vergleich von RV, BEV und PV

In der Entfernungsansicht ist die Punktwolke nicht mehr spärlich, sondern dicht aneinandergereiht. Die entfernten Ziele sind auf dem Entfernungsbild nur kleiner, werden aber nicht weggeworfen es kann theoretisch nachgewiesen werden.

Vielleicht, weil es dem Bild ähnlicher ist, ist die Forschung zu Wohnmobilen tatsächlich früher als zu BEV. Die frühesten Aufzeichnungen, die ich finden kann, stammen auch aus Baidus Artikel [4]. ist RV. Die früheste Anwendung von BEV stammt von Baidu.

Also habe ich es damals ausprobiert. Im Vergleich zur BEV-Methode ist der AP von RV um 30-40 Punkte gesunken ... Ich habe festgestellt, dass die Erkennung auf dem 2D-Entfernungsbild tatsächlich in Ordnung war, aber die Ausgabe des 3D Der Rahmeneffekt ist sehr schlecht. Als wir damals die Eigenschaften von RV analysierten, hatten wir das Gefühl, dass es alle Nachteile von Bildern aufwies: ungleichmäßige Objektmaßstäbe, gemischte Vorder- und Hintergrundmerkmale und unklare Fernzielmerkmale Vorteil der reichhaltigen semantischen Merkmale in Bildern, daher war ich damals relativ pessimistisch, was diese Lösung anging.

Weil formale Mitarbeiter die Umsetzungsarbeit schließlich noch leisten müssen, überlässt man solche Sondierungsfragen besser den Praktikanten. Später rekrutierte ich zwei Praktikanten, um dieses Problem gemeinsam zu untersuchen. Als ich es am öffentlichen Datensatz versuchte, verlor ich ebenfalls 30 Punkte ... Glücklicherweise waren die beiden Praktikanten durch eine Reihe von Bemühungen und Verweisen auf andere fähiger Nach einigen Details des Papiers wurden die Punkte auf ein Niveau gebracht, das der Mainstream-BEV-Methode ähnelt, und das endgültige Papier wurde auf ICCV21 veröffentlicht [5].

Obwohl die Punkte erhöht wurden, ist das Problem noch nicht vollständig gelöst. Zu diesem Zeitpunkt besteht Einigkeit darüber, dass Lidar eine Multi-Frame-Fusion benötigt, um das Signal-Rausch-Verhältnis zu verbessern -Entfernungsziele müssen Frames stapeln, um die Informationsmenge zu erhöhen. In der BEV-Lösung ist die Multi-Frame-Fusion sehr einfach. Fügen Sie einfach einen Zeitstempel zur Eingabepunktwolke hinzu und überlagern Sie dann mehrere Frames. Unter RV wurden jedoch viele Tricks geändert Ähnlicher Effekt wurde erzielt.

Und zu diesem Zeitpunkt ist LiDAR auch in Bezug auf die Hardware-technischen Lösungen von der mechanischen Rotation zum festen/halbfesten Zustand übergegangen. Die meisten festen/halbfesten LiDAR können kein Entfernungsbild mehr erzeugen, und die erzwungene Konstruktion eines Entfernungsbildes wird dies tun Informationen verloren, so dass dieser Weg schließlich aufgegeben wurde.

4. Sparse-Voxel-Schema

Wie bereits erwähnt besteht das Problem des punktbasierten Schemas darin, dass die unregelmäßige Anordnung der Punktwolken dazu führt, dass Downsampling- und Nachbarschaftsabfrageprobleme das Durchqueren aller Punktwolken erfordern, was zu übermäßigen Berechnungen führt BEV-Schema Die Daten sind organisiert, aber es gibt zu viele leere Bereiche, was zu übermäßigen Berechnungen führt. Wenn man beides kombiniert, scheint es ein praktikabler Weg zu sein, die Voxelisierung in gepunkteten Bereichen durchzuführen, um sie regelmäßig zu machen, und nicht in ungepunkteten Bereichen auszudrücken, um ungültige Berechnungen zu verhindern. Dies ist die Lösung mit spärlichen Voxeln.

Da Yan Yan, der Autor von SECOND[6], zu Tucson kam, haben wir in den frühen Tagen das Rückgrat von Sparse Conv ausprobiert. Da spconv jedoch keine Standardoperation ist, ist das von uns implementierte spconv immer noch zu langsam und unzureichend Die Erkennung erfolgt in Echtzeit, manchmal sogar langsamer als die dichte Konvertierung, daher wird sie vorerst zurückgestellt.

Später kam der erste LiDAR, der 500 m scannen konnte: Livox Tele15, und der LiDAR-Erkennungsalgorithmus mit großer Reichweite stand unmittelbar bevor. Ich habe die BEV-Lösung ausprobiert, aber sie war zu teuer, also habe ich die spconv-Lösung erneut ausprobiert, weil Tele15 das Fov ist relativ schmal und die Punktwolke in der Ferne ist ebenfalls sehr spärlich, sodass spconv kaum Echtzeitleistung erzielen kann.

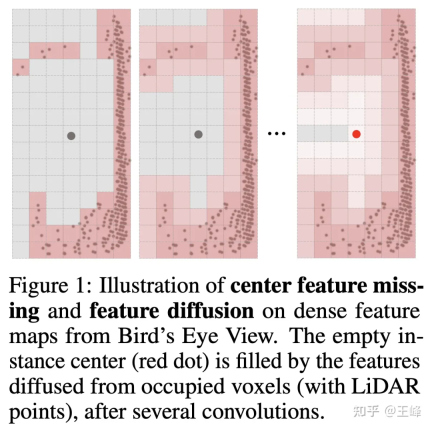

Aber wenn Sie Bev nicht verwenden, kann der Erkennungskopf den ausgereifteren Anker oder die Mittenzuweisung bei der 2D-Erkennung nicht verwenden. Dies liegt hauptsächlich daran, dass der Lidar die Oberfläche des Objekts scannt und die Mittenposition nicht unbedingt ein Punkt ist (wie). (siehe Abbildung unten) ist es natürlich unmöglich, ein Vordergrundziel ohne Punkt zuzuweisen. Tatsächlich haben wir intern viele Zuweisungsmethoden ausprobiert. Ich werde hier nicht näher auf die vom Unternehmen verwendeten Zuweisungsmethoden eingehen und diese auf NIPS2022 veröffentlichen.

明月不谙愿: Vollständig spärlicher 3D-Objektdetektor

Aber wenn Sie diesen Algorithmus auf eine LiDAR-Kombination aus 500 m vorwärts, 150 m rückwärts und links und rechts anwenden möchten, ist er immer noch unzureichend. Zufällig griff der Praktikant auf die Ideen von Swin Transformer zurück und schrieb einen Artikel über Sparse Transformer, bevor er nach Popularität suchte [8]. Es erforderte auch viel Mühe, Stück für Stück mehr als 20 Punkte aufzufrischen (Danke). (An den Praktikanten für die Anleitung, tql). Damals hatte ich das Gefühl, dass die Transformer-Methode immer noch sehr gut für unregelmäßige Punktwolkendaten geeignet war, also habe ich sie auch am Datensatz des Unternehmens ausprobiert.

Leider hat diese Methode die BEV-Methode im Datensatz des Unternehmens immer nicht übertroffen, und im Nachhinein beträgt der Unterschied möglicherweise einige Tricks oder Trainingsfähigkeiten, die ich nicht beherrsche Der Grund dafür ist, dass die Ausdrucksfähigkeit von Transformer nicht schwächer ist als die von conv, aber ich habe es später nicht noch einmal versucht. Zu diesem Zeitpunkt wurde die Zuweisungsmethode jedoch optimiert und viele Berechnungen reduziert, sodass ich es erneut mit spconv versuchen wollte. Das überraschende Ergebnis ist, dass durch direktes Ersetzen des Transformers durch spconv im Nahbereich die gleiche Genauigkeit wie mit der BEV-Methode erzielt werden kann Ganz schön, und es kann auch weit entfernte Ziele erkennen.

Zu dieser Zeit hat Yan Yan auch die zweite Version von spconv[9] erstellt, sodass die Rechenverzögerung kein Engpass mehr war. Schließlich konnte die LiDAR-Wahrnehmung über große Entfernungen alle Hindernisse beseitigen Das Auto startete in Echtzeit.

Später haben wir die LiDAR-Anordnung aktualisiert und die Scanreichweite auf 500 m vorwärts, 300 m rückwärts und 150 m links und rechts erhöht. Ich glaube auch, dass die Berechnungsverzögerung mit zunehmender Rechenleistung in Zukunft abnehmen wird . Es wird immer weniger zum Problem.

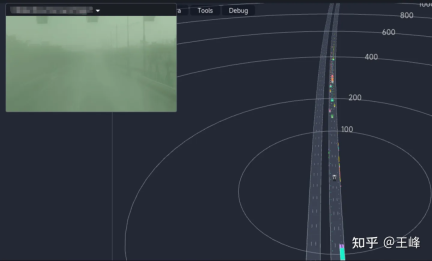

Der endgültige Fernerkennungseffekt ist unten dargestellt. Sie können sich auch die Position um 01:08:30 Uhr des Tucson AI Day-Videos ansehen, um den dynamischen Erkennungseffekt zu sehen:

Obwohl es sich um die endgültige Fusion handelt Ergebnis, aber da die Sichtbarkeit des Bildes aufgrund des Nebels an diesem Tag sehr schlecht war, stammten die Ergebnisse im Wesentlichen aus der LiDAR-Wahrnehmung.

V. Nachtrag

Von der punktbasierten Methode über die Range-Image-Methode bis hin zu den auf spärlichen Voxeln basierenden Transformer- und Sparse-Conv-Methoden kann man nicht sagen, dass die Erforschung der Fernwahrnehmung reibungslos verläuft ist einfach eine Straße voller Dornen. Letztendlich haben wir diesen Schritt tatsächlich durch die kontinuierliche Verbesserung der Rechenleistung und den kontinuierlichen Einsatz vieler Kollegen geschafft. Ich möchte mich bei Tucsons Chefwissenschaftler Wang Naiyan und allen Kollegen und Praktikanten in Tucson bedanken. Ich schäme mich sehr. Sie dienen eher als Bindeglied zwischen der Vergangenheit und der Zukunft.

Ich habe schon lange keinen so langen Artikel mehr geschrieben. Er war wie ein fortlaufender Bericht geschrieben, ohne eine berührende Geschichte zu entwickeln. In den letzten Jahren bestehen immer weniger Kollegen auf L4, und L2-Kollegen haben sich nach und nach der rein visuellen Forschung zugewandt, die für das bloße Auge sichtbar an den Rand gedrängt wird, obwohl ich immer noch fest davon überzeugt bin, dass ein direkter Entfernungssensor die bessere Wahl ist , aber Brancheninsider scheinen zunehmend anderer Meinung zu sein. Da ich immer mehr BEV und Occupancy in den Lebensläufen der Frischlinge sehe, frage ich mich, wie lange die LiDAR-Erkennung noch bestehen kann und wie lange ich durchhalten kann. Das Schreiben eines solchen Artikels kann auch als Erinnerung dienen.

Ich weine spät in der Nacht, ich verstehe nicht, wovon ich rede, tut mir leid.

Das obige ist der detaillierte Inhalt vonWarnung! LiDAR-Erfassung über große Entfernungen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Gemma Scope: Das Mikroskop von Google, um in den Denkprozess von AI zu blickenApr 17, 2025 am 11:55 AM

Gemma Scope: Das Mikroskop von Google, um in den Denkprozess von AI zu blickenApr 17, 2025 am 11:55 AMErforschen der inneren Funktionsweise von Sprachmodellen mit Gemma -Umfang Das Verständnis der Komplexität von KI -Sprachmodellen ist eine bedeutende Herausforderung. Die Veröffentlichung von Gemma Scope durch Google, ein umfassendes Toolkit, bietet Forschern eine leistungsstarke Möglichkeit, sich einzuschütteln

Wer ist ein Business Intelligence Analyst und wie kann man einer werden?Apr 17, 2025 am 11:44 AM

Wer ist ein Business Intelligence Analyst und wie kann man einer werden?Apr 17, 2025 am 11:44 AMErschließung des Geschäftserfolgs: Ein Leitfaden zum Analyst für Business Intelligence -Analyst Stellen Sie sich vor, Rohdaten verwandeln in umsetzbare Erkenntnisse, die das organisatorische Wachstum vorantreiben. Dies ist die Macht eines Business Intelligence -Analysts (BI) - eine entscheidende Rolle in Gu

Wie füge ich eine Spalte in SQL hinzu? - Analytics VidhyaApr 17, 2025 am 11:43 AM

Wie füge ich eine Spalte in SQL hinzu? - Analytics VidhyaApr 17, 2025 am 11:43 AMSQL -Änderungstabellanweisung: Dynamisches Hinzufügen von Spalten zu Ihrer Datenbank Im Datenmanagement ist die Anpassungsfähigkeit von SQL von entscheidender Bedeutung. Müssen Sie Ihre Datenbankstruktur im laufenden Flug anpassen? Die Änderungstabelleerklärung ist Ihre Lösung. Diese Anleitung Details Hinzufügen von Colu

Business Analyst vs. Data AnalystApr 17, 2025 am 11:38 AM

Business Analyst vs. Data AnalystApr 17, 2025 am 11:38 AMEinführung Stellen Sie sich ein lebhaftes Büro vor, in dem zwei Fachleute an einem kritischen Projekt zusammenarbeiten. Der Business Analyst konzentriert sich auf die Ziele des Unternehmens, die Ermittlung von Verbesserungsbereichen und die strategische Übereinstimmung mit Markttrends. Simu

Was sind Count und Counta in Excel? - Analytics VidhyaApr 17, 2025 am 11:34 AM

Was sind Count und Counta in Excel? - Analytics VidhyaApr 17, 2025 am 11:34 AMExcel -Datenzählung und -analyse: Detaillierte Erläuterung von Count- und Counta -Funktionen Eine genaue Datenzählung und -analyse sind in Excel kritisch, insbesondere bei der Arbeit mit großen Datensätzen. Excel bietet eine Vielzahl von Funktionen, um dies zu erreichen. Die Funktionen von Count- und Counta sind wichtige Instrumente zum Zählen der Anzahl der Zellen unter verschiedenen Bedingungen. Obwohl beide Funktionen zum Zählen von Zellen verwendet werden, sind ihre Designziele auf verschiedene Datentypen ausgerichtet. Lassen Sie uns mit den spezifischen Details der Count- und Counta -Funktionen ausgrenzen, ihre einzigartigen Merkmale und Unterschiede hervorheben und lernen, wie Sie sie in der Datenanalyse anwenden. Überblick über die wichtigsten Punkte Graf und Cou verstehen

Chrome ist hier mit KI: Tag zu erleben, täglich etwas Neues !!Apr 17, 2025 am 11:29 AM

Chrome ist hier mit KI: Tag zu erleben, täglich etwas Neues !!Apr 17, 2025 am 11:29 AMDie KI -Revolution von Google Chrome: Eine personalisierte und effiziente Browsing -Erfahrung Künstliche Intelligenz (KI) verändert schnell unser tägliches Leben, und Google Chrome leitet die Anklage in der Web -Browsing -Arena. Dieser Artikel untersucht die Exciti

Die menschliche Seite von Ai: Wohlbefinden und VierfacheApr 17, 2025 am 11:28 AM

Die menschliche Seite von Ai: Wohlbefinden und VierfacheApr 17, 2025 am 11:28 AMImpacting Impact: Das vierfache Endergebnis Zu lange wurde das Gespräch von einer engen Sicht auf die Auswirkungen der KI dominiert, die sich hauptsächlich auf das Gewinn des Gewinns konzentrierte. Ein ganzheitlicherer Ansatz erkennt jedoch die Vernetzung von BU an

5 verwendende Anwendungsfälle für Quantum Computing, über die Sie wissen solltenApr 17, 2025 am 11:24 AM

5 verwendende Anwendungsfälle für Quantum Computing, über die Sie wissen solltenApr 17, 2025 am 11:24 AMDie Dinge bewegen sich stetig zu diesem Punkt. Die Investition, die in Quantendienstleister und Startups einfließt, zeigt, dass die Industrie ihre Bedeutung versteht. Und eine wachsende Anzahl realer Anwendungsfälle entsteht, um seinen Wert zu demonstrieren

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

ZendStudio 13.5.1 Mac

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

EditPlus chinesische Crack-Version

Geringe Größe, Syntaxhervorhebung, unterstützt keine Code-Eingabeaufforderungsfunktion

Sicherer Prüfungsbrowser

Safe Exam Browser ist eine sichere Browserumgebung für die sichere Teilnahme an Online-Prüfungen. Diese Software verwandelt jeden Computer in einen sicheren Arbeitsplatz. Es kontrolliert den Zugriff auf alle Dienstprogramme und verhindert, dass Schüler nicht autorisierte Ressourcen nutzen.

Dreamweaver CS6

Visuelle Webentwicklungstools