Heim >Technologie-Peripheriegeräte >KI >Yancore Digital veröffentlicht ein groß angelegtes Nicht-Attention-Mechanismusmodell, das die Offline-Bereitstellung auf der Geräteseite unterstützt

Yancore Digital veröffentlicht ein groß angelegtes Nicht-Attention-Mechanismusmodell, das die Offline-Bereitstellung auf der Geräteseite unterstützt

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2024-01-26 08:24:061336Durchsuche

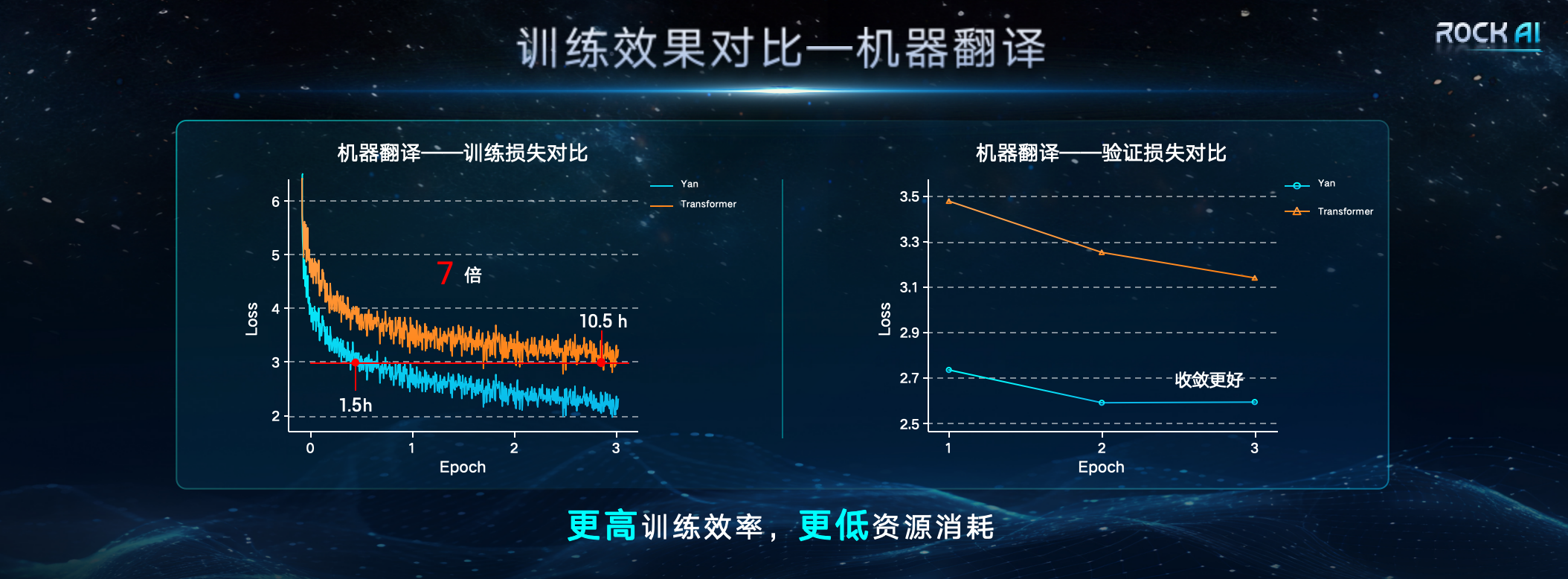

Am 24. Januar startete Shanghai Yanxinshuzhi Artificial Intelligence Technology Co., Ltd. ein großes allgemeines natürliches Sprachmodell ohne Aufmerksamkeitsmechanismus – das Yan-Modell. Laut der Pressekonferenz von Yancore Digital Intelligence verwendet das Yan-Modell eine neue selbst entwickelte „Yan-Architektur“, um die Transformer-Architektur zu ersetzen. Im Vergleich zur Transformer-Architektur verfügt die Yan-Architektur über eine um das Dreifache erhöhte Speicherkapazität und eine um das Siebenfache erhöhte Geschwindigkeit Zeiten bei gleichzeitiger Verbesserung des Inferenzdurchsatzes um das Fünffache.  Liu Fanping, CEO von Yancore Digital Intelligence, glaubt, dass die hohe Rechenleistung und die hohen Kosten von Transformer, das für seine große Reichweite in der Praxis bekannt ist, viele kleine und mittlere Unternehmen entmutigt haben. Die Komplexität seiner internen Architektur macht es schwierig, den Entscheidungsprozess zu erklären; die Schwierigkeit, lange Sequenzen zu verarbeiten, und das Problem unkontrollierbarer Halluzinationen schränken auch die breite Anwendung großer Modelle in bestimmten Schlüsselbereichen und speziellen Szenarien ein. Mit der Popularisierung von Cloud Computing und Edge Computing wächst die Nachfrage der Branche nach groß angelegten KI-Modellen mit hoher Leistung und geringem Energieverbrauch.

Liu Fanping, CEO von Yancore Digital Intelligence, glaubt, dass die hohe Rechenleistung und die hohen Kosten von Transformer, das für seine große Reichweite in der Praxis bekannt ist, viele kleine und mittlere Unternehmen entmutigt haben. Die Komplexität seiner internen Architektur macht es schwierig, den Entscheidungsprozess zu erklären; die Schwierigkeit, lange Sequenzen zu verarbeiten, und das Problem unkontrollierbarer Halluzinationen schränken auch die breite Anwendung großer Modelle in bestimmten Schlüsselbereichen und speziellen Szenarien ein. Mit der Popularisierung von Cloud Computing und Edge Computing wächst die Nachfrage der Branche nach groß angelegten KI-Modellen mit hoher Leistung und geringem Energieverbrauch.

„Weltweit haben viele herausragende Forscher versucht, die übermäßige Abhängigkeit von der Transformer-Architektur grundlegend zu lösen und nach besseren Möglichkeiten zu suchen, Transformer zu ersetzen. Sogar Llion Jones, einer der Autoren des Transformer-Artikels, untersucht ebenfalls „Möglichkeiten nach Transformer“. versucht, eine von der Natur inspirierte intelligente Methode zu verwenden, die auf evolutionären Prinzipien basiert, um eine Neudefinition des KI-Frameworks aus verschiedenen Blickwinkeln zu erstellen des Yan-Architekturmodells sind 7-mal bzw. 5-mal so groß wie die der Transformer-Architektur, und die Speicherkapazität ist um das Dreifache verbessert. Das Design der Yan-Architektur sorgt dafür, dass die räumliche Komplexität des Yan-Modells während der Inferenz konstant bleibt. Daher schneidet das Yan-Modell auch bei den langen Sequenzproblemen des Transformers gut ab. Vergleichsdaten zeigen, dass auf einer einzelnen 4090 24G-Grafikkarte das Transformer-Modell unter unzureichendem Videospeicher leidet, wenn die Länge des Modellausgabetokens 2600 überschreitet, während die Videospeichernutzung des Yan-Modells immer stabil bei etwa 14G liegt Ermöglicht theoretisch die Inferenz unendlicher Länge.

Darüber hinaus entwickelte das Forschungsteam eine sinnvolle Korrelationscharakteristikfunktion und einen Speicheroperator in Kombination mit linearen Berechnungsmethoden, um die Komplexität der internen Struktur des Modells zu reduzieren. Das Yan-Modell unter der neuen Architektur wird die „uninterpretierbare Blackbox“ der natürlichen Sprachverarbeitung in der Vergangenheit öffnen, die Transparenz und Erklärbarkeit des Entscheidungsprozesses vollständig erforschen und so die weit verbreitete Verwendung großer Modelle in Hochrisikobereichen erleichtern wie medizinische Versorgung, Finanzen und Recht.

Darüber hinaus entwickelte das Forschungsteam eine sinnvolle Korrelationscharakteristikfunktion und einen Speicheroperator in Kombination mit linearen Berechnungsmethoden, um die Komplexität der internen Struktur des Modells zu reduzieren. Das Yan-Modell unter der neuen Architektur wird die „uninterpretierbare Blackbox“ der natürlichen Sprachverarbeitung in der Vergangenheit öffnen, die Transparenz und Erklärbarkeit des Entscheidungsprozesses vollständig erforschen und so die weit verbreitete Verwendung großer Modelle in Hochrisikobereichen erleichtern wie medizinische Versorgung, Finanzen und Recht.

Das obige ist der detaillierte Inhalt vonYancore Digital veröffentlicht ein groß angelegtes Nicht-Attention-Mechanismusmodell, das die Offline-Bereitstellung auf der Geräteseite unterstützt. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Ist PHP schwer zu erlernen? Wie lange dauert es, PHP vom Einstieg bis zur Beherrschung zu erlernen?

- Zusammenfassung der PHP-Grundkenntnisse (notwendig für Anfänger zum Einstieg)

- Welche Bücher sollte ich lesen, um Java von Grund auf zu lernen? Empfohlene fortgeschrittene Java-Bücher

- Empfohlene 5 klassische Einführungsbücher in die Programmierung im Jahr 2018

- Einführungs-Tutorial zur Verwendung des Linux-Systems