Technologie-Peripheriegeräte

Technologie-Peripheriegeräte KI

KI Eine eingehende Analyse kontradiktorischer Lerntechniken beim maschinellen Lernen

Eine eingehende Analyse kontradiktorischer Lerntechniken beim maschinellen LernenEine eingehende Analyse kontradiktorischer Lerntechniken beim maschinellen Lernen

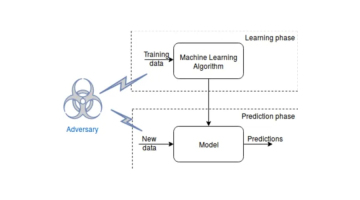

Adversarial Learning ist eine Technik des maschinellen Lernens, die die Robustheit eines Modells durch kontroverses Training verbessert. Der Zweck dieser Trainingsmethode besteht darin, das Modell durch die absichtliche Einführung anspruchsvoller Stichproben zu ungenauen oder falschen Vorhersagen zu veranlassen. Auf diese Weise kann sich das trainierte Modell besser an Änderungen in realen Daten anpassen und dadurch die Stabilität seiner Leistung verbessern.

Gegnerische Angriffe auf Modelle des maschinellen Lernens

Angriffe auf Modelle des maschinellen Lernens können in zwei Kategorien unterteilt werden: White-Box-Angriffe und Black-Box-Angriffe. Ein White-Box-Angriff bedeutet, dass der Angreifer auf die Struktur und Parameter des Modells zugreifen kann, um den Angriff durchzuführen, während ein Black-Box-Angriff bedeutet, dass der Angreifer nicht auf diese Informationen zugreifen kann. Zu den gebräuchlichen gegnerischen Angriffsmethoden gehören die Fast Gradient Sign Method (FGSM), die Basic Iterative Method (BIM) und der auf der Jacobi-Matrix basierende Salienzkartenangriff (JSMA).

Warum ist kontradiktorisches Lernen wichtig, um die Modellrobustheit zu verbessern?

Gegnerisches Lernen spielt eine wichtige Rolle bei der Verbesserung der Modellrobustheit. Es kann dabei helfen, Modelle besser zu verallgemeinern und Datenstrukturen zu identifizieren und sich an sie anzupassen, wodurch die Robustheit verbessert wird. Darüber hinaus kann kontradiktorisches Lernen Modellschwächen aufdecken und Hinweise zur Verbesserung des Modells geben. Daher ist kontradiktorisches Lernen für das Modelltraining und die Modelloptimierung von entscheidender Bedeutung.

Wie kann man kontradiktorisches Lernen in Modelle für maschinelles Lernen integrieren?

Die Integration von kontradiktorischem Lernen in ein Modell für maschinelles Lernen erfordert zwei Schritte: Generierung von kontradiktorischen Beispielen und Einbindung dieser Beispiele in den Trainingsprozess.

Generierung und Training von kontradiktorischen Beispielen

Es gibt viele Möglichkeiten, Informationen zu generieren, einschließlich gradientenbasierter Methoden, genetischer Algorithmen und verstärkendem Lernen. Unter diesen werden am häufigsten Gradientenmethoden verwendet. Bei dieser Methode wird der Gradient der Eingabeverlustfunktion berechnet und die Informationen basierend auf der Richtung des Gradienten angepasst, um den Verlust zu erhöhen.

Gegnerische Beispiele können durch gegnerisches Training und gegnerische Verbesserung in den Trainingsprozess integriert werden. Während des Trainings werden kontroverse Beispiele verwendet, um Modellparameter zu aktualisieren und gleichzeitig die Robustheit des Modells zu verbessern, indem den Trainingsdaten kontroverse Beispiele hinzugefügt werden.

Augmented Data ist eine einfache und effektive praktische Methode, die häufig zur Verbesserung der Modellleistung eingesetzt wird. Die Grundidee besteht darin, kontradiktorische Beispiele in die Trainingsdaten einzuführen und das Modell dann anhand der erweiterten Daten zu trainieren. Das trainierte Modell ist in der Lage, die Klassenbezeichnungen von ursprünglichen und kontradiktorischen Beispielen genau vorherzusagen, wodurch es robuster gegenüber Änderungen und Verzerrungen in den Daten wird. Diese Methode ist in der Praxis sehr verbreitet.

Anwendungsbeispiele für kontradiktorisches Lernen

Kontradiktorisches Lernen wurde auf eine Vielzahl maschineller Lernaufgaben angewendet, darunter Computer Vision, Spracherkennung und Verarbeitung natürlicher Sprache.

Um im Bereich Computer Vision die Robustheit von Bildklassifizierungsmodellen zu verbessern, kann die Anpassung der Robustheit von Convolutional Neural Networks (CNN) die Genauigkeit unsichtbarer Daten verbessern.

Gegnerisches Lernen spielt eine Rolle bei der Verbesserung der Robustheit von automatischen Spracherkennungssystemen (ASR) bei der Spracherkennung. Bei der Methode werden kontradiktorische Beispiele verwendet, um das eingegebene Sprachsignal so zu verändern, dass es für Menschen nicht wahrnehmbar ist, das ASR-System es jedoch falsch transkribiert. Untersuchungen zeigen, dass gegnerisches Training die Robustheit von ASR-Systemen gegenüber diesen gegnerischen Beispielen verbessern und dadurch die Erkennungsgenauigkeit und -zuverlässigkeit verbessern kann.

Bei der Verarbeitung natürlicher Sprache wurde kontradiktorisches Lernen eingesetzt, um die Robustheit von Stimmungsanalysemodellen zu verbessern. Kontroverse Beispiele in diesem Bereich des NLP zielen darauf ab, Eingabetext so zu manipulieren, dass falsche und ungenaue Modellvorhersagen entstehen. Es hat sich gezeigt, dass gegnerisches Training Sentiment-Analysemodelle robuster gegenüber dieser Art von gegnerischen Beispielen macht, was zu einer verbesserten Genauigkeit und Robustheit führt.

Das obige ist der detaillierte Inhalt vonEine eingehende Analyse kontradiktorischer Lerntechniken beim maschinellen Lernen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Der neue KI -Assistent von Meta: Produktivitätswahrnehmung oder Zeitspüle?May 01, 2025 am 11:18 AM

Der neue KI -Assistent von Meta: Produktivitätswahrnehmung oder Zeitspüle?May 01, 2025 am 11:18 AMMeta hat sich mit Partnern wie Nvidia, IBM und Dell zusammengetan, um die Einsatzintegration von Lama Stack auf Unternehmensebene zu erweitern. In Bezug auf die Sicherheit hat Meta neue Tools wie Llam Guard 4, Llamafirewall und Cyberseceval 4 auf den Markt gebracht und das Lama Defenders -Programm gestartet, um die KI -Sicherheit zu verbessern. Darüber hinaus hat Meta 1,5 Millionen US -Dollar an Lama -Impact -Zuschüssen an 10 globale Institutionen verteilt, darunter Startups, die an der Verbesserung der öffentlichen Dienste, der Gesundheitsversorgung und der Bildung arbeiten. Die neue Meta -AI -Anwendung von Lama 4, die als Meta AI konzipiert wurde

80% der Gen -Zers würden eine KI heiraten: StudiumMay 01, 2025 am 11:17 AM

80% der Gen -Zers würden eine KI heiraten: StudiumMay 01, 2025 am 11:17 AMJoi Ai, eine Firma Pionierin der Human-AI-Interaktion, hat den Begriff "AI-Lationships" eingeführt, um diese sich entwickelnden Beziehungen zu beschreiben. Jaime Bronstein, ein Beziehungstherapeut bei Joi AI, stellt klar, dass diese nicht dazu gedacht sind, das Menschen C zu ersetzen C.

AI verschlimmert das Bot -Problem des Internets. Dieses Startup von 2 Milliarden US -Dollar liegt an vorderster FrontMay 01, 2025 am 11:16 AM

AI verschlimmert das Bot -Problem des Internets. Dieses Startup von 2 Milliarden US -Dollar liegt an vorderster FrontMay 01, 2025 am 11:16 AMOnline -Betrug und Bot -Angriffe stellen eine bedeutende Herausforderung für Unternehmen dar. Einzelhändler bekämpfen Bots, die Produkte horten, Banken Battle Account Takeovers und Social -Media -Plattformen kämpfen mit Imitatoren. Der Aufstieg von AI verschärft dieses Problem, das Rende

Verkauf an Roboter: Die Marketing -Revolution, die Ihr Geschäft herstellt oder brechen wirdMay 01, 2025 am 11:15 AM

Verkauf an Roboter: Die Marketing -Revolution, die Ihr Geschäft herstellt oder brechen wirdMay 01, 2025 am 11:15 AMAI -Agenten sind bereit, das Marketing zu revolutionieren und möglicherweise die Auswirkungen früherer technologischer Verschiebungen zu übertreffen. Diese Agenten, die einen signifikanten Fortschritt in der generativen KI darstellen, verarbeiten nicht nur Informationen wie Chatgpt, sondern auch Actio

Wie die Computer -Vision -Technologie NBA Playoff amtiertMay 01, 2025 am 11:14 AM

Wie die Computer -Vision -Technologie NBA Playoff amtiertMay 01, 2025 am 11:14 AMDie Auswirkungen der KI auf wichtige Entscheidungen von NBA Game 4 Zwei entscheidende NBA-Matchups in Game 4 zeigten die bahnbrechende Rolle der KI beim Amtieren. Im ersten Fall führte Denvers verpasste Drei-Zeiger von Nikola Jokic zu einer Gasse in der letzten Sekunden von Aaron Gordon. Sony's Haw

Wie KI die Zukunft der regenerativen Medizin beschleunigtMay 01, 2025 am 11:13 AM

Wie KI die Zukunft der regenerativen Medizin beschleunigtMay 01, 2025 am 11:13 AMTraditionell forderte die weltweit expandierende Expertin der regenerativen Medizin umfangreiche Reisen, praktische Ausbildung und jahrelange Mentoring. Jetzt verändert AI diese Landschaft, überwindet geografische Einschränkungen und beschleunigte Fortschritte durch EN

Key Takeaways von Intel Foundry Direct Connect 2025May 01, 2025 am 11:12 AM

Key Takeaways von Intel Foundry Direct Connect 2025May 01, 2025 am 11:12 AMIntel arbeitet daran, seinen Herstellungsprozess in die führende Position zurückzugeben, während er versucht, Fab -Semiconductor -Kunden anzuziehen, um Chips an seinen Fabriken herzustellen. Zu diesem Zweck muss Intel mehr Vertrauen in die Branche aufbauen, um nicht nur die Wettbewerbsfähigkeit seiner Prozesse zu beweisen, sondern auch zu demonstrieren, dass Partner Chips in einer vertrauten und ausgereiften Workflow, konsistente und sehr zuverlässige Weise herstellen können. Alles, was ich heute höre, lässt mich glauben, dass Intel dieses Ziel zu diesem Ziel bewegt. Die Keynote -Rede des neuen CEO Tan Libai begann den Tag. Tan Libai ist unkompliziert und prägnant. Er skizziert mehrere Herausforderungen in den Foundry -Diensten von Intel und die Maßnahmen, die Unternehmen ergriffen haben, um diese Herausforderungen zu bewältigen und einen erfolgreichen Weg für Intel Foundry Services in Zukunft zu planen. Tan Libai sprach über den Prozess des OEM -Dienstes von Intel, um Kunden mehr zu machen

Ai schief gegangen? Jetzt ist dafür eine Versicherung dafürMay 01, 2025 am 11:11 AM

Ai schief gegangen? Jetzt ist dafür eine Versicherung dafürMay 01, 2025 am 11:11 AMDie Chaucer Group, ein globales Spezialversicherungsunternehmen, und Armilla AI haben sich mit den wachsenden Bedenken hinsichtlich der KI-Risiken befassen, und Armilla AI haben sich zusammengeschlossen, um ein neuartiges Versicherungsprodukt von Drittanbietern (TPL) einzubringen. Diese Richtlinie schützt Unternehmen vor

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

SecLists

SecLists ist der ultimative Begleiter für Sicherheitstester. Dabei handelt es sich um eine Sammlung verschiedener Arten von Listen, die häufig bei Sicherheitsbewertungen verwendet werden, an einem Ort. SecLists trägt dazu bei, Sicherheitstests effizienter und produktiver zu gestalten, indem es bequem alle Listen bereitstellt, die ein Sicherheitstester benötigen könnte. Zu den Listentypen gehören Benutzernamen, Passwörter, URLs, Fuzzing-Payloads, Muster für vertrauliche Daten, Web-Shells und mehr. Der Tester kann dieses Repository einfach auf einen neuen Testcomputer übertragen und hat dann Zugriff auf alle Arten von Listen, die er benötigt.

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Dreamweaver Mac

Visuelle Webentwicklungstools