Technologie-Peripheriegeräte

Technologie-Peripheriegeräte KI

KI Richtlinieniteration und Werteiteration: Schlüsselmethoden des verstärkenden Lernens

Richtlinieniteration und Werteiteration: Schlüsselmethoden des verstärkenden LernensRichtlinieniteration und Werteiteration: Schlüsselmethoden des verstärkenden Lernens

Richtlinieniteration und Wertiteration sind zwei Algorithmen, die häufig beim verstärkenden Lernen verwendet werden. Durch die Richtlinieniteration wird die Leistung des Agenten durch iterative Verbesserung der Richtlinie verbessert. Die Wertiteration aktualisiert die Zustandswertfunktion iterativ, um den optimalen Zustandswert zu erhalten. Die Kernideen der beiden sind unterschiedlich, aber beide können eine Rolle bei der Optimierung von Strategien bei verstärkenden Lernaufgaben spielen.

Strategieiteration

Die Strategieiteration verbessert die Strategie schrittweise durch Iteration, bis eine stabile Strategie erreicht ist. Bei der Richtlinieniteration wird eine Richtlinie zunächst initialisiert und dann durch mehrere Iterationen schrittweise verbessert. Jede Iteration besteht aus zwei Schritten: der Bewertung der aktuellen Strategie und der Verbesserung der aktuellen Strategie. Der Zweck der Bewertung der aktuellen Strategie besteht darin, den erwarteten Belohnungswert der aktuellen Strategie zu berechnen, der durch die Monte-Carlo-Methode oder die zeitliche Differenzmethode erreicht werden kann. Der Zweck der Verbesserung der aktuellen Richtlinie besteht darin, eine bessere Richtlinie als Ersatz für die aktuelle Richtlinie zu finden. Dies kann durch die deterministische Richtliniengradientenmethode oder die Monte-Carlo-Richtliniengradientenmethode erreicht werden.

Wertiteration

Wertiteration besteht darin, die Zustandswertfunktion schrittweise durch Iteration zu aktualisieren, um eine stabile Zustandswertfunktion zu erreichen. Bei der Wertiteration muss zunächst eine Zustandswertfunktion initialisiert werden, und dann wird die Funktion durch mehrere Iterationen schrittweise aktualisiert. Jede Iteration besteht aus zwei Schritten: Berechnen des erwarteten Belohnungswerts der aktuellen Zustandswertfunktion und Aktualisieren der aktuellen Zustandswertfunktion. Der Zweck der Berechnung des erwarteten Belohnungswerts der aktuellen Zustandswertfunktion besteht darin, den erwarteten Belohnungswert jedes Zustands zu bestimmen, der durch die Monte-Carlo-Methode oder die zeitliche Differenzmethode erreicht werden kann. Die Monte-Carlo-Methode schätzt den erwarteten Belohnungswert durch Simulation mehrerer tatsächlicher Erfahrungen, während die zeitliche Differenzmethode die Differenz zwischen der aktuellen Schätzung und der Schätzung des nächsten Zustands verwendet, um den erwarteten Belohnungswert zu aktualisieren. Der Zweck der Aktualisierung der aktuellen Zustandswertfunktion besteht darin, eine bessere Zustandswertfunktion als Ersatz für die aktuelle Funktion zu finden, was durch die Bellman-Gleichung erreicht werden kann. Die Bellman-Gleichung berechnet die Wertfunktion des aktuellen Zustands, indem sie die Belohnung des aktuellen Zustands mit der erwarteten Belohnung des nächsten Zustands akkumuliert. Durch kontinuierliche Anwendung der Bellman-Gleichung kann die Zustandswertfunktion schrittweise aktualisiert werden, bis eine stabile Zustandswertfunktion erreicht ist. Die Werteiteration ist eine effiziente Methode zum Finden optimaler Richtlinien beim Reinforcement Learning. Durch die schrittweise Aktualisierung der Zustandswertfunktion kann die Wertiteration eine optimale Richtlinie finden, die die kumulative Belohnung maximiert.

Der Unterschied zwischen Richtlinieniteration und Werteiteration

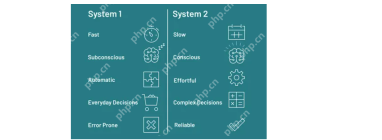

Obwohl Richtlinieniteration und Werteiteration häufig verwendete Methoden beim Reinforcement Learning sind, gibt es offensichtliche Unterschiede in ihren Implementierungsmethoden und Zielen.

1. Implementierungsmethode

Strategieiteration ist eine strategiebasierte Methode, die durch kontinuierliche Aktualisierung der Strategie die optimale Strategie findet. Konkret besteht die Strategieiteration aus zwei Schritten: Strategiebewertung und Strategieverbesserung. Bei der Richtlinienbewertung bewerten wir die Wertfunktion jedes Staates anhand der aktuellen Richtlinie. Bei der Richtlinienverbesserung aktualisieren wir die Richtlinie basierend auf der Wertfunktion des aktuellen Status, um die Richtlinie näher an die optimale Richtlinie heranzuführen.

Wertiteration ist eine auf Wertfunktionen basierende Methode, die durch kontinuierliche Aktualisierung der Wertfunktion die optimale Strategie findet. Insbesondere aktualisiert die Wertiteration die Wertfunktion jedes Zustands iterativ, bis die Wertfunktion konvergiert. Dann können wir die optimale Strategie basierend auf der Endwertfunktion erhalten.

2. Ziel

Das Ziel der Strategieiteration ist die direkte Optimierung der Strategie und die Annäherung an die optimale Strategie durch kontinuierliche iterative Aktualisierung der Strategie. Da jedoch jede Iteration eine Richtlinienbewertung und Richtlinienverbesserung erfordert, ist der Berechnungsaufwand groß.

Das Ziel der Wertiteration besteht darin, durch Optimierung der Zustandswertfunktion die optimale Strategie zu erhalten. Es nähert sich der optimalen Wertfunktion an, indem es die Wertfunktion jedes Zustands kontinuierlich aktualisiert, und leitet dann die optimale Strategie basierend auf dieser optimalen Wertfunktion ab. Im Vergleich zur Richtlinieniteration erfordert die Wertiteration weniger Berechnungen.

3. Konvergenzgeschwindigkeit

Im Allgemeinen konvergieren Richtlinieniterationen normalerweise schneller zur optimalen Richtlinie, aber jede Iteration erfordert normalerweise mehr Berechnungen. Für die Wertiteration sind möglicherweise weitere Iterationen erforderlich, um zu konvergieren.

4. Interaktion mit anderen Techniken

Wertiteration lässt sich leichter mit Funktionsnäherungsmethoden (z. B. Deep Learning) kombinieren, da sie sich auf die Optimierung von Wertfunktionen konzentriert. Richtlinieniteration wird häufiger in Szenarien mit klaren Modellen verwendet.

Das obige ist der detaillierte Inhalt vonRichtlinieniteration und Werteiteration: Schlüsselmethoden des verstärkenden Lernens. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Potenzielle Medicaid -Kürzungen bedrohen die mütterliche GesundheitsversorgungApr 17, 2025 am 11:18 AM

Potenzielle Medicaid -Kürzungen bedrohen die mütterliche GesundheitsversorgungApr 17, 2025 am 11:18 AMDas Repräsentantenhaus und der Senat stimmten am Wochenende einem Haushaltsrahmen zu. Der Rahmen erfordert Ausgabenkürzungen, um Steuersenkungen zu bezahlen, die überproportional zu den Reichen und den Geldern gehen, um steigende Defizite zu verhindern und gleichzeitig zu erhöhen

Laut Snowflake -CEO beginnt AI ROI damit, die Daten richtig zu machenApr 17, 2025 am 11:13 AM

Laut Snowflake -CEO beginnt AI ROI damit, die Daten richtig zu machenApr 17, 2025 am 11:13 AM"KI sollte kein Urknall sein", sagte mir der CEO von Snowflake in einem Sit-Down. "Es sollte eine Reihe kleiner Projekte sein, die jeden Schritt des Weges angeben." Aber wie Ramaswamy feststellte, ist dies zwar Vorsicht, aber es ist tatsächlich Strategie. In der Inter

20.000 AI-generierte Songs, die jeden Tag auf Deezer hochgeladen wurdenApr 17, 2025 am 11:11 AM

20.000 AI-generierte Songs, die jeden Tag auf Deezer hochgeladen wurdenApr 17, 2025 am 11:11 AM"Die KI erzeugte Inhalte, die weiterhin Streaming -Plattformen wie Deezer überfluten, und wir sehen kein Anzeichen dafür, dass es langsamer wird", sagte Aurelien Herault, Chief Innovation Officer von Deezer, in einer Erklärung. Obwohl es keine Anzeichen für die Überschwemmung gibt, hat Deezer

Von Stadien bis hin zu Seitenlinien: Wie KI die Zukunft des Sports neu erfindenApr 17, 2025 am 11:10 AM

Von Stadien bis hin zu Seitenlinien: Wie KI die Zukunft des Sports neu erfindenApr 17, 2025 am 11:10 AMUnd diese Transformation ist nicht mehr theoretisch. Die Kraft -Gruppe - Inhaber der New England Patriots, New England Revolution und Gillette Stadium - hat gerade eine strategische Partnerschaft mit NWN zur Modernisierung und Transformation von Technologie in der gesamten KR angekündigt

Was ist Kette von Fragen im schnellen Ingenieurwesen? - Analytics VidhyaApr 17, 2025 am 11:06 AM

Was ist Kette von Fragen im schnellen Ingenieurwesen? - Analytics VidhyaApr 17, 2025 am 11:06 AMKette von Fragen: revolutionieren prompt Engineering Stellen Sie sich ein Gespräch mit einer KI vor, in der jede Frage auf dem vorherigen aufbaut, was zu immer aufschlussreicheren Antworten führt. Dies ist die Kraft der Kette von Fragen (COQ) in der schnellen Technik

Zugriff auf Mistral NEMO: Funktionen, Anwendungen und AuswirkungenApr 17, 2025 am 11:04 AM

Zugriff auf Mistral NEMO: Funktionen, Anwendungen und AuswirkungenApr 17, 2025 am 11:04 AMMistral Nemo: Eine mächtige Open-Source-mehrsprachige LLM Mistral AI und Nvidias Zusammenarbeit, Mistral Nemo, ist ein hochmodernes Open-Source-Großsprachmodell (LLM), das modernste Verarbeitung natürlicher Sprache liefert. Dieser 12-Milliarden Par

Was ist die runde Funktion in Excel? - Analytics VidhyaApr 17, 2025 am 10:56 AM

Was ist die runde Funktion in Excel? - Analytics VidhyaApr 17, 2025 am 10:56 AMBeherrschen der runden Funktion von Microsoft Excel für präzise numerische Daten Zahlen sind für Tabellenkalkulationen von grundlegender Bedeutung, aber die Genauigkeit und Lesbarkeit erfordert häufig mehr als nur Rohdaten. Die runde Funktion von Microsoft Excel ist ein leistungsstarkes Werkzeug für TRA

Ein Leitfaden für Reflexionsmittel mit LamaindexApr 17, 2025 am 10:41 AM

Ein Leitfaden für Reflexionsmittel mit LamaindexApr 17, 2025 am 10:41 AMVerbesserung der AI -Intelligenz: Ein tiefes Eintauchen in reflektierende AI -Agenten mit Llamaindex Stellen Sie sich eine KI vor, die nicht nur Probleme löst, sondern auch über ihren eigenen Denkprozess nachwirkt, um sich zu verbessern. Dies ist der Bereich reflektierender KI -Agenten, und dieser Artikel untersucht

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

WebStorm-Mac-Version

Nützliche JavaScript-Entwicklungstools

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

EditPlus chinesische Crack-Version

Geringe Größe, Syntaxhervorhebung, unterstützt keine Code-Eingabeaufforderungsfunktion

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

VSCode Windows 64-Bit-Download

Ein kostenloser und leistungsstarker IDE-Editor von Microsoft