Heim >Technologie-Peripheriegeräte >KI >NetEase Fuxi hat im ICLR 2023 drei Arbeiten ausgewählt, die Bereiche wie Reinforcement Learning und Natural Language Processing abdecken.

NetEase Fuxi hat im ICLR 2023 drei Arbeiten ausgewählt, die Bereiche wie Reinforcement Learning und Natural Language Processing abdecken.

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2024-01-22 20:57:06915Durchsuche

Die 11. Internationale Konferenz zum Repräsentationslernen (ICLR) wird voraussichtlich vom 1. bis 5. Mai offline in Kigali, der Hauptstadt Ruandas, stattfinden. Kürzlich gab das ICLR die Ergebnisse der Papierannahme bekannt, darunter insgesamt drei Papiere von NetEase Fuxi. Von diesen drei Vorträgen wurde einer als mündlicher Vortragsvortrag und die anderen beiden als Spotlight-Vortragsvortrag ausgewählt. Der Inhalt dieser Arbeiten umfasst viele Bereiche wie Verstärkungslernen und Verarbeitung natürlicher Sprache. Diese Papierauswahl ist eine wichtige Errungenschaft des NetEase Fuxi-Teams in diesen Forschungsrichtungen und auch ihre Anerkennung und ihr herausragender Beitrag in der akademischen Welt.

Experimente zeigen, dass KLD empfindlicher auf abnormale Punkte reagiert, während TCD robuster ist.

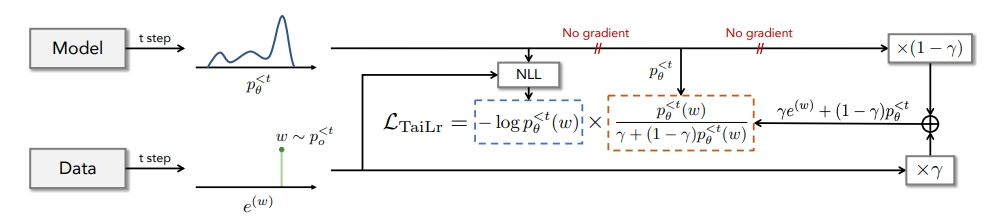

Um die TVD-Schätzung auszugleichen, führen wir das TaiLr-Ziel ein. TaiLr erreicht dieses Ziel, indem das Gewicht realer Datenstichproben mit geringer Modellwahrscheinlichkeit reduziert wird und die Strafstärke nach Bedarf angepasst werden kann. Experimente zeigen, dass unsere Methode die Überschätzung degenerierter Sequenzen unter Beibehaltung der Diversität verringert und die Generierungsqualität für ein breites Spektrum von Textgenerierungsaufgaben verbessert.

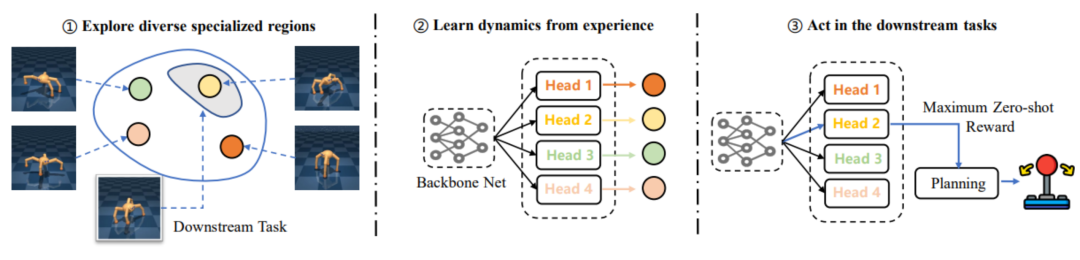

Frühere Arbeiten konzentrierten sich jedoch häufig auf das Vortraining einer Strategie mit unterschiedlichen Fähigkeiten durch Erkundung der Umgebung. Es ist jedoch schwierig, die Leistungsverbesserung nachgelagerter Aufgaben durch abwechslungsreiche Erkundungsmethoden vor dem Training sicherzustellen, und kann sogar dazu führen zu einem höheren Verbrauch vor dem Training, je geringer die Leistung, desto größer das „Mismatch“-Problem. Daher schlugen NetEase Fuxi und das Team des Deep Reinforcement Learning Laboratory der Tianjin University das EUCLID-Framework vor, das ein modellbasiertes RL-Paradigma einführt, um durch langfristiges Vortraining von genauen dynamischen Modellen zu profitieren und so eine schnelle nachgelagerte Aufgabenanpassung und eine höhere Stichprobeneffizienz zu erreichen. In der Feinabstimmungsphase verwendet EUCLID vorab trainierte dynamische Modelle für die richtliniengesteuerte Planung. Diese Einstellung kann durch Nichtübereinstimmungsprobleme verursachte Leistungsschocks beseitigen und monotone Leistungsverbesserungen erzielen.

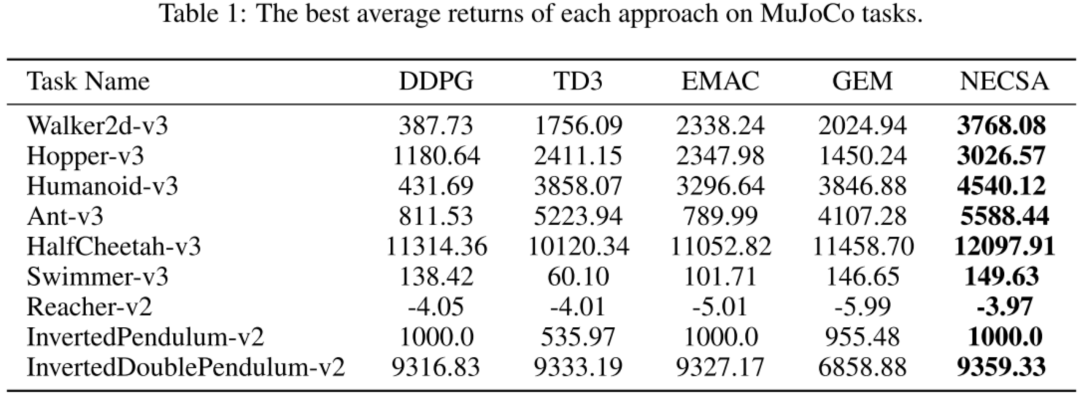

Die experimentellen Ergebnisse zeigen, dass NECSA in allen experimentellen Umgebungen die höchsten Punktzahlen erzielte und das State-of-the-Art-Niveau erreichte.

NECSA lässt sich leicht in Reinforcement-Learning-Algorithmen integrieren und ist äußerst vielseitig. Eines der typischen Anwendungsszenarien ist das Training von Spiel-Wettkampfrobotern. NECSA bietet eine neue Idee basierend auf der Zustandsanalyse, die den Lerneffekt verbessern kann und sich besonders für komplexe und hochdimensionale Spielzustandsdarstellungen eignet. Durch NECSA können das Wettbewerbsniveau und der Anthropomorphismus des Roboters besser und schneller optimiert und eine gute Modellinterpretierbarkeit bereitgestellt werden. Zukünftig wird NetEase Fuxi die praktische Anwendung der NECSA-Methode in mehreren Spielszenarien fördern.

Besonderer Dank geht an das Team von Professor Huang Minlie von der Tsinghua-Universität für ihren wichtigen Forschungsbeitrag zum Thema „Tailoring Language Generation Models under Total Variation Distance“. Ihre Forschungsarbeit hat wichtige Beiträge zur Anpassung von Sprachgenerierungsmodellen geleistet und neue Ideen und Methoden zur Verbesserung der Technologie zur Verarbeitung natürlicher Sprache geliefert. Gleichzeitig möchten wir dem Deep Reinforcement Learning Laboratory der Tianjin University für seinen wichtigen Forschungsbeitrag zu „EUCLID: Towards Efficient Unsupervised Reinforcement Learning with Multi-choice Dynamics Model“ danken. Ihre Forschungsarbeit konzentriert sich auf den Bereich des unbeaufsichtigten verstärkenden Lernens und schlägt ein effizientes dynamisches Multi-Choice-Modell vor, das wichtige Beiträge zur Entwicklung von Algorithmen für verstärkendes Lernen leistet. Darüber hinaus möchten wir dem Pangu-Labor der Kyushu-Universität für seinen wichtigen Forschungsbeitrag zum Thema „Neuronale episodische Kontrolle mit Zustandsabstraktion“ danken. Ihre Forschungsarbeit konzentriert sich auf die Gedächtniskontrolle und Zustandsabstraktion von Neuronen und schlägt eine neuartige Methode zur Neuronenkontrolle vor, die neue Ideen und technische Unterstützung für die Entwicklung und Anwendung intelligenter Systeme bietet. Die Beiträge dieser Forschungsteams sind nicht nur in der Wissenschaft wichtig, sondern haben auch potenzielle Auswirkungen auf praktische Anwendungen. Wir danken ihnen aufrichtig für ihre herausragende Arbeit und freuen uns auf ihren anhaltenden Erfolg in ihren jeweiligen Bereichen. Als führende inländische Forschungs- und Anwendungsinstitution für KI im Bereich Spiele und Unterhaltung ist NetEase Fuxi bestrebt, KI-Technologie und -Produkte für mehr zu öffnen Partner. Förderung der Anwendung der Technologie der künstlichen Intelligenz in verschiedenen Bereichen. Bisher haben sich mehr als 200 Kunden für die Dienste von NetEase Fuxi entschieden und die Zahl der Anrufe liegt täglich bei über Hunderten Millionen.

Das obige ist der detaillierte Inhalt vonNetEase Fuxi hat im ICLR 2023 drei Arbeiten ausgewählt, die Bereiche wie Reinforcement Learning und Natural Language Processing abdecken.. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- JavaScript-Maschinenlernen basierend auf TensorFlow.js

- Was bedeutet künstliche Intelligenz in Python?

- Was ist künstliche Intelligenz, maschinelles Lernen und Deep Learning?

- Zu welcher Kategorie gehört künstliche Intelligenz?

- Anwendungsfälle und Anwendungen für Datengitter in den Bereichen IoT, künstliche Intelligenz und maschinelles Lernen