Heim >Technologie-Peripheriegeräte >KI >Einführung in SqueezeNet und seine Eigenschaften

Einführung in SqueezeNet und seine Eigenschaften

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2024-01-22 19:15:161843Durchsuche

SqueezeNet ist ein kleiner und präziser Algorithmus, der eine gute Balance zwischen hoher Genauigkeit und geringer Komplexität schafft und sich daher ideal für mobile und eingebettete Systeme mit begrenzten Ressourcen eignet.

Im Jahr 2016 schlugen Forscher von DeepScale, der University of California, Berkeley und der Stanford University ein kompaktes und effizientes Convolutional Neural Network (CNN) vor – SqueezeNet. In den letzten Jahren haben Forscher mehrere Verbesserungen an SqueezeNet vorgenommen, darunter SqueezeNet v1.1 und SqueezeNet v2.0. Verbesserungen in beiden Versionen erhöhen nicht nur die Genauigkeit, sondern senken auch die Rechenkosten. SqueezeNet v1.1 verbessert die Genauigkeit des ImageNet-Datensatzes um 1,4 %, während SqueezeNet v2.0 die Genauigkeit um 1,8 % verbessert. Gleichzeitig wird die Anzahl der Parameter in diesen beiden Versionen um das 2,4-fache reduziert. Dies bedeutet, dass SqueezeNet die Komplexität des Modells und den Bedarf an Rechenressourcen reduzieren und gleichzeitig eine hohe Genauigkeit beibehalten kann. Aufgrund des kompakten Designs und des effizienten Betriebs von SqueezeNet bietet es große Vorteile in Szenarien mit begrenzten Rechenressourcen. Dadurch eignet sich SqueezeNet ideal für die Anwendung von Deep Learning in Edge-Geräten und eingebetteten Systemen. Durch kontinuierliche Verbesserung und Optimierung bietet SqueezeNet eine praktikable Lösung für effiziente Bildklassifizierungs- und Objekterkennungsaufgaben.

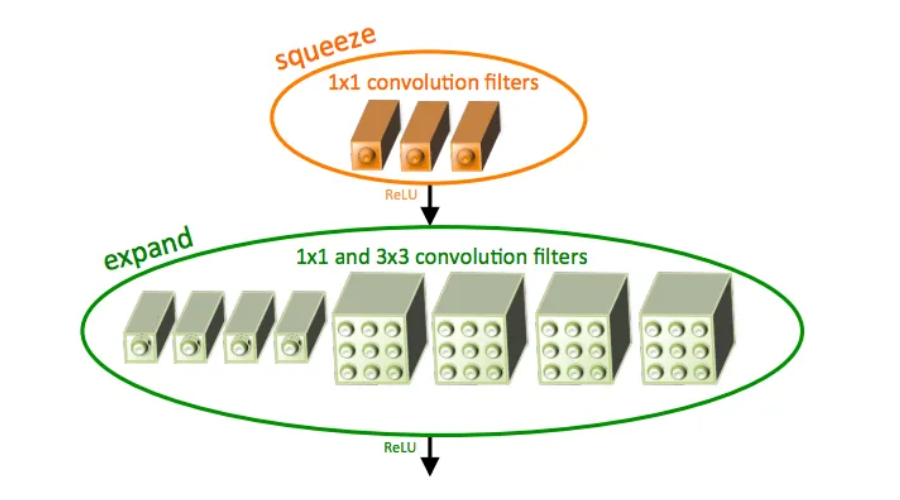

SqueezeNet verwendet das Feuermodul, eine spezielle Art von Faltungsschicht, die 1x1- und 3x3-Filter enthält und so die Anzahl der Parameter effektiv reduziert und gleichzeitig eine hohe Genauigkeit beibehält, was es ideal für Geräte mit eingeschränkten Ressourcen macht. Es ist in der Lage, mit nur einem Bruchteil der Rechenressourcen, die andere CNNs benötigen, hochpräzise Ergebnisse zu erzielen.

Ein großer Vorteil von SqueezeNet besteht darin, dass es ein Gleichgewicht zwischen Genauigkeit und Rechenressourcen schafft. Im Vergleich zu AlexNet wird die Anzahl der Parameter von SqueezeNet um das 50-fache reduziert und die Anforderungen an Gleitkommaoperationen pro Sekunde (FLOPS) werden um das 10-fache reduziert. Daher kann es auf Edge-Geräten mit begrenzten Rechenressourcen ausgeführt werden, wie z. B. Mobiltelefonen und IoT-Geräten. Diese Effizienz macht SqueezeNet ideal für Deep Learning in Umgebungen mit begrenzten Ressourcen.

SqueezeNet verwendet eine Methode namens Channel Squeezing, die eine der wichtigsten Innovationen dieser Technologie darstellt. Durch die Reduzierung der Anzahl der Kanäle in den Faltungsschichten des Modells reduziert SqueezeNet die Netzwerkrechenkosten und behält gleichzeitig die Genauigkeit bei. Neben anderen Methoden wie Feuermodulen und Tiefenkomprimierung verwendet SqueezeNet auch Kanalkomprimierung, um die Effizienz zu verbessern. Diese Methode kann die Anzahl der Parameter des Modells reduzieren, indem redundante Kanäle entfernt werden, wodurch der Rechenaufwand reduziert und die Ausführungsgeschwindigkeit des Modells verbessert wird. Diese Kanalquetschungsmethode reduziert effektiv die Rechenkosten des Netzwerks und behält gleichzeitig die Modellgenauigkeit bei, was SqueezeNet zu einem leichten und effizienten neuronalen Netzwerkmodell macht.

SqueezeNet erfordert im Gegensatz zu herkömmlichem CNN nicht viel Rechenleistung und kann mit Feature-Extraktoren in anderen Pipelines für maschinelles Lernen verwendet werden. Dadurch können andere Modelle von den von SqueezeNet erlernten Funktionen profitieren, was zu einer höheren Leistung auf Mobilgeräten führt.

SqueezeNet ist für seine architektonische Innovation und nachgewiesene Leistungsverbesserung bekannt und wurde von anderen CNN-Architekturen weitgehend übernommen.

Das obige ist der detaillierte Inhalt vonEinführung in SqueezeNet und seine Eigenschaften. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Algorithmus für künstliche neuronale Netzwerke

- Was ist ein künstlicher neuronaler Netzwerkalgorithmus?

- So implementieren Sie einen künstlichen neuronalen Netzwerkalgorithmus in PHP

- Künstliche Intelligenz: Einführung in das Wissen über Anwendungsszenarien künstlicher neuronaler Netze

- Wie schreibe ich künstliche neuronale Netzwerkalgorithmen in Python?