Heim >Technologie-Peripheriegeräte >KI >LeCuns Bewertung: Meta-Bewertung von ConvNet und Transformer, welches ist stärker?

LeCuns Bewertung: Meta-Bewertung von ConvNet und Transformer, welches ist stärker?

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2024-01-18 14:15:05770Durchsuche

Wie wählt man ein visuelles Modell basierend auf spezifischen Anforderungen aus?

Wie vergleichen sich ConvNet/ViT- und überwachte/CLIP-Modelle bei anderen Indikatoren als ImageNet?

Die neueste von Forschern von MABZUAI und Meta veröffentlichte Studie vergleicht umfassend gängige visuelle Modelle für „nicht standardmäßige“ Indikatoren.

Papieradresse: https://arxiv.org/pdf/2311.09215.pdf

LeCun lobte diese Forschung sehr und nannte sie eine ausgezeichnete Forschung. Die Studie vergleicht ConvNext- und VIT-Architekturen ähnlicher Größe und bietet einen umfassenden Vergleich verschiedener Eigenschaften beim Training im überwachten Modus und unter Verwendung von CLIP-Methoden.

Über die ImageNet-Genauigkeit hinaus

Die Computer-Vision-Modelllandschaft wird immer vielfältiger und komplexer.

Von frühen ConvNets bis zur Entwicklung von Vision Transformers werden die Arten der verfügbaren Modelle ständig erweitert.

In ähnlicher Weise haben sich Trainingsparadigmen von überwachtem Training auf ImageNet zu selbstüberwachtem Lernen und Bild-Text-Paar-Training wie CLIP entwickelt.

Beim Markieren von Fortschritten stellt diese Explosion an Optionen eine große Herausforderung für Praktiker dar: Wie wählen Sie das richtige Zielmodell für Sie aus?

Die ImageNet-Genauigkeit war schon immer der Hauptindikator für die Bewertung der Modellleistung. Seitdem es die Deep-Learning-Revolution ausgelöst hat, hat es bedeutende Fortschritte auf dem Gebiet der künstlichen Intelligenz vorangetrieben.

Es kann jedoch nicht die Nuancen von Modellen messen, die sich aus unterschiedlichen Architekturen, Trainingsparadigmen und Daten ergeben.

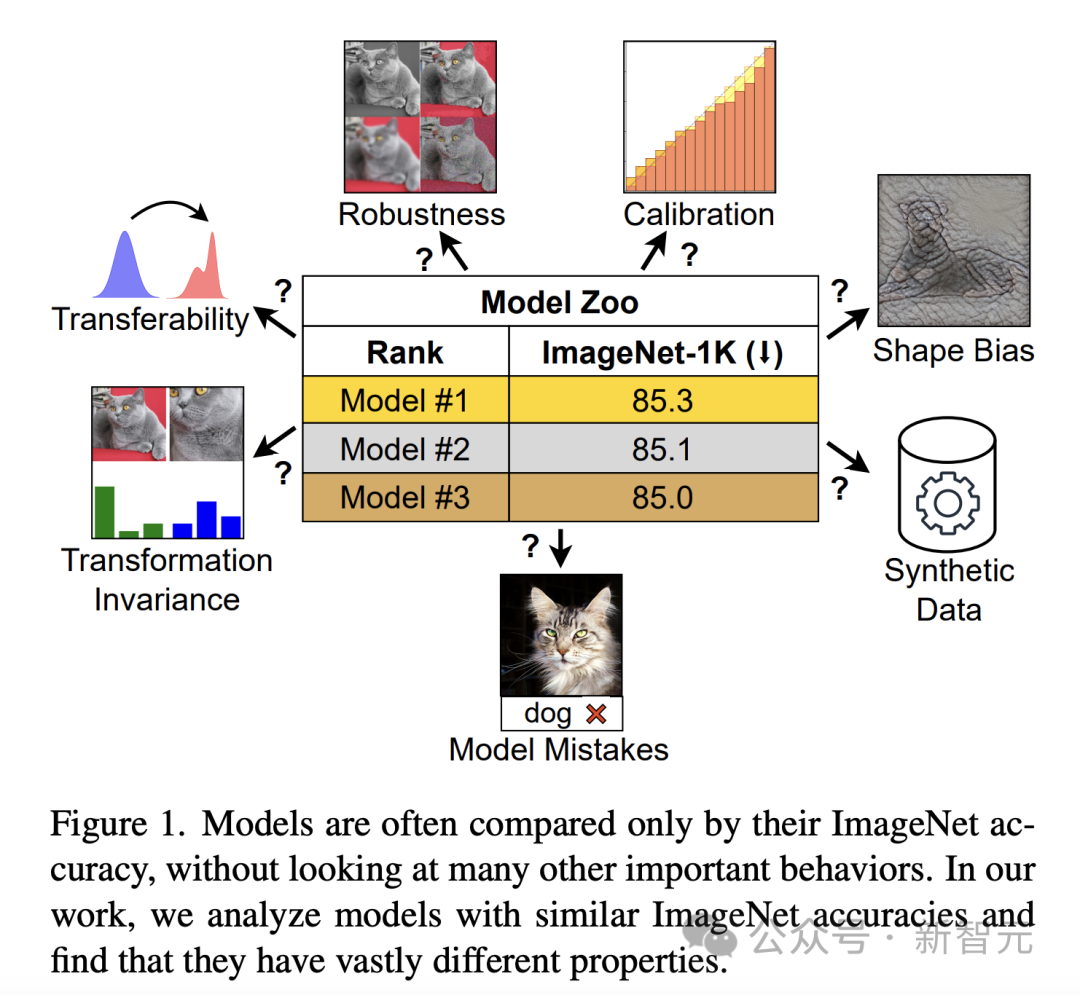

Wenn man ausschließlich die ImageNet-Genauigkeit beurteilt, sehen Modelle mit unterschiedlichen Eigenschaften möglicherweise ähnlich aus (Abbildung 1). Diese Einschränkung wird deutlicher, wenn das Modell beginnt, die Funktionen von ImageNet zu übertreffen und die Sättigung der Genauigkeit erreicht.

Um diese Lücke zu schließen, führten Forscher eine eingehende Untersuchung des Modellverhaltens durch, das über die ImageNet-Genauigkeit hinausgeht.

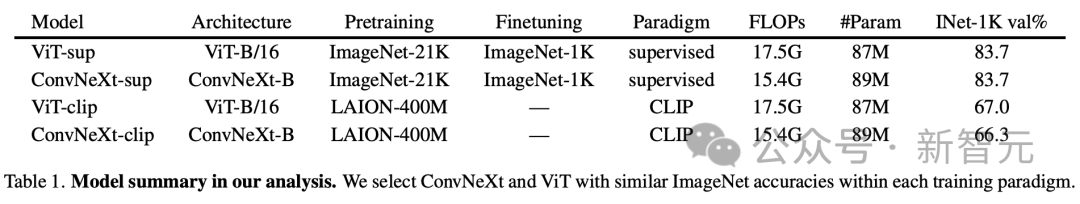

Um den Einfluss von Architektur und Trainingszielen auf die Modellleistung zu untersuchen, wurden Vision Transformer (ViT) und ConvNeXt gezielt verglichen. Die ImageNet-1K-Validierungsgenauigkeit und die Rechenanforderungen dieser beiden modernen Architekturen sind vergleichbar.

Darüber hinaus verglich die Studie überwachte Modelle, die durch DeiT3-Base/16 und ConvNeXt-Base repräsentiert werden, sowie den visuellen Encoder von OpenCLIP, der auf dem CLIP-Modell basiert.

Ergebnisanalyse

Die Analyse der Forscher wurde entwickelt, um Modellverhalten zu untersuchen, das ohne weiteres Training oder Feinabstimmung bewertet werden kann.

Dieser Ansatz ist besonders wichtig für Praktiker mit begrenzten Rechenressourcen, da sie häufig auf vorab trainierte Modelle angewiesen sind.

In der spezifischen Analyse erkennen die Autoren zwar den Wert nachgelagerter Aufgaben wie der Objekterkennung an, der Schwerpunkt liegt jedoch auf jenen Funktionen, die Erkenntnisse mit minimalem Rechenaufwand liefern und Verhaltensweisen widerspiegeln, die für reale Anwendungen wichtig sind.

Modellfehler

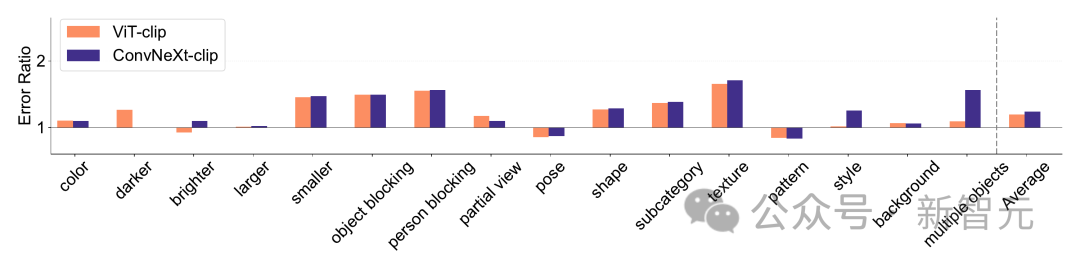

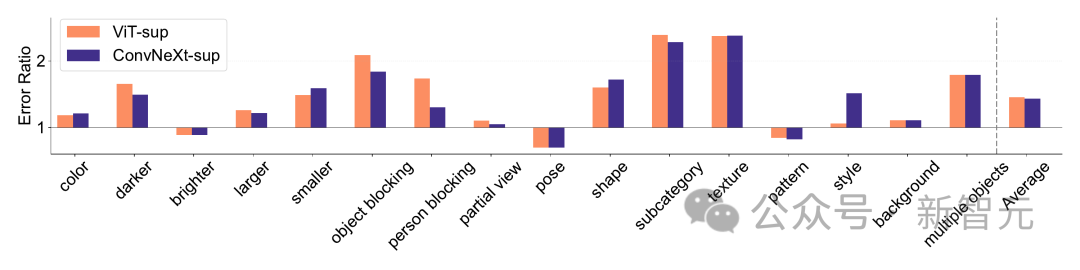

ImageNet-X ist ein Datensatz, der ImageNet-1K um detaillierte manuelle Anmerkungen zu 16 sich ändernden Faktoren erweitert und so eine eingehende Analyse von Modellfehlern bei der Bildklassifizierung ermöglicht.

Es nutzt die Fehlerrate (je niedriger, desto besser), um die Leistung des Modells in Bezug auf bestimmte Faktoren im Verhältnis zur Gesamtgenauigkeit zu quantifizieren, was eine differenzierte Analyse von Modellfehlern ermöglicht. Ergebnisse auf ImageNet-X zeigen:

1. Im Verhältnis zur ImageNet-Genauigkeit macht das CLIP-Modell weniger Fehler als das überwachte Modell.

2. Alle Modelle werden hauptsächlich von komplexen Faktoren wie Okklusion beeinflusst.

3. Die Textur ist der anspruchsvollste Faktor aller Modelle.

Shape/Texture Bias

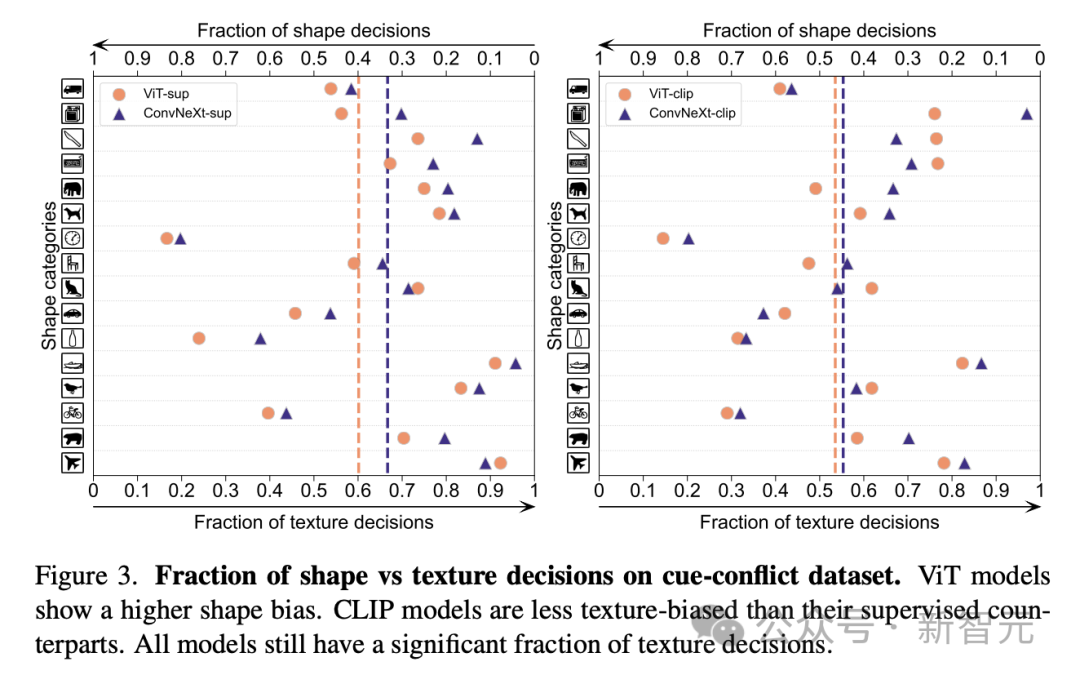

Shape/Texture Bias prüft, ob das Modell auf Texturverknüpfungen und nicht auf erweiterten Formhinweisen basiert.

Diese Tendenz lässt sich untersuchen, indem man Bilder unterschiedlicher Kategorien von Formen und Texturen kombiniert, die mit Hinweisen in Konflikt stehen.

Dieser Ansatz hilft zu verstehen, inwieweit die Entscheidungen des Modells auf der Form im Vergleich zur Textur basieren.

Die Forscher bewerteten die Form-Textur-Verzerrung im Cue-Konflikt-Datensatz und stellten fest, dass die Textur-Verzerrung des CLIP-Modells kleiner war als die des überwachten Modells, während die Form-Verzerrung des ViT-Modells höher war als die von ConvNets .

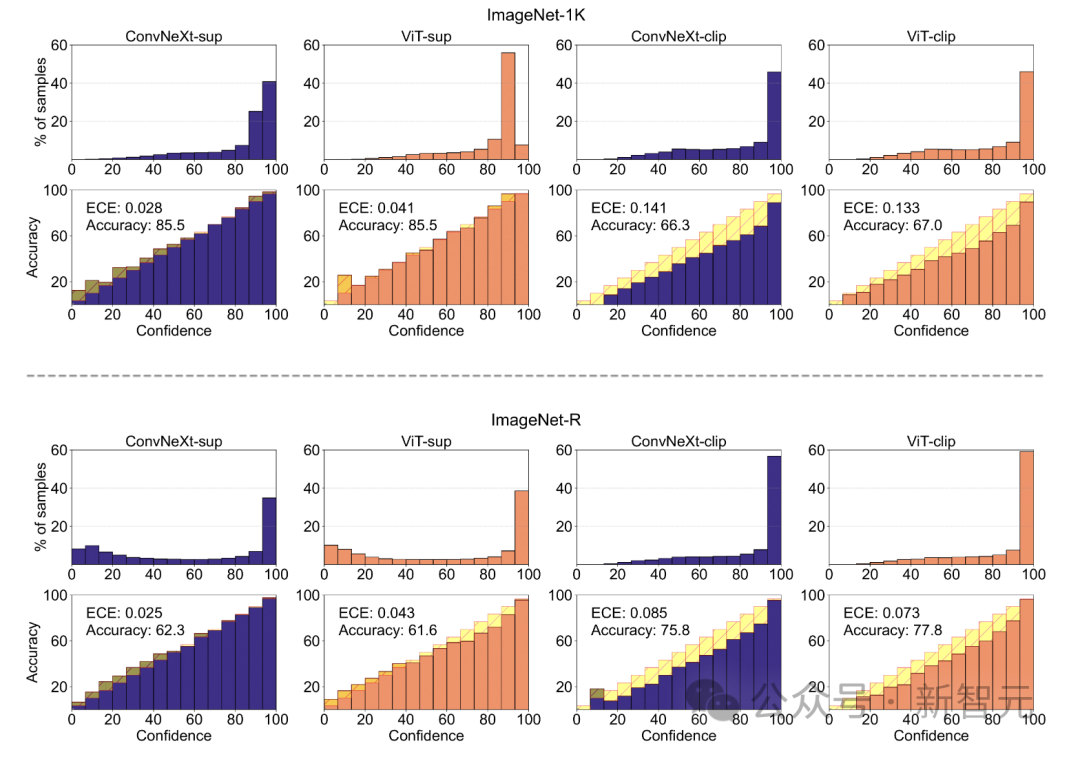

Modellkalibrierung

Die Kalibrierung quantifiziert, ob die Vorhersagesicherheit eines Modells mit seiner tatsächlichen Genauigkeit übereinstimmt.

Dies kann anhand von Metriken wie dem erwarteten Kalibrierungsfehler (ECE) sowie Visualisierungstools wie Zuverlässigkeitsdiagrammen und Konfidenzhistogrammen beurteilt werden.

Die Forscher bewerteten die Kalibrierung auf ImageNet-1K und ImageNet-R und klassifizierten Vorhersagen in 15 Stufen. Im Experiment wurden folgende Punkte beobachtet:

- Das CLIP-Modell weist ein hohes Vertrauen auf, während das überwachte Modell etwas unzureichend ist.

– Überwachtes ConvNeXt ist besser kalibriert als überwachtes ViT.

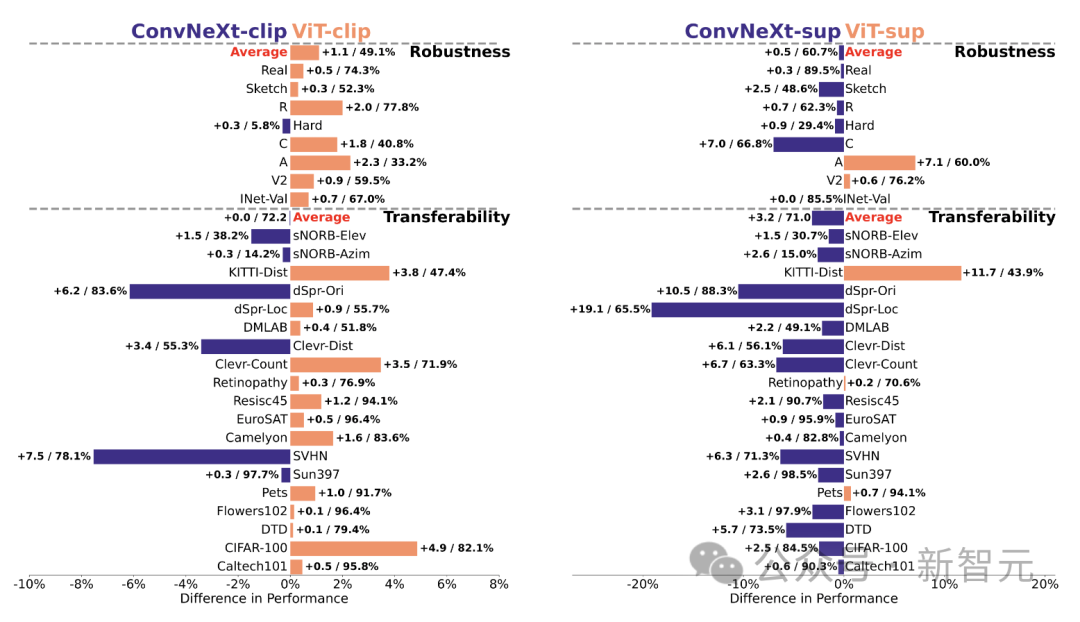

Robustheit und Portabilität

Die Robustheit und Portabilität des Modells sind der Schlüssel zur Anpassung an Änderungen in der Datenverteilung und neue Aufgaben.

Die Forscher bewerteten die Robustheit anhand verschiedener ImageNet-Varianten und stellten fest, dass die Modelle ViT und ConvNeXt mit Ausnahme von ImageNet-R und ImageNet-Sketch zwar eine ähnliche durchschnittliche Leistung aufwiesen, die überwachten Modelle jedoch im Allgemeinen hinsichtlich der Robustheit CLIP übertrafen.

In Bezug auf die Portabilität, bewertet anhand von 19 Datensätzen mithilfe des VTAB-Benchmarks, übertrifft das überwachte ConvNeXt ViT und liegt fast auf Augenhöhe mit der Leistung des CLIP-Modells.

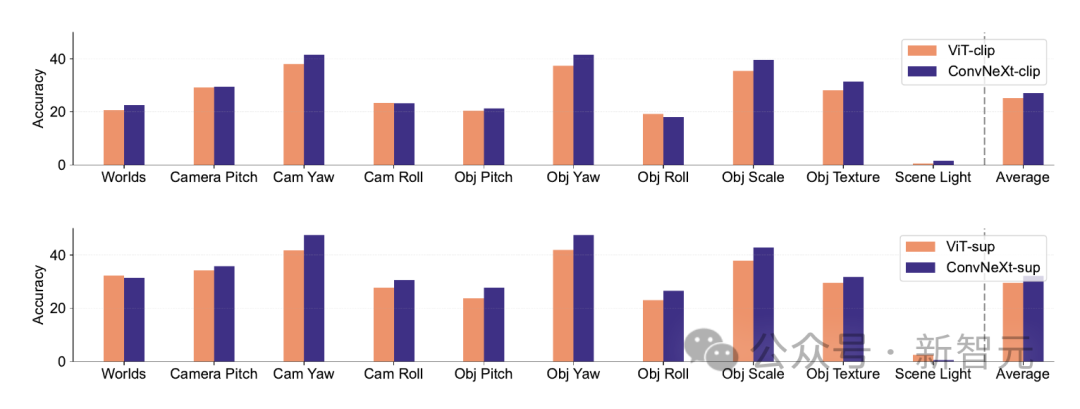

Synthetische Daten

Synthetische Datensätze wie PUG-ImageNet, die Faktoren wie Kamerawinkel und Textur präzise steuern können, sind zu einem vielversprechenden Forschungsweg geworden, sodass Forscher auf synthetischer Datenanalyse basieren Modelle.

PUG-ImageNet enthält fotorealistische ImageNet-Bilder mit systematischen Variationen in der Beleuchtung und anderen Faktoren, wobei die Leistung als absolut höchste Genauigkeit gemessen wird.

Die Forscher liefern Ergebnisse für verschiedene Faktoren in PUG-ImageNet und stellen fest, dass ConvNeXt ViT in fast allen Faktoren übertrifft.

Dies zeigt, dass ConvNeXt ViT bei synthetischen Daten übertrifft, während die Lücke des CLIP-Modells kleiner ist, da die Genauigkeit des CLIP-Modells geringer ist als die des überwachten Modells, was möglicherweise mit der geringeren Genauigkeit des ursprünglichen ImageNet zusammenhängt .

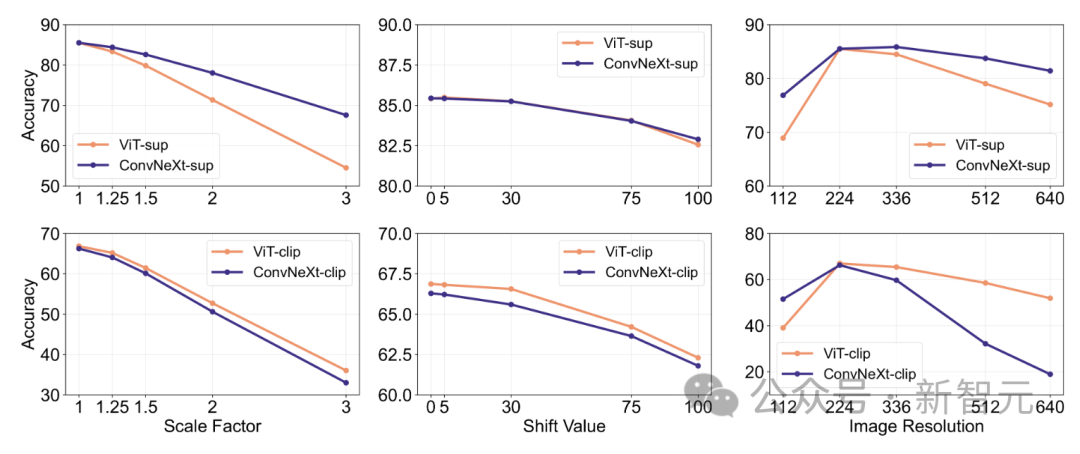

Feature-Invarianz

Feature-Invarianz bezieht sich auf die Fähigkeit des Modells, konsistente Darstellungen zu erzeugen, die nicht von Eingabetransformationen beeinflusst werden, wodurch die Semantik wie Skalierung oder Bewegung erhalten bleibt.

Diese Funktion ermöglicht dem Modell eine gute Verallgemeinerung über verschiedene, aber semantisch ähnliche Eingaben hinweg.

Der Ansatz der Forscher umfasst die Größenänderung von Bildern für Skaleninvarianz, das Verschieben von Ausschnitten für Positionsinvarianz und die Anpassung der Auflösung des ViT-Modells mithilfe interpolierter Positionseinbettungen.

ConvNeXt übertrifft ViT im betreuten Training.

Insgesamt ist das Modell robuster gegenüber Skalierungs-/Auflösungstransformationen als gegenüber Bewegungen. Für Anwendungen, die eine hohe Robustheit gegenüber Skalierung, Verschiebung und Auflösung erfordern, deuten die Ergebnisse darauf hin, dass überwachtes ConvNeXt möglicherweise die beste Wahl ist.

Forscher fanden heraus, dass jedes Modell seine eigenen einzigartigen Vorteile hat.

Dies legt nahe, dass die Modellauswahl vom Zielanwendungsfall abhängen sollte, da Standardleistungsmetriken möglicherweise geschäftskritische Nuancen übersehen.

Darüber hinaus sind viele bestehende Benchmarks von ImageNet abgeleitet, was die Bewertung verzerrt. Die Entwicklung neuer Benchmarks mit unterschiedlichen Datenverteilungen ist entscheidend, um Modelle in einem realistischeren repräsentativen Kontext zu bewerten.

ConvNet vs. Transformer

– In vielen Benchmarks hat überwachtes ConvNeXt eine bessere Leistung als überwachtes VIT: Es ist besser kalibriert, invariant gegenüber Datentransformationen, zeigt eine bessere Leistung, gute Übertragbarkeit und Robustheit.

- ConvNeXt übertrifft ViT bei synthetischen Daten.

- ViT hat eine höhere Formvoreingenommenheit.

Supervised vs. CLIP

– Obwohl das CLIP-Modell hinsichtlich der Übertragbarkeit besser ist, zeigte das überwachte ConvNeXt bei dieser Aufgabe eine wettbewerbsfähige Leistung. Dies zeigt das Potenzial überwachter Modelle.

– Überwachte Modelle schneiden bei Robustheitsbenchmarks besser ab, wahrscheinlich weil diese Modelle Varianten von ImageNet sind.

– Das CLIP-Modell weist im Vergleich zu seiner ImageNet-Genauigkeit eine höhere Formverzerrung und weniger Klassifizierungsfehler auf.

Das obige ist der detaillierte Inhalt vonLeCuns Bewertung: Meta-Bewertung von ConvNet und Transformer, welches ist stärker?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Das AI-Direktauswahltool zeigt keine Ankerpunkte an

- Wie kann das Problem gelöst werden, dass die Attributleiste oben in der KI fehlt?

- Wo befindet sich die Hauptfunktion im C-Quellprogramm?

- So verwenden Sie die Vlookup-Funktion von Excel, um mehrere Datenspalten gleichzeitig abzugleichen

- Wie nennt man die Geschwindigkeit, mit der ein Computer Daten hochlädt?