Einfache und effektive Interaktion zwischen Menschen und vierbeinigen Robotern ist der Weg, leistungsfähige intelligente Assistenzroboter zu schaffen, die auf eine Zukunft hinweisen, in der Technologie unser Leben auf eine Weise verbessert, die über unsere Vorstellungskraft hinausgeht. Der Schlüssel für solche Mensch-Roboter-Interaktionssysteme besteht darin, dem vierbeinigen Roboter die Fähigkeit zu geben, auf Befehle in natürlicher Sprache zu reagieren. Groß angelegte Sprachmodelle (LLM) haben sich in letzter Zeit rasant entwickelt und das Potenzial für eine Planung auf hoher Ebene gezeigt. Allerdings ist es für LLM immer noch schwierig, Anweisungen auf niedriger Ebene zu verstehen, wie z. B. Gelenkwinkelziele oder Motordrehmomente, insbesondere bei Robotern mit Beinen, die von Natur aus instabil sind und hochfrequente Steuersignale benötigen. Daher gehen die meisten vorhandenen Arbeiten davon aus, dass das LLM mit einer High-Level-API ausgestattet wurde, die das Verhalten des Roboters bestimmt, was die Ausdrucksfähigkeiten des Systems grundlegend einschränkt. Im CoRL 2023-Papier „SayTap: Language to Quadrupedal Locomotion“ haben Google DeepMind und die Universität Tokio eine neue Methode vorgeschlagen, die Fußkontaktmuster als Verbindung zwischen menschlichen Anweisungen in natürlicher Sprache und Ausgabebefehlen auf niedriger Ebene verwendet. Motion-Controller-Brücke.

- Papieradresse: https://arxiv.org/abs/2306.07580

- Projektwebsite: https://saytap.github.io/

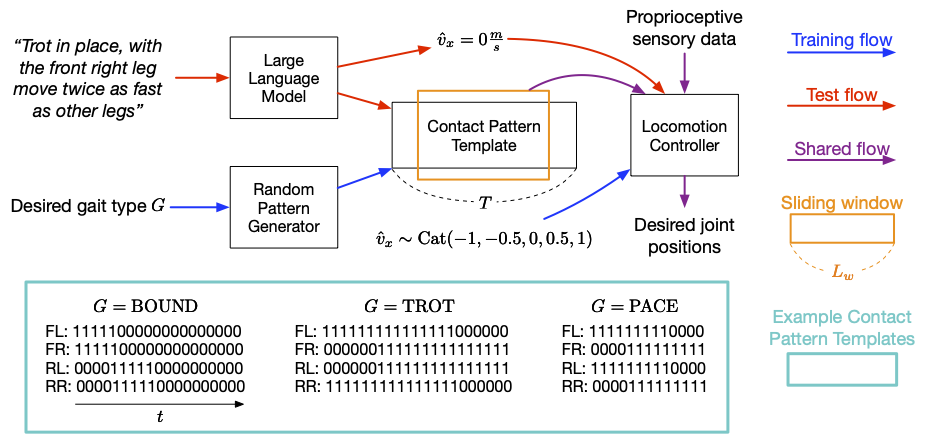

Fußkontaktmuster (Fuß Kontaktmuster) bezieht sich auf die Reihenfolge und Art und Weise, in der ein Vierbeiner bei der Bewegung seine Füße auf den Boden setzt. Darauf aufbauend entwickelten sie ein interaktives Vierbeiner-Robotersystem, das es Nutzern ermöglicht, flexibel verschiedene Bewegungsverhaltensweisen zu entwickeln. Beispielsweise können Nutzer dem Roboter mit einfacher Sprache Befehle zum Gehen, Laufen, Springen oder zum Ausführen anderer Aktionen geben. Zu ihren Beiträgen gehören ein LLM-Prompt-Design, eine Belohnungsfunktion und eine Methode, die es dem SayTap-Controller ermöglicht, realisierbare Kontaktmusterverteilungen zu verwenden. Untersuchungen zeigen, dass der SayTap-Controller mehrere Bewegungsmodi erreichen kann und diese Fähigkeiten auch auf echte Roboterhardware übertragen werden können. SayTap-Methode verwendet eine Kontaktmodusvorlage, bei der es sich um eine 4-Fuß-Berührung des Bodens handelt. Von oben nach unten gibt jede Zeile der Matrix das Fußkontaktmuster des linken Vorfußes (FL), des rechten Vorfußes (FR), des linken Rückfußes (RL) bzw. des rechten Rückfußes (RR) an. Die Steuerfrequenz von SayTap beträgt 50 Hz, was bedeutet, dass jede 0 oder 1 0,02 Sekunden dauert. Diese Studie definiert das gewünschte Fußkontaktmuster als zyklisches Schiebefenster der Größe L_w und der Form 4 x L_w. Dieses Schiebefenster extrahiert die vierfachen Erdungsflags aus der Kontaktmustervorlage, die angeben, ob der Roboterfuß zwischen den Zeiten t + 1 und t + L_w auf dem Boden oder in der Luft war. Die folgende Abbildung gibt einen Überblick über die SayTap-Methode.

Übersicht über die SayTap-Methode SayTap führt gewünschte Fußkontaktmuster als neue Schnittstelle zwischen Benutzerbefehlen in natürlicher Sprache und Bewegungssteuerungen ein. Der Bewegungscontroller wird verwendet, um Hauptaufgaben auszuführen (z. B. das Einhalten einer bestimmten Geschwindigkeit) und den Roboterfuß zu bestimmten Zeiten auf den Boden zu setzen, damit das erreichte Fußkontaktmuster dem gewünschten Kontaktmuster möglichst nahe kommt. Zu diesem Zweck verwendet der Bewegungscontroller bei jedem Zeitschritt als Eingabe das gewünschte Fußkontaktmuster sowie propriozeptive Daten (wie Gelenkpositionen und Geschwindigkeiten) und aufgabenbezogene Eingaben (wie benutzerspezifische Geschwindigkeitsbefehle). ). DeepMind nutzte Reinforcement Learning, um den Motion Controller zu trainieren und stellte ihn als tiefes neuronales Netzwerk dar. Während des Trainings des Controllers verwendeten die Forscher einen Zufallsgenerator, um die gewünschten Fußkontaktmuster abzutasten, und optimierten dann die Richtlinie, um Roboteraktionen auf niedriger Ebene auszugeben, die die gewünschten Fußkontaktmuster erreichen. Zur Testzeit wird LLM verwendet, um Benutzerbefehle in Fußkontaktmuster zu übersetzen.

SayTap nutzt Fußkontaktmuster als Brücke zwischen Benutzerbefehlen in natürlicher Sprache und Steuerbefehlen auf niedriger Ebene. SayTap unterstützt sowohl einfache und direkte Anweisungen (z. B. „Langsam vorwärts joggen“) als auch vage Benutzerbefehle (z. B. „Gute Nachrichten, wir machen dieses Wochenende ein Picknick!“) Durch Bewegungssteuerungen, die auf Verstärkungslernen basieren, vier Die Der Fußroboter reagiert entsprechend den Befehlen

Untersuchungen zeigen, dass LLM mithilfe entsprechend gestalteter Eingabeaufforderungen in der Lage ist, Benutzerbefehle genau in bestimmte Formate von Fußkontaktmustervorlagen abzubilden, selbst wenn die Benutzerbefehle unstrukturiert oder unscharf sind Im Training verwendeten die Forscher einen Zufallsmustergenerator, um mehrere Kontaktmustervorlagen zu generieren, die unterschiedliche Musterlängen T haben und auf dem Fuß-Boden-Kontaktverhältnis eines bestimmten Gangtyps G in einem Zyklus basieren, sodass die Bewegung Der Controller ist in der Lage, über einen weiten Bereich von Bewegungsmusterverteilungen zu lernen und bessere Generalisierungsfähigkeiten zu erreichen. Mit einer einfachen Eingabeaufforderung von Teilkontaktmodus-Kontextbeispielen kann LLM verschiedene menschliche Befehle genau übersetzen in Kontaktmodi, auch verallgemeinernd auf Situationen, in denen es keine explizite Spezifikation gibt, wie sich der Roboter verhalten soll. SayTap-Eingabeaufforderung ist einfach und kompakt. Enthält vier Komponenten:

(1) eine allgemeine Beschreibung die Aufgaben, die der LLM erledigen sollte;

(2) eine Gangdefinition, um den LLM daran zu erinnern, auf das Grundwissen über den Vierbeinergang und deren Zusammenhang mit Emotionen zu achten;

(4) Demonstrationsbeispiel, damit LLM Situationen im Kontext lernen kann Die Forscher stellen außerdem fünf Geschwindigkeiten ein, damit der Roboter vorwärts oder rückwärts, schnell oder langsam fahren oder still bleiben kann

Einfache und direkte Befehle befolgen Die Animation unten zeigt ein Beispiel für die erfolgreiche Ausführung eines direkten und klaren Befehls durch SayTap. Der Befehl ist in den drei Kontextbeispielen nicht enthalten, kann LLM jedoch dabei unterstützen, das im Vorfeld erlernte interne Wissen auszudrücken. Trainingsphase. Dabei wird das „Gangdefinitionsmodul“ in der Eingabeaufforderung verwendet, das die zweite Eingabeaufforderung im obigen Eingabeaufforderungsmodul ist.

Befolgen Sie unstrukturierte oder mehrdeutige Befehle

Aber noch interessanter ist die Fähigkeit von SayTap, mit unstrukturierten und mehrdeutigen Anweisungen umzugehen. Es bedarf nur einiger Hinweise, um bestimmte Gangarten mit allgemeinen emotionalen Eindrücken zu verknüpfen, etwa wenn der Roboter auf und ab hüpft, nachdem er etwas Aufregendes gehört hat (z. B. „Lass uns ein Picknick machen!“). Darüber hinaus kann er Szenen präzise darstellen, wenn ihm zum Beispiel mitgeteilt wird, dass der Boden sehr heiß ist, und sich so schnell bewegt, dass seine Füße den Boden so wenig wie möglich berühren.

Zusammenfassung und zukünftige ArbeitenSayTap ist ein interaktives System für vierbeinige Roboter, das es Benutzern ermöglicht, flexibel verschiedene Fortbewegungsverhalten zu formulieren. SayTap führt gewünschte Fußkontaktmuster als Schnittstelle zwischen natürlicher Sprache und Low-Level-Controllern ein. Die neue Schnittstelle ist sowohl unkompliziert als auch flexibel und ermöglicht es dem Roboter, sowohl direkte Anweisungen als auch Befehle zu befolgen, die nicht explizit angeben, wie sich der Roboter verhalten soll. DeepMind-Forscher sagten, dass eine wichtige zukünftige Forschungsrichtung darin besteht, zu testen, ob Befehle, die bestimmte Gefühle implizieren, es LLM ermöglichen können, den gewünschten Gang auszugeben. Im Gangdefinitionsmodul der oben genannten Ergebnisse lieferten die Forscher einen Satz, der glückliche Gefühle mit dem springenden Gang verknüpfte. Die Bereitstellung weiterer Informationen könnte die Fähigkeit von LLM verbessern, Befehle zu interpretieren, beispielsweise implizite Gefühle zu entschlüsseln. In experimentellen Untersuchungen ermöglichte die Verbindung zwischen glücklichen Emotionen und einem hüpfenden Gang dem Roboter, sich energisch zu verhalten und dabei vagen menschlichen Anweisungen zu folgen. Eine weitere interessante zukünftige Forschungsrichtung ist die Einführung multimodaler Eingaben wie Video und Audio. Theoretisch sind die aus diesen Signalen übersetzten Fußkontaktmuster auch für den hier neu vorgeschlagenen Workflow geeignet und dürften weitere interessante Anwendungsfälle eröffnen. Originallink: https://blog.research.google/2023/08/saytap-lingual-to-quadrupedal.html

Das obige ist der detaillierte Inhalt vonGoogle trainiert mithilfe eines großen Modells einen Roboterhund, vage Anweisungen zu verstehen, und freut sich auf ein Picknick. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!