Technologie-Peripheriegeräte

Technologie-Peripheriegeräte KI

KI Lassen Sie den Roboter Ihr „Hier sind Sie' spüren. Das Tsinghua-Team nutzt Millionen von Szenarien, um eine universelle Mensch-Maschine-Übergabe zu schaffen

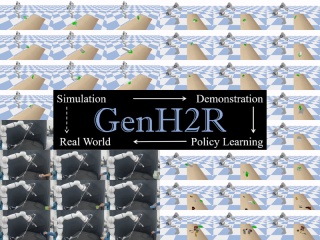

Lassen Sie den Roboter Ihr „Hier sind Sie' spüren. Das Tsinghua-Team nutzt Millionen von Szenarien, um eine universelle Mensch-Maschine-Übergabe zu schaffenForscher des Interdisziplinären Informationsinstituts der Tsinghua-Universität schlugen ein Framework namens „GenH2R“ vor, das es Robotern ermöglichen soll, eine universelle, auf Visionen basierende Strategie zur Übergabe von Mensch und Maschine zu erlernen. Diese Strategie ermöglicht es dem Roboter, verschiedene Objekte mit unterschiedlichen Formen und komplexen Bewegungsbahnen zuverlässiger zu fangen, was neue Möglichkeiten für die Mensch-Computer-Interaktion eröffnet. Diese Forschung stellt einen wichtigen Durchbruch für die Entwicklung des Bereichs der künstlichen Intelligenz dar und bringt größere Flexibilität und Anpassungsfähigkeit bei der Anwendung von Robotern in realen Szenarien.

Mit dem Aufkommen der Ära der verkörperten Intelligenz (verkörperte KI) erwarten wir, dass intelligente Körper aktiv mit der Umwelt interagieren. Dabei ist es von entscheidender Bedeutung, Roboter in die menschliche Lebenswelt zu integrieren und mit Menschen zu interagieren (Human Robot Interaction). Wir müssen darüber nachdenken, wie wir menschliches Verhalten und Absichten verstehen, ihre Bedürfnisse auf eine Weise erfüllen können, die den menschlichen Erwartungen am besten entspricht, und den Menschen in den Mittelpunkt der verkörperten Intelligenz stellen (Human-Centered Embodied AI). Eine der Schlüsselkompetenzen ist die verallgemeinerbare Mensch-zu-Roboter-Übergabe, die es Robotern ermöglicht, besser mit Menschen zusammenzuarbeiten, um eine Vielzahl alltäglicher Aufgaben wie Kochen, Heimorganisation und Möbelmontage zu erledigen.

Die explosionsartige Entwicklung großer Modelle zeigt, dass umfangreiche, qualitativ hochwertige Daten + groß angelegtes Lernen ein möglicher Weg zur allgemeinen Intelligenz sind. Können also allgemeine Fähigkeiten zur Mensch-Maschine-Übergabe durch umfangreiche Roboterdaten und umfangreiches Lernen erworben werden? Scale-Strategie-Nachahmung? Es ist jedoch gefährlich und teuer, groß angelegtes interaktives Lernen zwischen Robotern und Menschen in der realen Welt zu ermöglichen, und die Maschine wird wahrscheinlich Menschen schaden:

Trainieren Sie in einer Simulationsumgebung und nutzen Sie menschliche Simulationen und Dynamik Erfassen der Bewegungsplanung, um automatisch eine große Menge unterschiedlicher Roboter-Lerndaten bereitzustellen und diese Daten dann auf reale Roboter anzuwenden. Diese lernbasierte Methode wird als „Sim-to-Real-Transfer“ bezeichnet und kann die Beziehung zwischen Robotern und echten Robotern erheblich verbessern Roboter. Kollaborative Interaktionsfähigkeiten zwischen Menschen mit höherer Zuverlässigkeit.

Daher wurde das „GenH2R“-Framework vorgeschlagen, das von drei Perspektiven ausgeht: Simulation, Demonstration und Nachahmung, um Robotern erstmals ein durchgängiges Lernen zu ermöglichen jede Greifmethode, jede Übergabetrajektorie und jede Objektgeometrie: 1) Bietet Millionen von Ebenen verschiedener komplexer Simulationsübergabeszenarien, die in der „GenH2R-Sim“-Umgebung einfach zu generieren sind, 2) Führt eine Reihe automatisierter Expertendemonstrationsgenerierung ein Prozess basierend auf Vision-Aktion-Zusammenarbeit, 3) Verwendung der Imitation Learning-Methode basierend auf 4D-Informationen und Vorhersageunterstützung (Punktwolke + Zeit).

Im Vergleich zur SOTA-Methode (CVPR2023 Highlight) ist die durchschnittliche Erfolgsrate der GenH2R-Methode bei verschiedenen Testsätzen um 14 % erhöht, die Zeit wird um 13 % verkürzt und sie ist in realen Maschinenexperimenten robuster.

- Papieradresse: https://arxiv.org/abs/2401.00929

- Papierhomepage: https://GenH2R.github.io.

- Papier Video: https: //youtu.be/BbphK5QlS1Y

Einführung in die Methode

Um Spielern zu helfen, die das Level noch nicht abgeschlossen haben, lernen wir die spezifischen Rätsellösungsmethoden von „Simulation Environment (GenH2R-Sim)“ kennen )".

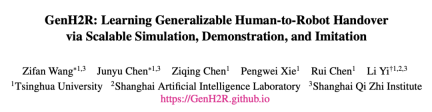

Um hochwertige, umfangreiche Datensätze menschlicher Handobjekte zu generieren, modelliert die GenH2R-Sim-Umgebung die Szene im Hinblick auf Greifhaltungen und Bewegungsbahnen.

In Bezug auf Greifposen führte GenH2R-Sim umfangreiche 3D-Objektmodelle von ShapeNet ein, wählte 3266 für die Übergabe geeignete Alltagsobjekte aus und generierte mithilfe der geschickten Greifgenerierungsmethode (DexGraspNet) insgesamt 100 Eine Szene mit Dutzenden Tausende Hände greifen nach einem Gegenstand. In Bezug auf Bewegungstrajektorien verwendet GenH2R-Sim mehrere Kontrollpunkte, um mehrere glatte Bézier-Kurven zu erzeugen, und führt die Drehung menschlicher Hände und Objekte ein, um verschiedene komplexe Bewegungstrajektorien von handgelieferten Objekten zu simulieren.

In den 1 Million Szenen von GenH2R-Sim übertrifft es nicht nur die neuesten Arbeiten in Bezug auf Bewegungsbahnen (1.000 vs. 1 Million) und Anzahl der Objekte (20 vs. 3266) bei weitem, sondern führt auch Methoden ein, die diesem nahe kommen Interaktive Informationen (z. B. wenn der Roboterarm nah genug am Objekt ist, stoppt der Mensch die Bewegung und wartet, bis die Übergabe abgeschlossen ist) und nicht die einfache Wiedergabe der Flugbahn. Obwohl die durch Simulation generierten Daten nicht vollständig realistisch sein können, zeigen experimentelle Ergebnisse, dass Simulationsdaten in großem Maßstab lernförderlicher sind als reale Daten in kleinem Maßstab.

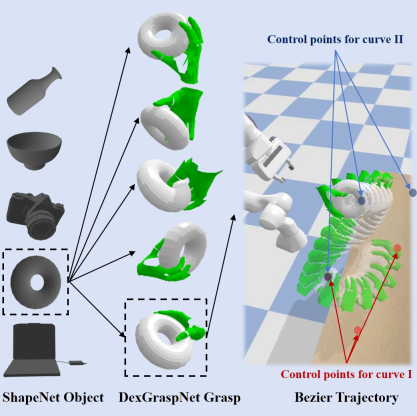

B. Groß angelegte Generierung von Expertenbeispielen, die die Destillation erleichtern

Basierend auf groß angelegten Daten zur Bewegungsbahn von menschlichen Händen und Objekten generiert GenH2R automatisch eine große Anzahl von Expertenbeispielen. Die von GenH2R gesuchten „Experten“ sind verbesserte Bewegungsplaner (z. B. OMG Planner). Bei diesen Methoden handelt es sich um eine nicht lernende, steuerungsbasierte Optimierung, die nicht auf visuelle Punktwolken angewiesen ist und häufig bestimmte Szenenzustände (z. B. die Zielerfassungsposition) erfordert des Objekts). Um sicherzustellen, dass das nachfolgende visuelle Richtliniennetzwerk lernförderliche Informationen destillieren kann, muss sichergestellt werden, dass die von den „Experten“ bereitgestellten Beispiele eine Korrelation zwischen Vision und Aktion aufweisen. Wenn der endgültige Landepunkt während der Planung bekannt ist, kann der Roboterarm die Sicht ignorieren und direkt zur endgültigen Position planen, um zu „warten und zu warten“. Dies kann dazu führen, dass die Kamera des Roboters das Objekt nicht sehen kann Nachgeschaltetes visuelles Strategienetzwerk; Wenn der Roboterarm basierend auf der Position des Objekts häufig neu geplant wird, kann dies dazu führen, dass sich der Roboterarm diskontinuierlich bewegt und seltsame Formen annimmt, was ein angemessenes Greifen unmöglich macht.

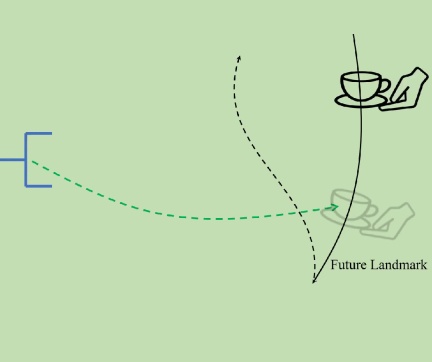

Um destillationsfreundliche Expertenbeispiele zu generieren, führt GenH2R Landmark Planning ein. Die Bewegungsbahn der menschlichen Hand wird entsprechend der Glätte und Entfernung der Flugbahn in mehrere Segmente unterteilt, wobei Landmark als Segmentierungsmarke dient. In jedem Segment ist die Flugbahn der menschlichen Hand gleichmäßig und die Expertenmethode plant in Richtung der Landmark-Punkte. Dieser Ansatz gewährleistet sowohl die visuelle Aktionskorrelation als auch die Aktionskontinuität.

C. Vorhersagegestütztes 4D-Nachahmungs-Lernnetzwerk

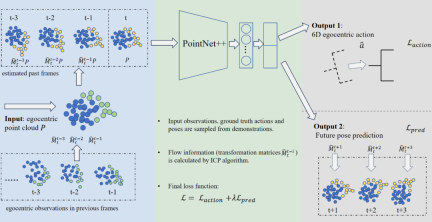

GenH2R nutzt die Nachahmungs-Lernmethode, um ein 4D-Richtliniennetzwerk zur Beobachtung der Zeitreihen-Punktwolkeninformationen aufzubauen Führen Sie geometrische und kinematische Zerlegungen durch. Für jede Frame-Punktwolke wird die Posentransformation zwischen der Punktwolke des vorherigen Frames und dem iterativen Algorithmus für den nächstgelegenen Punkt berechnet, um die Flussinformationen jedes Punkts abzuschätzen, sodass die Punktwolke jedes Frames alle Bewegungseigenschaften aufweist. Dann wird PointNet++ verwendet, um jeden Frame der Punktwolke zu kodieren und schließlich nicht nur die endgültige erforderliche 6D-egozentrische Aktion zu dekodieren, sondern auch eine Vorhersage der zukünftigen Pose des Objekts auszugeben, wodurch die Fähigkeit des Richtliniennetzwerks verbessert wird, zukünftige Hand- und Objektbewegungen vorherzusagen .

Im Gegensatz zu komplexeren 4D-Backbones (z. B. Transformer-basiert) verfügt diese Netzwerkarchitektur über eine sehr hohe Inferenzgeschwindigkeit und eignet sich besser für Mensch-Computer-Interaktionsszenarien wie die Übergabe von Objekten, die eine geringe Latenz erfordern Gleichzeitig kann es auch Timing-Informationen effektiv nutzen und so ein Gleichgewicht zwischen Einfachheit und Effektivität erreichen.

Experiment

Ein Simulationsumgebungsexperiment

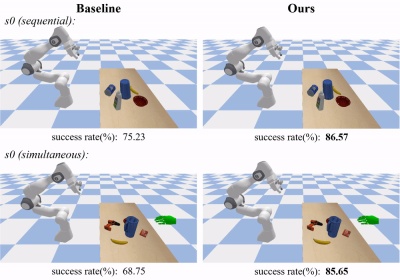

GenH2R- und SOTA-Methoden wurden mit der Methode unter Verwendung kleiner realer Daten verglichen. GenH2R-Sim Die Methode zur Verwendung großer Durch groß angelegte Simulationsdaten für das Training können erhebliche Vorteile erzielt werden (die Erfolgsquote bei verschiedenen Testsätzen wird um durchschnittlich 14 % erhöht und die Zeit wird um 13 % verkürzt).

Im realen Datentestsatz s0 kann die GenH2R-Methode komplexere Objekte erfolgreich übergeben und die Haltung im Voraus anpassen, um häufige Haltungsanpassungen zu vermeiden, wenn sich der Greifer in der Nähe des Objekts befindet:

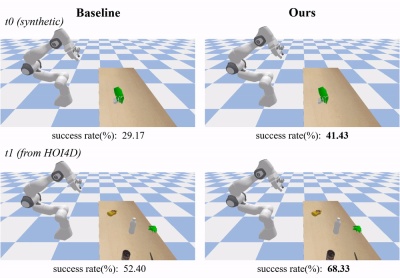

Im Simulationsdatentestsatz t0 (eingeführt von GenH2R-sim) kann die Methode von GenH2R die zukünftige Lage des Objekts vorhersagen, um eine vernünftigere Annäherungsbahn zu erreichen:

Im realen Datentestsatz t1 ( GenH2R-sim wurde von HOI4D eingeführt (ungefähr siebenmal größer als der s0-Testsatz früherer Arbeiten). Die Methode von GenH2R kann auf unsichtbare reale Objekte mit unterschiedlichen Geometrien verallgemeinert werden.

B. Reales Maschinenexperiment

GenH2R setzt die erlernten Strategien auch auf den Roboterarm in der realen Welt ein, um den „Simul-to-Real“-Sprung zu vollenden.

Für komplexere Bewegungsbahnen (z. B. Rotation) zeigt die Strategie von GenH2R eine stärkere Anpassungsfähigkeit; für komplexere Geometrien kann die Methode von GenH2R eine stärkere Verallgemeinerung zeigen:

GenH2R hat reale Maschinentests und Benutzerforschung abgeschlossen verschiedene Übergabeobjekte, die eine starke Robustheit beweisen.

Weitere Experimente und Methoden finden Sie auf der Paper-Homepage.

Teamvorstellung

Dieser Artikel stammt vom 3DVICI Lab der Tsinghua University, dem Shanghai Artificial Intelligence Laboratory und dem Shanghai Qizhi Research Institute. Die Autoren des Artikels sind die Studenten der Tsinghua University, Wang Zifan (Co-Autor), Chen Junyu (Co -Autor), Chen Ziqing und Xie Pengwei, die Dozenten sind Yi Li und Chen Rui.

Das 3D Vision Computing and Machine Intelligence Laboratory (3DVICI Lab) der Tsinghua University ist ein Labor für künstliche Intelligenz im Institut für interdisziplinäre Information der Tsinghua University. Es wurde von Professor Yi Li gegründet und geleitet. Das 3DVICI Lab befasst sich mit den aktuellsten Themen des allgemeinen dreidimensionalen Sehens und der intelligenten Roboterinteraktion in der künstlichen Intelligenz. Seine Forschungsrichtungen umfassen verkörperte Wahrnehmung, Interaktionsplanung und -generierung, Mensch-Maschine-Kollaboration usw. und stehen in engem Zusammenhang mit der Anwendung Bereiche wie Roboter, virtuelle Realität und autonomes Fahren. Das Forschungsziel des Teams besteht darin, intelligenten Agenten zu ermöglichen, die dreidimensionale Welt zu verstehen und mit ihr zu interagieren. Die Ergebnisse wurden in wichtigen Top-Computerkonferenzen und Fachzeitschriften veröffentlicht.

Das obige ist der detaillierte Inhalt vonLassen Sie den Roboter Ihr „Hier sind Sie' spüren. Das Tsinghua-Team nutzt Millionen von Szenarien, um eine universelle Mensch-Maschine-Übergabe zu schaffen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

So erstellen Sie Ihren persönlichen KI -Assistenten mit Smollm mit Umarmung. SmollmApr 18, 2025 am 11:52 AM

So erstellen Sie Ihren persönlichen KI -Assistenten mit Smollm mit Umarmung. SmollmApr 18, 2025 am 11:52 AMNutzen Sie die Kraft von AI On-Device: Bauen eines persönlichen Chatbot-Cli In der jüngeren Vergangenheit schien das Konzept eines persönlichen KI -Assistenten wie Science -Fiction zu sein. Stellen Sie sich Alex vor, ein Technik -Enthusiast, der von einem klugen, lokalen KI -Begleiter träumt - einer, der nicht angewiesen ist

KI für psychische Gesundheit wird aufmerksam durch aufregende neue Initiative an der Stanford University analysiertApr 18, 2025 am 11:49 AM

KI für psychische Gesundheit wird aufmerksam durch aufregende neue Initiative an der Stanford University analysiertApr 18, 2025 am 11:49 AMIhre Eröffnungseinführung von AI4MH fand am 15. April 2025 statt, und Luminary Dr. Tom Insel, M. D., berühmter Psychiater und Neurowissenschaftler, diente als Kick-off-Sprecher. Dr. Insel ist bekannt für seine herausragende Arbeit in der psychischen Gesundheitsforschung und für Techno

Die 2025 WNBA -Entwurfsklasse tritt in eine Liga ein, die wächst und gegen Online -Belästigung kämpftApr 18, 2025 am 11:44 AM

Die 2025 WNBA -Entwurfsklasse tritt in eine Liga ein, die wächst und gegen Online -Belästigung kämpftApr 18, 2025 am 11:44 AM"Wir möchten sicherstellen, dass die WNBA ein Raum bleibt, in dem sich alle, Spieler, Fans und Unternehmenspartner sicher fühlen, geschätzt und gestärkt sind", erklärte Engelbert und befasste sich mit dem, was zu einer der schädlichsten Herausforderungen des Frauensports geworden ist. Die Anno

Umfassende Anleitung zu Python -integrierten Datenstrukturen - Analytics VidhyaApr 18, 2025 am 11:43 AM

Umfassende Anleitung zu Python -integrierten Datenstrukturen - Analytics VidhyaApr 18, 2025 am 11:43 AMEinführung Python zeichnet sich als Programmiersprache aus, insbesondere in der Datenwissenschaft und der generativen KI. Eine effiziente Datenmanipulation (Speicherung, Verwaltung und Zugriff) ist bei der Behandlung großer Datensätze von entscheidender Bedeutung. Wir haben zuvor Zahlen und ST abgedeckt

Erste Eindrücke von OpenAIs neuen Modellen im Vergleich zu AlternativenApr 18, 2025 am 11:41 AM

Erste Eindrücke von OpenAIs neuen Modellen im Vergleich zu AlternativenApr 18, 2025 am 11:41 AMVor dem Eintauchen ist eine wichtige Einschränkung: KI-Leistung ist nicht deterministisch und sehr nutzungsgewohnt. In einfacherer Weise kann Ihre Kilometerleistung variieren. Nehmen Sie diesen (oder einen anderen) Artikel nicht als endgültiges Wort - testen Sie diese Modelle in Ihrem eigenen Szenario

AI -Portfolio | Wie baue ich ein Portfolio für eine KI -Karriere?Apr 18, 2025 am 11:40 AM

AI -Portfolio | Wie baue ich ein Portfolio für eine KI -Karriere?Apr 18, 2025 am 11:40 AMErstellen eines herausragenden KI/ML -Portfolios: Ein Leitfaden für Anfänger und Profis Das Erstellen eines überzeugenden Portfolios ist entscheidend für die Sicherung von Rollen in der künstlichen Intelligenz (KI) und des maschinellen Lernens (ML). Dieser Leitfaden bietet Rat zum Erstellen eines Portfolios

Welche Agenten KI könnte für Sicherheitsvorgänge bedeutenApr 18, 2025 am 11:36 AM

Welche Agenten KI könnte für Sicherheitsvorgänge bedeutenApr 18, 2025 am 11:36 AMDas Ergebnis? Burnout, Ineffizienz und eine Erweiterung zwischen Erkennung und Wirkung. Nichts davon sollte für jeden, der in Cybersicherheit arbeitet, einen Schock erfolgen. Das Versprechen der Agenten -KI hat sich jedoch als potenzieller Wendepunkt herausgestellt. Diese neue Klasse

Google versus openai: Der KI -Kampf für SchülerApr 18, 2025 am 11:31 AM

Google versus openai: Der KI -Kampf für SchülerApr 18, 2025 am 11:31 AMSofortige Auswirkungen gegen langfristige Partnerschaft? Vor zwei Wochen hat Openai ein leistungsstarkes kurzfristiges Angebot vorangetrieben und bis Ende Mai 2025 den kostenlosen Zugang zu Chatgpt und Ende Mai 2025 gewährt. Dieses Tool enthält GPT-4O, A A A.

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

SecLists

SecLists ist der ultimative Begleiter für Sicherheitstester. Dabei handelt es sich um eine Sammlung verschiedener Arten von Listen, die häufig bei Sicherheitsbewertungen verwendet werden, an einem Ort. SecLists trägt dazu bei, Sicherheitstests effizienter und produktiver zu gestalten, indem es bequem alle Listen bereitstellt, die ein Sicherheitstester benötigen könnte. Zu den Listentypen gehören Benutzernamen, Passwörter, URLs, Fuzzing-Payloads, Muster für vertrauliche Daten, Web-Shells und mehr. Der Tester kann dieses Repository einfach auf einen neuen Testcomputer übertragen und hat dann Zugriff auf alle Arten von Listen, die er benötigt.

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Herunterladen der Mac-Version des Atom-Editors

Der beliebteste Open-Source-Editor

MinGW – Minimalistisches GNU für Windows

Dieses Projekt wird derzeit auf osdn.net/projects/mingw migriert. Sie können uns dort weiterhin folgen. MinGW: Eine native Windows-Portierung der GNU Compiler Collection (GCC), frei verteilbare Importbibliotheken und Header-Dateien zum Erstellen nativer Windows-Anwendungen, einschließlich Erweiterungen der MSVC-Laufzeit zur Unterstützung der C99-Funktionalität. Die gesamte MinGW-Software kann auf 64-Bit-Windows-Plattformen ausgeführt werden.