Nach 5 Monaten Update-Iterationen ist Keras 3.0 endlich da.

„Große Neuigkeit: Wir haben gerade Version Keras 3.0 veröffentlicht!“, sagte François Chollet, der Vater von Keras, aufgeregt auf X. „Jetzt können Sie Keras auf JAX-, TensorFlow- und PyTorch-Frameworks ausführen …“

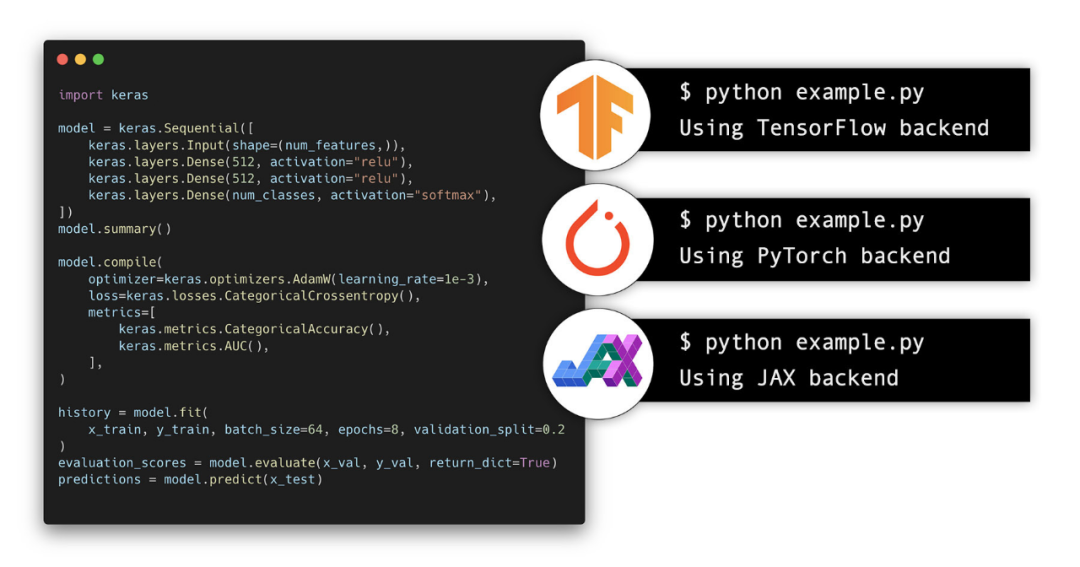

Für dieses Update gaben die Verantwortlichen von Keras an, dass die Fertigstellung dieser Version 5 Monate an öffentlichen Tests gedauert habe. Keras 3.0 ist eine vollständige Neufassung von Keras, die es Ihnen ermöglicht, Keras-Workflows auf JAX, TensorFlow oder PyTorch auszuführen. Die neue Version verfügt außerdem über neue Funktionen für das Training und die Bereitstellung großer Modelle. Sie können das Framework auswählen, das am besten zu Ihnen passt, oder je nach Ihren aktuellen Zielen von einem Framework zum anderen wechseln.

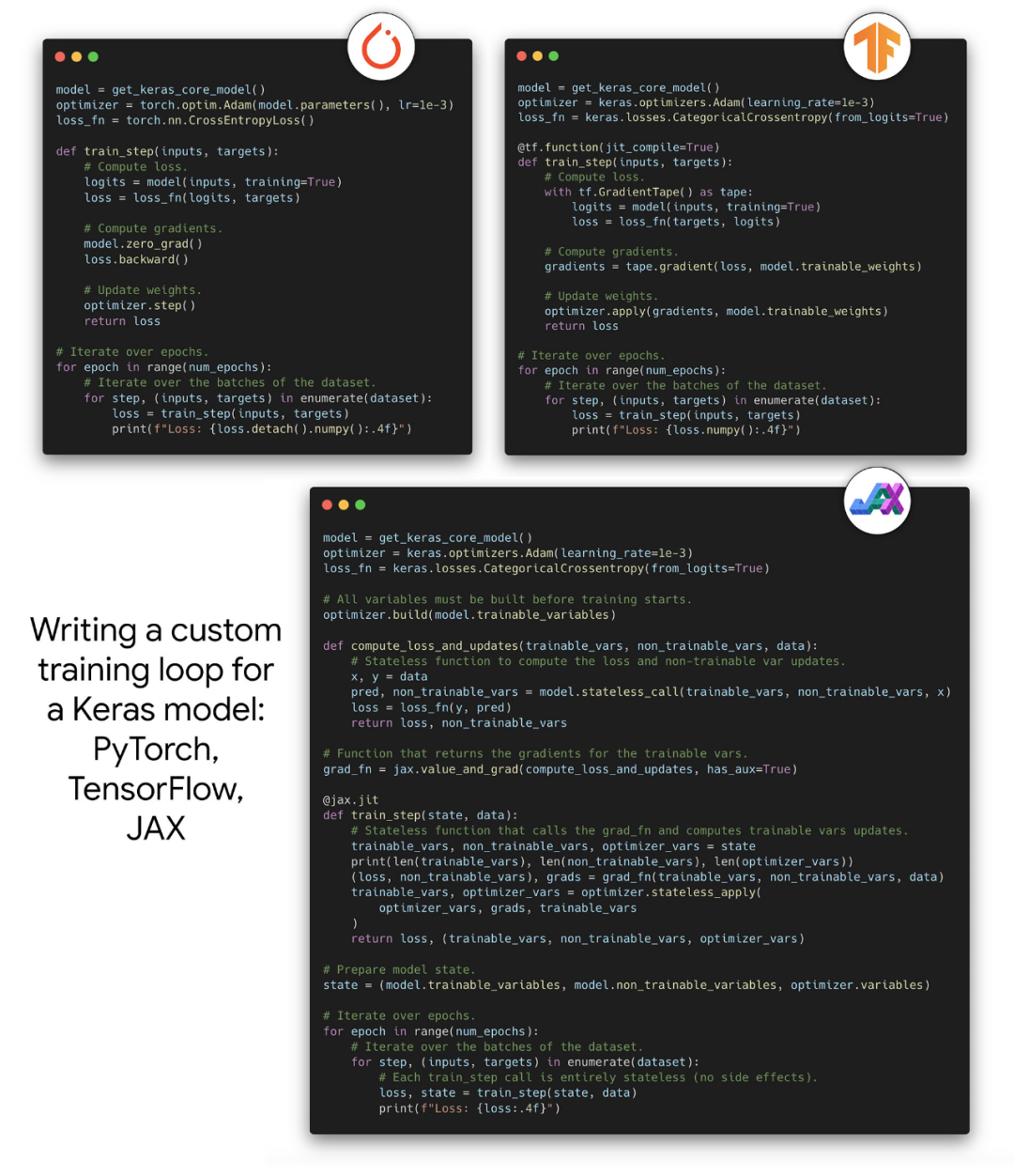

Keras-Adresse: https://keras.io/keras_3/ Keras, das von mehr als 2,5 Millionen Entwicklern verwendet wird, begrüßt Version 3.0 JAX, TensorFlow und PyTorch. Bestehende tf.keras-Modelle, die nur integrierte Ebenen verwenden, können in JAX und PyTorch ausgeführt werden! Keras 3 funktioniert nahtlos mit jedem JAX-, TensorFlow- und PyTorch-Workflow. Keras 3 eignet sich nicht nur für Keras-zentrierte Arbeitsabläufe wie die Definition von Keras-Modellen, Optimierern, Verlusten und Metriken, sondern ist auch für die nahtlose Integration in native Back-End-Arbeitsabläufe von JAX, TensorFlow und PyTorch auf niedriger Ebene beim Training von Keras-Modellen konzipiert. Sie können zwischen JAX-Training, TensorFlow-Training, PyTorch-Training oder der Verwendung als Teil eines JAX- oder PyTorch-Modells wählen. Bei den oben genannten Vorgängen gibt es kein Problem. Keras 3 bietet den gleichen Grad an Implementierungsflexibilität auf niedriger Ebene in JAX und PyTorch wie tf.keras in TensorFlow.

Vortrainiertes Modell. Sie können jetzt eine Vielzahl vorab trainierter Modelle in Keras 3 verwenden. Im Backend sind jetzt 40 Keras-Anwendungsmodelle verfügbar. Darüber hinaus sind auch eine große Anzahl vorab trainierter Modelle (wie BERT, T5, YOLOv8, Whisper

, SAM usw.) in  KerasCV

KerasCV

vorhanden in allen Backends verfügbar.

Keras 3 ist hochgradig abwärtskompatibel mit Keras 2: Keras 3 implementiert jetzt die öffentliche API-Schnittstelle von Keras 2. Die meisten Benutzer können Keras-Skripte auf Keras 3 ausführen, ohne Code zu ändern. Wenn Sie nicht daran gewöhnt sind, Keras 3 zu verwenden, können Sie das neue Versionsupdate ignorieren und weiterhin Keras 2 mit TensorFlow verwenden. Keras 3 unterstützt die rahmenübergreifende Datenpipeline für alle Backends. Maschinelles Lernen mit mehreren Frames bedeutet auch das Laden und Vorverarbeiten von Multiframe-Daten. Keras 3-Modelle können mit einer Vielzahl von Datenpipelines trainiert werden, unabhängig davon, ob Sie das JAX-, PyTorch- oder TensorFlow-Backend verwenden: tf.data.Dataset-Pipelines. torch.utils.data.DataLoader-Objekt.

-

NumPy-Arrays und Pandas-Datenrahmen.

-

Keras‘ keras.utils.PyDataset-Objekt.

-

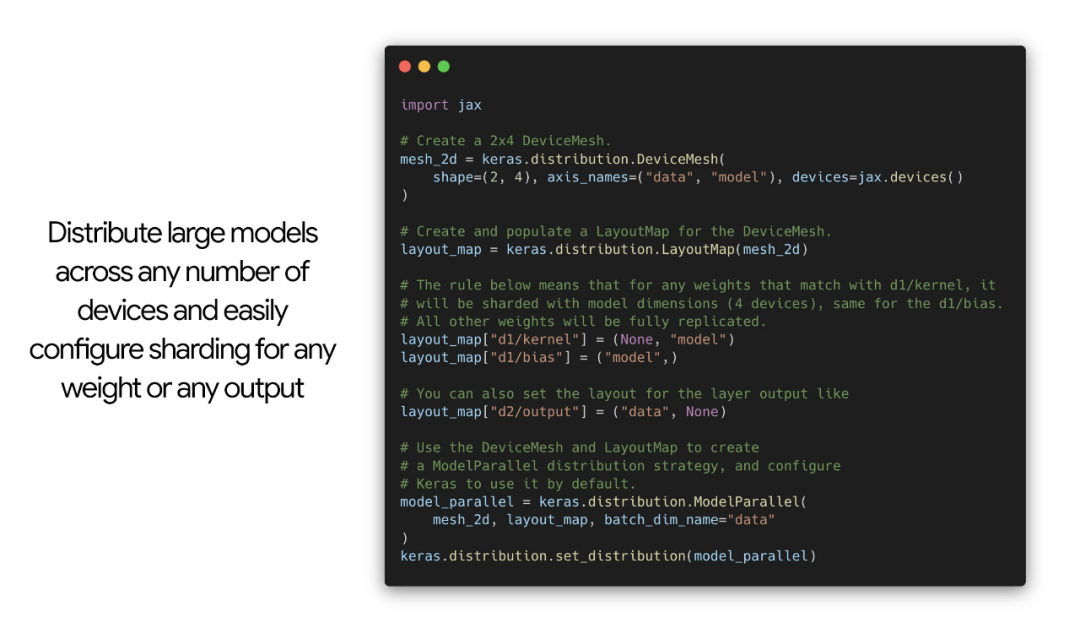

Eine neue verteilte API für groß angelegte Datenparallelität und

Modellparallelität

. Dieses Update ist derzeit nur für das JAX-Backend verfügbar, TensorFlow- und PyTorch-Unterstützung folgen in Kürze.

Datenparallelität (das identische Kopieren eines kleinen Modells auf mehrere Geräte) kann mit nur zwei Zeilen gehandhabt werden: Als nächstes kommt die Modellparallelität. Mit dieser API können Sie das Layout jeder Variablen und jedes Ausgabetensors über reguläre Ausdrücke konfigurieren. Dies erleichtert die schnelle Angabe des gleichen Layouts für eine gesamte Variablenkategorie.

Abschließend hat das Keras-Team auch viele Fragen gesammelt, die alle beschäftigen, und sie beantwortet. Interessierte Leser können auf der offiziellen Website von Keras mehr erfahren. Das obige ist der detaillierte Inhalt vonKeras 3.0 offiziell veröffentlicht: verfügbar für TensorFlow, JAX und PyTorch. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

KerasCV

KerasCV