Heim >Technologie-Peripheriegeräte >KI >Die patentierte gemeinsame Gehirn-Computer-Schnittstelle des Samsung XR bietet eine vollständige sensorische Feedback-Stimulation – Geruch, Geschmack usw.

Die patentierte gemeinsame Gehirn-Computer-Schnittstelle des Samsung XR bietet eine vollständige sensorische Feedback-Stimulation – Geruch, Geschmack usw.

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-11-27 12:58:49759Durchsuche

(Nweon, 27. November 2023) Früheren Informationen zufolge hat Samsung eine vollständige Metaverse-Strategie formuliert und zielt darauf ab, ein Samsung-zentriertes XR-Ökosystem aufzubauen, und rekrutiert aktiv Talente. Dem Patentantrag zufolge hat das Unternehmen tatsächlich über die ultimative Gehirn-Computer-Schnittstelle nachgedacht.

In der Vergangenheit war die Forschung zu Gehirn-Computer-Schnittstellen häufiger bei Meta, Valve und anderen Startups anzutreffen. Natürlich haben sich auch Unternehmen wie Microsoft damit beschäftigt. Heutzutage beginnen Unternehmen, die aktiv im XR-Bereich tätig sind, mit der Erforschung fortschrittlicherer Gehirn-Computer-Schnittstellen. In einer Patentanmeldung mit dem Titel „Information Generation Method and Device“ schlug Samsung vor, die Gehirn-Computer-Schnittstelle auf den Bereich der XR-Sensor-Feedback-Stimulation anzuwenden

Dieses Unternehmen ist davon überzeugt, dass in der XR-Technologie verschiedene sensorische Simulationen hauptsächlich auf der Grundlage von Sensoren implementiert werden. Allerdings wird jede sensorische Simulation durch einen Sensor realisiert, sodass der Prozess umständlich ist. Zudem ist die Sensorik nicht umfassend genug, so dass viele Simulationen nicht umsetzbar sind. Mit anderen Worten: Die mit den entsprechenden Sensoren erzielten Effekte sind weit von der Realität entfernt und der Benutzer kann keine realistischen Simulationen erhalten.

Daher schlägt Samsung vor, Gehirn-Computer-Schnittstellengeräte zu verwenden, um realistische Sinnessimulationen bereitzustellen. Unter anderem kann das System Informationen über die Position des Benutzers relativ zum Zielobjekt in der virtuellen Umgebung erhalten, dann basierend auf den Positionsinformationen und Attributinformationen sensorische Informationen ermitteln, die dem Zielobjekt entsprechen, und schließlich die sensorischen Informationen in elektrische Signale umwandeln Leiten Sie sie durch Gehirn-Computer-Schnittstellengeräte, um Benutzer zu stimulieren.

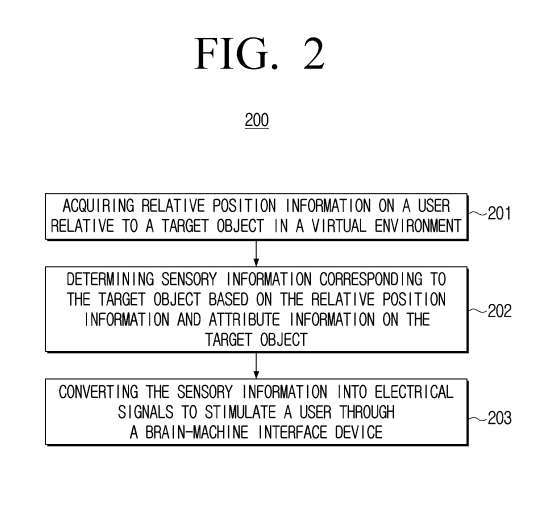

Gemäß einer beispielhaften Ausführungsform zeigt Abbildung 2 ein Flussdiagramm 200 zur Generierung zugehöriger Informationen. Das Informationsgenerierungsverfahren umfasst einen Vorgang zum Erhalten relativer Positionsinformationen des Benutzers relativ zum Zielobjekt in der virtuellen Umgebung 201

In einer Ausführungsform können ein oder mehrere Geräte, die kooperativ miteinander arbeiten, als Ausführungseinheiten bezeichnet werden. Die Ausführungseinheit kann ein räumliches rechteckiges Koordinatensystem erstellen, die Standortinformationen des Benutzers im rechteckigen Koordinatensystem und die Standortinformationen des Zielobjekts in der virtuellen Umgebung in Echtzeit abrufen und basierend auf den Standortinformationen des Benutzers und den Standortinformationen von bestimmen das Zielobjekt. Relative Positionsinformationen des Benutzers relativ zum Zielobjekt.

Die Ausführungseinheit kann regelmäßig die Positionsinformationen des Benutzers im rechteckigen Koordinatensystem und die Positionsinformationen des Zielobjekts in der virtuellen Umgebung abrufen. Das Zielobjekt kann ein beliebiges Zielobjekt in der virtuellen Umgebung sein, beispielsweise ein Tisch, ein Glas Wasser, Brot usw.

In Vorgang 202 werden sensorische Informationen, die dem Zielobjekt entsprechen, basierend auf den relativen Positionsinformationen und Attributinformationen des Zielobjekts bestimmt.

Gemäß einer beispielhaften Ausführungsform kann die Ausführungseinheit nach Erhalt der relativen Positionsinformationen des Benutzers relativ zum Zielobjekt in der virtuellen Umgebung weiterhin die sensorischen Informationen bestimmen, die dem Zielobjekt gemäß der Entsprechungstabelle oder der sensorischen Informationsvorhersage entsprechen Modell. Beispielsweise kann die Korrespondenztabelle vorbestimmte relative Positionsinformationen, Attributinformationen des Zielobjekts und damit verbundene sensorische Informationen speichern. Das Vorhersagemodell für sensorische Informationen kann ein vorbestimmtes Vorhersagemodell für sensorische Informationen sein, das durch Durchführen eines Trainingsvorgangs bestimmt wird.

Gemäß der beispielhaften Ausführungsform können wir die relativen Positionsinformationen des Zielobjekts und Attributproben mit sensorischen Informationen verwenden, um das Modell zu trainieren und so ein Modell zu erhalten, das sensorische Informationen vorhersagt

Zu den sensorischen Informationen des Zielobjekts können zumindest Berührung, Hören, Geruch oder Geschmack gehören. Sinnesinformationen können durch Reizparameter dargestellt werden. Stimulationsparameter können auf Basis der tatsächlich vom Benutzer am Zielobjekt in der realen Umgebung erzeugten sensorischen Informationen ermittelt werden

Interessanterweise schlug Samsung vor, dass der relevante Stimulator CereStim sein könnte, ein vollständig programmierbarer 96-Kanal-Neurostimulator des Gehirncomputer-Startups Blackrock. Aber natürlich gibt das Unternehmen an, dass das betreffende Gerät nur eine Option sei und andere Emulatoren möglich seien.

In einem Beispielszenario berührt der Benutzer ein Objekt bei 30 Grad Celsius und die Elektrodenaktivität wird mithilfe des Neural Port Neural Signal Collector aufgezeichnet. Die von den Elektroden aufgezeichnete neuronale Aktivität wird verstärkt und mit einer Abtastfrequenz von 30 kHz analog-digital (A/D) abgetastet und dann mit dem Neural Port Neural Signal Processor NSP-System aufgezeichnet. Schreiben Sie dann Stimulationsparameter über die Matlab-API von CereStim und erhalten Sie erneut Elektrodensignale durch unterschiedliche Impulsstimulation und Anpassung der Stromstärke. Wenn die Elektrodensignale unendlich nahe beieinander liegen, können sie die Stimulationsparameter des 30 Grad Celsius heißen Objekts berühren.

Ebenso können beliebige Stimulationsparameter für Berührung, Hören oder Riechen ermittelt werden.

Bei der Durchführung von 203 Operationen umfasst die Methode die Umwandlung sensorischer Informationen in elektrische Signale und die Stimulation des Benutzers über ein Gehirn-Computer-Schnittstellengerät

Nach der Bestimmung der sensorischen Informationen, die dem Zielobjekt entsprechen, kann die Ausführungseinheit das Gehirn-Computer-Schnittstellengerät verwenden, um diese sensorischen Informationen in elektrische Signale umzuwandeln und dann das entsprechende Gefühl durch Stimulierung der entsprechenden Teile in der Großhirnrinde des Benutzers zu erzeugen

Gemäß einer anderen beispielhaften Ausführungsform kann der Vorgang des Bestimmens sensorischer Informationen, die dem Zielobjekt entsprechen, basierend auf den relativen Positionsinformationen und Attributinformationen des Zielobjekts, das Bestimmen der sensorischen Informationen, die dem Zielobjekt entsprechen, basierend auf der Gesichtsausrichtung des Benutzers und dem umfassen Abstand zwischen dem Kopf des Benutzers und dem Zielobjekt und Bestimmen der Geruchsinformationen als sensorische Informationen, die dem Zielobjekt entsprechen.

Gemäß einer anderen beispielhaften Ausführungsform kann das Verfahren das Bestimmen, dass das Zielobjekt ein Geruchsattribut aufweist, und das Bestimmen von Geruchsinformationen, die dem Zielobjekt entsprechen, entsprechend der Gesichtsausrichtung des Benutzers und dem Abstand zwischen dem Kopf des Benutzers und dem Zielobjekt umfassen. Als Reaktion auf oder basierend auf der Feststellung, dass das Zielobjekt ein Geruchsattribut aufweist, werden olfaktorische Informationen als sensorische Informationen bestimmt, die dem Zielobjekt entsprechen.

Geruchsattribute können Fruchtaroma, Blumenaroma, Lebensmittelaroma und andere Attributinformationen umfassen.

In einer Ausführungsform werden sensorische Informationen in Bezug auf das Zielobjekt durch Nutzung relativer Positionsinformationen und Attributinformationen des Zielobjekts bestimmt. Auf der Grundlage der Bestätigung, dass das Zielobjekt Schallattribute aufweist, können die mit dem Zielobjekt verbundenen Hörinformationen basierend auf der Gesichtsrichtung des Benutzers und dem Abstand zwischen dem Kopf des Benutzers und dem Zielobjekt bestimmt werden, und dann werden die Hörinformationen ermittelt bestimmt, dass sie mit dem Zielobjekt in Zusammenhang stehen

Die Ausführungseinheit kann die tragbaren Positionierungsgeräte auf der linken und rechten Seite des Kopfes des Benutzers verwenden, um die linken und rechten Koordinaten des Benutzers zu bestimmen, außerdem die Linie zu bestimmen, die die linken und rechten Koordinaten des Kopfes des Benutzers verbindet, und basierend darauf auf der Linie und den Koordinaten Der Winkel zwischen den Ebenenrichtungen, in denen sich die Koordinaten des Zielobjekts befinden, bestimmt die Ausrichtung des Gesichts des Benutzers.

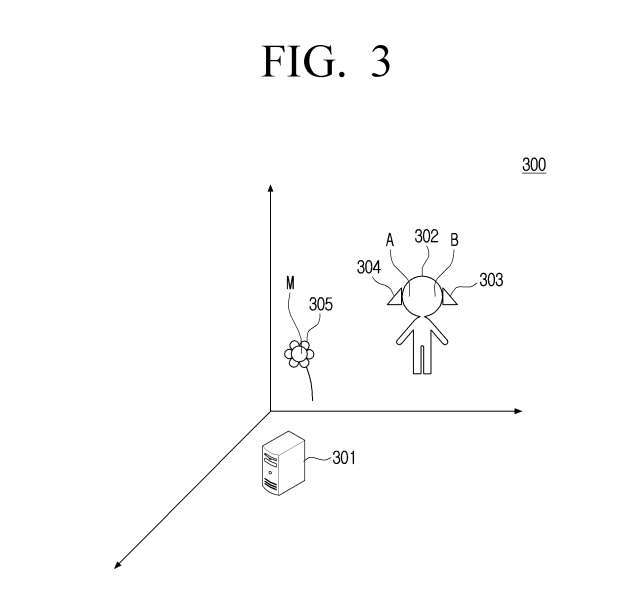

Gemäß Abbildung 3 kann die Ausführungseinheit 301 unter Verwendung der UWB-Basisstation als Ursprung ein räumliches rechtwinkliges Koordinatensystem erstellen und das erste tragbare Positionierungsgerät 303 auf der linken Seite des Kopfes des Benutzers und das zweite tragbare Positionierungsgerät verwenden 303 auf der rechten Seite des Kopfes des Benutzers erhält die Koordinaten A und B, die dem Kopf des Benutzers entsprechen

Gemäß beispielhaften Ausführungsformen können die tragbaren Positionierungsgeräte 303 und 304 UWB-Chips sein. Die UWB-Basisstation kann durch die Ausführungseinheit 301 implementiert werden. Koordinate A entspricht Chip 303, also der Koordinate der linken Seite des Kopfes des Benutzers, und Koordinate B entspricht Chip 304, also der Koordinate der rechten Seite des Kopfes des Benutzers.

Ermitteln Sie gleichzeitig die Koordinate M des Zielobjekts 305 und bestimmen Sie den Winkel zwischen der Geraden AB und der Richtung der Ebene, in der sich M befindet, als Orientierung für den Benutzer. Hier ist das Zielobjekt 305 eine virtuelle Blume. Die Ausführungseinheit kann die dem Zielobjekt entsprechenden Geruchsinformationen aus der vorgegebenen Entsprechungstabelle entsprechend der Gesichtsausrichtung des Benutzers und dem Abstand zwischen dem Kopf des Benutzers und dem Zielobjekt ermitteln Die olfaktorischen Informationen entsprechen den sensorischen Informationen. Die Korrespondenztabelle erfasst die Gesichtsausrichtung des Benutzers, den Abstand zwischen dem Kopf des Benutzers und dem Zielobjekt sowie die damit verbundenen olfaktorischen Informationen.

In dieser Ausführungsform werden die Koordinaten der linken und rechten Seite des Kopfes des Benutzers bestimmt, indem tragbare Positionierungsgeräte auf der linken und rechten Seite des Kopfes des Benutzers verwendet werden. Die Richtung des Gesichts des Benutzers wird bestimmt, indem der Winkel zwischen der geraden Linie, die die Koordinaten auf der linken und rechten Seite des Kopfes des Benutzers verbindet, und der Richtung der Ebene berechnet wird, in der sich die Koordinaten des Zielobjekts befinden. Dies verbessert effektiv die Genauigkeit der Bestimmung der Gesichtsausrichtung des Benutzers

Die Ausführungseinheit kann basierend auf den relativen Positionsinformationen des Kopfes des Benutzers relativ zum Zielobjekt erkennen und den Geschmack bestimmen, der dem essbaren Attribut entspricht, basierend auf der Bedingung, dass sich das Zielobjekt an einer vorbestimmten Position des Kopfes des Benutzers befindet Das Zielobjekt verfügt über essbare Attribute als sensorische Informationen, die dem Zielobjekt entsprechen

Kann Attributinformationen wie Bananengeschmack, Apfelgeschmack usw. enthalten.

Es ist zu beachten, dass, bevor festgestellt wird, dass sich das Zielobjekt an der vorgegebenen Position des Kopfes des Benutzers befindet, möglicherweise eine Aktion des Benutzers das Zielobjekt berührt oder keine Aktion des Benutzers erfolgt Zielobjekt innerhalb des vorgegebenen Zeitbereichs.

In einer Ausführungsform kann durch die Bestimmung, ob der Abstand zwischen der Hand des Benutzers und dem Zielobjekt einen vorgegebenen Schwellenwert erreicht, bestimmt werden, ob eine Aktion des Benutzers vorliegt, die das virtuelle Objekt berührt.

In dieser Ausführungsform werden zunächst basierend auf der vorgegebenen Position des Zielobjekts auf dem Kopf des Benutzers und seinem essbaren Attribut die Geschmacksinformationen, die dem essbaren Attribut entsprechen, als sensorische Informationen des Zielobjekts bestimmt. Die sensorischen Informationen werden dann in elektrische Signale umgewandelt und über Gehirn-Computer-Schnittstellengeräte stimuliert, wodurch Benutzer die essbaren Eigenschaften von Objekten in der virtuellen Umgebung erleben und die Authentizität der Interaktion verbessert werden

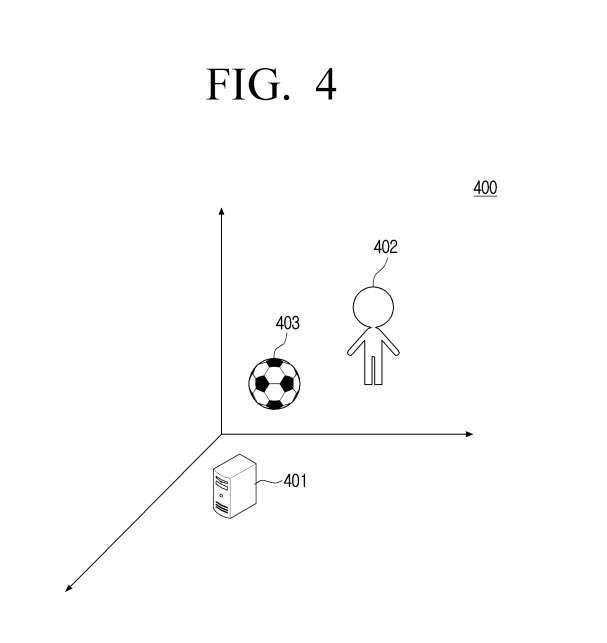

Das schematische Diagramm zeigt das Anwendungsszenario der Informationsgenerierungsmethode, wie in Abbildung 4 dargestellt

In dem in Abbildung 4 dargestellten Anwendungsszenario kann Entität 401 ein räumliches rechtwinkliges Koordinatensystem mit der UWB-Basisstation als Ursprung erstellen. Durch die Verwendung eines tragbaren Positionierungsgeräts an einem oder mehreren Körperteilen des Benutzers 402 können die Positionsinformationen des Benutzers im räumlichen rechtwinkligen Koordinatensystem erhalten werden

Zum Beispiel können tragbare Positionierungsgeräte an Händen und Kopf des Benutzers angebracht werden. Die UWB-Basisstation kann durch die Ausführungseinheit 401 implementiert werden. Gemäß einer beispielhaften Ausführungsform kann die Entität Positionsinformationen zu einem Zielobjekt 403, beispielsweise einem virtuellen Fußball, erhalten, um dadurch die relative Position des Benutzers relativ zum Zielobjekt basierend auf den Positionsinformationen des Benutzers und den Positionsinformationen auf dem Zielobjekt zu bestimmen Zielobjektinformationen.

Bestimmen Sie als Nächstes die sensorischen Informationen, die dem Zielobjekt entsprechen, anhand der Entsprechungstabelle. Diese Korrespondenztabelle zeichnet die vorgegebenen relativen Positionsinformationen, Attributinformationen (wie Glätte, Weichheit usw.) und entsprechende sensorische Informationen des Zielobjekts auf. Anschließend werden diese sensorischen Informationen in elektrische Signale umgewandelt und durch das Gehirn-Computer-Schnittstellengerät 402

stimuliertDas Informationserzeugungsverfahren kann das Erhalten der relativen Positionsinformationen des Benutzers relativ zum Zielobjekt in der virtuellen Umgebung, das Bestimmen der sensorischen Informationen, die dem Zielobjekt entsprechen, gemäß den relativen Positionsinformationen und Attributinformationen des Zielobjekts und deren Verwendung umfassen Das Gehirn-Computer-Schnittstellengerät wandelt die sensorischen Informationen in elektrische Signale um, um den Benutzer zu stimulieren. Dadurch kann der Benutzer die Eigenschaften von Objekten in der virtuellen Umgebung erleben und die Authentizität der Interaktion verbessern.

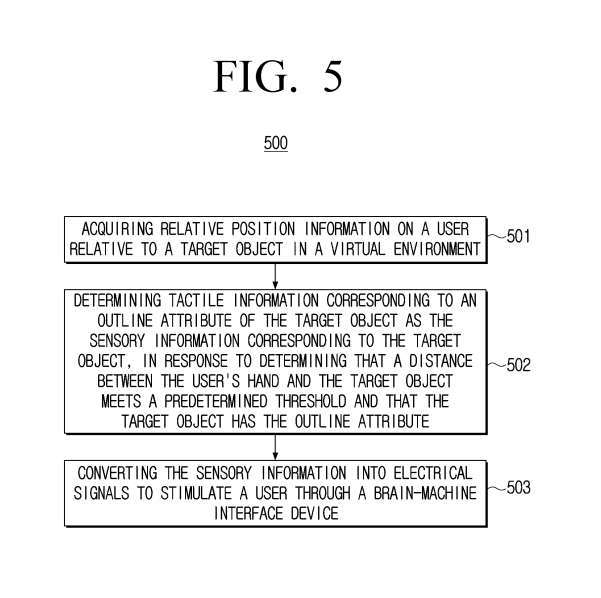

Bitte beachten Sie Abbildung 5, die ein Flussdiagramm 500 der Informationsgenerierungsmethode ist

Bei der 501-Operation können die relativen Positionsinformationen des Benutzers relativ zum Zielobjekt in der virtuellen Umgebung durch die Informationsgenerierungsmethode erhalten werden

Wenn bei der Durchführung der 502-Operation festgestellt wird, dass der Abstand zwischen der Hand des Benutzers und dem Zielobjekt den voreingestellten Schwellenwert erreicht und das Zielobjekt Umrissmerkmale aufweist, werden die taktilen Informationen entsprechend den Umrissmerkmalen des Zielobjekts angezeigt Als Zielobjekt werden entsprechende sensorische Informationen ermittelt

Umgeschriebener Inhalt: Die relativen Positionsinformationen können relative Positionsinformationen zwischen der Hand des Benutzers und dem Zielobjekt umfassen, und die Ausführungseinheit kann den Abstand zwischen der Hand des Benutzers und dem Zielobjekt erkennen. Als Reaktion auf die Feststellung, dass der Abstand zwischen der Hand des Benutzers und dem Zielobjekt einem vorgegebenen Schwellenwert entspricht und das Zielobjekt ein Konturattribut aufweist, werden taktile Informationen, die dem Konturattribut des Zielobjekts entsprechen, als sensorische Informationen, die dem Zielobjekt entsprechen

, bestimmtKann Profil-, Material-, Textur-, Glätte-, Temperatur-, Qualitäts- und andere Attributinformationen enthalten

Dabei kann der vorgegebene Schwellenwert basierend auf Erfahrung, tatsächlichen Bedürfnissen und spezifischen Anwendungsszenarien festgelegt werden. Beispielsweise ist der Abstand zwischen den Fingern und/oder der Handfläche und dem Zielobjekt kleiner oder gleich 1 cm, oder der Abstand zwischen den Fingern und/oder der Handfläche und dem Zielobjekt ist kleiner oder gleich 0,5 cm. was in der vorliegenden Offenbarung nicht beschränkt ist.

Konkret erstellt das System ein räumliches rechtwinkliges Koordinatensystem mit der UWB-Basisstation als Ursprung, verwendet einen an der Hand des Benutzers getragenen Datenhandschuh, um Informationen zur Handposition des Benutzers zu erhalten, und erhält gleichzeitig die Positionsinformationen des Zielobjekts. Das Zielobjekt ist ein Wasserbecher und der voreingestellte Schwellenwert besteht darin, dass der Abstand zwischen den Fingern und/oder Handflächen des Benutzers und dem Wasserbecher höchstens 1 cm beträgt

Um den vorgegebenen Schwellenwert zu erreichen, wird der Abstand zwischen den Fingern und/oder der Handfläche des Benutzers und dem Wasserbecher unter Berücksichtigung der Konturattribute des Wasserbechers bestimmt, wobei die taktilen Informationen den Konturattributen des Wasserbechers entsprechen wird als sensorische Information des Wasserbechers ermittelt

In Operation 503 umfasst es die Umwandlung sensorischer Informationen in elektrische Signale über das Gehirn-Computer-Schnittstellengerät, um den Benutzer zu stimulieren.

Verglichen mit der in der beispielhaften Ausführungsform von FIG. 2 gezeigten Methode, um zu bestimmen, ob der Abstand zwischen der Hand des Benutzers und dem Zielobjekt den vorgegebenen Schwellenwert erfüllt Das Zielobjekt verfügt über Konturattribute. Die taktilen Informationen, die den Umrissattributen des Zielobjekts entsprechen, werden als sensorische Informationen bestimmt, die dem Zielobjekt entsprechen.

Über das Gehirn-Computer-Schnittstellengerät werden die vom Benutzer wahrgenommenen Informationen in elektrische Signale umgewandelt und der Benutzer wird dazu angeregt, die Kontureigenschaften des Objekts in der virtuellen Umgebung zu erleben, um die Authentizität der Interaktion zu verbessern

Erweiterte Lektüre: Samsung-Patent | Methode und Gerät zur Informationsgenerierung

Samsungs Patentanmeldung mit dem Titel „Methode und Gerät zur Informationsgenerierung“ wurde ursprünglich im Juli 2023 eingereicht und kürzlich vom US-amerikanischen Patent- und Markenamt veröffentlicht.

Normalerweise wird eine US-Patentanmeldung nach Prüfung automatisch oder auf Antrag des Anmelders innerhalb von 18 Monaten nach dem Anmelde- oder Prioritätsdatum veröffentlicht. Es ist zu beachten, dass die Veröffentlichung einer Patentanmeldung nicht bedeutet, dass das Patent erteilt wurde. Nachdem die Patentanmeldung veröffentlicht wurde, muss das USPTO eine inhaltliche Prüfung durchführen, die 1 bis 3 Jahre dauern kann

Das obige ist der detaillierte Inhalt vonDie patentierte gemeinsame Gehirn-Computer-Schnittstelle des Samsung XR bietet eine vollständige sensorische Feedback-Stimulation – Geruch, Geschmack usw.. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Das Zhongguancun Forum 2023 konzentriert sich auf Spitzenbereiche wie künstliche Intelligenz und Gehirn-Computer-Schnittstelle und bietet viele Höhepunkte

- Stecken Sie die Elektroden ein und Musk wird Ihr Gehirn zerschneiden! Klinische Neuralink-Studie von der FDA genehmigt, Gehirn-Computer-Schnittstellenprojekt erreicht neuen Meilenstein

- Endlich! Die FDA genehmigt die Gehirn-Computer-Schnittstelle von Musk für chirurgische Eingriffe im echten Leben, was von großer Bedeutung ist

- Brain Tiger-Technologie: An der Spitze der „Gehirn-Computer-Schnittstelle' stehen und schrittweise Ergebnisse bei der grenzüberschreitenden Integration erzielen

- Musk enthüllt große Neuigkeiten! Sein Unternehmen für Gehirn-Computer-Schnittstellen entwickelt einen Vision-Chip ...