Heim >Technologie-Peripheriegeräte >KI >Das IDEA Research Institute hat eine neue Technologie eingeführt und das T-Rex-Modell veröffentlicht, mit dem Benutzer direkt auf dem Bild „Prompt'-Eingabeaufforderungen auswählen können

Das IDEA Research Institute hat eine neue Technologie eingeführt und das T-Rex-Modell veröffentlicht, mit dem Benutzer direkt auf dem Bild „Prompt'-Eingabeaufforderungen auswählen können

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-11-24 08:10:381458Durchsuche

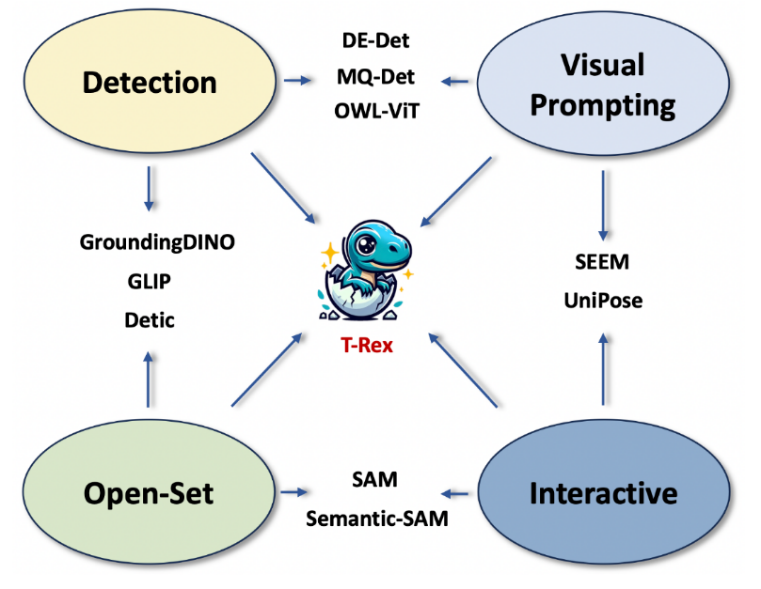

Nach dem beliebten Grounded SAM ist das Team des IDEA Research Institutemit einer neuen Arbeit zurück: einem neuen visuellen Prompt (Visual Prompt) Modell T-Re x, verwenden Sie Bilder, um Bilder zu erkennen, verwenden Sie es sofort nach dem Auspacken,  eröffnen Sie eine neue Welt der Erkennung offener Mengen!

eröffnen Sie eine neue Welt der Erkennung offener Mengen!

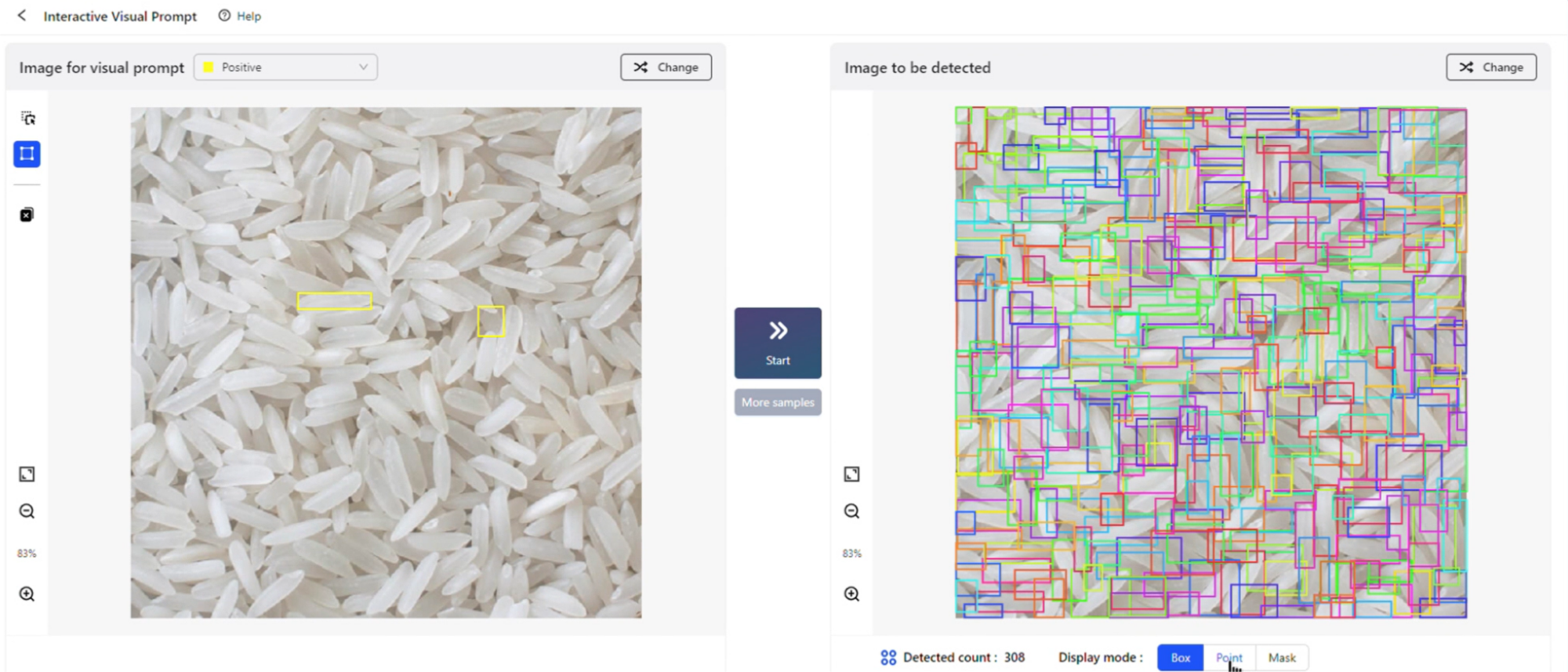

Rahmen ziehen, prüfen und fertigstellen! Auf der gerade zu Ende gegangenen IDEA-Konferenz 2023 demonstrierte Shen Xiangyang, Gründungsvorsitzender des IDEA Research Institute und ausländischer Akademiker der National Academy of Engineering, ein neues Zielerkennungserlebnis basierend auf visuellen Hinweisen und stellte das Modelllabor (Spielplatz) des neuen vor visuelle Hinweise Modell T-Rex), Interactive Visual Prompt (iVP), löste vor Ort eine Welle von Testhöhepunkten aus.

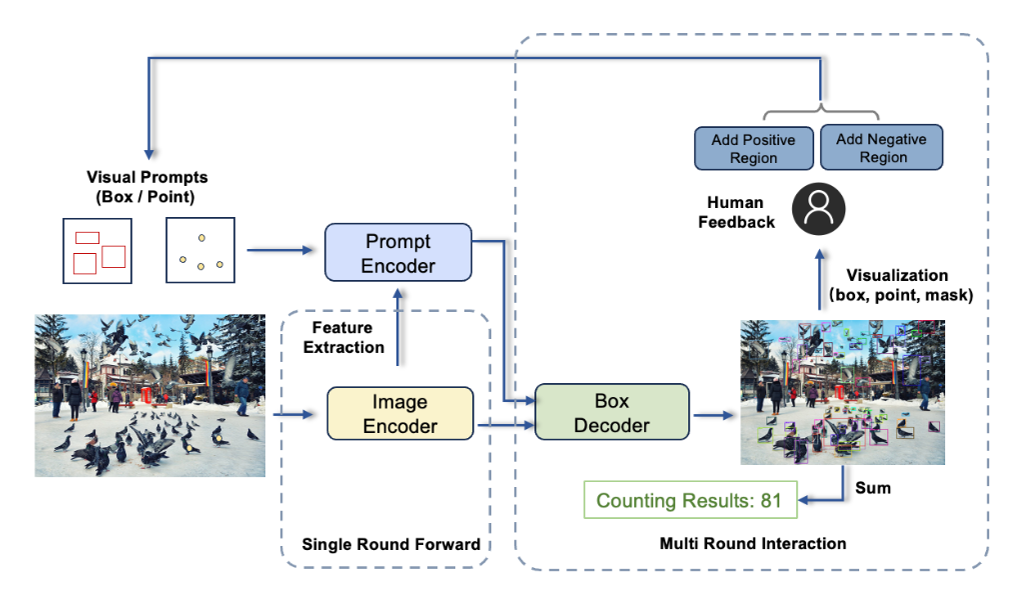

Auf iVP können Benutzer persönlich das Erlebnis „Ein Bild sagt mehr als tausend Worte“ freischalten: Markieren Sie das gewünschte Objekt auf dem Bild, geben Sie dem Modell ein visuelles Beispiel, und das Modell erkennt dann alles ähnliche Objekte im Zielbild Beispiel. Der gesamte Prozess ist interaktiv und kann problemlos in wenigen Schritten abgeschlossen werden.

Grounded SAM (Grounding DINO + SAM), veröffentlicht vom IDEA Research Institute im April, erfreute sich auf Github großer Beliebtheit und hat bisher 11.000 Sterne gesammelt. Im Gegensatz zu Grounded SAM, das nur Textaufforderungen unterstützt, bietet das dieses Mal veröffentlichte T-Rex-Modell eine visuelle Aufforderungsfunktion, die sich auf die Schaffung einer starken Interaktion konzentriert.

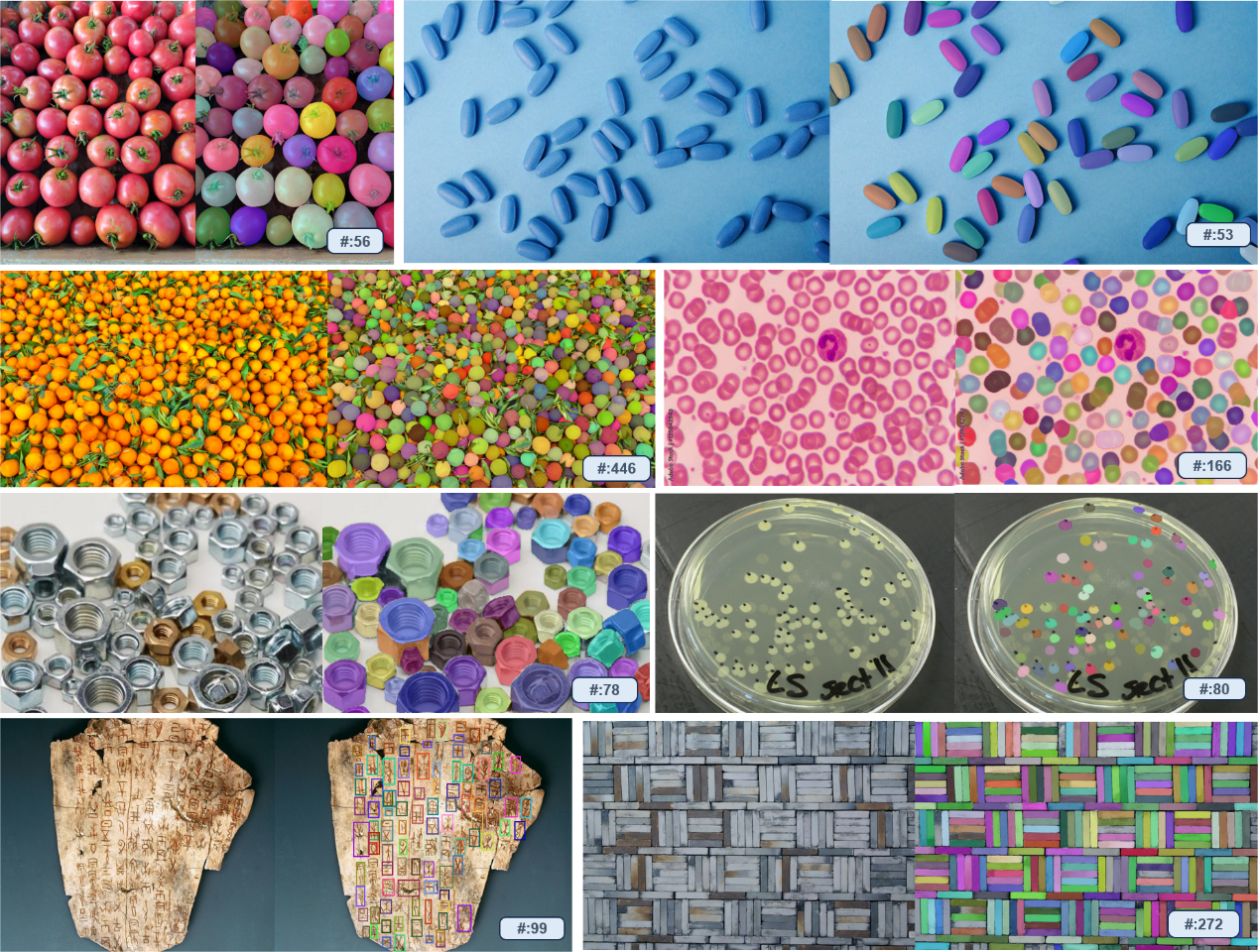

T-Rex verfügt über starke sofort einsatzbereite Funktionen und kann Objekte erkennen, die das Modell während der Trainingsphase noch nie gesehen hat, ohne dass eine Neuschulung oder Feinabstimmung erforderlich ist. Dieses Modell kann nicht nur auf alle Detektionsaufgaben einschließlich der Zählung angewendet werden, sondern bietet auch neue Lösungen für intelligente interaktive Annotationsszenarien.

Das Team stellte fest, dass die Entwicklung der visuellen Eingabeaufforderungstechnologie auf der Beobachtung von Schmerzpunkten in realen Szenen beruhte. Einige Partner hoffen, visuelle Modelle zu verwenden, um die Anzahl der Waren auf Lastwagen zu zählen. Das Modell kann jedoch nicht jede Ware einzeln anhand von Textaufforderungen identifizieren. Der Grund dafür ist, dass Objekte in Industrieszenen im täglichen Leben selten und schwer mit Worten zu beschreiben sind. In diesem Fall sind visuelle Hinweise eindeutig ein effizienterer Ansatz. Gleichzeitig tragen intuitives visuelles Feedback und starke Interaktivität dazu bei, die Effizienz und Genauigkeit der Erkennung zu verbessern.

Basierend auf Erkenntnissen über die tatsächlichen Nutzungsanforderungen hat das Team T-Rex als ein Modell entworfen, das mehrere visuelle Hinweise akzeptieren kann und über die Fähigkeit verfügt, über Bilder hinweg Eingabeaufforderungen zu erteilen. Zusätzlich zum einfachsten Einzelrunden-Promptmodus unterstützt das aktuelle Modell auch die folgenden drei erweiterten Modi

- Mehrrunden-Positivmodus: geeignet für Szenarien, in denen visuelle Eingabeaufforderungen nicht genau genug sind und zu Fehlerkennungen führen

- Positiv + Negativ-Modus: Geeignet für Szenarien, in denen visuelle Hinweise mehrdeutig sind und zu Fehlerkennungen führen.

- Cross-Image-Modus: Geeignet für Szenarien, in denen ein einzelnes Referenzbild die Erkennung anderer Bilder auslöst Zeitlich fasste das Team die vier Hauptmerkmale des Rex-Modells zusammen:

Offener Satz: nicht durch vordefinierte Kategorien eingeschränkt, mit der Fähigkeit, alle Objekte zu erkennen.

Offener Satz: nicht durch vordefinierte Kategorien eingeschränkt, mit der Fähigkeit, alle Objekte zu erkennen.

- Visuelle Eingabeaufforderungen: Verwenden Sie visuelle Beispiele, um Erkennungsziele anzugeben Überwinden Sie die Schwierigkeit, seltene und komplexe Objekte zu verwenden. Vollständig in Text ausgedrückte Fragen verbessern die Effizienz der Eingabeaufforderung.

- Intuitives visuelles Feedback: Bieten Sie intuitives visuelles Feedback wie Begrenzungsrahmen, um Benutzern eine effiziente Bewertung der Erkennungsergebnisse zu erleichtern und korrekte Modellergebnisse

- Das Forschungsteam wies darauf hin, dass in Zielerkennungsszenarien das Hinzufügen visueller Hinweise einige der Mängel von Texthinweisen ausgleichen kann. In Zukunft wird die Kombination beider das Potenzial der CV-Technologie in noch vertikaleren Bereichen freisetzen.

- Technische Details zum T-Rex-Modell entnehmen Sie bitte dem zeitgleich veröffentlichten technischen Bericht.

iVP

https://deepdataspace.com/playground/ivp

Github-Link: trex-counting.github.io

Diese Arbeit stammt vom Computer Vision and Robotics Research Center des IDEA Institute. Das bisherige Open-Source-Zielerkennungsmodell DINO war das erste DETR-Modell, das den ersten Platz in der COCO-Zielerkennungsrankings erreichte; der sehr beliebte Zero-Shot-Detektor Grounding DINO auf Github kann auch jedes Objekt erkennen und segmentieren die Arbeit dieses Teams

Das obige ist der detaillierte Inhalt vonDas IDEA Research Institute hat eine neue Technologie eingeführt und das T-Rex-Modell veröffentlicht, mit dem Benutzer direkt auf dem Bild „Prompt'-Eingabeaufforderungen auswählen können. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- h5-Tutorial zum Selbststudium: 6 empfohlene nullbasierte HTML5-Tutorials zum Selbststudium, die für Anfänger geeignet sind

- Ausführliche Erläuterung des ABP-Einführungs-Tutorials der ABP-Reihe des ASP.NET-Vorlagenentwicklungsframeworks

- Erste Schritte-Tutorial zur Verwendung eines Digitalmultimeters

- Panoramaanalyse der industriellen Bildverarbeitungskette

- Ling Yunguang: Maschinelles Sehen und KI-Innovation helfen bei der „intelligenten' Herstellung von Lithiumbatterien