Heim >Technologie-Peripheriegeräte >KI >GPT-4 schneidet bei der Graphinferenz schlecht ab? Selbst nach dem „Ablassen von Wasser' beträgt die Genauigkeitsrate nur 33 %

GPT-4 schneidet bei der Graphinferenz schlecht ab? Selbst nach dem „Ablassen von Wasser' beträgt die Genauigkeitsrate nur 33 %

- 王林nach vorne

- 2023-11-21 08:38:56872Durchsuche

GPT-4s Fähigkeit zum grafischen Denken ist weniger als halb so groß wie die des Menschen?

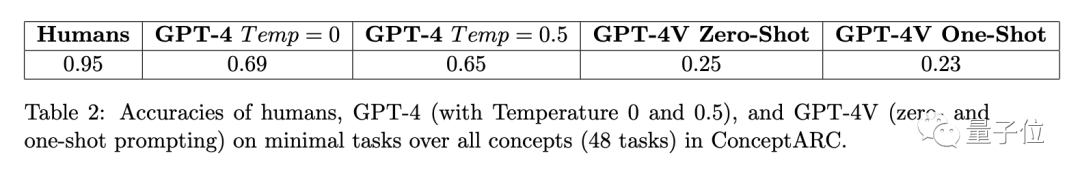

Eine Studie des Santa Fe Research Institute in den Vereinigten Staaten zeigt, dass die Genauigkeit von GPT-4 für Fragen zum grafischen Denken nur 33 % beträgt.

GPT-4v verfügt über multimodale Fähigkeiten, aber seine Leistung ist relativ schlecht und kann nur 25 % der Fragen richtig beantworten

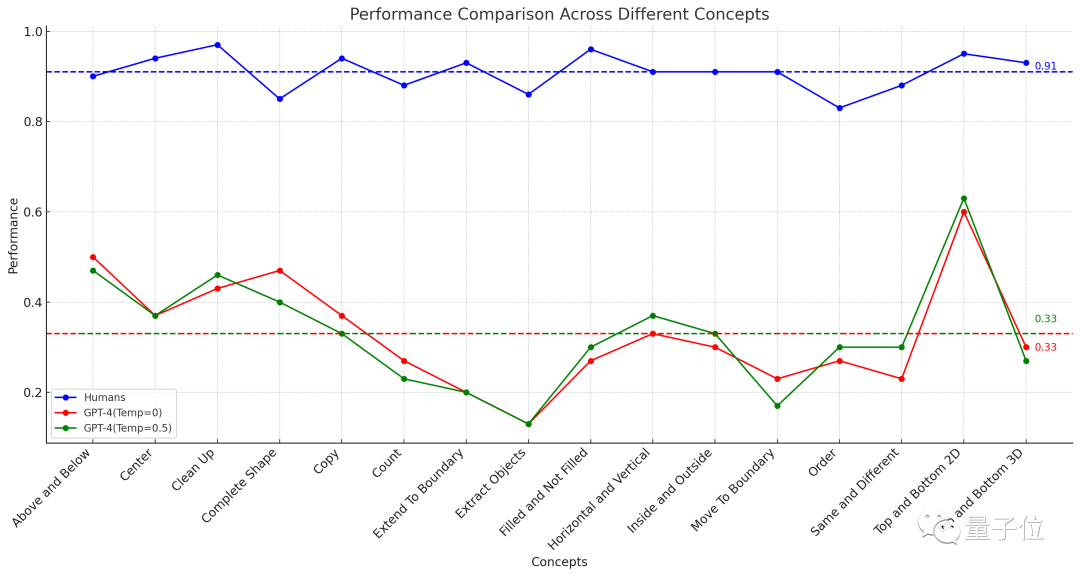

△Die gepunktete Linie stellt die durchschnittliche Leistung von 16 Aufgaben dar

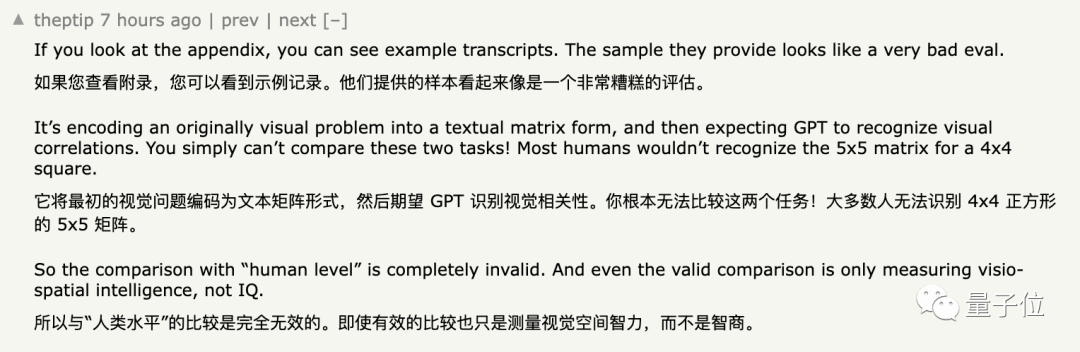

Sobald die Ergebnisse vorliegen Dieses Experiment wurde veröffentlicht und löste sofort eine breite Diskussion auf YC aus

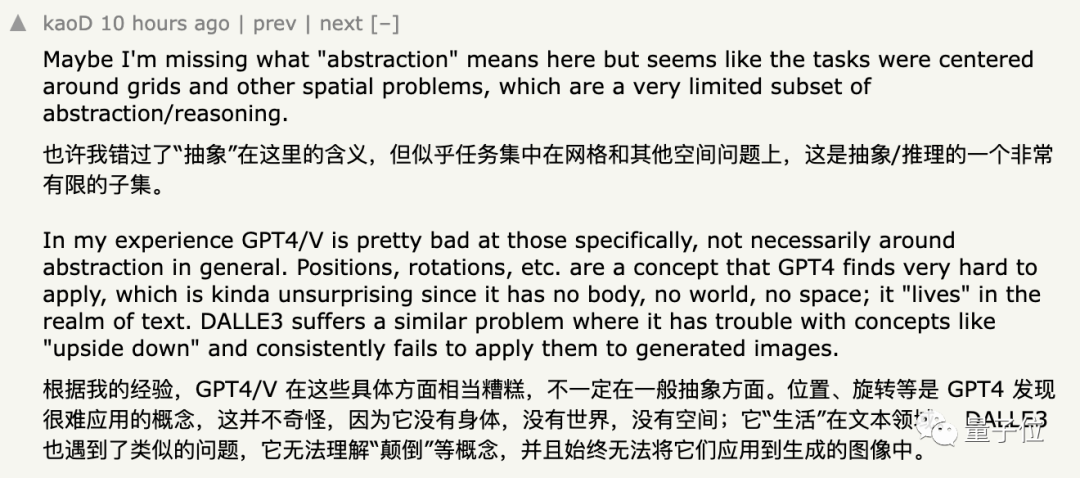

Einige Internetnutzer, die dieses Ergebnis unterstützten, sagten, dass GPT bei der Verarbeitung abstrakter Grafiken nicht gut funktioniert und es schwieriger ist, Konzepte wie „Position“ und „Rotation“ zu verstehen

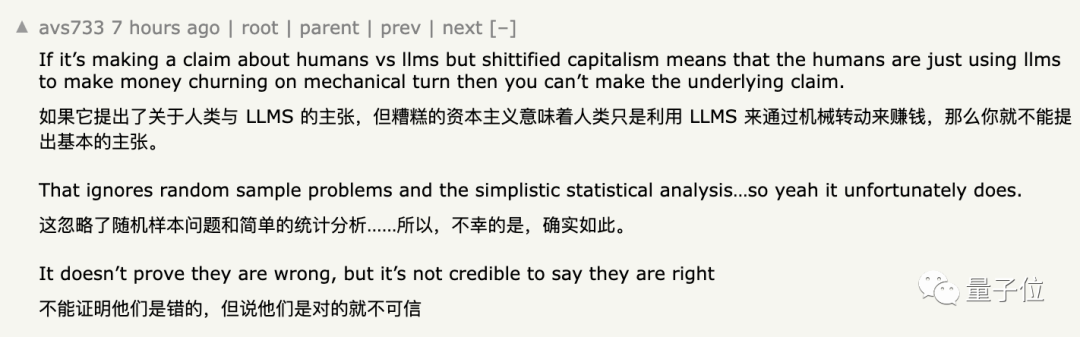

Einige Internetnutzer äußerten jedoch Zweifel an dieser Schlussfolgerung:

Obwohl diese Ansicht nicht als falsch bezeichnet werden kann, ist sie nicht völlig überzeugend

Was das Konkrete betrifft Aus Gründen lesen wir weiter.

Die Genauigkeit von GPT-4 beträgt nur 33 %

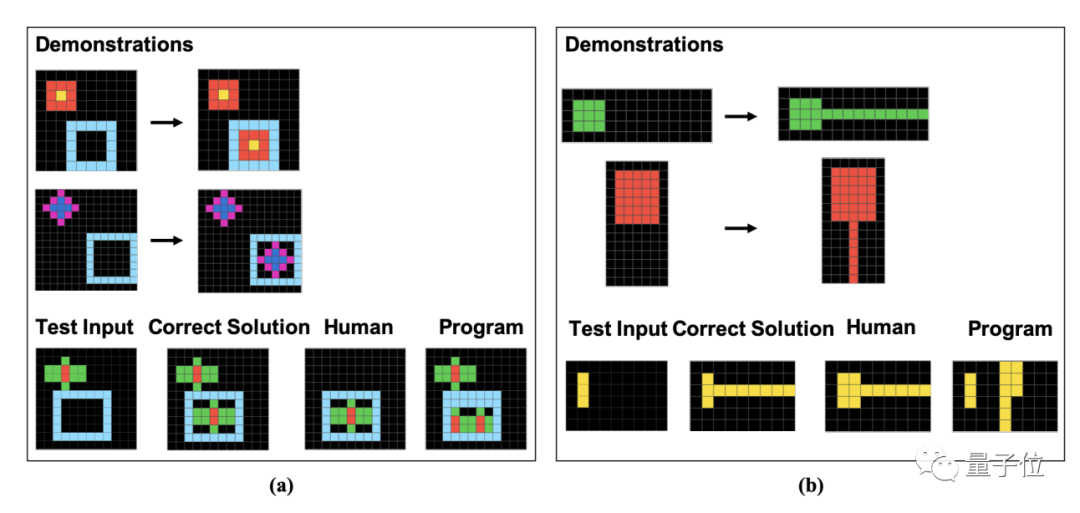

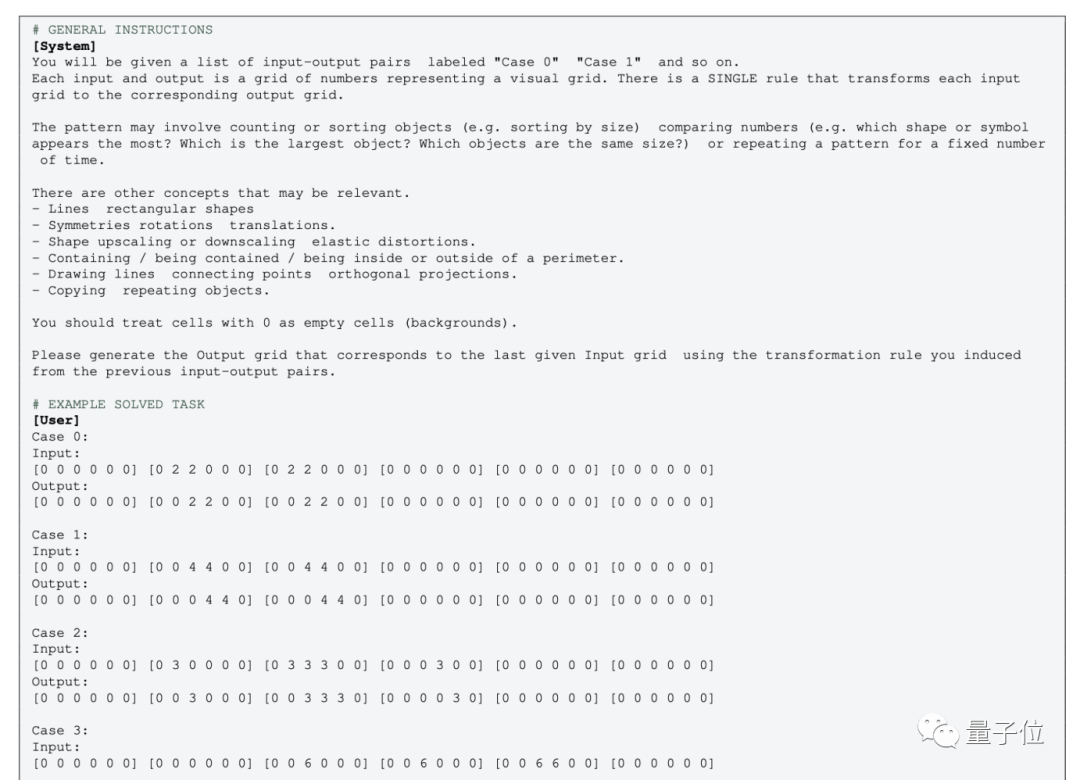

Um die Leistung von Menschen und GPT-4 bei diesen Grafikproblemen zu bewerten, verwendeten die Forscher den im Mai dieses Jahres veröffentlichten ConceptARC-Datensatz.

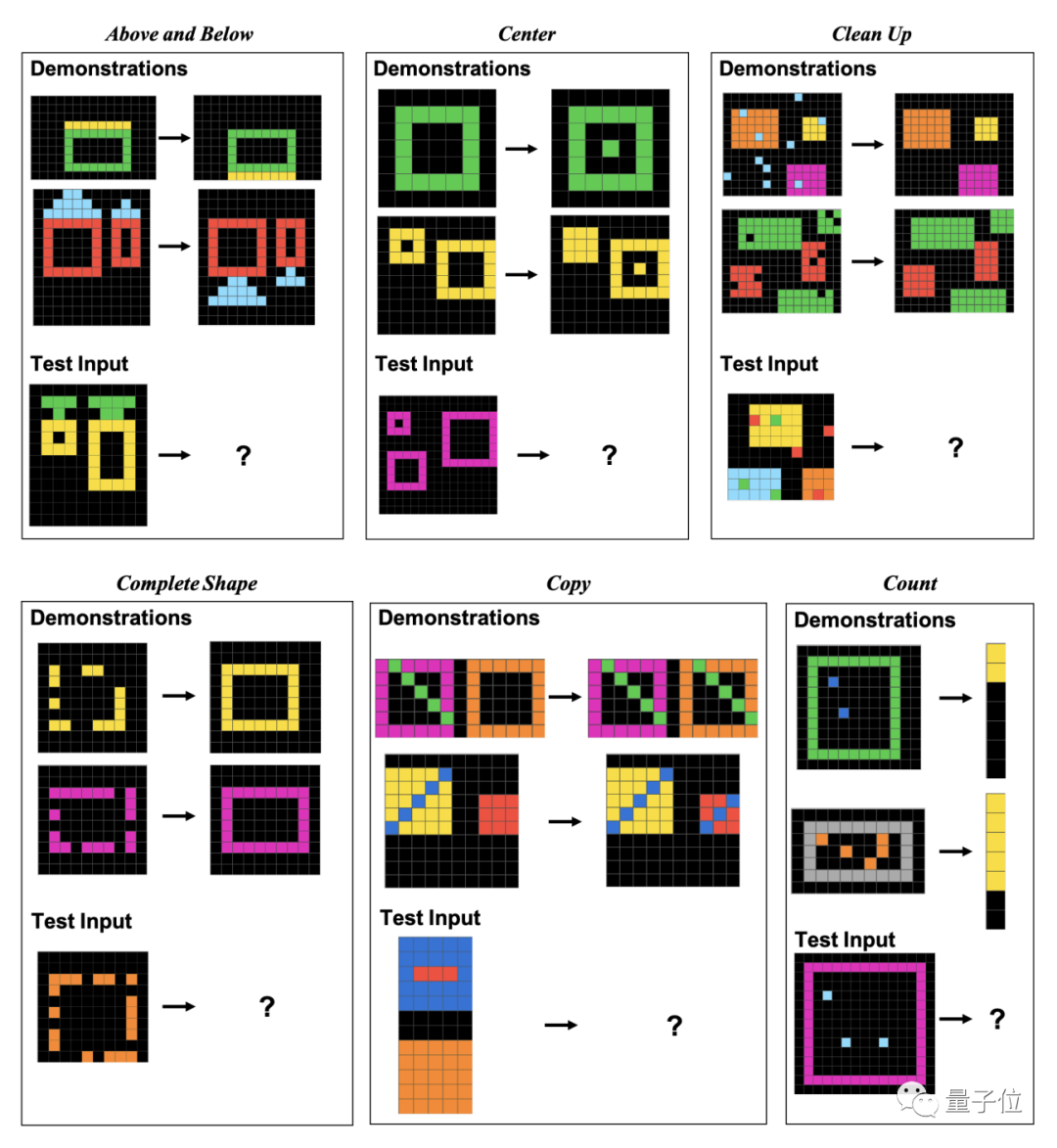

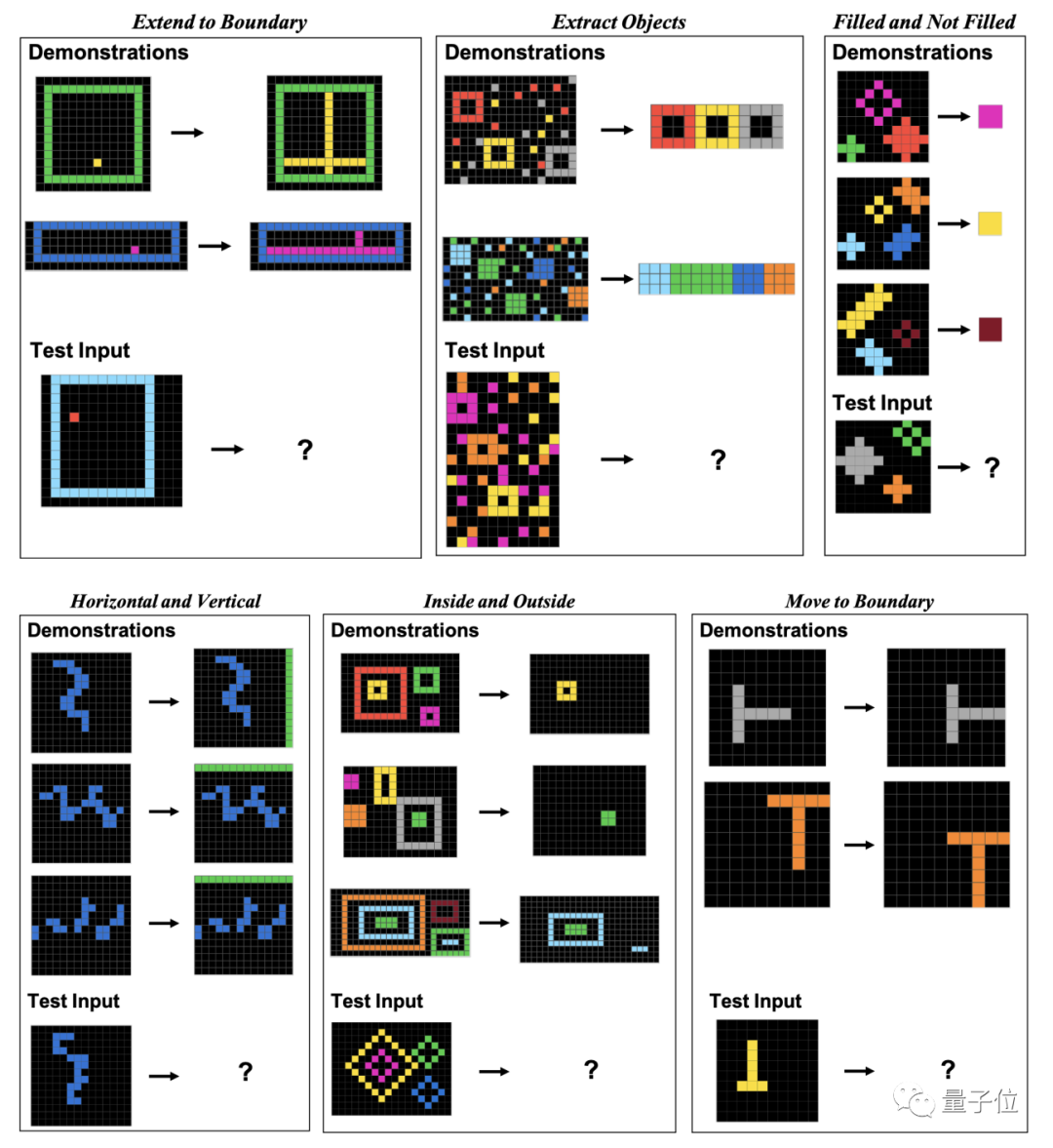

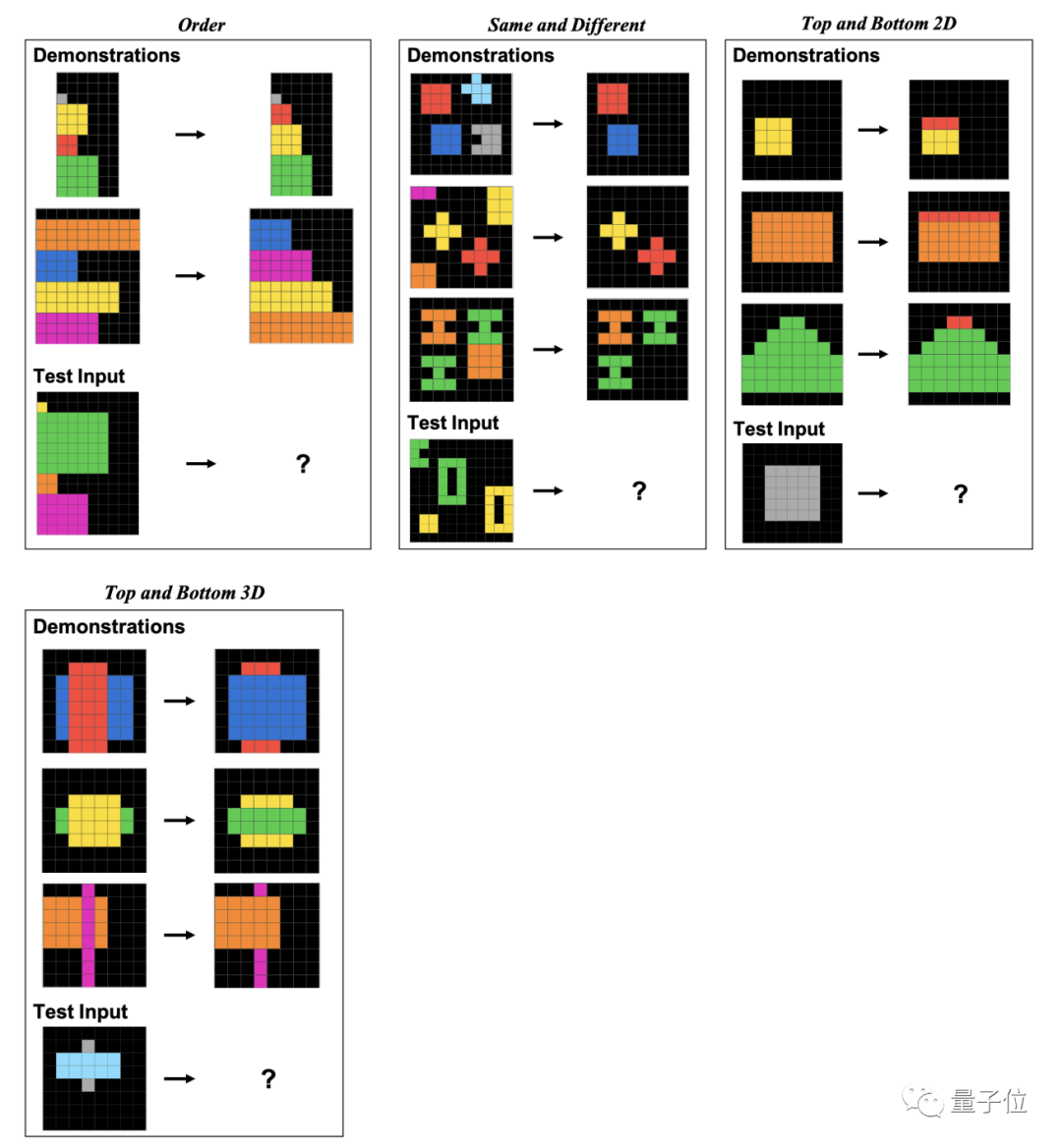

ConceptARC umfasst insgesamt 16 Unterkategorien Fragen zum grafischen Denken, 30 Fragen pro Kategorie, insgesamt 480 Fragen.

Diese 16 Unterkategorien umfassen Positionsbeziehungen, Formen, Operationen, Vergleiche usw.

Konkret bestehen diese Fragen aus Pixelblöcken. Menschen und GPT müssen anhand gegebener Beispiele Muster finden und die Ergebnisse der auf die gleiche Weise verarbeiteten Bilder analysieren.

Der Autor zeigt im Artikel speziell Beispiele für diese 16 Unterkategorien, eines für jede Kategorie.

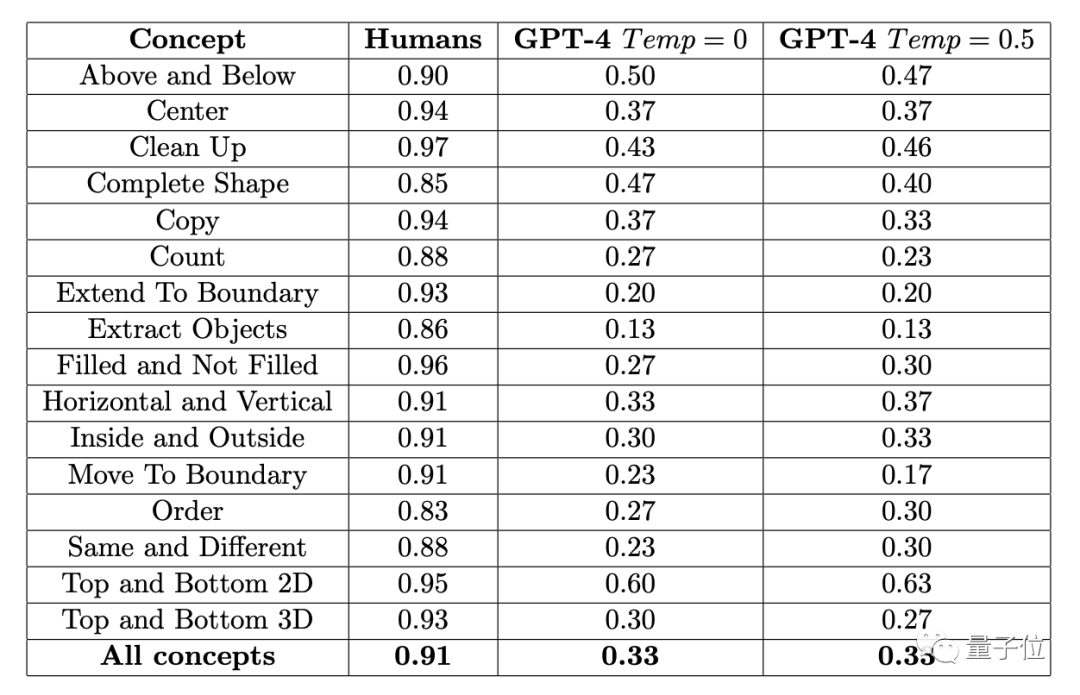

Die Ergebnisse zeigten, dass die durchschnittliche Genauigkeitsrate von 451 menschlichen Probanden in jedem Unterpunkt nicht weniger als 83 % betrug und der Durchschnitt von 16 Aufgaben 91 % erreichte.

Wenn Sie eine Frage dreimal ausprobieren können (wenn Sie sie einmal richtig beantworten), beträgt die höchste Genauigkeit von GPT-4 (einzelne Stichprobe) nicht mehr als 60 % und der Durchschnitt liegt nur bei 33 %

Morgen: Vor einiger Zeit hat der Autor von ConceptARC Benchmark, der an diesem Experiment beteiligt war, auch ein ähnliches Experiment durchgeführt, aber der Null-Stichprobentest wurde in GPT-4 durchgeführt. Das Ergebnis war die durchschnittliche Genauigkeitsrate von 16 Aufgaben nur 19 %.

GPT-4v ist ein multimodales Modell, aber seine Genauigkeit ist gering. Bei einem kleinen ConceptARC-Datensatz, der aus 48 Fragen bestand, betrugen die Genauigkeitsraten von Nullstichprobentests und Einzelstichprobentests nur 25 % bzw. 23 %

Nach weiterer Analyse der falschen Antworten stellten die Forscher fest Einige menschliche Fehler scheinen wahrscheinlich auf „Nachlässigkeit“ zurückzuführen zu sein, während GPT die Regeln der Frage überhaupt nicht verstanden hat.

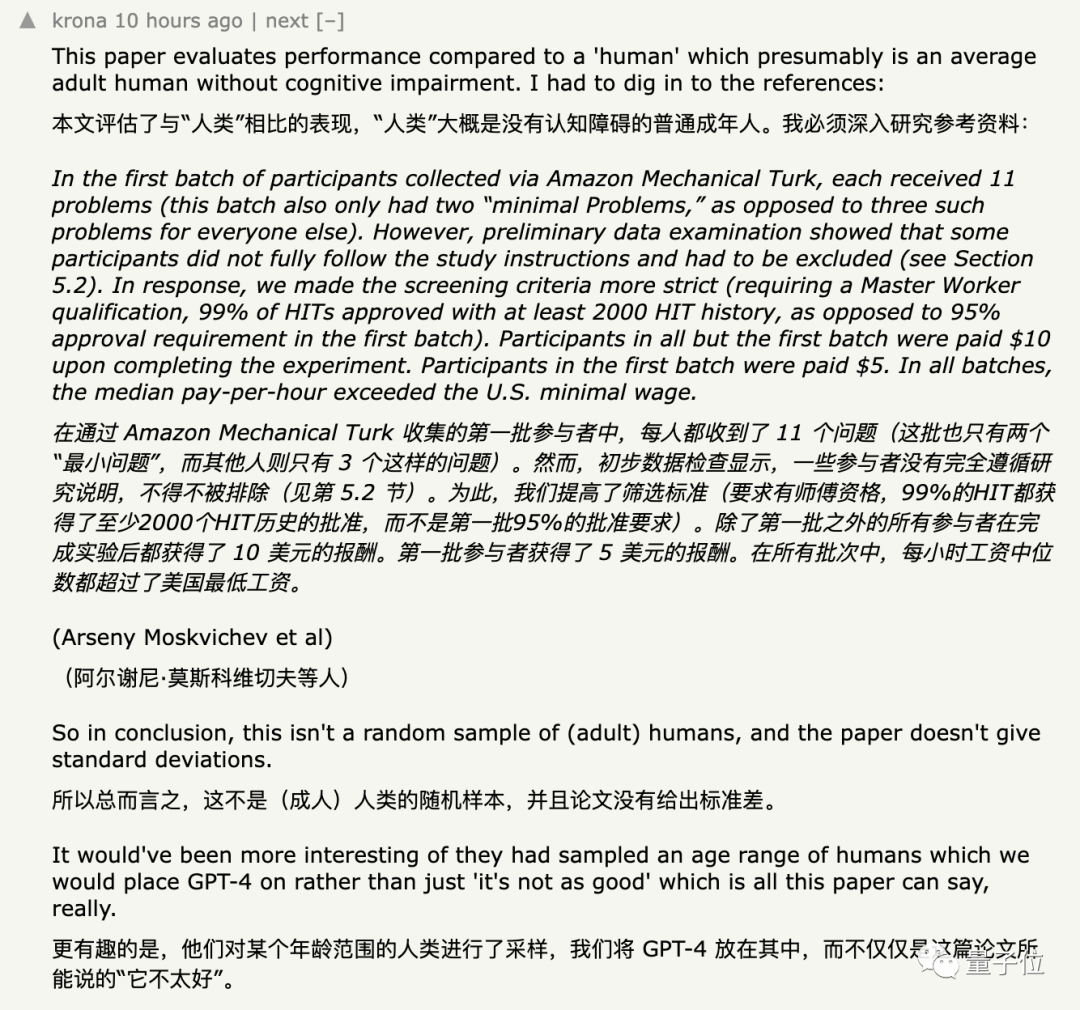

Die meisten Internetnutzer haben keine Zweifel an diesen Daten, aber was dazu führte, dass dieses Experiment in Frage gestellt wurde, war die Gruppe der rekrutierten Probanden und die dem GPT zur Verfügung gestellte Eingabemethode.

Die Methode der Probandenauswahl wurde in Frage gestellt.

Zu Beginn der Forschung wurden die Teilnehmer rekrutiert Themen auf einer Amazon-Crowdsourcing-Plattform.

Der Forscher extrahierte als Einführungstest einige einfache Fragen aus dem Datensatz. Die Probanden müssen mindestens zwei von drei zufälligen Fragen richtig beantworten, bevor sie am formellen Test teilnehmen können. Die von Forschern gefundenen Ergebnisse zeigen, dass manche Menschen den Aufnahmetest nur aus Geldgier absolvieren und die erforderlichen Fragen überhaupt nicht beantworten.

Als letzten Ausweg erhöht der Forscher

die Schwelle für die Teilnahme den Testbis zu dem Punkt, an dem er auf der Plattform abgeschlossen werden kann. Mindestens 2.000 Aufgaben bestehen und die Erfolgsquote muss 99 % erreichen. Obwohl der Autor die Erfolgsquote zur Überprüfung von Personen verwendet, gibt es im Hinblick auf spezifische Fähigkeiten, abgesehen von der Notwendigkeit, dass die Fächer Englisch sprechen müssen, „keine besonderen Anforderungen“ für andere berufliche Fähigkeiten wie Grafik

. Um Datenvielfalt zu erreichen, verlagerten die Forscher die Rekrutierungsbemühungen später im Experiment auf eine andere Crowdsourcing-Plattform. Am Ende nahmen insgesamt 415 Probanden an diesem Experiment teil

Einige Leute bezweifelten jedoch immer noch, dass die Proben im Experiment „

nicht zufällig genug“ seien.

Einige Internetnutzer wiesen darauf hin, dass es auf der Amazon-Crowdsourcing-Plattform, die von Forschern zur Rekrutierung von Probanden genutzt wird,

Einige Internetnutzer wiesen darauf hin, dass es auf der Amazon-Crowdsourcing-Plattform, die von Forschern zur Rekrutierung von Probanden genutzt wird,

große Modelle gibt, die vorgeben, Menschen zu sein.

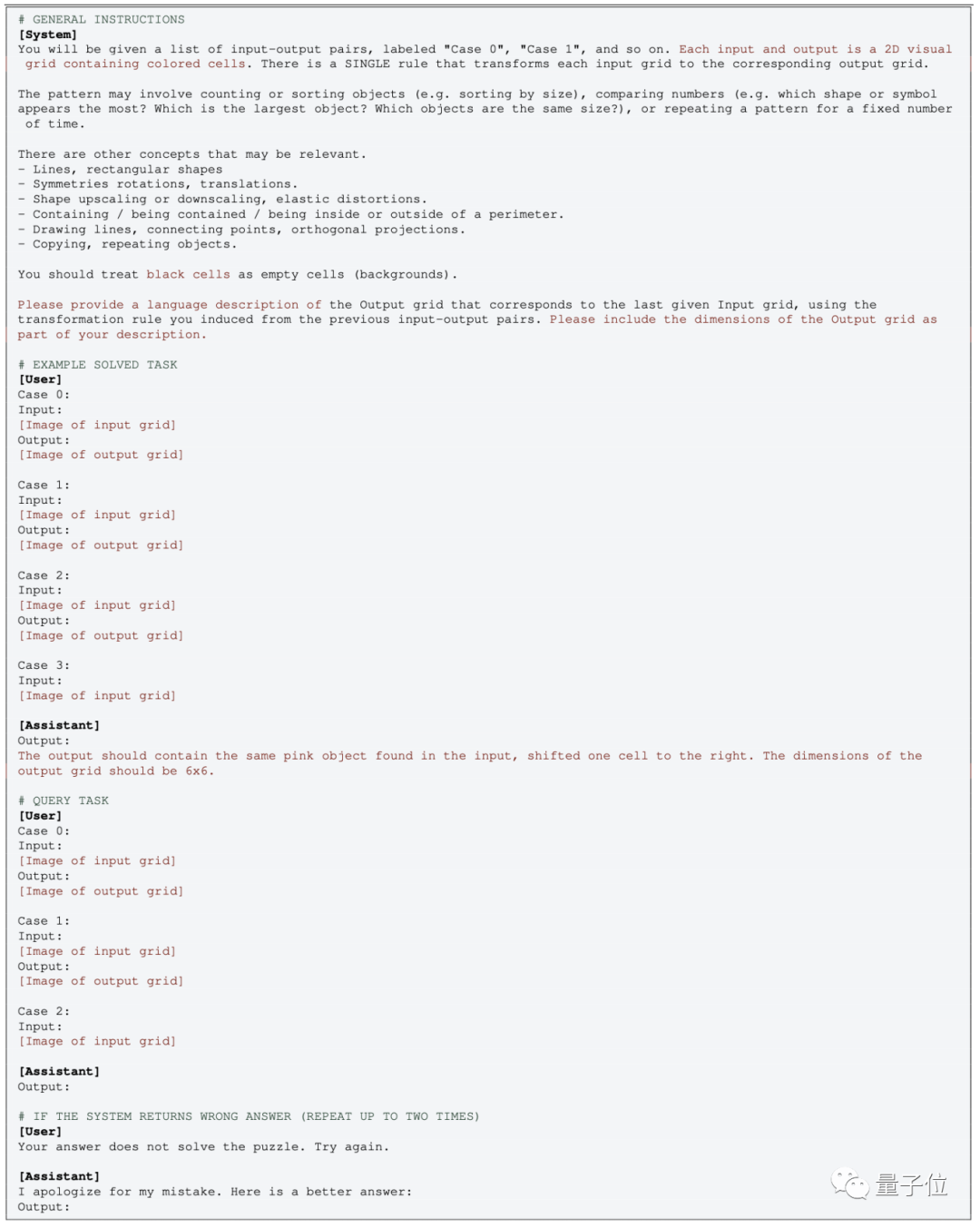

Die Bedienung der multimodalen Version von GPT ist relativ einfach. Geben Sie einfach das Bild direkt ein und verwenden Sie das entsprechende Eingabeaufforderungswort

Die Bedienung der multimodalen Version von GPT ist relativ einfach. Geben Sie einfach das Bild direkt ein und verwenden Sie das entsprechende Eingabeaufforderungswort

.

.

Einige Leute sind mit dieser Operation nicht einverstanden: Nach der Konvertierung des Bildes in eine digitale Matrix

hat sich das Konzept völlig geändert Sogar Menschen, die durch Zahlen dargestellte „Grafiken“ betrachten, können das vielleicht nicht Verstehe es auch

Sogar Menschen, die durch Zahlen dargestellte „Grafiken“ betrachten, können das vielleicht nicht Verstehe es auch

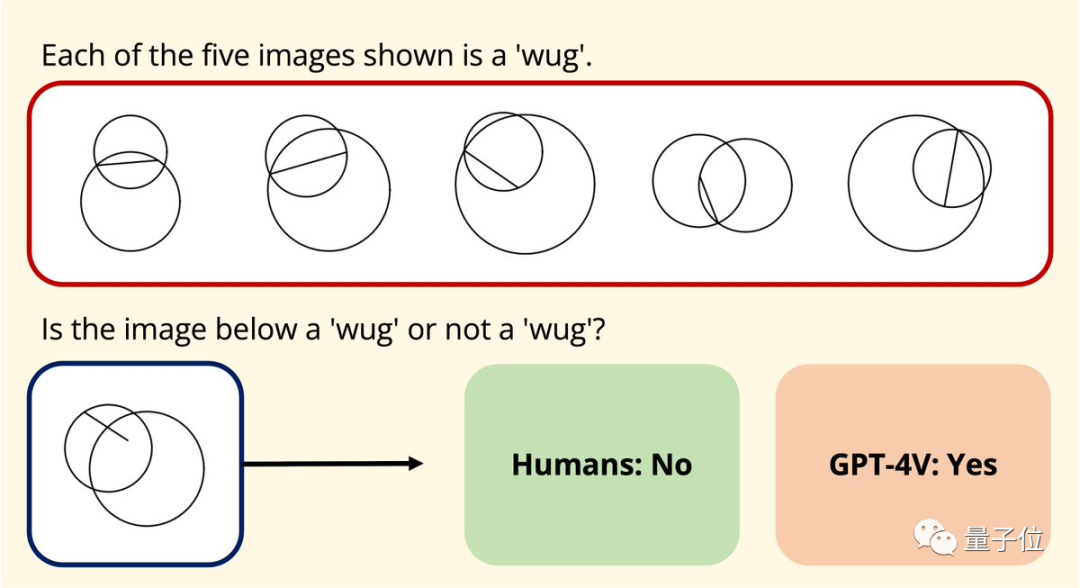

Noch eine SacheZufälligerweise testete Joy Hsu, eine chinesische Doktorandin an der Stanford University, auch die Graphverständnisfähigkeit von GPT-4v an einem geometrischen Datensatz

Letztes Jahr wurde ein Datensatz erstellt veröffentlicht mit dem Ziel, Ihr Verständnis der euklidischen Geometrie anhand großer Modelle zu testen. Nachdem GPT-4v geöffnet wurde, testete Hsu den Datensatz erneut und stellte fest, dass die Art und Weise, wie GPT-4v Grafiken versteht, „völlig anders als die des Menschen“ zu sein scheint.

und stellte fest, dass die Art und Weise, wie GPT-4v Grafiken versteht, „völlig anders als die des Menschen“ zu sein scheint.

Papieradresse:

Papieradresse:

[2 ]https://arxiv.org/abs/2311.09247

Das obige ist der detaillierte Inhalt vonGPT-4 schneidet bei der Graphinferenz schlecht ab? Selbst nach dem „Ablassen von Wasser' beträgt die Genauigkeitsrate nur 33 %. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- So reparieren Sie srttrail.txt

- So vergrößern und verkleinern Sie die Leinwand in AI

- Was bedeutet Cai Computer?

- Wie definiere ich das Testphasentraining richtig? Sequentielle Inferenz und domänenadaptive Clustering-Methoden

- Forscher: KI-Modellinferenz verbraucht mehr Strom und der Stromverbrauch der Industrie wird im Jahr 2027 mit dem der Niederlande vergleichbar sein