Heim >Technologie-Peripheriegeräte >KI >Liegt die Zukunft der Grafikkarten nur in der KI? Eine eingehende Analyse der „gewalttätigen Kommentare' von NV-Führungskräften

Liegt die Zukunft der Grafikkarten nur in der KI? Eine eingehende Analyse der „gewalttätigen Kommentare' von NV-Führungskräften

- 王林nach vorne

- 2023-09-23 11:33:051102Durchsuche

In den letzten Tagen haben relevante Personen von NVIDIA erklärt, dass „Spiele mit nativer Auflösung tot sind“, was erneut Besorgnis in der Spielergemeinschaft hervorgerufen hat. Die Ursache für diesen Vorfall ergab sich aus einer Diskussionsrunde, in der mehrere Führungskräfte von NVIDIA mit Jakub Knapik vom Spielehersteller CD Projekt Red über die Auswirkungen der Deep-Learning-Anti-Aliasing-Technologie (auch bekannt als DLSS) auf die Verbesserung der Bildrate von Spielen diskutierten Rendering-Bedeutung.

Für Spielehersteller wie CD Projekt Red, die den ultimativen Bildeffekt anstreben, aber bei der Optimierung nur eine mittelmäßige Leistung erbringen, begrüßen sie sicherlich die weit verbreitete Anwendung von Deep Learning und KI-Superscore-Algorithmen auf Grafikkarten

Wie Jakub Knapik sagte, fügt DLSS als Vertreter der Technologie zur Verbesserung der Bildrate „modernen GPUs auf subtile Weise mehr Leistungsspielraum hinzu“, was es Spielen wie „Cyberpunk 2077“ ermöglicht, die neueste Raytracing-Simulationstechnologie sicher zu übernehmen und die Spielgrafiken zu verbessern. realistischer und detaillierter“

Als jedoch Bryan Catanzaro, Vice President of Deep Learning Research bei NVIDIA, behauptete, dass „native Auflösung nicht mehr die beste Lösung für maximale Grafiktreue in Spielen ist, verlässt sich die Spielegrafikbranche stärker auf KI-Bildrekonstruktion und KI-basierte Grafiken.“ die Zukunft. Es macht den Menschen ein wenig Unbehagen, wenn sich die Grafik-Rendering-Richtung der KI weiterentwickelt“

Der NVIDIA-Manager erklärte weiter, dass, um die Sache noch schlimmer zu machen, die Verbesserung der Grafiktreue durch rohe Gewalt keine ideale Lösung mehr sei. Er sagte, dass wir nur durch die Einführung intelligenterer Technologie das Problem der geringen Leistungsverbesserung der heutigen Grafikhardware vermeiden können

Auf den ersten Blick scheinen diese Aussagen Sinn zu machen, denn jeder weiß, dass DLSS, insbesondere die Version nach DLSS3, extrem „leistungsstark“ ist, solange es eingeschaltet ist, kann sich die Bildrate des Spiels direkt um ein Vielfaches erhöhen. Aber die Frage ist, ob Catanzaro als Techniker, der sich auf Deep-Learning-Forschung konzentriert, Grafikkarten und die Entwicklung der GPU-Rasterleistung wirklich „versteht“?

Nach den tatsächlichen Daten sollte zunächst einmal das Display diese Verantwortung nicht tragen

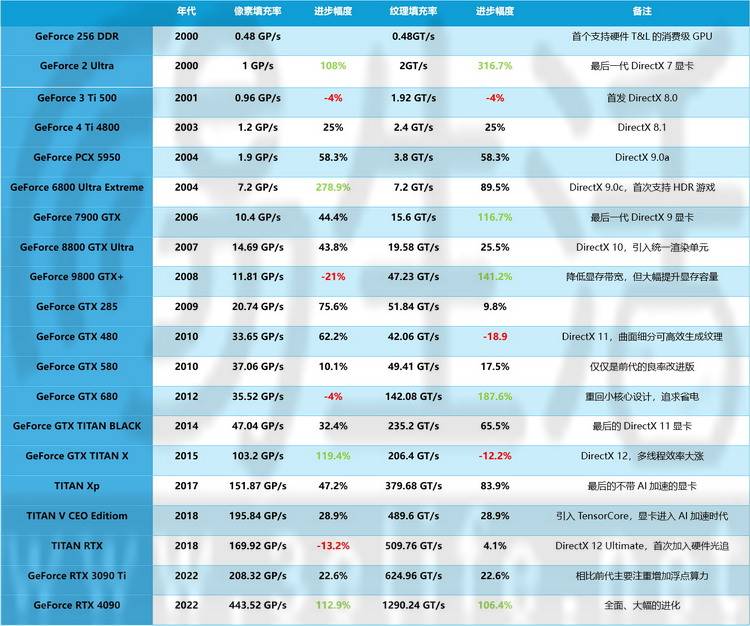

Um das Entwicklungsmuster der traditionellen Rasterleistung der GPU seit ihrer Einführung zu untersuchen, haben wir bei Sanyi Life öffentliche Daten gesammelt und die Vergleichstabelle zur Pixel- und Texturgenerierungsleistung von NVIDIA-Grafikkarten für Endverbraucher von 2000 bis heute zusammengefasst. In der Tabelle weisen rote Schriftarten auf einen Leistungsabfall und grüne Schriftarten auf individuelle Leistungssteigerungen von mehr als 100 % für eine bestimmte Generation hin

Aus dieser Tabelle geht deutlich hervor, dass es bei Consumer-GPUs mehr als einmal in der Geschichte zu einer Verschlechterung der Rasterleistung kam. Zweitens, wenn man den allgemeinen Entwicklungstrend betrachtet, wurde die Rasterleistung der neuesten Generation von Flaggschiff-GPUs im Vergleich zu den Produkten von vor 22 Jahren tausendfach verbessert.

Einige Freunde mögen sagen, dass sich die Rasterleistung der GPU zwar verbessert hat, die heutigen Spieltexturen jedoch komplexer sind als zuvor und die heutigen Monitore häufig über hohe Bildwiederholraten von 4K+ verfügen und Benutzer höhere Leistungsanforderungen haben, sodass dies nicht ausreicht. Ist das normal? ?

Eigentlich ist das überhaupt nicht normal. Denn bereits um das Jahr 2000 konnten die damaligen Spitzenmodelle der „großen“ CRT-Monitore eine Auflösung von 2304*1440 erreichen, was nicht viel niedriger war als die aktuellen Mainstream-„2K“-Monitore, oder sogar nur diese etwa halb so viele Pixel wie 4K.

Bereits im Jahr 2003 konnten PC-Enthusiasten den von ViewSonic hergestellten 4K-LCD-Monitor T221 mit einer Auflösung von bis zu 3840*2400 kaufen, was höher ist als bei den meisten 4K-Monitoren 20 Jahre später

Heutzutage ist die Verbesserung der Bildschirmauflösung nicht so groß, wie sich jeder vorstellt. Daher sollten wir die Vorstellung ausschließen, dass Fortschritte in der Monitorauflösung zu einer unzureichenden Grafikkartenleistung führen

Das eigentliche Problem könnte in der Grafik-API liegen

Was ist also der Grund, warum manche Leute das Gefühl haben, dass die Rasterleistung moderner GPUs „nicht ausreichend“ ist? Kehren wir zur vorherigen Tabelle zurück und betrachten die darin enthaltenen Daten genauer.

Einige Freunde haben möglicherweise herausgefunden, dass fast jedes Mal, wenn sich die Rasterleistung (Pixel, Textur) neuer GPUs verschlechtert hat, dies „zufällig“ zum Zeitpunkt des DirectX-API-Upgrades auftrat. Genauer gesagt: Wenn sich die API ändert und PC-Spiele neue visuelle Effekte und Bildverarbeitungstechnologien einführen, kann es beim Hardware-Design der Grafikkarte zu Rückschlägen kommen.

Warum ist das so? Dies liegt zum einen daran, dass neue APIs häufig eine komplett neu gestaltete Architektur der GPU erfordern, was dazu führen kann, dass die Designs der Hersteller bei einem Upgrade nicht ausgereift genug sind und die Rasterleistung sinkt. Aus der obigen Tabelle können Sie ersehen, dass im Allgemeinen nach einem Produkt, dessen Leistung aufgrund des Austauschs nachlässt, nachfolgende neue Produkte oft eine neue und wesentliche Verbesserung aufweisen, was indirekt beweist, dass das frühe Design noch so ausgereift ist.

Das Upgrade der Grafik-API hat den kurzfristigen Rückgang der Grafikkarten-Rasterleistung bis zu einem gewissen Grad überdeckt

Wenn PC-Spiele andererseits ein API-Upgrade einführen, bedeutet dies, dass Verbraucher die durch das neue Technologiesystem erzielten Spezialeffekte nur durch den Kauf einer neuen Grafikkarte genießen können. Wenn Sie noch das alte Modell verwenden, wird zumindest die Bildwirkung beeinträchtigt und im schlimmsten Fall können Sie keine Spiele ausführen, die der neuen API entsprechen.

Da die neuen Bildeffekte (wie HDR, Tessellation und Raytracing), die der neuen API entsprechen, „exklusiv“ für die neue Hardware sind, ist es in diesem Zusammenhang tatsächlich unmöglich, die alten und neuen GPUs über Generationen hinweg wirklich miteinander in Einklang zu bringen. Vergleichen Sie die Leistung in Spielen (da die alte Karte zu diesem Zeitpunkt überhaupt keine neuen Spiele ausführen kann oder selbst wenn sie ausgeführt werden kann, keine neuen Grafikeffekte öffnen kann). Selbst wenn die neue GPU-Generation einen Rückgang der Rasterleistung aufweist, spüren Verbraucher dies oft nicht.

DX12.2, das sich auf Raytracing konzentriert, gibt es tatsächlich schon seit vier Jahren

Aber das Problem ist, dass die heutige Windows-Grafik-API seit mindestens vier Jahren, vielleicht sogar acht Jahren, nicht wesentlich aktualisiert wurde. Dies bedeutet, dass sich der Austausch der GPU nicht auf die Qualität der Bildspezialeffekte auswirken kann, sondern nur auf die „hart erarbeitete“ Auflösung, Bildrate und Anti-Aliasing-Stufe, also die sogenannte hart erarbeitete Rasterleistung.

Ist diese Aussage von NVIDIA nur eine Rauchbombe oder bedeutet sie etwas anderes?

Was noch interessanter ist, ist, dass aus der obigen Tabelle klar hervorgeht, dass NVIDIA nicht so „erfolgreich“ zu sein scheint, wie sie behaupten. Sogar die RTX 4090 hat sich zum Flaggschiffprodukt der Generation mit der größten Verbesserung der Rasterleistung und der größten Aufrichtigkeit seit vielen Jahren entwickelt

Dadurch entsteht eine seltsame Situation. Eigentlich behauptete NVIDIA nebenbei, dass „die Entwicklung der nächsten Produktgeneration immer schwieriger wird und wir unsere Denkweise ändern müssen“, doch tatsächlich brachte das Unternehmen neue Produkte auf den Markt, die völlig dem traditionellen Denken entsprachen und große Fortschritte machten

Um dies zu verstehen und dann im Nachhinein die Absichten ihrer Bemerkungen zu analysieren, gibt es eigentlich nur die folgenden Möglichkeiten.

Die erste Möglichkeit besteht darin, dass der „Vizepräsident für angewandte Deep-Learning-Forschung“ das Grafikdesign der GPU nicht wirklich versteht. Er glaubt fälschlicherweise, dass die technische Entwicklung seiner eigenen Produkte auf Schwierigkeiten stoßen wird, aber tatsächlich ist dies nicht der Fall.

Die zweite Möglichkeit besteht darin, dass er, weil er diese Position innehat, diese „Szenenworte“ sagen und die Bedeutung von KI und DLSS betonen muss, obwohl die Leistung von RTX 4090 in den meisten Spielen bereits sehr leistungsstark ist und dies nicht erforderlich ist Benutze KI-Anti-Aliasing, das muss ich auch sagen

Natürlich können wir nicht ausschließen, dass es sich bei den obigen Ausführungen tatsächlich nur um eine „Rauchbombe“ handelt und NVIDIA bewusst falsche Informationen verbreitet, um die Konkurrenz zu verwirren

Noch weiter: Wenn die enorme Leistungsverbesserung der RTX 4090-Generation als NVIDIAs „vollständiges Verständnis der Eigenschaften von DX12.2“ verstanden wird, dann sind seine ultrahohe Rasterleistung und die „Raster ist nutzlos“-Theorie der relevanten Leute von NVIDIA seine Bemerkungen, die auch darauf hindeuten, dass sich eine PC-Grafik-API der nächsten Generation, die stark auf KI-Rechenleistung angewiesen ist, tatsächlich in der Entwicklung befindet und möglicherweise in Kürze veröffentlicht (aktualisiert) wird?

[Einige Bilder in diesem Artikel stammen aus dem Internet]

Das obige ist der detaillierte Inhalt vonLiegt die Zukunft der Grafikkarten nur in der KI? Eine eingehende Analyse der „gewalttätigen Kommentare' von NV-Führungskräften. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!