Heim >Technologie-Peripheriegeräte >KI >Versteckter Roboter im iPhone: basierend auf der GPT-2-Architektur, mit Emoji-Tokenizer, entwickelt von MIT-Alumni

Versteckter Roboter im iPhone: basierend auf der GPT-2-Architektur, mit Emoji-Tokenizer, entwickelt von MIT-Alumni

- PHPznach vorne

- 2023-09-20 13:05:09968Durchsuche

Enthusiasten haben das „Geheimnis“ von Apples Transformer gelüftet Neue Versionen von iOS und macOS verfügen über integrierte Transformer-Sprachmodelle, um Eingabemethoden mit Textvorhersagefunktionen bereitzustellen.

Obwohl Apple-Beamte keine weiteren Informationen preisgegeben haben, können Technologiebegeisterte es kaum erwarten Ein Typ namens Jack Cook hat erfolgreich ein neues Kapitel der Betaversion von macOS Sonoma aufgeschlagen und unerwartet viele neue Informationen entdeckt

Ein Typ namens Jack Cook hat erfolgreich ein neues Kapitel der Betaversion von macOS Sonoma aufgeschlagen und unerwartet viele neue Informationen entdeckt

GPT-2

basiert.- In Bezug auf den Tokenizer ist Emoticon unter ihnen sehr prominent.

- Für weitere Details werfen wir einen Blick darauf. Basierend auf der GPT-2-Architektur

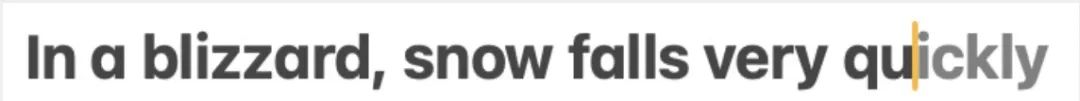

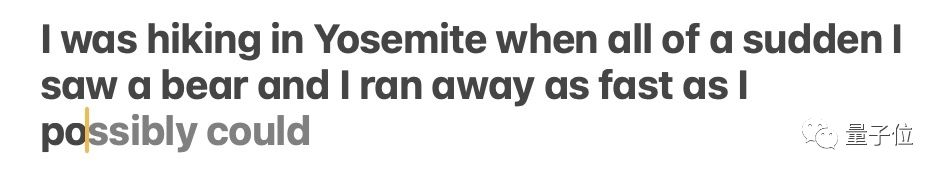

Jack Cook hat es speziell getestet und festgestellt, dass diese Funktion hauptsächlich die Vorhersage einzelner Wörter implementiert.

Der Inhalt, der neu geschrieben werden muss, ist: △Quelle: Jack Cooks Blog-Beitrag

Das Modell sagt manchmal mehrere kommende Wörter voraus, dies ist jedoch auf Situationen beschränkt, in denen die Semantik des Satzes sehr offensichtlich ist und eher ähnlich ist Funktion zur automatischen Vervollständigung von Gmail.

Der Inhalt, der neu geschrieben werden muss, ist: △Quelle: Jack Cooks Blogbeitrag

Wo ist dieses Modell installiert? Nach eingehender Recherche stellte Bruder Cook fest:

Ich habe das prädiktive Textmodell in /System/Library/LinguisticData/RequiredAssets_en.bundle/AssetData/en.lm/unilm.bundle gefunden. Der Grund ist:

Viele Dateien in unilm.bundle existieren nicht in macOS Ventura (13.5), sondern erscheinen nur in der neuen Version von macOS Sonoma Beta (14.0).

Es gibt eine sp.dat-Datei in unilm.bundle, die sowohl in Ventura als auch in Sonoma Beta zu finden ist, aber die Sonoma Beta-Version wurde mit einer Reihe von Tokens aktualisiert, die offensichtlich wie ein Tokenizer aussehen.

- Die Anzahl der Token in sp.dat kann mit den beiden Dateien in unilm.bundle übereinstimmen – unilm_joint_cpu.espresso.shape und unilm_joint_ane.espresso.shape. Diese beiden Dateien beschreiben die Form jeder Schicht im Espresso/CoreML-Modell.

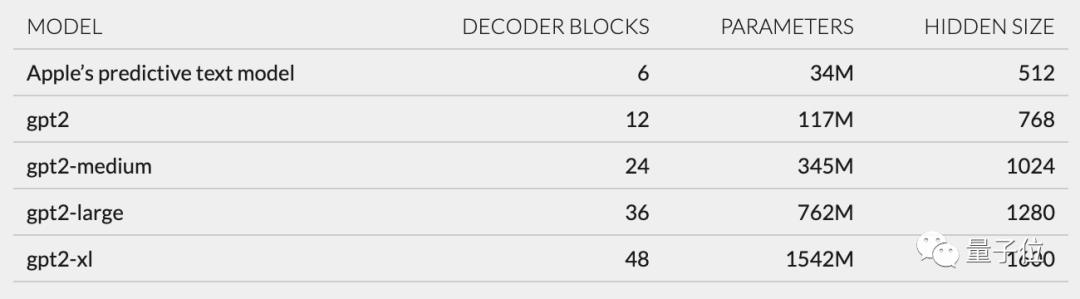

- Weitere Spekulationen: Gemäß der in unilm_joint_cpu beschriebenen Netzwerkstruktur glaube ich, dass das Apple-Modell auf der GPT-2-Architektur basiert.

- Zu den Hauptkomponenten gehören jeweils Token-Einbettung, Positionscodierung, Decoderblock und Ausgabeschicht In jedem Decoderblock werden Wörter angezeigt, die „gpt2_transformer_layer_3d“ ähneln beträgt etwa 34 Millionen Parameter, die Größe der verborgenen Ebene beträgt 512. Mit anderen Worten, es ist kleiner als die kleinste Version von GPT-2

.

Er hat einen Satz von 15.000 Token in unilm.bundle/sp.dat gefunden. Es ist erwähnenswert, dass er 100 Emoji enthält.

Cook enthüllt Cook

Obwohl dieser Cook nicht dieser Cook ist, erregte mein Blog-Beitrag gleich nach seiner Veröffentlichung dennoch viel Aufmerksamkeit

Basierend auf seinen Erkenntnissen diskutierten die Internetnutzer enthusiastisch über die Benutzererfahrung und Innovationen von Apple Technologieanwendungen.

Zurück zu Jack Cook selbst. Er hat einen Bachelor- und einen Master-Abschluss in Informatik und studiert derzeit einen Master-Abschluss in Internet-Sozialwissenschaften an der Universität Oxford.

Zuvor absolvierte er ein Praktikum bei NVIDIA und konzentrierte sich auf die Erforschung von Sprachmodellen wie BERT. Er ist außerdem leitender Forschungs- und Entwicklungsingenieur für die Verarbeitung natürlicher Sprache bei der New York Times

Das obige ist der detaillierte Inhalt vonVersteckter Roboter im iPhone: basierend auf der GPT-2-Architektur, mit Emoji-Tokenizer, entwickelt von MIT-Alumni. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!