Heim >Technologie-Peripheriegeräte >KI >Online im Angebot! Das erste Heart of Machine AI-Technologieforum ist erfolgreich zu Ende gegangen. Diese großen technischen Informationen sind immer wieder sehenswert.

Online im Angebot! Das erste Heart of Machine AI-Technologieforum ist erfolgreich zu Ende gegangen. Diese großen technischen Informationen sind immer wieder sehenswert.

- PHPznach vorne

- 2023-09-14 09:49:02686Durchsuche

Künstliche Intelligenz ist in die Ära großer Modelle eingetreten, die das Implementierungsmodell von KI in verschiedenen Branchen völlig verändern und auch neue Anforderungen an KI-Fähigkeiten für F&E- und technische Praktiker in verschiedenen Branchen stellen wird.

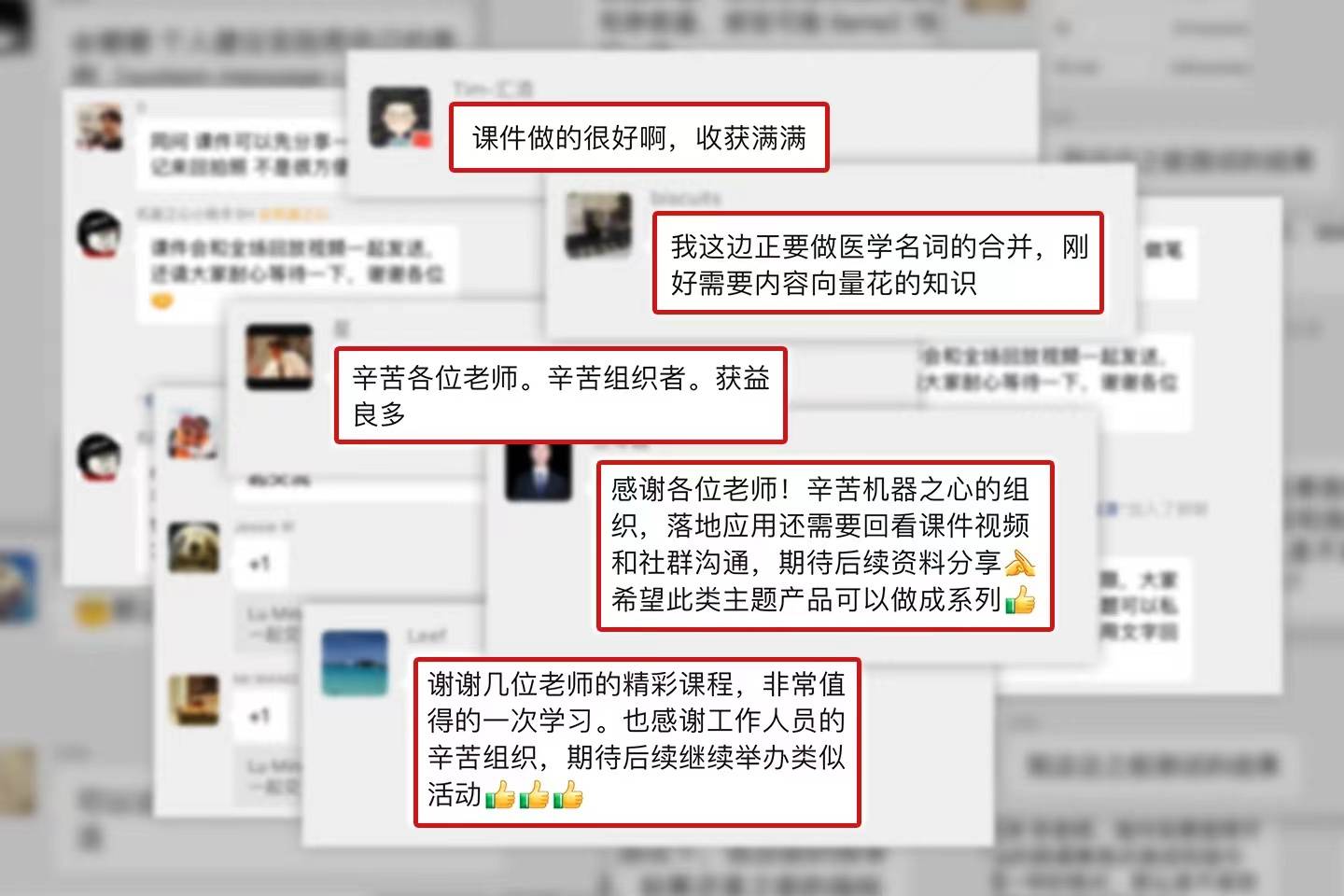

Um zur Verbesserung der Großmodelltechnologie beizutragen, haben wir eine Veranstaltung mit dem Titel „Llama 2 Large Model Algorithm and Application Practice“ abgehalten. Dieses KI-Technologieforum wurde erfolgreich abgeschlossen. Am Tag der Veranstaltung war die Multifunktionshalle im zweiten Stock des Turms B des Wangjing Pohang Centers in Peking mit 200 Teilnehmern aus mehr als zehn Städten im ganzen Land gefüllt. Unter der Anleitung von vier Experten für Großmodelltechnologie haben wir die zugrunde liegende Großmodelltechnologie von Llama 2 systematisch untersucht, persönlich unser eigenes exklusives Großmodell gebaut und gemeinsam die Aufrüstung der Großmodelltechnologie effizient abgeschlossen Die Veranstaltung Die Veranstaltung wurde von den Teilnehmern weithin gelobt

Der Inhalt war von hoher Qualität und übertraf die Erwartungen, die Erklärungen waren wunderbar und ausführlich, der Frage-und-Antwort-Austausch vor Ort war aufschlussreich und der Service war umfassend und aufmerksam ... Die Teilnehmer gaben Die Veranstaltung erhielt großes Lob und äußerte den Wunsch nach mehr Fülle und tiefergehenden Inhaltserwartungen an die technischen Aktivitäten. Darüber hinaus konnten viele Freunde, die an der Veranstaltung interessiert waren, aufgrund der Entfernung zur Stadt, des Reiseplans und aus anderen Gründen leider nicht zum Veranstaltungsort kommen. Um auf die Lern- und Übungsbedürfnisse aller einzugehen, ist die offizielle Wissensstation dieser Website (https://vtizr.xet.tech/s/1GOWfs) jetzt mit dem Live-Video dieses Forums online. Der vollständige Satz an Videos kostet 699 Yuan (nach erfolgreichem Kauf fügen Sie bitte die Assistenten-ID dieser Website hinzu: 13661489516, um das unterstützende Lernmaterialpaket vor und nach der Konferenz zu erhalten). Kaufen Sie jetzt den Kurs und beginnen Sie Ihre Reise zur Verbesserung der Großmodelltechnik!

Darüber hinaus konnten viele Freunde, die an der Veranstaltung interessiert waren, aufgrund der Entfernung zur Stadt, des Reiseplans und aus anderen Gründen leider nicht zum Veranstaltungsort kommen. Um auf die Lern- und Übungsbedürfnisse aller einzugehen, ist die offizielle Wissensstation dieser Website (https://vtizr.xet.tech/s/1GOWfs) jetzt mit dem Live-Video dieses Forums online. Der vollständige Satz an Videos kostet 699 Yuan (nach erfolgreichem Kauf fügen Sie bitte die Assistenten-ID dieser Website hinzu: 13661489516, um das unterstützende Lernmaterialpaket vor und nach der Konferenz zu erhalten). Kaufen Sie jetzt den Kurs und beginnen Sie Ihre Reise zur Verbesserung der Großmodelltechnik!

Liu Pengfei, außerordentlicher Professor am Qingyuan Research Institute der Shanghai Jiao Tong University und Leiter der Generative Artificial Intelligence Research Group (GAIR)

„Trainieren Sie das Modell Es ist gründlich genug und kann in einem relativ kleinen Modell eine sehr gute Leistung erzielen.“ Der erste Redner, Liu Pengfei, konzentriert sich auf Forschungsrichtungen wie Vortraining, Generierung und Bewertung natürlicher Sprache.

„Trainieren Sie das Modell Es ist gründlich genug und kann in einem relativ kleinen Modell eine sehr gute Leistung erzielen.“ Der erste Redner, Liu Pengfei, konzentriert sich auf Forschungsrichtungen wie Vortraining, Generierung und Bewertung natürlicher Sprache.

Llama 2 ist das vorab trainierte Sprachmodell mit dem höchsten Grad an Originalität, den transparentesten technischen Trainingsdetails und dem besten Ruf auf dem Markt und hat einen extrem hohen Forschungswert. Diesmal nahm Liu Pengfei die „Technische Interpretation des großen Llama-2-Modells“ zum Thema. Ausgehend vom Hintergrund der Geburt von LLaMA, wichtigen Konzepten, der Llama-2-Trainingstechnologie und der Ausrichtungstechnologie interpretierte Liu Pengfei die Details des beteiligten Technologie-Stacks eingehend In Llama 2 und seiner Chat-Version teilte er auch seine praktischen Erfahrungen mit der Optimierung, einschließlich technischer Details wie Datenquellengewichtung und Upsampling, und erörterte die Schwierigkeiten beim Durchbruch der Entwicklung großer Modelle Account-Autor und Open-Source-Enthusiast Liu Huanyong

Umgeschrieben: Das Grundmodell stellt sehr hohe Anforderungen an Rechenleistung und Algorithmen. Daher wird es in mehr Industrieanwendungen gewählt, große Branchenmodelle auf Basis des Grundmodells zu erstellen und die Felder weiter zu unterteilen . Sprecher Liu Huanyong sagte: „Basierend auf dem großen Industriemodell enthält das Basismodell weniger vertikale Felddaten, was zu Halluzinationen neigt und der Effekt unbefriedigend ist, obwohl Llama nicht die beste Wahl für den chinesischen Markt ist.“ Als erstes Open-Source-Modell kann es für die kommerzielle Nutzung verwendet werden. Die gesammelten, umfangreichen Industrie-Implementierungsfälle sind sehr wertvoll Fälle für die Industrieimplementierung basierend auf dem Open-Source-Modell der Llama-Serie. Interpretiert den Fall des Domänen-Feinabstimmungsmodells basierend auf dem Modell der Llama-Serie und den Implementierungsfall „basierend auf dem Modell der LLama-Serie + Erweiterung der Wissensdatenbank“. Es fasst die Rechenleistungsbedingungen, Datenmengen- und -qualitätsanforderungen, ROI und Szenarien sowie andere notwendige Bedingungen für die Feinabstimmung von Modellen in Branchen zusammen. Es wird betont, dass die Form der Implementierung großer Modelle in der Branche heterogene Daten aus mehreren Quellen sein kann. Dokumentieren Sie intelligente Analysen und Wissensdatenbankspezifikationen.

Shi Yemin, CEO von LinkSoul.AI und Initiator des chinesischen Llama 2 7B-Projekts

Mit der Entwicklung der Großmodelltechnologie sind multimodale Großmodelle zunehmend zum Schlüssel für die Förderung verkörperter Intelligenz und ein besseres Benutzererlebnis geworden wird sicherlich eine Schlüsselkomponente der künstlichen Intelligenztechnologie der nächsten Generation werden. Die LLM-basierte Transformation ist derzeit eine der besten multimodalen Modelllösungen und hat einen großen Forschungs- und Praxiswert.

Shi Yemin sprach über das Thema „Technologie und Praxis multimodaler großer Modelle basierend auf Llama 2“, teilte die Modi und Prinzipien multimodaler Modelle mit und diskutierte eingehend visuelle multimodale große Modelle und Sprachmultimodalitätsverbesserungspraktiken für große Modelle. Er erwähnte, wie alte Modelle neue Modalitäten unterstützen können und welche wichtigen Punkte bei der Betrachtung neuer Fähigkeiten zu beachten sind. Darüber hinaus stellte er mehrere Lösungen zur multimodalen Verbesserung vor und betonte Aspekte, auf die bei den Schulungsdetails geachtet werden muss. Shi Yemin glaubt, dass die größte Herausforderung multimodaler Modelle in Daten liegt. Er teilte einige Methoden und Wege zur Generierung von Bildern oder grafischen Daten auf der Grundlage von Modellen mit

In der Umfrage dieser Veranstaltung schenkten die Teilnehmer den Branchenanwendungsinhalten „Quantifizierung und Feinabstimmung“ am meisten Aufmerksamkeit. In seinem Vortrag stellte Su Yang den besonderen Inhalt von „Llama 2 Open-Source-Modellquantifizierung und kostengünstige Feinabstimmungspraxis“ vor, einschließlich des aktuellen Status der Open-Source-Modellökologie und der Lama-Ökologie sowie gängiger Quantifizierungs- und Feinabstimmungslösungen. und die Leichtigkeit dieser beiden Dinge

„Für die Feinabstimmung wird empfohlen, die von der Open-Source-Industrie geteilte Sota-Lösung zu verwenden, anstatt blind nach Originalität zu streben.“ Er betonte, dass Quantifizierung und Feinabstimmung relativ praktisch seien nach verschiedenen Prinzipien. Der eigentliche Modellquantifizierungsprozess ist kein einfacher Einheitsprozess. Es gibt viele Dimensionen und Parameter. Bei der Feinabstimmung müssen auch die Besonderheiten berücksichtigt werden Schulungsumgebung, Hardwareumgebung und Basissystemumgebung, Su Yang gab eine ausführliche Erklärung dazu.

Nach einer detaillierten technischen Interpretation und Fallanalyse führten Shi Yemin und Su Yang die Teilnehmer dazu, mit der Schulung, Quantifizierung und Feinabstimmung großer Modelle zu beginnen.

Shi Yemin konzentrierte sich auf die grundlegende Modellauswahl, Trainingstechniken und Erfahrung, einschließlich zweier Wege: Training von Grund auf basierend auf einem Basismodell und Vokabelerweiterungstraining basierend auf Open-Source-Modellen sowie der entsprechenden Architektur und Modellgröße, sofern dies möglich ist kommerzialisiert werden und ob es das Vokabular erweitern kann, Filterbedingungen wie Tabellen und verwandte Fragen wie SFT-Datensätze beantworten kann.

Su Yang führte die Teilnehmer vor Ort dazu, eine Reihe von Vorgängen durchzuführen, darunter das Bereitstellen von Bildern, das Laden von Modellen, das Laden von Datensätzen, das Festlegen von QLoRA-Parametern, das Konfigurieren von SFT-Parametern, die Verwendung des Transformator-Parameterpakets usw. Ein großes privates Modell wurde erfolgreich einer Feinabstimmung unterzogen, die den Teilnehmern dabei half, die Inhalte dieser Veranstaltung besser zu verstehen.

Auch in Zukunft werden wir die neuesten Entwicklungen in der Branche und die Bedürfnisse der Entwickler im Auge behalten und verfolgen Halten Sie weiterhin qualitativ hochwertige groß angelegte technische Aktivitäten ab, die Entwicklern helfen, ihre Ingenieurspraxis und innovativen Anwendungsmöglichkeiten schnell zu verbessern und sich auf die Ära der großen Modelle vorzubereiten. Wir heißen alle herzlich willkommen, weiterhin auf die Aktivitäten unseres KI-Technologieforums zu achten

Das obige ist der detaillierte Inhalt vonOnline im Angebot! Das erste Heart of Machine AI-Technologieforum ist erfolgreich zu Ende gegangen. Diese großen technischen Informationen sind immer wieder sehenswert.. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Welche Kenntnisse müssen Linux-Betriebs- und Wartungsingenieure beherrschen?

- Was bedeutet „Energie auffüllen' im Handy-Technik-Menü?

- Das große Modell von Alibaba Qianwen kombinierte erstmals erfolgreich Industrieroboter mit der DingTalk-Fernsteuerung, um Experimente durchzuführen

- Der große Modelltest ist da! Dieser Artikel wird Ihnen helfen, die Evolutionsgeschichte großer Modelle globaler KI-Giganten zu klären

- Meitu veröffentlicht MiracleVision, Chinas erstes „ästhetisch versiertes' visuelles KI-Modell