Heim >Technologie-Peripheriegeräte >KI >„Scene Control Portal: Vier-in-eins-Objektteleportation, übermittelt und produziert'

„Scene Control Portal: Vier-in-eins-Objektteleportation, übermittelt und produziert'

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-09-12 16:05:021123Durchsuche

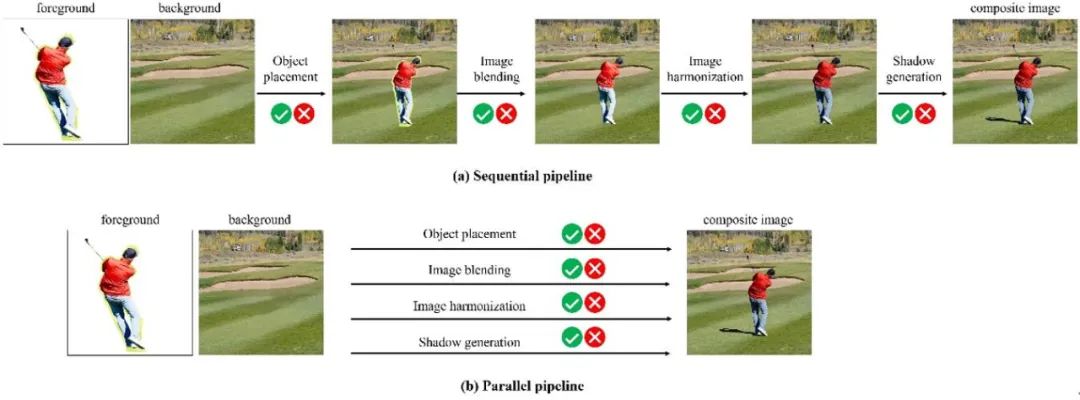

Bei gängigen Bildbearbeitungsvorgängen bezieht sich die Bildsynthese auf den Prozess, bei dem das Vordergrundobjekt eines Bildes mit einem anderen Hintergrundbild kombiniert wird, um ein zusammengesetztes Bild zu erzeugen. Der visuelle Effekt des synthetisierten Bildes ähnelt der Übertragung des Vordergrundobjekts von einem Bild auf ein anderes Hintergrundbild, wie in der folgenden Abbildung dargestellt. Die Bildsynthese wird in der Kunsterstellung, im Plakatdesign, im E-Commerce und in der virtuellen Realität verwendet , Datenerweiterung und andere Bereiche sind weit verbreitet

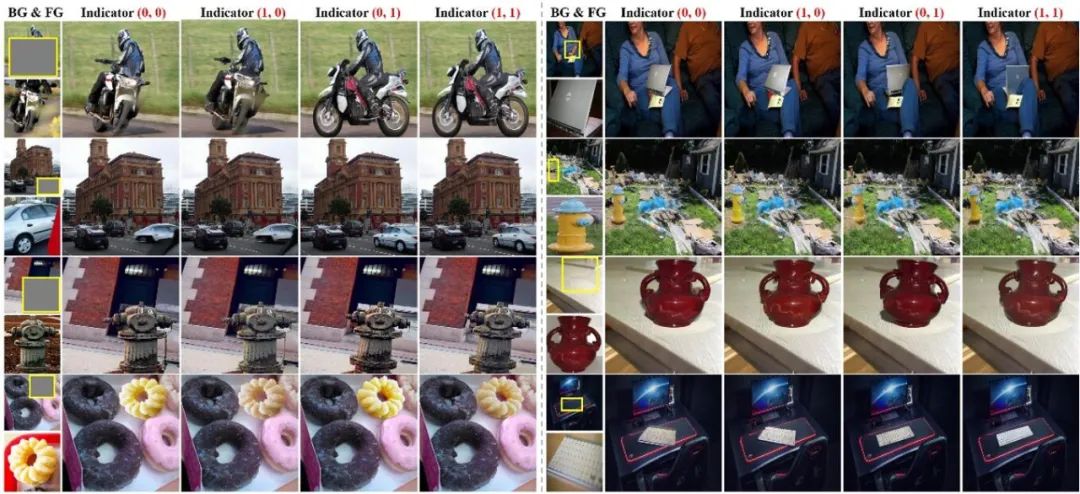

Als nächstes zeigen wir weitere Ergebnisse von vier Versionen unserer Methode (0,0), (1,0), (0,1), (1,1). Es ist ersichtlich, dass unsere Methode bei Verwendung verschiedener Indikatorvektoren einige Attribute von Vordergrundobjekten selektiv anpassen, den Effekt des zusammengesetzten Bildes effektiv steuern und den unterschiedlichen Anforderungen der Benutzer gerecht werden kann.

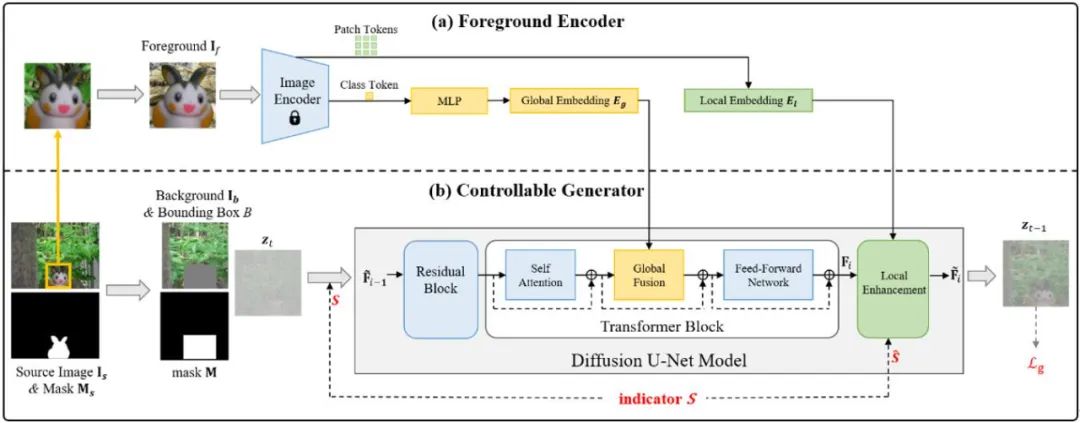

Was wir neu schreiben müssen, ist: Welche Modellstruktur kann die vier Funktionen realisieren? Unsere Methode verwendet die folgende Modellstruktur. Die Eingabe des Modells umfasst Hintergrundbilder mit Vordergrundbegrenzungsrahmen und Vordergrundobjektbildern. Wir extrahieren die globalen Merkmale von die Vordergrundobjekte und lokalen Features und verschmelzen zuerst globale Features und dann lokale Features. Während des lokalen Fusionsprozesses verwenden wir ausgerichtete Vordergrund-Feature-Maps zur Feature-Modulation, um eine bessere Detailerhaltung zu erreichen. Gleichzeitig werden Indikatorvektoren sowohl bei der globalen Fusion als auch bei der lokalen Fusion verwendet, um die Eigenschaften von Vordergrundobjekten besser zu steuern.

Wir verwenden den vorab trainierten stabilen Diffusionsalgorithmus, um das Modell basierend auf 1,9 Millionen Bildern von OpenImage zu trainieren. Um vier Teilaufgaben gleichzeitig zu trainieren, haben wir eine Reihe von Datenverarbeitungs- und -verbesserungsprozessen entworfen. Einzelheiten zu den Daten und zum Training finden Sie im Dokument

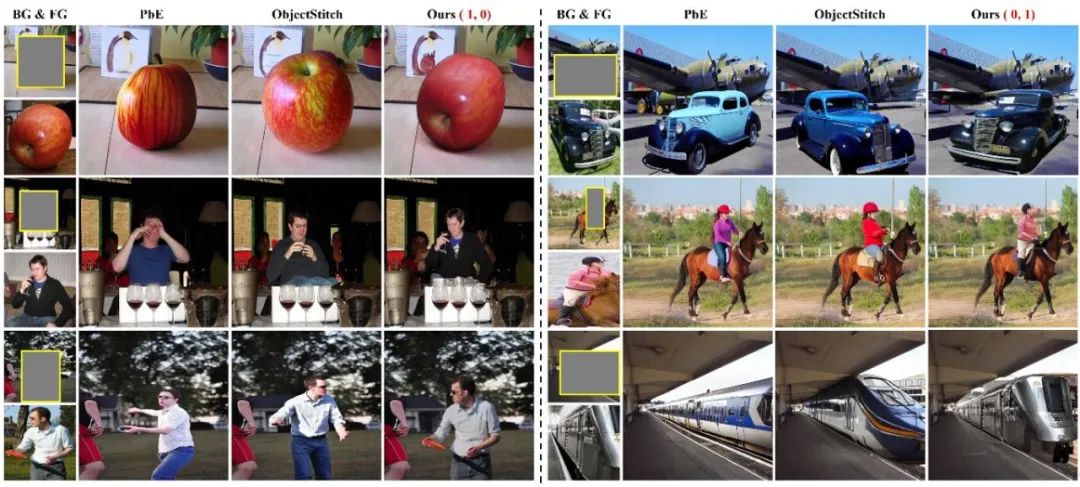

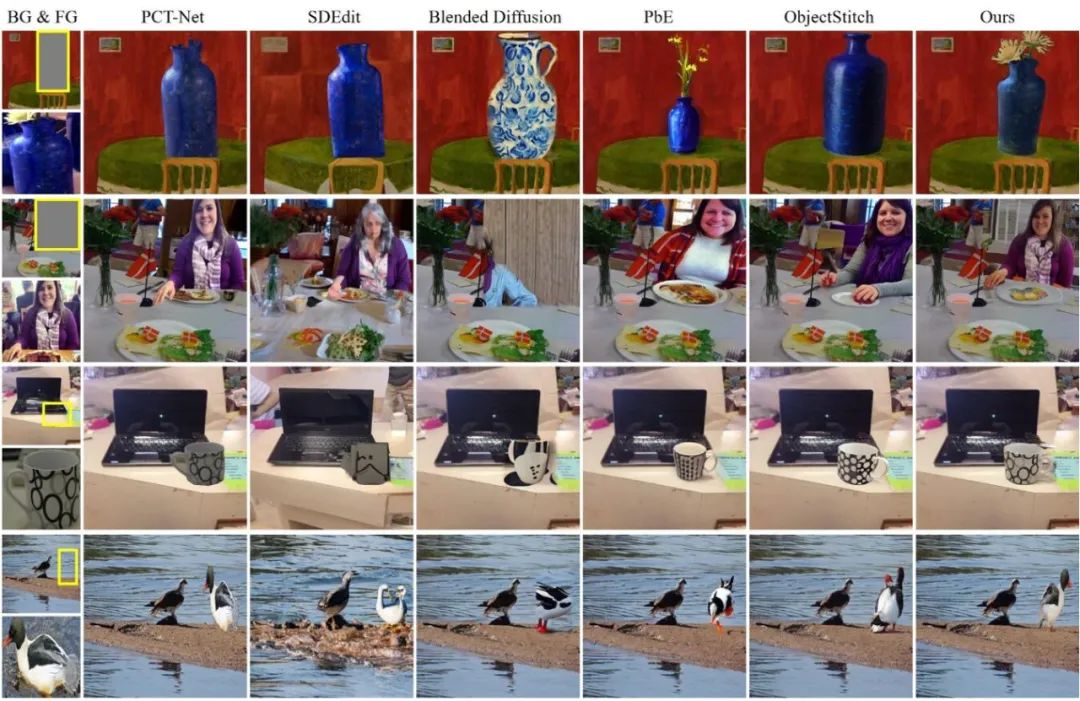

Wir haben den COCOEE-Datensatz und einen selbst erstellten Datensatz getestet. Da frühere Methoden nur eine unkontrollierbare Bildsynthese erreichen können, haben wir sie mit der (1,1)-Version und früheren Methoden verglichen. Die Vergleichsergebnisse sind in der folgenden Abbildung dargestellt. PCTNet ist eine Bildharmonisierungsmethode, die die Details von Objekten beibehalten kann, jedoch weder die Position des Vordergrunds anpassen noch die Vordergrundobjekte vervollständigen kann. Andere Methoden können die gleiche Art von Objekten erzeugen, sind jedoch weniger effektiv bei der Beibehaltung von Details, wie z. B. dem Kleidungsstil, der Textur von Körbchen, der Farbe von Vogelfedern usw.

Wir haben den COCOEE-Datensatz und einen selbst erstellten Datensatz getestet. Da frühere Methoden nur eine unkontrollierbare Bildsynthese erreichen können, haben wir sie mit der (1,1)-Version und früheren Methoden verglichen. Die Vergleichsergebnisse sind in der folgenden Abbildung dargestellt. PCTNet ist eine Bildharmonisierungsmethode, die die Details von Objekten beibehalten kann, jedoch weder die Position des Vordergrunds anpassen noch die Vordergrundobjekte vervollständigen kann. Andere Methoden können die gleiche Art von Objekten erzeugen, sind jedoch weniger effektiv bei der Beibehaltung von Details, wie z. B. dem Kleidungsstil, der Textur von Körbchen, der Farbe von Vogelfedern usw. Unsere Methode ist besser bei der Beibehaltung der Details im Vordergrund Details, unvollständige Vordergrundobjekte vervollständigen und die Beleuchtung, Haltung und Anpassung der Vordergrundobjekte an den Hintergrund anpassen

Diese Arbeit ist der erste Versuch einer kontrollierbaren Bildsynthese, und es gibt immer noch viele Allerdings ist die Leistung des Modells nicht stabil und robust genug. Darüber hinaus können neben Beleuchtung und Haltung auch die Eigenschaften von Vordergrundobjekten weiter verfeinert werden, um eine feinkörnigere, steuerbare Bildsynthese zu erreichen.

Diese Arbeit ist der erste Versuch einer kontrollierbaren Bildsynthese, und es gibt immer noch viele Allerdings ist die Leistung des Modells nicht stabil und robust genug. Darüber hinaus können neben Beleuchtung und Haltung auch die Eigenschaften von Vordergrundobjekten weiter verfeinert werden, um eine feinkörnigere, steuerbare Bildsynthese zu erreichen.

Yang, Gu, Zhang, Zhang, Chen, Sun, Chen, Wen (2023). Beispielbasierte Bildbearbeitungs- und Diffusionsmodelle. In CVPR

[2] Song Yongzhong, Zhang Zhi, Lin Zhilong, Cohen, S. D., Price, B. L., Zhang Jing, Jin Suying, Arriaga, D. G. 2023. ObjectStitch: Generative Objektsynthese. Im CVPR

Das obige ist der detaillierte Inhalt von„Scene Control Portal: Vier-in-eins-Objektteleportation, übermittelt und produziert'. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Was ist die theoretisch schnellste Übertragungsrate der USB3.0-Schnittstelle?

- Lassen Sie uns über die Theorie der Master-Slave-Replikation, Sentry und Clustering in Redis sprechen [ausführliche Erklärung mit Bildern und Text]

- Java-theoretische Basis - Stapel (Zusammenfassungsfreigabe)

- Wie hoch wird die theoretische Höchstgeschwindigkeit des 5g-Netzes sein?