Heim >Technologie-Peripheriegeräte >KI >Neues Rückgrat eines leichten visuellen Netzwerks: effizienter Fourier-Operator-Token-Mixer

Neues Rückgrat eines leichten visuellen Netzwerks: effizienter Fourier-Operator-Token-Mixer

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-08-17 17:57:081615Durchsuche

1. Hintergrund

Im Laufe der Jahre haben drei visuelle Backbone-Netzwerke, Transformer, Large-Kernel-CNN und MLP, große Erfolge bei einer Vielzahl von Computer-Vision-Aufgaben erzielt, hauptsächlich aufgrund ihrer effizienten globalen Skalierung um Informationen zu verschmelzen

Transformer, CNN und MLP sind derzeit die drei gängigen neuronalen Netze, und sie verwenden jeweils unterschiedliche Methoden, um eine globale Token-Fusion zu erreichen. Im Transformer-Netzwerk verwendet der Selbstaufmerksamkeitsmechanismus die Korrelation von Abfrage-Schlüssel-Paaren als Gewicht der Token-Fusion. CNN erreicht eine ähnliche Leistung wie Transformer, indem es die Größe des Faltungskerns erweitert. MLP implementiert ein weiteres leistungsstarkes Paradigma zwischen allen Token durch vollständige Konnektivität. Obwohl diese Methoden effektiv sind, weisen sie eine hohe Rechenkomplexität (O(N^2)) auf und lassen sich nur schwer auf Geräten mit begrenzten Speicher- und Rechenkapazitäten bereitstellen, wodurch der Anwendungsbereich vieler AFF-Token-Mixer eingeschränkt wird : Leicht, global, adaptiv

Um das rechenintensive Problem zu lösen, entwickelten Forscher einen effizienten globalen Token-Fusion namens Adaptive Fourier Filter (AFF)-Algorithmus. Dieser Algorithmus verwendet die Fourier-Transformation, um den Token-Satz in den Frequenzbereich umzuwandeln, und erlernt eine Filtermaske, die adaptive Inhalte im Frequenzbereich verarbeiten kann, um adaptive Filteroperationen für den in den Frequenzbereich konvertierten Token-Satz durchzuführen.

Adaptive Frequenzfilter : Effiziente globale Token-Mixer

Klicken Sie auf diesen Link, um auf den Originaltext zuzugreifen: https://arxiv.org/abs/2307.14008

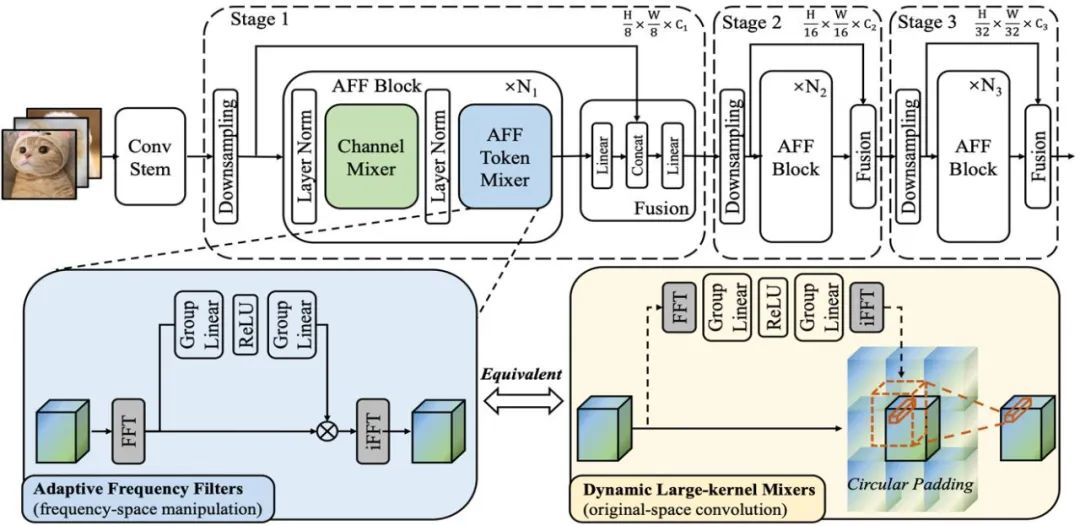

Gemäß dem Frequenzdomänen-Faltungstheorem ist die Mathematik des AFF-Token-Mixers Die äquivalente Operation ist eine im Originalbereich ausgeführte Faltungsoperation, die der im Fourier-Bereich ausgeführten Hadamard-Produktoperation entspricht. Das bedeutet, dass AFF Token Mixer eine inhaltsadaptive globale Token-Fusion erreichen kann, indem er einen dynamischen Faltungskern in der Originaldomäne mit derselben räumlichen Auflösung wie der Größe des Token-Sets verwendet (wie in der rechten Teilfigur der Abbildung unten gezeigt)

Es ist bekannt, dass die dynamische Faltung rechenintensiv ist, insbesondere wenn dynamische Faltungskerne mit großer räumlicher Auflösung verwendet werden. Dieser Aufwand scheint für ein effizientes/leichtgewichtiges Netzwerkdesign inakzeptabel zu sein. Der in diesem Artikel vorgeschlagene AFF-Token-Mixer kann jedoch gleichzeitig die oben genannten Anforderungen in einer äquivalenten Implementierung mit geringem Stromverbrauch erfüllen, wodurch die Komplexität von O (N^2) auf O (N log N) reduziert und somit die Recheneffizienz erheblich verbessert wird

Schematisches Diagramm 1: Zeigt die Struktur des AFF-Moduls und des AFFNet-Netzwerks

3. AFFNet: das neue Rückgrat des leichten visuellen Netzwerks

Durch die Verwendung von AFF Token Mixer als Hauptoperation des neuronalen Netzwerks Betreiber, Den Forschern gelang es, ein leichtes neuronales Netzwerk namens AFFNet aufzubauen. Umfangreiche experimentelle Ergebnisse zeigen, dass AFF Token Mixer bei einer Vielzahl visueller Aufgaben, einschließlich visueller semantischer Erkennung und dichter Vorhersageaufgaben, ein hervorragendes Gleichgewicht zwischen Genauigkeit und Effizienz erreicht Token Mixer und AFFNet vergleichen mehrere Aufgaben wie visuelle semantische Erkennung, Segmentierung und Erkennung mit dem fortschrittlichsten leichten visuellen Backbone-Netzwerk im aktuellen Forschungsbereich. Experimentelle Ergebnisse zeigen, dass das Modelldesign bei einer Vielzahl visueller Aufgaben gut funktioniert, was das Potenzial von AFF Token Mixer als neue Generation eines leichten und effizienten Token-Fusion-Operators bestätigt. Im Vergleich zu SOTA zeigt Abbildung 2 Acc -Param- und Acc-FLOPs-Kurven für den ImageNet-1K-Datensatz. Vergleich der Ergebnisse der modernsten Methoden mit dem ImageNet-1K-Datensatz, siehe Tabelle 1 Tabelle 2 zeigt den Vergleich visueller Erkennungs- und Segmentierungsaufgaben mit modernsten Techniken

5. Fazit

Diese Studie beweist, dass die Frequenzbereichstransformation im latenten Raum eine wichtige Rolle bei der globalen adaptiven Token-Fusion spielt und eine effiziente und stromsparende äquivalente Implementierung darstellt. Es liefert neue Forschungsideen für den Entwurf von Token-Fusion-Operatoren in neuronalen Netzen und bietet neuen Entwicklungsraum für den Einsatz neuronaler Netzmodelle auf Edge-Geräten, insbesondere wenn die Speicher- und Rechenkapazitäten begrenzt sind

Das obige ist der detaillierte Inhalt vonNeues Rückgrat eines leichten visuellen Netzwerks: effizienter Fourier-Operator-Token-Mixer. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Unter Datenstruktur versteht man die Untersuchung von Daten und den Beziehungen zwischen ihnen

- Welche Funktion haben die Funktionstasten des Taschenrechners?

- Was sind die wichtigsten Überlegungen für Benutzer, wenn sie sich für Cloud Computing entscheiden?

- Was sind die fünf Hauptbestandteile eines Computers mit Von-Neumann-Architektur?

- So berechnen Sie den Median in Excel