Heim >häufiges Problem >Was ist ein Webcrawler?

Was ist ein Webcrawler?

- DDDOriginal

- 2023-06-20 16:36:251845Durchsuche

Wenn es um technisches SEO geht, kann es schwierig sein, zu verstehen, wie es funktioniert. Aber es ist wichtig, so viel Wissen wie möglich zu gewinnen, um unsere Website zu optimieren und ein größeres Publikum zu erreichen. Ein Tool, das bei SEO eine wichtige Rolle spielt, ist der Webcrawler.

Ein Webcrawler (auch Webspider genannt) ist ein Roboter, der Inhalte im Internet durchsucht und indiziert. Webcrawler sind im Wesentlichen dafür verantwortlich, den Inhalt einer Webseite zu verstehen, um ihn bei einer Abfrage abzurufen.

Sie fragen sich vielleicht: „Wer betreibt diese Webcrawler?“

Typischerweise werden Webcrawler von Suchmaschinen mit eigenen Algorithmen betrieben. Der Algorithmus teilt Webcrawlern mit, wie sie als Reaktion auf Suchanfragen relevante Informationen finden können.

Ein Webspider durchsucht (crawlt) und kategorisiert alle Webseiten im Internet, die er finden kann, und wird aufgefordert, ihn zu indizieren. Wenn Sie also nicht möchten, dass Ihre Seite in Suchmaschinen gefunden wird, können Sie Webcrawler anweisen, Ihre Seite nicht zu crawlen.

Dazu müssen Sie eine robots.txt-Datei hochladen. Im Wesentlichen teilt die robots.txt-Datei den Suchmaschinen mit, wie sie die Seiten Ihrer Website crawlen und indizieren sollen.

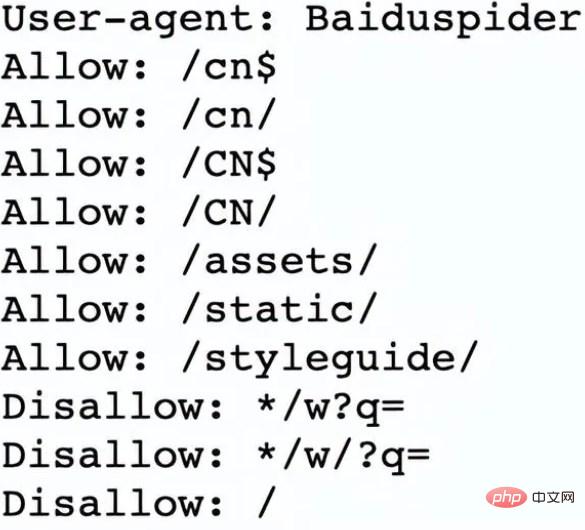

Schauen wir uns zum Beispiel Nike.com/robots.txt an.

Nike verwendet seine robots.txt-Datei, um zu bestimmen, welche Links innerhalb seiner Website gecrawlt und indiziert werden.

In diesem Abschnitt des Dokuments wird Folgendes festgelegt:

Der Webcrawler Baiduspider durfte die ersten 7 Links crawlen.

Dem Webcrawler Baiduspider wurde das Crawlen der verbleibenden drei Links untersagt.

Das ist gut für Nike Ja, da einige Seiten des Unternehmens nicht für die Suche geeignet sind und unzulässige Links keinen Einfluss auf die optimierten Seiten haben, die ihnen beim Ranking in Suchmaschinen helfen.

Jetzt wissen wir also, was Webcrawler sind und wie sie ihre Arbeit erledigen? Sehen wir uns als Nächstes an, wie Webcrawler funktionieren.

Webcrawler funktionieren, indem sie URLs erkennen und Webseiten anzeigen und klassifizieren. Dabei finden sie Hyperlinks zu anderen Webseiten und fügen sie der Liste der Seiten hinzu, die als nächstes gecrawlt werden sollen. Webcrawler sind intelligent und können die Wichtigkeit jeder Webseite bestimmen.

Suchmaschinen-Webcrawler werden höchstwahrscheinlich nicht das gesamte Internet durchsuchen. Stattdessen wird die Bedeutung jeder Webseite anhand von Faktoren wie der Anzahl der darauf verlinkten anderen Seiten, Seitenaufrufen und sogar der Markenautorität bestimmt. Daher bestimmen Webcrawler, welche Seiten gecrawlt werden sollen, in welcher Reihenfolge sie gecrawlt werden und wie oft sie Updates crawlen sollen.

Wenn Sie beispielsweise eine neue Webseite haben oder Änderungen an einer vorhandenen Webseite vorgenommen werden, zeichnet der Webcrawler den Index auf und aktualisiert ihn. Wenn Sie eine neue Webseite haben, können Sie auch Suchmaschinen bitten, Ihre Website zu crawlen.

Wenn sich ein Webcrawler auf Ihrer Seite befindet, prüft er die Text- und Meta-Tags, speichert diese Informationen und indiziert sie, damit Suchmaschinen sie nach Schlüsselwörtern bewerten können.

Bevor der gesamte Prozess beginnt, schauen sich Webcrawler Ihre robots.txt-Datei an, um zu sehen, welche Seiten gecrawlt werden sollen, weshalb dies für technisches SEO so wichtig ist.

Wenn ein Webcrawler Ihre Seite crawlt, bestimmt er letztendlich, ob Ihre Seite auf der Suchergebnisseite für Ihre Suchanfrage angezeigt wird. Es ist wichtig zu beachten, dass sich einige Webcrawler möglicherweise anders verhalten als andere. Manche Leute ziehen beispielsweise unterschiedliche Faktoren heran, wenn sie entscheiden, welche Seiten am wichtigsten gecrawlt werden sollen.

Da wir nun verstehen, wie Webcrawler funktionieren, besprechen wir, warum sie Ihre Website crawlen sollten.

Das obige ist der detaillierte Inhalt vonWas ist ein Webcrawler?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Erstellen Sie den effizientesten Webcrawler: mit PHP und Selenium

- Einführung in Schlüsselkompetenzen für die Implementierung von Webcrawlern mit PHP und Selenium

- Bringen Sie Ihnen bei, wie Sie PHP und Selenium verwenden, um die Webcrawler-Entwicklung zu implementieren

- Der PHP-Webcrawler verwendet fsockopen, um HTTP-Anfragen zu implementieren

- Detaillierte Erläuterung der HTTP-Anfragemethode des PHP-Webcrawlers