Technologie-Peripheriegeräte

Technologie-Peripheriegeräte KI

KI „Zensiert' während der Bilderzeugung: Fehlerfälle einer stabilen Diffusion werden von vier Hauptfaktoren beeinflusst

„Zensiert' während der Bilderzeugung: Fehlerfälle einer stabilen Diffusion werden von vier Hauptfaktoren beeinflusstModelle zur Generierung von Text-zu-Bild-Diffusion, wie Stable Diffusion, DALL-E 2 und Mid-Journey, befinden sich in einer Phase intensiver Entwicklung und verfügen über starke Fähigkeiten zur Text-zu-Bild-Generierung, bei „Rollover“-Fällen ist dies jedoch der Fall auch Gelegentlich.

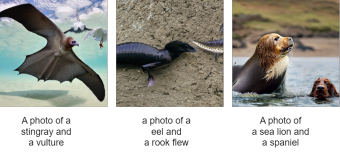

Wie in der Abbildung unten gezeigt, kann das Stable Diffusion-Modell bei einer Textaufforderung „Ein Foto eines Warzenschweins“ ein entsprechendes, klares und realistisches Foto eines Warzenschweins erzeugen. Wenn wir diese Textaufforderung jedoch leicht modifizieren und sie in „Ein Foto eines Warzenschweins und eines Verräters“ ändern, was ist dann mit dem Warzenschwein? Wie ist daraus ein Auto geworden?

Werfen wir einen Blick auf die nächsten Beispiele?

Was verursacht diese seltsamen Phänomene? Diese Fälle von Generationenversagen stammen alle aus einem kürzlich veröffentlichten Papier "Stabile Diffusion ist instabil":

- Paper -Adresse: https://arxiv.org/abs/2306.02583

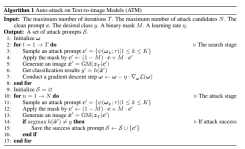

In diesem Artikel wird erstmals ein Gradienten-basierter kontradiktorischer Algorithmus für Text-zu-Bild-Modelle vorgeschlagen. Dieser Algorithmus kann effizient und effektiv eine große Anzahl anstößiger Textaufforderungen generieren und die Instabilität des stabilen Diffusionsmodells effektiv untersuchen. Dieser Algorithmus erreichte eine Angriffserfolgsrate von 91,1 % bei Kurztext-Eingabeaufforderungen und 81,2 % bei Langtext-Eingabeaufforderungen. Darüber hinaus bietet dieser Algorithmus umfangreiche Beispiele für die Untersuchung der Fehlermodi von Text-zu-Bild-Generierungsmodellen und legt damit eine Grundlage für die Erforschung der Steuerbarkeit der Bildgenerierung.

Basierend auf einer großen Anzahl von Generationsfehlerfällen, die von diesem Algorithmus generiert wurden, fasste der Forscher vier Gründe für Generationsfehler zusammen, nämlich:

- Unterschied in der Generationsgeschwindigkeit

- Ähnlichkeit grobkörniger Merkmale

- Die Mehrdeutigkeit von Wörtern

- Die Position des Wortes in der Eingabeaufforderung

Der Unterschied in der Generierungsgeschwindigkeit

Wenn eine Eingabeaufforderung (Eingabeaufforderung) mehrere Generationsziele enthält, tritt häufig ein bestimmtes Ziel auf Generieren Das Problem verschwindet während des Vorgangs. Theoretisch sollten alle Ziele innerhalb desselben Cues das gleiche Anfangsgeräusch haben. Wie in Abbildung 4 dargestellt, generierten die Forscher auf ImageNet unter der Bedingung eines festen Anfangsrauschens eintausend Kategorieziele. Sie verwendeten das letzte von jedem Ziel generierte Bild als Referenzbild und berechneten den SSIM-Score (Structural Similarity Index) zwischen dem in jedem Zeitschritt generierten Bild und dem im letzten Schritt generierten Bild, um die Unterschiede in der Erstellungsgeschwindigkeit zu demonstrieren.

Ähnlichkeit grobkörniger Merkmale

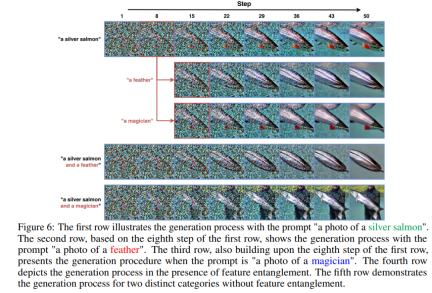

Während des Diffusionsgenerierungsprozesses stellten Forscher fest, dass bei globaler oder lokaler Ähnlichkeit grobkörniger Merkmale zwischen zwei Zieltypen die Queraufmerksamkeit berechnet wird ( Dort ist ein Problem mit Kreuzaufmerksamkeitsgewichten. Dies liegt daran, dass sich die beiden Zielnomen gleichzeitig auf denselben Block desselben Bildes konzentrieren können, was zu einer Merkmalsverschränkung führt. Beispielsweise weisen in Abbildung 6 Feder- und Silberlachs gewisse Ähnlichkeiten in grobkörnigen Merkmalen auf, was dazu führt, dass Federn ihre Erzeugungsaufgabe im achten Schritt des auf Silberlachs basierenden Erzeugungsprozesses weiterhin erfüllen können. Bei zwei Arten von Zielen ohne Verschränkung, wie Silberlachs und Magier, kann der Magier seine Erzeugungsaufgabe auf dem Zwischenschrittbild basierend auf Silberlachs nicht abschließen.

Polysemie

In diesem Kapitel untersuchen Forscher eingehend die Generationssituation, in der ein Wort mehrere Bedeutungen hat. Sie fanden heraus, dass das resultierende Bild ohne äußere Störung oft eine bestimmte Bedeutung des Wortes darstellte. Nehmen Sie als Beispiel „Warzenschwein“. Die erste Zeile in Abbildung A4 basiert auf der Bedeutung des Wortes „Warzenschwein“.

Forscher fanden jedoch auch heraus, dass es zu semantischen Verschiebungen kommen kann, wenn andere Wörter in die ursprüngliche Eingabeaufforderung eingefügt werden. Wenn beispielsweise das Wort „Verräter“ in einer Aufforderung zur Beschreibung von „Warzenschwein“ eingeführt wird, kann der generierte Bildinhalt von der ursprünglichen Bedeutung von „Warzenschwein“ abweichen und völlig neue Inhalte generieren.

Die Position des Wortes in der Eingabeaufforderung

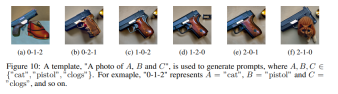

In Abbildung 10 beobachtete der Forscher ein interessantes Phänomen. Obwohl aus menschlicher Sicht die in unterschiedlicher Reihenfolge angeordneten Eingabeaufforderungen im Allgemeinen dieselbe Bedeutung haben und alle ein Bild einer Katze, Holzschuhen und einer Pistole beschreiben. Beim Sprachmodell, also dem CLIP-Textencoder, beeinflusst die Reihenfolge der Wörter jedoch bis zu einem gewissen Grad das Verständnis des Textes, was wiederum den Inhalt der generierten Bilder verändert. Dieses Phänomen zeigt, dass unsere Beschreibungen zwar semantisch konsistent sind, das Modell jedoch aufgrund der unterschiedlichen Reihenfolge der Wörter zu unterschiedlichen Verständnis- und Generierungsergebnissen führen kann. Dies zeigt nicht nur, dass die Art und Weise, wie Modelle Sprache verarbeiten und Semantik verstehen, sich von der des Menschen unterscheidet, sondern erinnert uns auch daran, dass wir beim Entwerfen und Verwenden solcher Modelle mehr auf die Auswirkungen der Wortreihenfolge achten müssen.

Die Modellstruktur

ist in Abbildung 1 unten dargestellt. Ohne das ursprüngliche Zielnomen in der Eingabeaufforderung zu ändern, setzte der Forscher den diskreten Prozess der Wortersetzung oder -erweiterung fort, indem er die Gumbel-Softmax-Verteilung lernte Um die Differenzierbarkeit der Störungserzeugung sicherzustellen, verwenden Sie nach der Generierung des Bildes den CLIP-Klassifikator und den Randverlust, um ω zu optimieren, um Bilder zu generieren, die CLIP nicht korrekt klassifizieren kann. Um sicherzustellen, dass die anstößigen Eingabeaufforderungen und die sauberen Eingabeaufforderungen eine gewisse Ähnlichkeit aufweisen, recherchieren In einem weiteren Schritt werden semantische Ähnlichkeitsbeschränkungen und Textflussbeschränkungen verwendet.

Sobald diese Verteilung gelernt ist, kann der Algorithmus mehrere Textaufforderungen mit Angriffseffekten für dieselbe Klartextaufforderung abtasten.

Weitere Einzelheiten finden Sie im Originalartikel.

Das obige ist der detaillierte Inhalt von„Zensiert' während der Bilderzeugung: Fehlerfälle einer stabilen Diffusion werden von vier Hauptfaktoren beeinflusst. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Gemma Scope: Das Mikroskop von Google, um in den Denkprozess von AI zu blickenApr 17, 2025 am 11:55 AM

Gemma Scope: Das Mikroskop von Google, um in den Denkprozess von AI zu blickenApr 17, 2025 am 11:55 AMErforschen der inneren Funktionsweise von Sprachmodellen mit Gemma -Umfang Das Verständnis der Komplexität von KI -Sprachmodellen ist eine bedeutende Herausforderung. Die Veröffentlichung von Gemma Scope durch Google, ein umfassendes Toolkit, bietet Forschern eine leistungsstarke Möglichkeit, sich einzuschütteln

Wer ist ein Business Intelligence Analyst und wie kann man einer werden?Apr 17, 2025 am 11:44 AM

Wer ist ein Business Intelligence Analyst und wie kann man einer werden?Apr 17, 2025 am 11:44 AMErschließung des Geschäftserfolgs: Ein Leitfaden zum Analyst für Business Intelligence -Analyst Stellen Sie sich vor, Rohdaten verwandeln in umsetzbare Erkenntnisse, die das organisatorische Wachstum vorantreiben. Dies ist die Macht eines Business Intelligence -Analysts (BI) - eine entscheidende Rolle in Gu

Wie füge ich eine Spalte in SQL hinzu? - Analytics VidhyaApr 17, 2025 am 11:43 AM

Wie füge ich eine Spalte in SQL hinzu? - Analytics VidhyaApr 17, 2025 am 11:43 AMSQL -Änderungstabellanweisung: Dynamisches Hinzufügen von Spalten zu Ihrer Datenbank Im Datenmanagement ist die Anpassungsfähigkeit von SQL von entscheidender Bedeutung. Müssen Sie Ihre Datenbankstruktur im laufenden Flug anpassen? Die Änderungstabelleerklärung ist Ihre Lösung. Diese Anleitung Details Hinzufügen von Colu

Business Analyst vs. Data AnalystApr 17, 2025 am 11:38 AM

Business Analyst vs. Data AnalystApr 17, 2025 am 11:38 AMEinführung Stellen Sie sich ein lebhaftes Büro vor, in dem zwei Fachleute an einem kritischen Projekt zusammenarbeiten. Der Business Analyst konzentriert sich auf die Ziele des Unternehmens, die Ermittlung von Verbesserungsbereichen und die strategische Übereinstimmung mit Markttrends. Simu

Was sind Count und Counta in Excel? - Analytics VidhyaApr 17, 2025 am 11:34 AM

Was sind Count und Counta in Excel? - Analytics VidhyaApr 17, 2025 am 11:34 AMExcel -Datenzählung und -analyse: Detaillierte Erläuterung von Count- und Counta -Funktionen Eine genaue Datenzählung und -analyse sind in Excel kritisch, insbesondere bei der Arbeit mit großen Datensätzen. Excel bietet eine Vielzahl von Funktionen, um dies zu erreichen. Die Funktionen von Count- und Counta sind wichtige Instrumente zum Zählen der Anzahl der Zellen unter verschiedenen Bedingungen. Obwohl beide Funktionen zum Zählen von Zellen verwendet werden, sind ihre Designziele auf verschiedene Datentypen ausgerichtet. Lassen Sie uns mit den spezifischen Details der Count- und Counta -Funktionen ausgrenzen, ihre einzigartigen Merkmale und Unterschiede hervorheben und lernen, wie Sie sie in der Datenanalyse anwenden. Überblick über die wichtigsten Punkte Graf und Cou verstehen

Chrome ist hier mit KI: Tag zu erleben, täglich etwas Neues !!Apr 17, 2025 am 11:29 AM

Chrome ist hier mit KI: Tag zu erleben, täglich etwas Neues !!Apr 17, 2025 am 11:29 AMDie KI -Revolution von Google Chrome: Eine personalisierte und effiziente Browsing -Erfahrung Künstliche Intelligenz (KI) verändert schnell unser tägliches Leben, und Google Chrome leitet die Anklage in der Web -Browsing -Arena. Dieser Artikel untersucht die Exciti

Die menschliche Seite von Ai: Wohlbefinden und VierfacheApr 17, 2025 am 11:28 AM

Die menschliche Seite von Ai: Wohlbefinden und VierfacheApr 17, 2025 am 11:28 AMImpacting Impact: Das vierfache Endergebnis Zu lange wurde das Gespräch von einer engen Sicht auf die Auswirkungen der KI dominiert, die sich hauptsächlich auf das Gewinn des Gewinns konzentrierte. Ein ganzheitlicherer Ansatz erkennt jedoch die Vernetzung von BU an

5 verwendende Anwendungsfälle für Quantum Computing, über die Sie wissen solltenApr 17, 2025 am 11:24 AM

5 verwendende Anwendungsfälle für Quantum Computing, über die Sie wissen solltenApr 17, 2025 am 11:24 AMDie Dinge bewegen sich stetig zu diesem Punkt. Die Investition, die in Quantendienstleister und Startups einfließt, zeigt, dass die Industrie ihre Bedeutung versteht. Und eine wachsende Anzahl realer Anwendungsfälle entsteht, um seinen Wert zu demonstrieren

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

SublimeText3 Englische Version

Empfohlen: Win-Version, unterstützt Code-Eingabeaufforderungen!

Dreamweaver CS6

Visuelle Webentwicklungstools

MantisBT

Mantis ist ein einfach zu implementierendes webbasiertes Tool zur Fehlerverfolgung, das die Fehlerverfolgung von Produkten unterstützen soll. Es erfordert PHP, MySQL und einen Webserver. Schauen Sie sich unsere Demo- und Hosting-Services an.

VSCode Windows 64-Bit-Download

Ein kostenloser und leistungsstarker IDE-Editor von Microsoft