Heim >Betrieb und Instandhaltung >Nginx >So konfigurieren Sie die Nginx-Strombegrenzung

So konfigurieren Sie die Nginx-Strombegrenzung

- PHPznach vorne

- 2023-06-02 13:10:062079Durchsuche

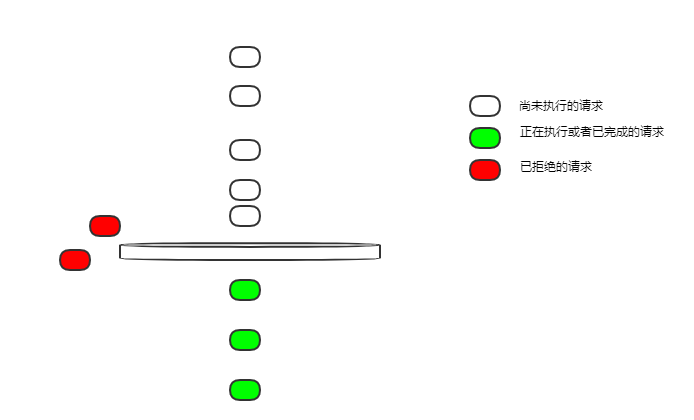

Leerer Bucket

Wir beginnen mit der einfachsten Strombegrenzungskonfiguration:

limit_req_zone $binary_remote_addr zone=ip_limit:10m rate=10r/s;

server {

location /login/ {

limit_req zone=ip_limit;

proxy_pass http://login_upstream;

}

}$binary_remote_addr für die Client-IP-Strombegrenzung;

zone=ip_limit:10m Der Name der aktuellen Begrenzungsregel ist ip_limit, was zulässig ist 10 MB Speicherplatz zum Aufzeichnen des aktuellen Begrenzungsstatus entsprechend der IP;

rate=10r/s Die aktuelle Begrenzungsgeschwindigkeit beträgt 10 Anfragen pro Sekunde

Standort /login/ Begrenzt den Anmeldefluss

Die Streaming-Geschwindigkeit beträgt 10 Anfragen pro Sekunde. Wenn 10 Anfragen gleichzeitig bei einem inaktiven Nginx eintreffen, werden sie dann alle ausgeführt?

Leaky-Bucket-Leak-Anfragen erfolgen mit gleichmäßiger Geschwindigkeit. Wie ist 10 U/s eine konstante Geschwindigkeit? Alle 100 ms wird eine Anfrage durchgesickert.

Bei dieser Konfiguration ist der Bucket leer und alle Anfragen, die nicht in Echtzeit durchgesickert sind, werden abgelehnt.

Wenn also 10 Anfragen gleichzeitig eingehen, kann nur eine Anfrage ausgeführt werden, die anderen werden abgelehnt.

Das ist nicht sehr freundlich. In den meisten Geschäftsszenarien hoffen wir, dass diese 10 Anfragen ausgeführt werden können.

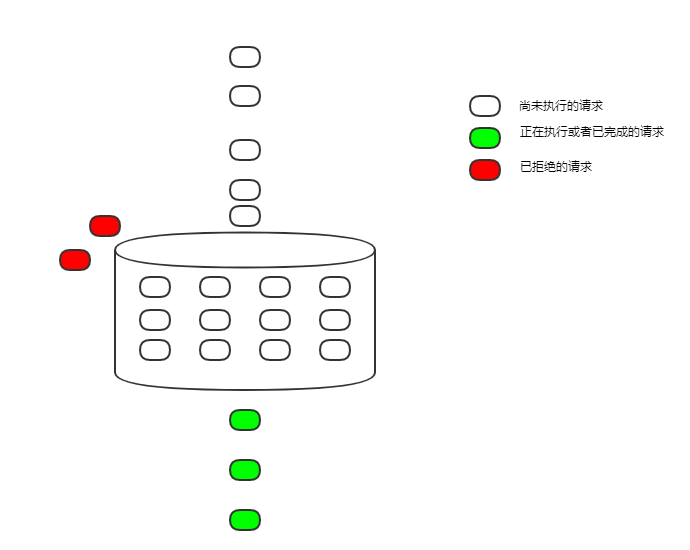

burst

Ändern wir die Konfiguration, um das Problem im vorherigen Abschnitt zu lösen

limit_req_zone $binary_remote_addr zone=ip_limit:10m rate=10r/s;

server {

location /login/ {

limit_req zone=ip_limit burst=12;

proxy_pass http://login_upstream;

}

}burst=12 Die Größe des Leaky-Buckets ist auf 12 eingestellt. und es ist als Fifo-Warteschlange implementiert, um Anforderungen, die nicht ausgeführt werden können, vorübergehend zwischenzuspeichern.

Auf diese Weise begrenzt der undichte Eimer nicht nur den Durchfluss, sondern übernimmt auch die Rolle der Spitzenglättung und Talfüllung.

Auf diese Weise begrenzt der undichte Eimer nicht nur den Durchfluss, sondern übernimmt auch die Rolle der Spitzenglättung und Talfüllung.

Wenn bei einer solchen Konfiguration 10 Anfragen gleichzeitig eintreffen, werden sie nacheinander alle 100 ms ausgeführt.

Obwohl es ausgeführt wurde, erhöhte sich die Verzögerung aufgrund der Warteschlangenausführung erheblich, was in vielen Szenarien immer noch inakzeptabel ist.

nodelay Ändern Sie die Konfiguration weiter, um das Problem der durch eine zu lange Verzögerung verursachten erhöhten Verzögerung zu lösen Jetzt gibt es keine Verzögerung. Sobald es in den Bucket gelegt wird, wird es entweder sofort ausgeführt oder aufgrund der aktuellen Begrenzung abgelehnt.Da Anfragen mit konstanter Geschwindigkeit aus dem Bucket austreten und der Bucket-Speicherplatz festgelegt ist, werden am Ende durchschnittlich 5 Anfragen pro Sekunde ausgeführt und der Zweck der Strombegrenzung wird weiterhin erreicht.

Aber das hat auch Nachteile. Das aktuelle Limit ist begrenzt, aber das Limit ist nicht so einheitlich. Nehmen wir die obige Konfiguration als Beispiel: Wenn 12 Anfragen gleichzeitig eintreffen, können diese 12 Anfragen sofort ausgeführt werden, und nachfolgende Anfragen können nur mit konstanter Geschwindigkeit in den Bucket eingegeben werden, und alle 100 ms wird eine Anfrage ausgeführt . Wenn für einen bestimmten Zeitraum keine Anfragen vorliegen und der Bucket leer ist, können 12 gleichzeitige Anfragen gleichzeitig ausgeführt werden.

In den meisten Fällen stellt diese ungleichmäßige Strombegrenzung kein großes Problem dar. Nginx bietet jedoch auch einen Parameter zur Steuerung der gleichzeitigen Ausführung, nämlich die Anzahl der Nodelay-Anfragen.

limit_req_zone $binary_remote_addr zone=ip_limit:10m rate=10r/s;

server {

location /login/ {

limit_req zone=ip_limit burst=12 nodelay;

proxy_pass http://login_upstream;

}

}delay=4 beginnt mit der Verzögerung ab der 5. Anfrage im Bucket gleichmäßig und ressourcenintensiv. Es ist immer noch notwendig, diese Menge im Dienst zu kontrollieren.

Das obige ist der detaillierte Inhalt vonSo konfigurieren Sie die Nginx-Strombegrenzung. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!