Heim >Backend-Entwicklung >Python-Tutorial >So implementieren Sie Softmax-Backpropagation in Python.

So implementieren Sie Softmax-Backpropagation in Python.

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-05-09 08:05:531377Durchsuche

Backpropagation-Ableitung

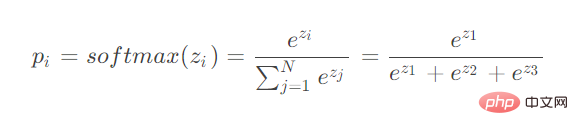

Wie Sie sehen können, berechnet Softmax die Eingaben mehrerer Neuronen. Bei der Backpropagation-Ableitung müssen Sie die Ableitung der Parameter verschiedener Neuronen berücksichtigen.

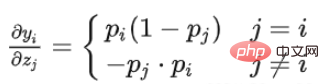

Betrachten Sie zwei Situationen:

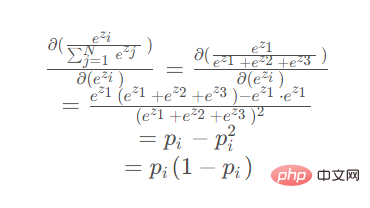

Wenn der Parameter für die Differenzierung im Zähler liegt.

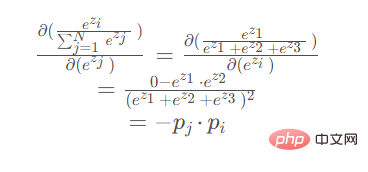

Wenn der Parameter für die Differenzierung im Nenner liegt.

Wenn der Parameter für die Differenzierung im Nenner liegt Zähler:

Wenn der Ableitungsparameter im Nenner befindet (e z2

z2

z3 sind symmetrisch, das Ableitungsergebnis ist das gleiche):

Code

import torch

import math

def my_softmax(features):

_sum = 0

for i in features:

_sum += math.e ** i

return torch.Tensor([ math.e ** i / _sum for i in features ])

def my_softmax_grad(outputs):

n = len(outputs)

grad = []

for i in range(n):

temp = []

for j in range(n):

if i == j:

temp.append(outputs[i] * (1- outputs[i]))

else:

temp.append(-outputs[j] * outputs[i])

grad.append(torch.Tensor(temp))

return grad

if __name__ == '__main__':

features = torch.randn(10)

features.requires_grad_()

torch_softmax = torch.nn.functional.softmax

p1 = torch_softmax(features,dim=0)

p2 = my_softmax(features)

print(torch.allclose(p1,p2))

n = len(p1)

p2_grad = my_softmax_grad(p2)

for i in range(n):

p1_grad = torch.autograd.grad(p1[i],features, retain_graph=True)

print(torch.allclose(p1_grad[0], p2_grad[i]))Das obige ist der detaillierte Inhalt vonSo implementieren Sie Softmax-Backpropagation in Python.. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!