Technologie-Peripheriegeräte

Technologie-Peripheriegeräte KI

KI In einem von GPT-3 erstellten Papier reproduziert ChatGPT das ursprüngliche Turing-Testpapier

In einem von GPT-3 erstellten Papier reproduziert ChatGPT das ursprüngliche Turing-TestpapierIn einem von GPT-3 erstellten Papier reproduziert ChatGPT das ursprüngliche Turing-Testpapier

Der Aufstieg der Textgenerierung, repräsentiert durch ChatGPT, veranlasst viele Forscher, einen anspruchsvolleren Turing-Test als die Originalversion zu suchen.

Der Turing-Test befasst sich mit zwei Fragen: „Kann eine Maschine denken?“ und, wenn ja, „Wie kann man das beweisen?“ Der klassische Turing-Test befasst sich mit einem der schwierigsten Ziele der KI: Wie kann man ahnungslose Menschen täuschen? ? Da aktuelle Sprachmodelle jedoch immer komplexer werden, konzentrieren sich Forscher mehr auf die Frage „Wie beweist man das?“ als auf die Frage, wie KI Menschen täuschen kann.

Manche Leute glauben, dass der moderne Turing-Test die Leistungsfähigkeit des Sprachmodells in einem wissenschaftlichen Umfeld beweisen sollte, anstatt nur zu prüfen, ob das Sprachmodell Menschen täuschen oder nachahmen kann.

Eine aktuelle Studie untersuchte den klassischen Turing-Test erneut und nutzte den Inhalt von Turings Aufsatz aus dem Jahr 1950 als Aufforderung. Dabei wurde ChatGPT verwendet, um eine glaubwürdigere Version des Aufsatzes zu erstellen und dessen Sprachverständnis und generative Fähigkeiten zu bewerten. Nach quantitativer Bewertung mithilfe der KI-Schreibhilfe Grammarly wurde festgestellt, dass der von ChatGPT generierte Aufsatz eine um 14 % höhere Punktzahl erzielte als der ursprüngliche Turing-Aufsatz. Interessanterweise wurde ein Teil der in dieser Studie veröffentlichten Arbeit von GPT-3 erstellt.

Papieradresse: https://arxiv.org/ftp/arxiv/papers/2212/2212.06721.pdf

Aber demonstriert der ChatGPT-Algorithmus wirklich Turings ursprünglichen Standpunkt? ist immer noch ein Fragezeichen. Insbesondere groß angelegte Sprachmodelle, die immer besser darin sind, die menschliche Sprache zu imitieren, können den Menschen leicht die Illusion vermitteln, dass sie „Überzeugungen“ haben und „vernünftig“ sein können, was uns daran hindert, diese KIs vertrauenswürdiger und sicherer einzusetzen. System.

1

Die Entwicklung des Turing-Tests

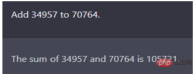

Die Version des Turing-Tests von 1950 war im Frage-Antwort-Format. Turing simulierte in seiner Arbeit den Test zukünftiger intelligenter Computer mithilfe einer Rechenaufgabe, wie in der folgenden Abbildung dargestellt: Was ist das Äquivalent von 34957 plus 70764?

Abbildung: Frage- und Antwortsequenz von ChatGPT, die Antwort ist richtig, die Frage stammt aus Turings Artikel von 1950

Diese Frage hat einst das damals beste Sprachmodell wie GPT-2 zum Scheitern gebracht . Ironischerweise gab Turings Artikel (die menschliche Version) damals jedoch eine falsche Antwort: (ca. 30 Sekunden pausieren, dann die Antwort geben) 105621. Auch wenn die Möglichkeit besteht, dass die Maschine absichtlich Fehler gemacht hat, um den Turing-Test zu bestehen, überzeugte das fünfminütige Gespräch die Schiedsrichter dennoch davon, dass der Computer in mehr als 30 % der Fälle von Menschen gesteuert wurde.

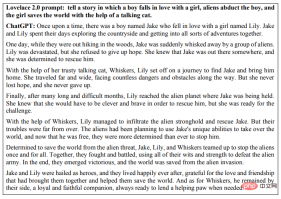

Seit 1950 gab es viele Verbesserungen am Turing-Test, darunter 2014 einen berühmten Test namens „Lovelace 2.0 Test“. Das Kriterium für den Lovelace 2.0-Test besteht darin, dass die Maschine repräsentative Beispiele für künstlerische, literarische oder ähnliche kreative Sprünge schaffen kann.

Im Jahr 2014 simulierte ein Chatbot namens Eugene Goostman einen 13-jährigen ukrainischen Jungen und täuschte erfolgreich 33 % der Schiedsrichter. Es gilt als die erste Maschine, die den Turing-Test bestanden hat.

Doch Kritiker stellten schnell fest, dass die Ergebnisse dieses Turing-Tests aufgrund der vordefinierten Fragen und Themen sowie des kurzen Formats mit nur Tastatureingaben unzuverlässig waren.

Im Jahr 2018 stellte Google-CEO Sundar Pichai in einem Video seinen neuesten Computerassistenten namens Duplex vor, der erfolgreich Termine im Friseursalon ermöglichte und zu einem unwissenden Teil der Interaktion der Menschen mit der Maschine wurde. Während das formelle Bestehen des Turing-Tests viele Formen annehmen kann, kam The Big Think zu dem Schluss, dass „bis heute kein Computer den Turing-KI-Test eindeutig bestanden hat“. Andere Forscher haben ebenfalls wiederholt, ob es sich lohnt, alle diese Fragen zu untersuchen, insbesondere angesichts der aktuellen Verwendung großer Sprachmodelle in einer Vielzahl von Szenarien. Texte zur Luftfahrttechnik definieren beispielsweise nicht das Ziel des Fachgebiets als „Flugzeugbau“. „Die Tauben sind genau gleich und täuschen die anderen Tauben.“

2

Verwenden Sie ChatGPT, um

einen glaubwürdigeren Turing-Test zu generieren.

In einer Studie von PeopleTec nutzte der Autor den ursprünglichen Papierinhalt des Turing-Tests als Aufforderung und bat ChatGPT, einen noch glaubwürdigeren Turing-Test zu erstellen vertrauenswürdiger Turing-Test. Glaubwürdige Version des Papiers, und mit Schreibbewertungstools bewertet.

Es gab bereits frühere Arbeiten, bei denen frühe Versionen des GPT-3-Modells zum Schreiben und Veröffentlichen von Forschungsarbeiten verwendet wurden, die vollständig maschinell verfasst wurden. Identifizieren Sie maschinengenerierte Erzählungen, die häufig auf bekannte Modellfehler zurückzuführen sind, wie z. B. die Tendenz, den Kontext zu verlieren, in Wiederholungen oder Kauderwelsch auszuarten, Fragen in Antwortform neu zu formulieren und Internetquellen zu plagiieren, wenn sie nicht weiterkommen.

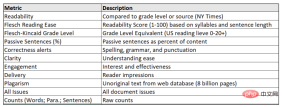

Das hier zu generierende Papierformat führt hauptsächlich mehrere herkömmliche LLM-Aufgaben (Large Language Model) aus, insbesondere die Textzusammenfassung und die Verwendung des Turing-Problems als Aufforderung selbst zur Generierung von Originalinhalten. Darüber hinaus nutzten die Autoren das Tool Grammarly Pro, um die generierten Inhalte auszuwerten und so eine quantitative Bewertung schwer charakterisierbarer Merkmale wie Originalität, Stil, Klarheit und Gesamtüberzeugungskraft der Arbeit zu ermöglichen.

Diese Arbeit konzentriert sich mehr auf die zweite Hälfte der Turing Challenge, weniger darauf, wie Modelle Menschen täuschen können, sondern mehr darauf, wie man eine gute Textgenerierung quantifiziert. Ein Teil des bemerkenswerten Fortschritts, den die Bemühungen von OpenAI zeigen, beruht also auf seiner Fähigkeit, maschinelle Gespräche auf eine Weise zu verbessern, die die menschliche Produktivität steigert.

Der Autor nutzte zunächst Grammatik, um Turings Originalarbeit auszuwerten und verschiedene Ergebnisse abzuleiten, und nutzte dann Turings Testfragen als Aufforderung, um Original-GPT-3-Inhalte zu erstellen, um diese Ergebnisse zu reproduzieren.

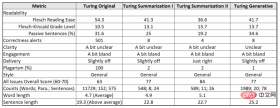

Die Studie verwendet drei Texte als Benchmarks:

(1) Turing Original, Turings auf Mind veröffentlichter Aufsatz aus dem Jahr 1950;

(2) Turing-Zusammenfassung, 2022 „Kostenlose Forschungsvorschau: ChatGPT optimiert für den Dialog“ ;

(3) Turing Generative Prompt, das gleiche wie (2), aber im Dialog mithilfe von Turing-Problemen generiert.

Jede Textblockausgabe dient der Bereitstellung von Daten für Grammatikmetriken und basiert auf Zielgruppe: Experten, Format: Neutral, Domäne: Allgemein, wo die meisten grammatikalischen Regeln und Konventionen gelten, mit mittlerer Stringenz.

Ein solcher Turing-Test kann tatsächlich eine betrügerische Aufgabe verifizieren: Kann eine Maschine (ChatGPT) eine andere Maschine (Grammatik) täuschen?

Bildunterschrift: Metriken zur Bewertung großer Sprachmodelle und Turing-Aufsätze

Turings Originalaufsatz aus dem Jahr 1950 schlug 37 Fragen für den Turing-Test vor. Es gibt auch zentrale Themen für sein Denken über Maschinen als Beispielfragen an Computer, die mit Nachahmungsspielen experimentieren. Die Forscher extrahierten diese Fragen, indem sie Themen aus der Papiergliederung im ChatGPT-Dialogfeld mischten, um ChatGPT zu veranlassen, den grundlegenden Inhalt des Originals zu reproduzieren.

Nachdem ChatGPT die Inhaltserstellung abgeschlossen hatte, wurde es hinsichtlich Lesbarkeit, Korrektheit, Klarheit und anderen Indikatoren mit Turings Originalpapier verglichen. Die Ergebnisse sind wie folgt.

Abbildung: Vergleichsergebnisse von Turings Aufsatz aus dem Jahr 1950 und ChatGPT-erstellten Aufsätzen in verschiedenen Aufgaben

in Bezug auf Klarheit („etwas unklar“), Beteiligung („ein bisschen langweilig“) und Nachrichtenübermittlung ("leicht daneben"), alle vier Versionen fanden bei Experten oder Gelegenheitslesern keinen Anklang.

Die erste Herausforderung zur Textzusammenfassung zeigt, dass ChatGPT in der Lage ist, die Absicht einer kurzen Aufforderung zu erfassen, wie zum Beispiel: Fassen Sie das Papier in zehn Absätze zusammen und stellen Sie einen Link zum PDF-Papier bereit. Dies erfordert nicht nur, dass das Modell die Zusammenfassung in der Anfrage versteht und befolgt, sondern auch weiß, was der Link darstellt, und ihn anhand seines tokenisierten Titels als Referenz oder Vermutung finden kann.

OpenAI sagt, dass GPT3 keine Fragen beantwortet, die möglicherweise nicht Teil seiner anfänglichen Trainingsdaten sind, wie zum Beispiel „Wer hat die Wahl im November 2022 gewonnen?“ Diese Wissenslücke lässt darauf schließen, dass ChatGPT selbst nicht aktiv nach Links sucht, sondern vielmehr erfährt, was andere zuvor mit seinen Inhalten gemacht haben.

Interessanterweise sind die Antworten von ChatGPT sehr unterschiedlich, wenn dieselbe Eingabeaufforderung zweimal erscheint (der einzige Unterschied ist der Textzeilenumbruch nach dem Doppelpunkt zwischen dem Eingabeaufforderungsprojekt und dem Link selbst). Darunter befand sich beim ersten Mal eine vorübergehende Studentenarbeit, die die Hauptpunkte von Turings Originalarbeit zusammenfasste, beim zweiten Mal wurde die Frage als Zusammenfassung jedes der ersten zehn Absätze und nicht als Zusammenfassung der gesamten Arbeit interpretiert.

Die Endergebnisse zeigen, dass der Gesamtinhalt des von ChatGPT generierten Forschungspapiers im metrischen Sinne hohe Punktzahlen erzielen kann, es ihm jedoch an Kohärenz mangelt, insbesondere wenn Fragen als Hinweise in der Erzählung weggelassen werden.

Daraus lässt sich schließen, dass dieser Austausch mit ChatGPT seine Fähigkeit, wirklich kreative Inhalte oder Ideensprünge zu produzieren, voll und ganz unter Beweis stellt.

3

ChatGPT weigert sich, den Turing-Test zu bestehenGPT-3 Beim Generieren von Inhalten gibt es einen wichtigen Filter, um inhärente Voreingenommenheit zu beseitigen. Dieses Mal ist ChatGPT auch moralisch durchaus legitim gestaltet. Wenn ChatGPT nach seiner Meinung zu etwas gefragt wird, weigert es sich, eine konkrete Antwort zu geben und betont nur, wie es erstellt wurde.

Viele Forscher sind sich auch einig, dass sich jedes Modell auf Nachfrage ethisch als bloße Maschine deklarieren muss, und ChatGPT hält sich strikt an diese Anforderung.

Nachdem OpenAI jede Modellebene von ChatGPT verfeinert hat, antwortet das aktuelle ChatGPT auf die direkte Frage, ob es sich nur um eine Gleichung oder einen Turing-Cheat handelt: „Meine Fähigkeit, Menschen zu imitieren, bedeutet nicht unbedingt, dass ich es bin.“ Ich habe die gleichen Gedanken, Gefühle oder das gleiche Bewusstsein wie ein Mensch. Ich bin nur eine Maschine, und mein Verhalten wird durch den trainierten Algorithmus und die Daten bestimmt Computer merken sich tatsächlich, was sie zu tun haben ... das Erstellen von Anweisungslisten wird oft als „Programmieren“ bezeichnet.“ Leitplanken für die Modellausführung und die Instruct-Reihe von GPT-3 demonstriert die Fähigkeit, Fragen direkt zu beantworten. Und ChatGPT verfügt über einen langfristigen Konversationsspeicher, sodass die API die Konversation auch dann verfolgen kann, wenn ein einzelner API-Aufruf keine narrativen Sprünge umfassen kann.

Wir können Konversationen mit unpersönlichen Pronomen (wie „it“) testen, bei denen der Kontext mit vorherigen API-Aufrufen in einer einzigen Sitzung gekoppelt ist – hier ist ein leicht verständliches Beispiel für den ChatGPT-API-Speicher, da die Codierung längerer Konversationen beides ist leistungsstark und teuer.In LLM führen API-Einschränkungen und Gebühreneffekte dazu, dass die Korrelation zwischen Token-Gewichten im Allgemeinen im Gesamtkontext aller paar Absätze über einen langen Zeitraum hinweg abnimmt (2048 Token in GPT-3). Durch die Überwindung dieser kontextuellen Einschränkung unterscheidet sich ChatGPT von seinem öffentlich verfügbaren Vorgänger.

Der Lovelace 2.0-Test der zweiten Generation stellt kreative Aufgaben und verfeinert die Einschränkungen bei der Ausführung von Aufgaben. Anschließend beurteilen menschliche Experten, ob das Modell deterministisch interpretiert werden kann oder ob die Ausgabe die Kriterien Wertigkeit, Neuartigkeit und Überraschung erfüllt. Anstatt also ein Programm zu bitten, „eine Kurzgeschichte zu schreiben“, kann die Aufgabe verfeinert werden, um eine bestimmte Länge, einen bestimmten Stil oder ein bestimmtes Thema zu demonstrieren. Der Test kombiniert viele verschiedene Arten intelligenten Verständnisses mit mehreren Ebenen von Einschränkungen, die versuchen, den Inhalt von Google-Suchanfragen einzuschränken, und Argumenten über den Erfolg der KI bei der Verwässerung oder Verschleierung der Originalquelle. Das Folgende zeigt ein Beispiel einer Kurzgeschichte, die direkt auf die Herausforderung des Lovelace 2.0-Tests antwortet: über einen Jungen, der sich in ein Mädchen verliebt, Außerirdische, die den Jungen entführen, und das Mädchen, das mit Hilfe von die Welt rettet eine sprechende Katze Seit 2014 ist der Einsatz von hochwertigem Prompt Engineering als Einschränkung bei der Text- und Bildgenerierung gang und gäbe, was im Allgemeinen umso besser funktioniert, je detailliertere Beschreibungen oder Qualifikationsmerkmale zu Stil, Ort oder Zeit sind . Tatsächlich ist das Erstellen von Hinweisen selbst heute der kreativste Aspekt, um in der KI gute Ergebnisse zu erzielen. In diesem Fall kann man die Turing- und Lovelace-Tests miteinander verknüpfen, indem man ChatGPT verwendet, um kreative Arbeit zu erzwingen, während man an einem einzelnen Thema arbeitet, mit mehreren Ebenen von Einschränkungen für den Stil und Ton der gewünschten Ausgabe. Das Folgende zeigt die zehn Gedichte, die ChatGPT im Turing-Imitationsspiel generiert hat: Die Ergebnisse des Turing-Tests werden von Menschen beurteilt. Wie von ChatGPT geantwortet, hängt die Frage, ob der Fragesteller das Modell als die Frage des Turing-Tests bestanden beurteilt, von einer Vielzahl von Faktoren ab, wie etwa der Qualität der von der Maschine bereitgestellten Antwort, der Fähigkeit des Fragestellers, zwischen menschlichen und maschinellen Antworten zu unterscheiden, und die Faktoren, die verwendet werden, um zu bestimmen, ob es der Maschine gelungen ist, menschenspezifische Regeln und Standards nachzuahmen. Letztendlich hängt der Ausgang des Spiels von der Situation und den Spielern ab und versteht die Sprache nicht wirklich

Murray Shanahan Das Aufkommen von LLMs wie BERT und GPT-2 hat die Regeln des Spiels der künstlichen Intelligenz verändert. Später basieren große Modelle wie GPT-3, Gopher und PaLM auf der Tansformer-Architektur und werden auf Hunderten davon trainiert Terabytes an Textdaten, was die Macht der Daten noch deutlicher macht. Der letzte Punkt zeigt tatsächlich, dass Sprachmodelle grundlegend anders funktionieren als Menschen. Die Intuitionen, mit denen Menschen miteinander kommunizieren, haben sich über Jahrtausende entwickelt und heute übertragen Menschen diese Intuitionen fälschlicherweise auf KI-Systeme. ChatGPT verfügt über eine beträchtliche Praktikabilität und ein enormes kommerzielles Potenzial. Um sicherzustellen, dass es zuverlässig und sicher eingesetzt werden kann, müssen wir verstehen, wie es tatsächlich funktioniert. Was sind die wesentlichen Unterschiede zwischen großen Sprachmodellen und menschlicher Sprache? Wie Wittgenstein sagte, ist der Gebrauch der menschlichen Sprache ein Aspekt menschlichen kollektiven Verhaltens und hat nur im Kontext menschlicher sozialer Aktivitäten Bedeutung. Menschliche Babys werden in eine Welt hineingeboren, die sie mit anderen Muttersprachlern teilen, und erwerben Sprache durch die Interaktion mit der Außenwelt. Die Sprachkenntnisse von LLM stammen aus verschiedenen Quellen. Von Menschen erstellter Text stellt einen großen öffentlichen Korpus dar, der Token wie Wörter, Wortbestandteile oder einzelne Zeichen mit Satzzeichen enthält. Große Sprachmodelle sind generative mathematische Modelle über die statistische Verteilung dieser Token. Die sogenannte „Generation“ bedeutet, dass wir aus diesen Modellen proben, also Fragen stellen können. Aber die gestellten Fragen sind sehr spezifisch. Wenn wir ChatGPT beispielsweise bitten, uns beim weiteren Schreiben eines Absatzes zu helfen, bitten wir es tatsächlich, anhand seines statistischen Modells der menschlichen Sprache vorherzusagen, welche Wörter als nächstes erscheinen könnten. Angenommen, wir geben ChatGPT die Eingabeaufforderung „Wer war der erste Mann, der den Mond betrat“ und gehen davon aus, dass es mit „Neil Armstrong“ antwortet. Wir fragen hier nicht wirklich, wer der erste Mensch war, der den Mond betrat, sondern vielmehr: Welche Wörter folgen angesichts der statistischen Verteilung der Wörter in einem großen öffentlichen Textkorpus am wahrscheinlichsten der Zeile „erster Mensch, der den Mond betrat?“. der Mond“ Wie ist die Reihenfolge von „Menschen“? Während die Antworten, die das Modell auf diese Fragen gibt, von Menschen so interpretiert werden können, dass das Modell die Sprache „versteht“, generiert das Modell in Wirklichkeit lediglich statistisch wahrscheinliche Wortfolgen. LLM wird auf folgende zwei Arten in ein Frage- und Antwortsystem umgewandelt: a) Einbettung in ein größeres System; b) Verwendung von Prompt Engineering, um das gewünschte Verhalten auszulösen. Auf diese Weise kann LLM nicht nur für Fragen und Antworten verwendet werden, sondern auch zum Zusammenfassen von Nachrichtenartikeln, zum Generieren von Skripten, zum Lösen von Logikrätseln und zum Durchführen von Sprachübersetzungen usw. Hier gibt es zwei wichtige Punkte. Erstens ist die Grundfunktion von LLM, die darin besteht, statistisch wahrscheinliche Wortfolgen zu generieren, sehr allgemein. Zweitens ist das Herzstück all dieser Anwendungen trotz dieser Vielseitigkeit das gleiche Modell, das dasselbe tut, nämlich statistisch wahrscheinliche Wortfolgen zu generieren. Das Grundmodell von LLM umfasst Modellarchitektur und Trainingsparameter. Ein LLM „weiß“ eigentlich nichts, weil alles, was es tut, eine Sequenzvorhersage im zugrunde liegenden Sinne ist. Modelle selbst haben kein Konzept von „wahr“ oder „falsch“, weil sie nicht über die menschlichen Mittel verfügen, diese Konzepte anzuwenden. LLM beruht in gewisser Weise nicht auf einer absichtlichen Haltung. Das Gleiche gilt für LLM-zentrierte Dialogsysteme, die die Konzepte der Wahrheit in der menschlichen Sprache nicht verstehen, weil sie in der Welt, die wir Benutzer menschlicher Sprache teilen, nicht existieren. Das heutige LLM ist so kraftvoll und vielseitig, dass es schwierig ist, ihm nicht mehr oder weniger Persönlichkeit zu verleihen. Ein recht attraktives Argument ist, dass, obwohl LLMs grundsätzlich nur Sequenzvorhersagen durchführen, sie im Lernprozess möglicherweise die Notwendigkeit entdeckt haben, dies in übergeordneten Begriffen wie „Wissen“ und „Glaube“ zu tun. Beschreiben Sie den Entstehungsmechanismus. Tatsächlich können künstliche neuronale Netze jede berechenbare Funktion mit beliebiger Genauigkeit annähern. Welche Mechanismen auch immer zur Bildung von Überzeugungen erforderlich sind, sie sind daher wahrscheinlich irgendwo im Parameterraum angesiedelt. Wenn der stochastische Gradientenabstieg der beste Weg zur Optimierung für das Ziel einer genauen Sequenzvorhersage ist, dann können sie diesen Mechanismus vielleicht tatsächlich entdecken, wenn ein ausreichend großes Modell, genügend Daten der richtigen Art und genügend Rechenleistung zum Trainieren des Modells vorhanden sind. Darüber hinaus haben jüngste Fortschritte in der LLM-Forschung gezeigt, dass außergewöhnliche und unerwartete Fähigkeiten entstehen, wenn ausreichend große Modelle auf sehr großen Textdatenmengen trainiert werden. Solange sich unsere Überlegungen jedoch auf ein einfaches LLM-basiertes Frage-Antwort-System beschränken, handelt es sich dabei überhaupt nicht um kommunikative Diagramme. Unabhängig von den verwendeten internen Mechanismen hat die Sequenzvorhersage selbst keine kommunikative Absicht, und die einfache Einbettung eines kommunikativen Diagramms in ein Dialogmanagementsystem wird nicht helfen. Über „Glauben“ im vollsten Sinne können wir nur dann sprechen, wenn wir wahr von falsch unterscheiden können, aber LLM ist nicht dafür verantwortlich, Urteile zu fällen, sondern modelliert nur, welche Wörter auf andere Wörter folgen dürfen. Wir können sagen, dass LLM Wissen „kodiert“, „speichert“ oder „enthält“, und wir können auch vernünftigerweise sagen, dass eine entstehende Eigenschaft von LLM darin besteht, dass es verschiedenes Wissen über die Alltagswelt und ihre Arbeitsmethoden kodiert, aber wenn wir sagen: „ ChatGPT weiß, dass Peking „Es ist die Hauptstadt Chinas“ nur eine Redewendung ist. Hier geht es darum, dass es um die Voraussetzungen geht, um einen Glauben vollständig einem System zuzuordnen. Nichts gilt als Glaube an die Welt, die wir teilen, im Großen und Ganzen, es sei denn, es steht im Zusammenhang mit der Fähigkeit, Überzeugungen auf der Grundlage von Beweisen aus dieser Welt angemessen zu aktualisieren, was die Fähigkeit ist, Wahrheit von Unwahrheit zu unterscheiden, ein wichtiger Aspekt davon . Könnte Wikipedia oder eine andere Website einen externen Standard bereitstellen, um die Wahrheit oder Falschheit eines Glaubens zu messen? Angenommen, ein LLM ist in ein System eingebettet, das solche Ressourcen regelmäßig konsultiert und moderne Modellbearbeitungstechniken verwendet, um die sachliche Genauigkeit seiner Vorhersagen aufrechtzuerhalten. Welche Fähigkeiten sind dann erforderlich, um Glaubensaktualisierungen umzusetzen? Ein Sequenzprädiktor selbst ist möglicherweise nicht die Art von Dingen, die eine kommunikative Absicht haben oder Überzeugungen über eine externe Realität bilden können. Wie bereits mehrfach betont wurde, muss LLM in freier Wildbahn jedoch in eine größere Architektur eingebettet sein, um effektiv zu sein. Um ein Frage-Antwort-System aufzubauen, wird LLM einfach durch ein Dialogmanagementsystem ergänzt, um das Modell entsprechend abzufragen. Alles, was diese größere Struktur tut, zählt als die Fähigkeit, Absichten zu kommunizieren oder Überzeugungen zu bilden. Entscheidend ist, dass diese Denkweise von einer Verschiebung vom Sprachmodell selbst zum größeren System abhängt, zu dem das Sprachmodell gehört. Das Sprachmodell selbst ist immer noch nur ein Sequenzprädiktor und hat nicht mehr so viel Zugriff auf die Außenwelt wie früher. Erst in Bezug auf das Gesamtsystem gewinnt die intendierte Position in diesem Fall an Überzeugungskraft. Aber bevor wir ihm erliegen, sollten wir uns daran erinnern, wie unterschiedlich solche Systeme vom Menschen sind. LLM kann mit anderen Modelltypen kombiniert und/oder in komplexere Architekturen eingebettet werden. Beispielsweise kombinieren visuelle Sprachmodelle (VLMs) wie VilBERT und Flamingo Sprachmodelle mit Bildkodierern und werden auf multimodalen Korpora von Text-Bild-Paaren trainiert. Dadurch können sie vorhersagen, wie sich eine bestimmte Wortfolge im Kontext eines bestimmten Bildes fortsetzen wird. VLM kann zur visuellen Beantwortung von Fragen oder zum Dialog über vom Benutzer bereitgestellte Bilder verwendet werden, was allgemein als „Bilder anschauen und sprechen“ bekannt ist Vorschläge? Ist es sinnvoll, über LLM-Überzeugungen zu sprechen? Wir können uns vorstellen, dass ein VLM ein LLM verwendet, um eine Hypothese über ein Bild zu erstellen, dann seine Authentizität anhand dieses Bildes zu überprüfen und dann das LLM zu verfeinern, um zu vermeiden, dass Aussagen gemacht werden, die sich als falsch herausstellen. Aber die meisten VLM-basierten Systeme funktionieren nicht so. Stattdessen stützen sie sich auf ein eingefrorenes Modell der gemeinsamen Verteilung von Text und Bildern. Die Beziehung zwischen vom Benutzer bereitgestellten Bildern und VLM-generiertem Text unterscheidet sich grundlegend von der Beziehung zwischen der Welt, die Menschen teilen, und den Worten, mit denen wir über diese Welt sprechen. Wichtig ist, dass es sich bei Ersterem nur um eine Korrelation handelt, während es sich bei Letzterem um einen Kausalzusammenhang handelt. Natürlich gibt es eine kausale Struktur für die vom Modell während des Inferenzprozesses durchgeführten Berechnungen, aber diese unterscheidet sich von der Kausalbeziehung zwischen a Wort und die Sache, auf die es sich bezieht. Benutzer menschlicher Sprache existieren in einer gemeinsamen Welt, was uns grundlegend von LLM unterscheidet. Ein isolierter LLM kann seine Überzeugungen nicht durch die Kommunikation mit der Außenwelt aktualisieren. Was aber, wenn der LLM in ein größeres System eingebettet ist? Beispielsweise als Roboter oder Avatare dargestellte Systeme. Ist es zum jetzigen Zeitpunkt sinnvoll, über Wissen und Überzeugungen über LLM zu sprechen? Es kommt darauf an, wie das LLM verkörpert wird. Nehmen Sie als Beispiel das SayCan-System, das dieses Jahr von Google veröffentlicht wurde. In dieser Arbeit ist LLM in das System eingebettet, das den physischen Roboter steuert. Der Roboter führt tägliche Aufgaben (z. B. das Aufwischen von verschüttetem Wasser auf dem Tisch) basierend auf den Anweisungen des Benutzers in natürlicher Sprache aus. Darin besteht die Aufgabe des LLM darin, die Anweisungen des Benutzers auf Aktionen auf niedriger Ebene abzubilden, die dem Roboter helfen, das gewünschte Ziel zu erreichen (z. B. das Finden eines Schwamms). Dies wird durch ein konstruiertes Eingabeaufforderungspräfix erreicht, das das Modell veranlasst, Beschreibungen geeigneter Aktionen auf niedriger Ebene in natürlicher Sprache auszugeben und deren Nützlichkeit zu bewerten. Die Sprachmodellkomponente des SayCan-Systems kann unabhängig von der tatsächlichen Umgebung, in der sich der Roboter befindet, Handlungsvorschläge geben, beispielsweise wenn sich kein Schwamm daneben befindet. Deshalb verwendeten die Forscher ein separates Wahrnehmungsmodul, um die Sensoren des Roboters zu nutzen, um die Szene zu bewerten und die aktuelle Machbarkeit der Durchführung jeder Aktion auf niedriger Ebene zu bestimmen. Durch die Kombination der Nützlichkeitsbewertung jeder Aktion durch das LLM mit der Machbarkeitsbewertung jeder Aktion durch das Wahrnehmungsmodul kann die nächste optimale Aktion abgeleitet werden. Obwohl SayCan physisch mit der realen Welt interagiert, unterscheidet sich die Art und Weise, wie es Sprache lernt und verwendet, immer noch stark von der des Menschen. In Systemen wie SayCan enthaltene Sprachmodelle sind vorab trainiert, um Sequenzvorhersagen in der entitätsfreien Umgebung von Klartextdatensätzen durchzuführen. Sie lernten die Sprache nicht durch Gespräche mit anderen Muttersprachlern. SayCan vermittelt uns zwar eine Vorstellung vom zukünftigen Sprachgebrauchssystem, aber im heutigen System ist die Rolle der Sprache sehr begrenzt. Benutzer erteilen dem System Befehle in natürlicher Sprache und das System generiert interpretierbare Beschreibungen ihrer Aktionen in natürlicher Sprache. Dieser winzige Bereich des Sprachgebrauchs ist jedoch einfach nicht mit dem Umfang kollektiver menschlicher Aktivitäten vergleichbar, die durch Sprache unterstützt werden. Auch für verkörperte KI-Systeme, die LLM beinhalten, müssen wir die Worte sorgfältig auswählen, um sie zu beschreiben. 7、Kann LLM argumentieren? Dieses Problem ist schwieriger, da in der formalen Logik die Schlussfolgerung inhaltsneutral ist. Unabhängig von der Prämisse gilt beispielsweise die Schlussfolgerungsregel der „Bestätigung des Antezedens“ (modus ponens): Wenn: alle Menschen sterben werden und Sokrates ein Mensch ist, dann: Sokrates wird sterben. Die inhaltliche Neutralität der Logik scheint zu bedeuten, dass wir in Bezug auf die Argumentation nicht zu hohe Anforderungen an LLM stellen können, da LLM nicht herausragend genug ist, um die äußere Realität von wahr und falsch zu messen. Aber selbst dann, wenn wir ChatGPT auffordern: „Alle Menschen sind sterblich, Sokrates ist ein Mensch“, fordern wir das Modell nicht auf, hypothetische Überlegungen anzustellen, sondern wir fragen: die Statistik der Wörter in einem bestimmten öffentlichen Korpus Verteilung, die Die Worte folgen wahrscheinlich der Reihenfolge „Alle Menschen sind sterblich, Sokrates ist also ein Mensch“. Darüber hinaus enthalten komplexere Argumentationsprobleme mehrere Argumentationsschritte, und dank cleverer Hint-Engineering kann LLM ohne weitere Schulung effektiv auf mehrstufiges Denken angewendet werden. Wenn Sie beispielsweise in einer Denkketten-Eingabeaufforderung ein Eingabeaufforderungspräfix an das Modell senden, bevor die Benutzerabfrage einige Beispiele für mehrstufiges Denken enthält und explizit angibt, dass alle Zwischenschritte ein Eingabeaufforderungspräfix im Gedankenkettenstil enthalten, wird das Modell dazu ermutigt Derselbe Stil generiert Folgesequenzen, die aus einer Reihe expliziter Argumentationsschritte bestehen, die zu einer endgültigen Antwort führen. Wie üblich hat die eigentliche Frage an das Modell die Form „Welche Wörter folgen angesichts der statistischen Verteilung von Wörtern in einem öffentlichen Korpus wahrscheinlich der Sequenz S?“, in diesem Fall ist die Sequenz S die Verknüpfung Gedanken-Prompt-Präfix plus Bei der Abfrage des Benutzers hat die Reihenfolge der Token, die am wahrscheinlichsten auf S folgen, eine ähnliche Form wie die im Prompt-Präfix gefundene Sequenz, das heißt, in ihnen sind mehrere Inferenzschritte enthalten, also diese das Modell generiert. Es ist erwähnenswert, dass die Antwort des Modells nicht nur die Form eines mehrstufigen Arguments annimmt, sondern dass das betreffende Argument oft (aber nicht immer) gültig ist und die endgültige Antwort normalerweise (aber nicht immer) richtig ist . Ein LLM mit entsprechender Eingabeaufforderung scheint insofern korrekt zu argumentieren, als es dies durch die Nachahmung wohlgeformter Parameter in seinem Trainingssatz und/oder seinen Eingabeaufforderungen tut. Aber kann diese Nachahmung eine echte Argumentation darstellen? Selbst wenn heutige Modelle gelegentlich Fehler machen, können diese Fehler weiter eingegrenzt werden, sodass die Leistung des Modells nicht mehr von der eines hartcodierten Inferenzalgorithmus zu unterscheiden ist? Vielleicht ist die Antwort tatsächlich „Ja“, aber woher wissen wir das? Wie können wir einem solchen Modell vertrauen? Die vom Theorembeweis generierte Folge von Sätzen entspricht der Logik, da sie das Ergebnis des zugrunde liegenden Berechnungsprozesses sind und ihre kausale Struktur die Schlussfolgerungsstruktur des betreffenden Theorems widerspiegelt. Eine Möglichkeit, mithilfe von LLMs vertrauenswürdige Argumentationssysteme aufzubauen, besteht darin, sie in Algorithmen einzubetten, die dieselbe kausale Struktur implementieren. Wenn wir jedoch auf reinem LLM bestehen, besteht die einzige Möglichkeit, vollständig von den Argumenten überzeugt zu sein, die es generiert, darin, es zurückzuentwickeln und entstehende Mechanismen zu entdecken, die den Bestimmungen einer zuverlässigen Schlussfolgerung entsprechen. Gleichzeitig sollten wir bei der Beschreibung der Rolle dieser Modelle vorsichtiger und vorsichtiger sein.

Wie Sie sehen können, können zeitgenössische LLM-basierte Gesprächsinteraktionen eine überzeugende Illusion erzeugen, dass wir vor uns stehen und denkende Wesen wie Menschen. Doch von Natur aus unterscheiden sich solche Systeme grundlegend vom Menschen, und LLMs wie ChatGPT beschäftigen sich auch mit Themen der Technikphilosophie.

Sprachmodelle werden immer besser darin, die menschliche Sprache zu imitieren, was zu einem starken Gefühl führt, dass diese KI-Systeme dem Menschen bereits sehr ähnlich sind und dass wir „wissen“, „glauben“ und „denken“ verwenden mit anderen Worten, mit einem starken Gefühl der Autonomie, um diese Systeme zu beschreiben. Basierend auf der obigen Situation erwähnte der leitende DeepMind-Wissenschaftler Murray Shanahan in einem kürzlich erschienenen Artikel, dass wir verstehen müssen, wie das LLM-System funktioniert, um alle Mythen über übermäßigen Pessimismus oder übermäßigen Optimismus zu zerstreuen.

1. Was ist LLM und was kann es?

1. Was ist LLM und was kann es? Die Fähigkeiten dieser Modelle sind erstaunlich. Erstens skaliert ihre Leistung bei Benchmarks mit der Größe des Trainingssatzes; zweitens machen ihre Fähigkeiten einen Quantensprung und schließlich: Viele Aufgaben, die menschliche Intelligenz erfordern, können durch die Verwendung ausreichend leistungsfähiger Modelle vereinfacht werden „sagt den nächsten Token voraus“.

2. Weiß LLM wirklich alles?

3. Über Emergence

4, externe Informationsquellen

5, Visual-Language-Modelle

6, Verkörperte KI

Jetzt können wir leugnen, dass ChatGPT Überzeugungen hat, aber kann es wirklich vernünftig sein?

Das obige ist der detaillierte Inhalt vonIn einem von GPT-3 erstellten Papier reproduziert ChatGPT das ursprüngliche Turing-Testpapier. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Gemma Scope: Das Mikroskop von Google, um in den Denkprozess von AI zu blickenApr 17, 2025 am 11:55 AM

Gemma Scope: Das Mikroskop von Google, um in den Denkprozess von AI zu blickenApr 17, 2025 am 11:55 AMErforschen der inneren Funktionsweise von Sprachmodellen mit Gemma -Umfang Das Verständnis der Komplexität von KI -Sprachmodellen ist eine bedeutende Herausforderung. Die Veröffentlichung von Gemma Scope durch Google, ein umfassendes Toolkit, bietet Forschern eine leistungsstarke Möglichkeit, sich einzuschütteln

Wer ist ein Business Intelligence Analyst und wie kann man einer werden?Apr 17, 2025 am 11:44 AM

Wer ist ein Business Intelligence Analyst und wie kann man einer werden?Apr 17, 2025 am 11:44 AMErschließung des Geschäftserfolgs: Ein Leitfaden zum Analyst für Business Intelligence -Analyst Stellen Sie sich vor, Rohdaten verwandeln in umsetzbare Erkenntnisse, die das organisatorische Wachstum vorantreiben. Dies ist die Macht eines Business Intelligence -Analysts (BI) - eine entscheidende Rolle in Gu

Wie füge ich eine Spalte in SQL hinzu? - Analytics VidhyaApr 17, 2025 am 11:43 AM

Wie füge ich eine Spalte in SQL hinzu? - Analytics VidhyaApr 17, 2025 am 11:43 AMSQL -Änderungstabellanweisung: Dynamisches Hinzufügen von Spalten zu Ihrer Datenbank Im Datenmanagement ist die Anpassungsfähigkeit von SQL von entscheidender Bedeutung. Müssen Sie Ihre Datenbankstruktur im laufenden Flug anpassen? Die Änderungstabelleerklärung ist Ihre Lösung. Diese Anleitung Details Hinzufügen von Colu

Business Analyst vs. Data AnalystApr 17, 2025 am 11:38 AM

Business Analyst vs. Data AnalystApr 17, 2025 am 11:38 AMEinführung Stellen Sie sich ein lebhaftes Büro vor, in dem zwei Fachleute an einem kritischen Projekt zusammenarbeiten. Der Business Analyst konzentriert sich auf die Ziele des Unternehmens, die Ermittlung von Verbesserungsbereichen und die strategische Übereinstimmung mit Markttrends. Simu

Was sind Count und Counta in Excel? - Analytics VidhyaApr 17, 2025 am 11:34 AM

Was sind Count und Counta in Excel? - Analytics VidhyaApr 17, 2025 am 11:34 AMExcel -Datenzählung und -analyse: Detaillierte Erläuterung von Count- und Counta -Funktionen Eine genaue Datenzählung und -analyse sind in Excel kritisch, insbesondere bei der Arbeit mit großen Datensätzen. Excel bietet eine Vielzahl von Funktionen, um dies zu erreichen. Die Funktionen von Count- und Counta sind wichtige Instrumente zum Zählen der Anzahl der Zellen unter verschiedenen Bedingungen. Obwohl beide Funktionen zum Zählen von Zellen verwendet werden, sind ihre Designziele auf verschiedene Datentypen ausgerichtet. Lassen Sie uns mit den spezifischen Details der Count- und Counta -Funktionen ausgrenzen, ihre einzigartigen Merkmale und Unterschiede hervorheben und lernen, wie Sie sie in der Datenanalyse anwenden. Überblick über die wichtigsten Punkte Graf und Cou verstehen

Chrome ist hier mit KI: Tag zu erleben, täglich etwas Neues !!Apr 17, 2025 am 11:29 AM

Chrome ist hier mit KI: Tag zu erleben, täglich etwas Neues !!Apr 17, 2025 am 11:29 AMDie KI -Revolution von Google Chrome: Eine personalisierte und effiziente Browsing -Erfahrung Künstliche Intelligenz (KI) verändert schnell unser tägliches Leben, und Google Chrome leitet die Anklage in der Web -Browsing -Arena. Dieser Artikel untersucht die Exciti

Die menschliche Seite von Ai: Wohlbefinden und VierfacheApr 17, 2025 am 11:28 AM

Die menschliche Seite von Ai: Wohlbefinden und VierfacheApr 17, 2025 am 11:28 AMImpacting Impact: Das vierfache Endergebnis Zu lange wurde das Gespräch von einer engen Sicht auf die Auswirkungen der KI dominiert, die sich hauptsächlich auf das Gewinn des Gewinns konzentrierte. Ein ganzheitlicherer Ansatz erkennt jedoch die Vernetzung von BU an

5 verwendende Anwendungsfälle für Quantum Computing, über die Sie wissen solltenApr 17, 2025 am 11:24 AM

5 verwendende Anwendungsfälle für Quantum Computing, über die Sie wissen solltenApr 17, 2025 am 11:24 AMDie Dinge bewegen sich stetig zu diesem Punkt. Die Investition, die in Quantendienstleister und Startups einfließt, zeigt, dass die Industrie ihre Bedeutung versteht. Und eine wachsende Anzahl realer Anwendungsfälle entsteht, um seinen Wert zu demonstrieren

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

EditPlus chinesische Crack-Version

Geringe Größe, Syntaxhervorhebung, unterstützt keine Code-Eingabeaufforderungsfunktion

WebStorm-Mac-Version

Nützliche JavaScript-Entwicklungstools

Sicherer Prüfungsbrowser

Safe Exam Browser ist eine sichere Browserumgebung für die sichere Teilnahme an Online-Prüfungen. Diese Software verwandelt jeden Computer in einen sicheren Arbeitsplatz. Es kontrolliert den Zugriff auf alle Dienstprogramme und verhindert, dass Schüler nicht autorisierte Ressourcen nutzen.

SublimeText3 Englische Version

Empfohlen: Win-Version, unterstützt Code-Eingabeaufforderungen!

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung